摘要 - 雾霾和烟雾是影响图像质量的最常见环境因素,因此也影响图像分析。 本文提出了一种图像去雾的端到端生成方法。 它基于设计完全卷积神经网络,以识别输入图像中的雾霾结构,并恢复清晰,无雾的图像。 所提出的方法不探索大气散射模型,一定意义上是不可知的。 有些令人惊讶的是,相对于所有现有的最先进的图像去雾方法,即使在使用大气散射模型合成的SOTS室外图像上,它也能实现卓越的性能。

1 introduction

许多现代应用程序依赖于分析可视化数据来发现模式并做出决策。 在智能监视,跟踪和控制系统中可以找到一些例子,其中高质量的图像或帧对于准确的结果和可靠的性能是必不可少的。 然而,这种系统可能受到环境引起的扭曲的显着影响,其中最常见的是雾霾和烟雾。 因此,计算机视觉领域的许多研究致力于解决从朦胧对应物中恢复高质量图像的问题,[1],[2],[3],[4]等等。 这个问题通常被称为dehaze问题。

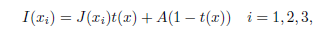

原始图像和模糊图像[5]之间的关系近似通过以下称为大气散射模型的公式:

I(xi)是第i个通道的模糊像素的强度,J(xi)是该像素的实际强度,并且t(x)是取决于场景深度和大气散射系数beta的介质传输函数。 等式(1)中的参数A是大气光强度,其被假定为整个图像上的整体常数。 由于除了模糊像素强度I(xi)之外,等式(1)中的所有变量都是未知的,因此除雾通常是未确定的问题。

去雾算法大致分为基于传统和机器学习(ML)的方法。

基于传统的他们通过利用某种形式的先验信息来解决欠定问题。如1.3.6He_基于暗通道\颜色衰减先验

另一方面,诸如[7],[2]dehazenet,[8]MSCNN和[9]AODNet之类的作品遵循基于学习的方法。 他们利用经典和深度学习技术的进步来解决dehaze问题。

无论这两个类别看起来有多么不同,

共性:

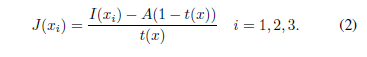

它们都旨在通过首先估计未知参数A和t(x)然后反转等式(1)来确定J(xi)来恢复原始图像:

从估计理论的角度来看,两类方法都属于插件原则1的范畴,它们都将被称为插件方法。

存在问题:

然而,对于dehaze问题,插件原理的最优性并不完全合理。 实际上,至少当两个问题受到相同的评估度量时,原始图像的有损重建问题不可能等效地转换为参数A和t(x)(或它们的变体)的估计问题。(1.不可等效)

此外,原始图像和模糊图像之间的实际关系可能相当复杂,并且可能无法通过大气散射模型完全捕获。 (2是等效后难以完全表示)

由于这种潜在的不匹配,依赖于大气散射模型(包括但不限于插入方法)的方法不能保证对自然图像的期望的推广,即使它们可以在合成图像上实现良好性能。

提出:

基于前面提到的插件方法(以及更一般地,依赖于模型的方法),本文从一个不同的,更不可知的角度来看待dehaze问题;它提供了一个dehaze神经网络,专注于生成输入图像的无雾版本。它利用深度学习的最新进展来构建编码器 - 解码器网络架构,该架构经过训练以直接恢复清晰图像,完全忽略参数估计问题。

所提出的方法具有识别训练数据中存在的复杂雾结构的潜力,但不通过大气散射模型捕获。

据我们所知,这种除雾问题的观点从未被探索过,除了最近的工作[10],其中引入了所谓的门控融合网络(GFN)用于图像去雾。可以看出,我们提出的网络比GFN有几个优点,特别是在架构复杂性和输入大小灵活性方面;此外,GFN的某些特征是专门针对dehaze问题而定制的,而我们网络的架构更通用,因此更广泛适用。

本文的其余部分分为三个部分。

第2节,介绍了用于图像去雾的通用模型 - 不可知卷积神经网络(GMAN)以及网络体系结构及其构建块的详细说明。

第3节将介绍实验结果,显示GMAN的性能。 它还包括数据集和训练过程的描述。

最后,第4节将结束本文的一些结论性意见。

2 方法

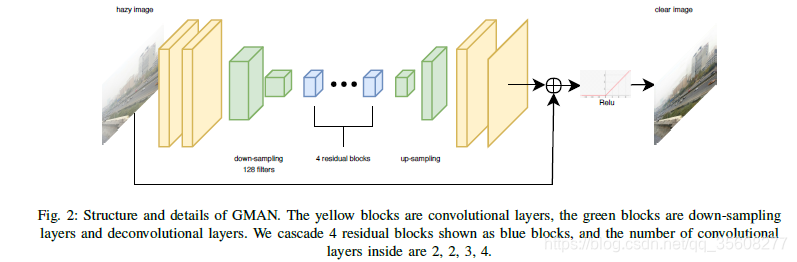

由于单个图像雾度去除是一个病态问题,因此设计并训练基于卷积,残差和去卷积块的深度神经网络以呈现模糊图像并恢复其无雾度版本。 网络具有编码器 - 解码器结构,如图2所示。在以下小节中,将更详细地讨论网络架构,其构建块和训练损失功能。

架构

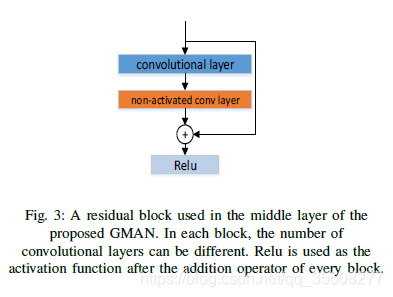

所提出的网络是完全卷积神经网络(CNN)。它用于从朦胧的输入中恢复清晰的图像。从功能上讲,它是一个端到端的生成网络,使用编码器 - 解码器结构,其下采样因子为2,其前两层由64通道卷积块构成。接下来是两步下采样层,将输入图像编码为56 56 128卷。然后将编码图像馈送到由4个残差块构建的残差层,每个残差块包含快捷连接,参见图3.

该层表示从编码到解码的转换,因为它后面是反卷积层,其上采样剩余层输出并为另一轮卷积重建新的224 224 64卷。最后两层包括卷积块。他们将上采样特征映射转换为RGB图像,最终将其添加到输入图像中并使用ReLU进行阈值处理以生成无雾模型。

残差学习

该网络在本地和全局两个层面上使用剩余学习。 在中间层并且恰好在下采样之后,残差块用于构建局部残差层。 它利用了假设的和经验证明的[11],[12],[13],[14]残差块的易于训练的特性(见[15]),并学会识别雾霾结构。 残差学习也出现在GMAN的整体架构中。 具体来说,输入图像与最终卷积层的输出一起馈送到求和运算符,创建一个全局残差块,参见图2.这个全局残差块的主要优点是它有助于所提出的网络更好地捕获 场景中具有不同深度的对象的边界细节。

编解码

所提出的GMAN的体系结构遵循在去噪问题中使用的流行的编码器 - 解码器体系结构。 它由三部分组成:编码器,隐藏层和解码器。 这种架构可以训练深度网络并减少数据维度。 由于雾度可以被认为是一种噪声形式,因此编码器输出被下采样并馈送到残余层以提取重要特征。 网络挤出原始图像的特征并丢弃噪声信息。 期望解码器部分学习并重新生成无雾图像的丢失数据,在解码周期期间符合输入信息的统计分布。

损失函数

为了训练提出的GMAN,定义了双损失函数。 第一个组件测量输出和GT之间的相似性,第二个组件有助于产生视觉上有意义的图像。 以下三个小节提供了有关每个组件和总损失的更多信息:

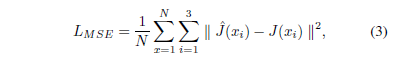

1)MSE损失:使用PSNR测量差异

在输出图像和地面实况之间是显示算法有效性的最常用方法。 因此,选择MSE作为损失函数的第一个分量,即LMSE。 通过最小化像素级的MSE可以达到PSNR的最佳值,表示为:

其中^ J(xi)是网络的输出,J(xi)是gt,i是信道索引,N是像素的总数。

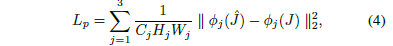

2)感知损失:在许多经典图像恢复问题中,输出图像的质量仅由MSE损失来测量。 然而,MSE损失不一定是视觉效果的良好指标。 正如Johnson等人。 在[16]中证明,从预训练的神经网络的特定层中提取高级特征可能对内容重建有益。 从高级特征获得的感知损失可以比像素级损失更鲁棒地描述两个图像之间的差异。

添加感知损失组件使得GMAN的解码器部分能够获得使用已经提取的特征来生成目标图像的精细细节的改进能力。 在目前的工作中,网络输出和基础事实都被送到VGG16 [17]; 在[16]之后,我们使用从图层conv11中提取的特征图;conv22; 将VGG16的conv33(将简称为第1,2,3层)定义感知损失Lp如下:

其中fai j(^ J)和fai j(J)分别是由网络输出和GT引起的VGG16层j的特征图,Cj,Hj和Wj是VGG16层j的特征体积的维数。

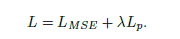

3)总损失:结合MSE和感知损失成分导致GMAN的总损失。 为了在两个组成部分之间提供某种平衡,感知损失预先乘以LUMDA,产生以下表达式:

3 实验

数据集

根据大气散射模型,透射图t(x)和大气光强度A控制图像的雾度水平。因此,正确设置这两个因素对于构建雾天图像的数据集非常重要。我们使用来自RESIDE [18]的OTS数据集,它是使用收集的真实世界室外场景构建的。整个数据集包含313,950个合成模糊图像,通过改变A的值和(使用[19]估计深度信息)从8970个地面实况图像生成。因此,对于每个地面实况图像,存在35个对应的模糊图像。

我们注意到RESIDE的测试集SOTS有1000个地面实况图像,每个图像都有35个合成模糊对应物,它们都包含在训练数据中。这肯定会导致测试结果出现一些不准确之处。因此,测试图像全部从训练数据(包括他们的模糊对应物)中移除,导致尺寸减小的训练数据集278,950个模糊图像(从7970地面真实图像生成)。

训练

通过最小化等式(5)给出的损失L,对所提出的GMAN进行端对端训练。 GMAN中的所有层都有64个滤波器(内核),除了具有128个滤波器的下采样,大小为3*3.网络需要大小为224 224的输入,因此训练数据集中的每个图像都是随机裁剪的 为了适应输入大小3。 批量大小设置为35以平衡GPU上的训练速度和内存消耗。 对于加速训练,Adam optimizer [20]使用以下设置:

初始学习率为0.001,beta1 = 0.9,beta2 = 0.999。 该网络及其训练流程已使用TensorFlow软件框架实施,并在NVIDIA Titan Xp GPU上实施。 经过20个epoch后,损失函数下降到0.0004的值,这被认为是一个很好的停止点。

评估

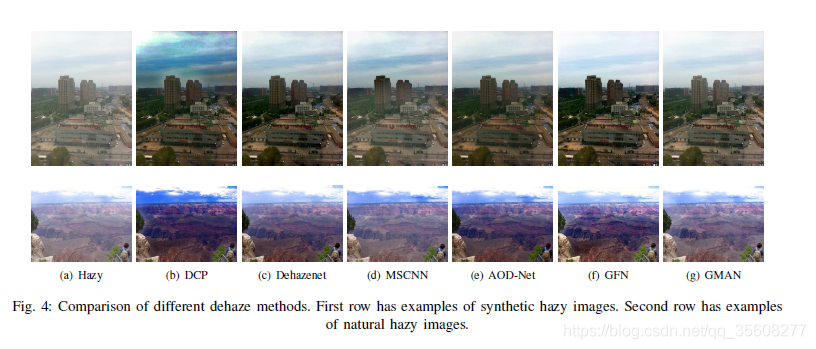

与许多最先进的方法相比,GMAN实现了卓越的性能。 根据下面的表I 4,它明显优于SOTS室外数据集[3],[2],[8],[9]所考虑的所有其他竞争方法。 而且,如图4所示,GMAN避免使图像颜色变暗以及物体边缘的过度锐化。 相反,从图4可以看出,DCP方法[3]使去雾图像的光强度变暗,并且在高深度值区域(例如,天空)中引起颜色失真;

在这里插入图片描述

虽然MSCNN [8]在这些高深度值区域表现良好,但其性能在目标图像的中深度区域会降低。 因此,提出的GMAN可以克服许多这些问题并产生更好的无雾图像。

我们还在SOTS室内数据集上测试了我们的网络(见表II)。 在这种情况下,性能并不那么令人印象深刻,并且在DehazeNet,GFN和AOD-Net之后排名第四。 尽管如此,即使在室内数据集上,人们仍然可以看到模型无关的dehaze方法的巨大希望。 事实上,同样作为模式诊断网络家族的一员,GFN在PSNR方面排名第二,在SSIM方面排名第一(几乎与排名靠前的DehazeNet并列)。 我们的初步结果表明,通过整合和概括GMAN、GFN的基础和概念,可以设计一个更强大的模型无关网络,在SOTS室外和室内数据集上支配所有现有的网络(特别是那些基于插件原理的网络)。 这一系列研究将在后续工作中报告。