第8章 提升方法

提升boosting方法:在分类问题中,它通过改变训练样本地权重,学习多个分类器,并将这些分类器进行线性组合,提高分类地性能;

8.1 提升方法AdaBoost算法

“三个臭皮匠赛过诸葛亮”

- 强可学习&弱可学习:PDF153;

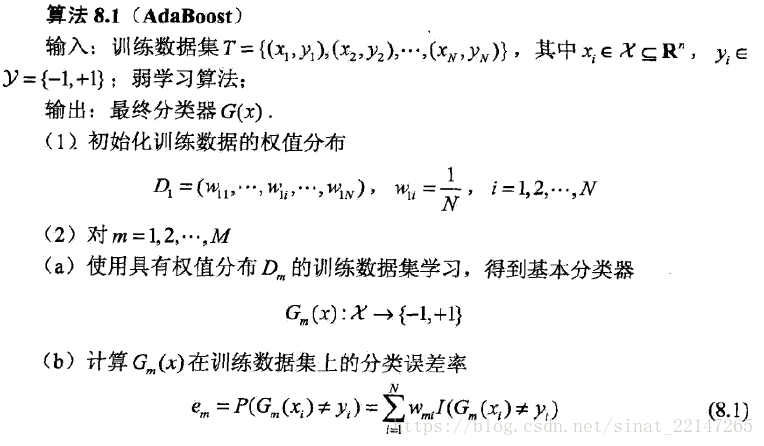

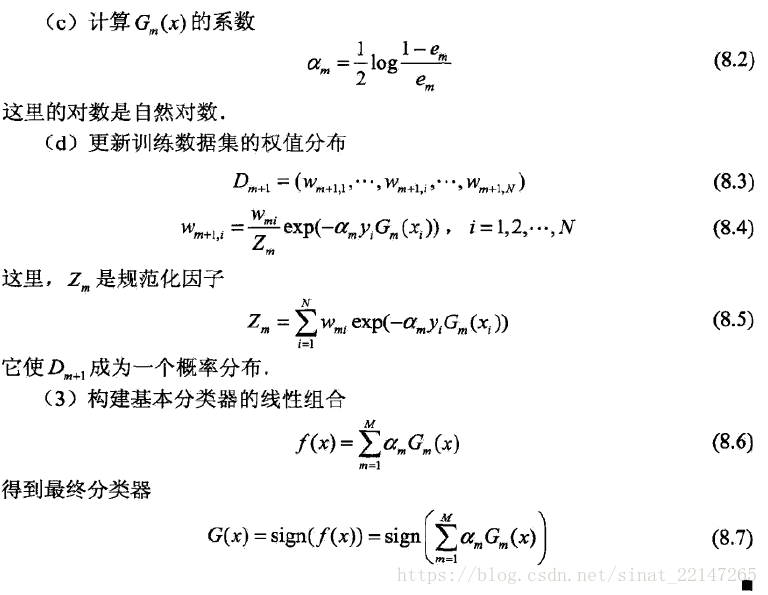

- AdaBoost算法:将“弱学习算法”提升为“强学习算法”;提高那些被前一轮弱分类器错误分类样本的权值,降低那些被正确分类样本的权值;采取加权多数表决的方法组合弱分类器;(详见PDF155)

- 算法性质:在学习过程中不断减少训练误差,即在训练数据集上的分类误差率;训练误差是以指数速率下降的;AdaBoost能适应弱分类器各自的训练误差率;

8.3 AdaBoost算法的解释

- AdaBoost算法另一理解:模型为加法模型、损失函数为指数函数、学习算法为前向分布算法时的二类分类学习方法;

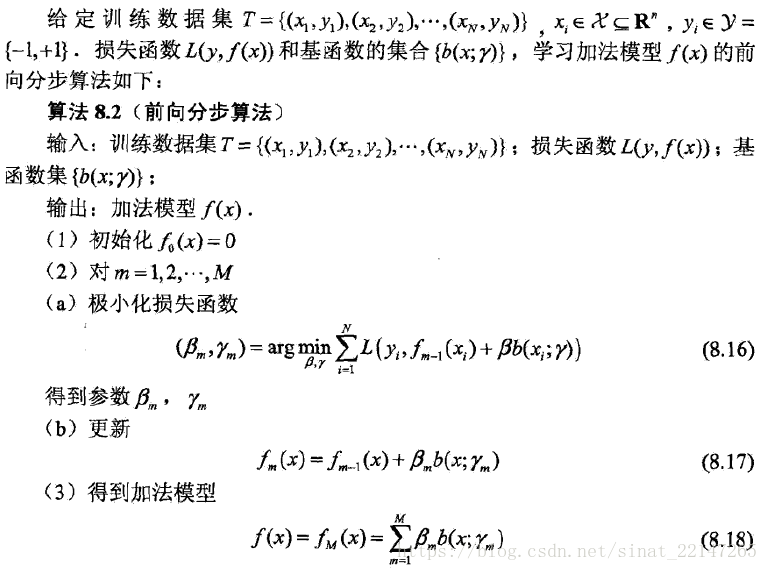

- 前向分步算法:求解优化问题——经验风险极小化即损失函数极小化问题,从前向后每一步只学习一个基函数及其系数,逐步逼近优化目标函数;

- 与AdaBoost算法的关系:AdaBoost算法是前向分步加法算法的特例,这时,模型由基本分类器组成的加法模型,损失函数是指数函数;(证明详见PDF161)

8.4 提升树

指以分类树或回归树为基本分类器的提升方法;

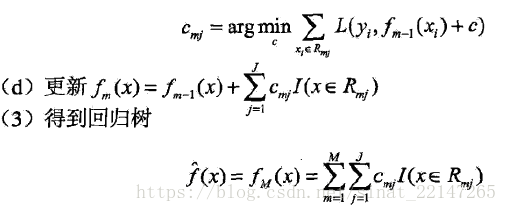

提升树模型:实际采用加法模型(即基函数的线性组合)与前向分步算法,以决策树为基函数的提升方法称为提升树;

提升树算法:前向分步算法;

梯度提升算法:利用损失函数的负梯度在当前模型的值作为回归问题提升树算法中的残差的近似值,拟合一个回归树;

这一章很多算法没弄明白,基本概念掌握了,之后还需学习。