版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/pku_langzi/article/details/82793555

文章的主要贡献点如下:值得学习的是,文章的写作挺好的。

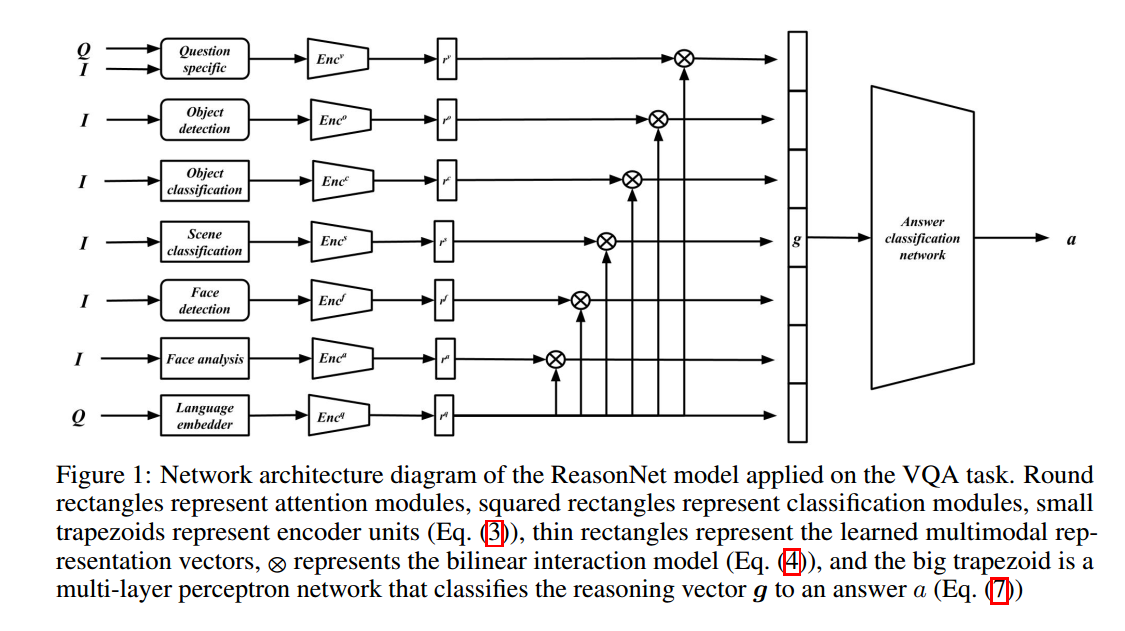

文章的一个主要思想就是modular neural network,通过学习关于question与image的多模态(multimodal)与多方面(multifaceted)的表征,在VQA1.与VQA2.0上取得不错效果。

如上图所示,主要分为6个module

(1)对resnet提出的

做question guided的attention,得到

(2)object detection检测出的物体做attention,得到

,pretrained on existing work.

(3)object classification,其类别标签文本,得到

,pretrained on COCO.

(4)scene classification,其类别标签文本,得到

, pretrained on place365.

(5)face detection做attention,得到

, pretrained on existing face work.

(6)face根据gender,emotion,age分类标签,得到

每个module的输出分别于question进行bilinear交互,最终拼接成一个向量 ,作为分类的输入。

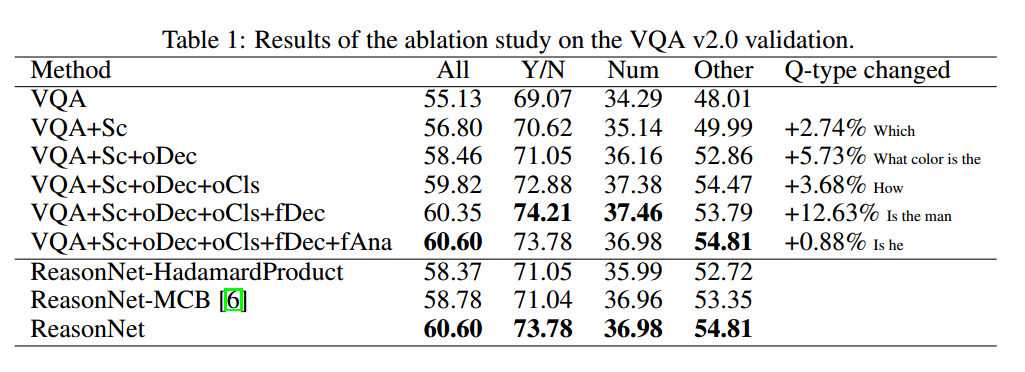

Ablaion study

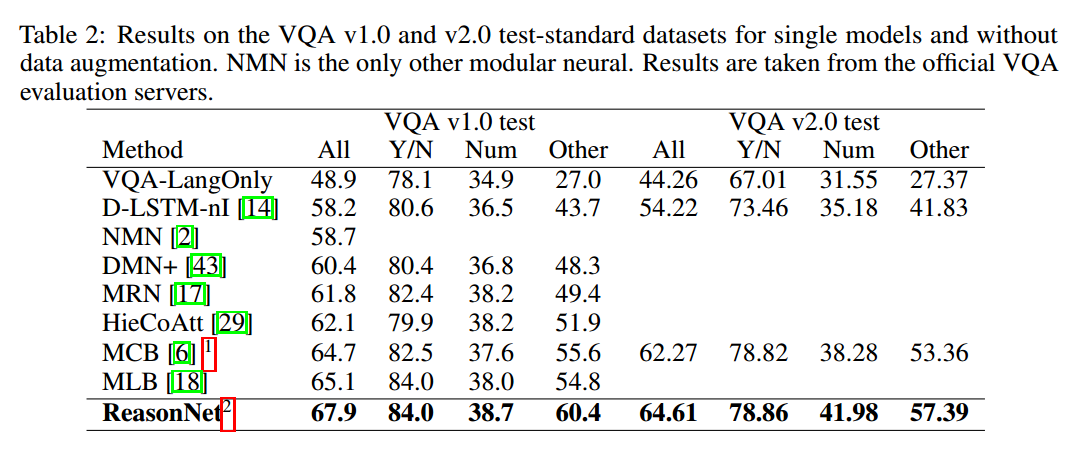

Comparing with state of the art