版权声明:转载请注明出处http://blog.csdn.net/xuaho0907 https://blog.csdn.net/xuaho0907/article/details/84937398

机器学习中的“向量”是指的只有一列的“矩阵”,这个矩阵有多少行就称其为有多少维度

矩阵的加(减)法:两个矩阵必须维度相同(行数列数相同)才可以加减,对应的元素相加减

矩阵的乘(除)法:

1、标量与矩阵的乘(除)法:标量与矩阵中的每个元素进行相乘(除)【符合乘法交换律,结果一样;符合乘法结合律】

2、矩阵与矩阵的乘法:前行乘后列,前面矩阵的列数要和后一个矩阵的行数相同,最终得到一个前行数X后列数维的矩阵【不符合乘法交换律;符合乘法结合律】例如:

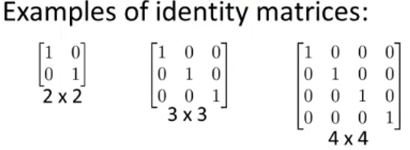

单位矩阵:主对角线上全为1,其余位置全为0的矩阵,例如:

任何矩阵乘以单位矩阵都为其本身,单位矩阵与标量乘法里面的“1”相同,不同维度矩阵的单位矩阵维度也不同,单位矩阵的维度可以通过与之相乘矩阵的行或者列来确定,例如:

逆矩阵:相当于实数中的“倒数”概念,任何矩阵乘以它的逆矩阵都等于单位矩阵,例如:

扫描二维码关注公众号,回复:

4449546 查看本文章

只有方阵才有逆矩阵! 不存在逆矩阵的矩阵称之为奇异矩阵或者退化矩阵

矩阵的转置:原矩阵的行变为列,原矩阵的列变为行,形成原矩阵的转置,例如:

转置矩阵的定义为:Aij = Aji