AlexNet在ImageNet LSVRC-2012上取得了top-1 和top-5错误率分别为37.5%和17.0%的好成绩,获得了冠军。它使用的神经网络有600000个参数,650000个神经元,五个卷积层和三个全连接层,并且使用了双GPU进行训练。

- 采用的数据集是ImageNet数据集,包含22000种类别共150多万张带标签的高分辨率图像。ILSVRC是ImageNet的子集,包含1000个类别每个类别包含约1000幅图片。总的来说,有约120万张训练图像,5万张验证图像和15万张测试图像。

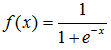

- 使用了ReLU非线性函数。相比普通的

或者

或者  这种饱和的非线性函数,文中用到的ReLU函数在同样深度的卷积神经网络的训练速度要快好几倍。

这种饱和的非线性函数,文中用到的ReLU函数在同样深度的卷积神经网络的训练速度要快好几倍。 - 多GPU训练。本网络中使用了两个GTX580 GPU并行训练,大多数层上都是单独训练。并且只在某些层(第三个卷积层和第一个全连接层)上两个GPU之间进行通信。

- 在某些特定层中使用了局部响应归一化(LRN)。实现了lateral inhibition,稍微降低了错误率。

- 使用了重叠池化。传统的池化方案是令步长s等于池化单元边长z,但作者使用的是s<z,减少了过拟合。

- 采用的8层结构:前面是五层卷积层,最后面是三层全连接层,ReLU非线性变换应用于每一个卷积和全连接层的输出。全连接层中的神经元和前一层中的所有神经元相连接。响应归一化层跟着第一和第二层卷积层。最大池化层既跟着响应归一化层也跟着第五层卷积层。第二、四、五层卷积层的核只和同一个GPU上的前层的核特征图相连。第三层卷积层和第二层所有的核特征图相连接。两个GPU的信息交换发生在第三个卷积层和第一个全连接层。

- 防止过拟合:采用了数据增强和dropout技术。

- 数据增强,包括生成平移图像和水平翻转图像,改变训练图像的RGB通道的强度。对整个ImageNet训练集的RGB像素值进行了PCA

- Dropout, 它将每一个隐藏神经元的输出以50%的概率设为0。这些以这种方式被“踢出”的神经元不会参加前向传递,也不会加入反向传播。因此每次有输入时,神经网络采样一个不同的结构,但是所有这些结构都共享权值。这个技术降低了过拟合

8,采用了随机梯度下降