- 项目网址:https://davischallenge.org/davis2016/code.html

- 稠密标注的视频目标分割数据集

- 可以用于半监督和无监督的方法检验

- 可以用于目标分割问题,也可以用于运动检测问题

- 有训练集,但测试集包含训练集

- 后续会更新如何使用该数据集

目录

1.摘要

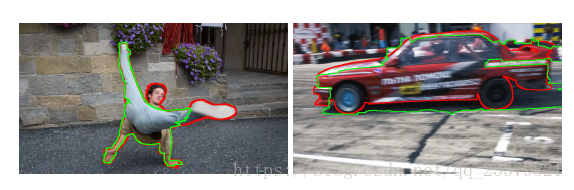

DAVIS由50个高质量,全高清的视频序列组,包含有多个视频目标分割挑战,如遮挡,运动模糊和外观变化。每一个视频都是稠密标注,像素级别的精度和逐帧的真值分割。

3.数据集介绍

根据对现有数据集的经验,我们首先确定我们应该关注的四个关键方面,以创建一个平衡和全面的数据集。

3.1数据数量和质量

足够大数量的数据是必要的,这可以保证内容的多样性,并且提供一组均匀分布的挑战。

并且,有足够的数据对于以下方面至关重要:避免算法过拟合,延迟性能饱使数据集保持一个较长的使用寿命。

质量也是很重要的,因为数据集的质量需能反映现有技术的水平。

综上原因,DAVIS构成包括50个序列总共3455标注帧,视频帧率为24fps,1080p分辨率。

由于计算复杂度是视频处理的一个重要瓶颈,DAVIS中的视频序列采用较短的时间长度(2-4秒),但是却涵盖了大部分在长视频序列中找到的挑战。

3.2实验验证

对于视频中的每一帧,我们提供像素级别的精度,以二进制掩码的方式手工创建分割。

虽然我们细分DAVIS为训练和测试集,为未来的工作提供指导,但是在我们的评估时,不使用分区,而是考虑整个数据集,因为大多数的评估方法不需要训练,并且由于计算复杂度,网格搜索最优参数的估计是不可行的。

3.3对象存在

直观地说,每个序列应该至少包含一个目标的前地对象,以用于与背景区域进行分离。

DAVIS的剪辑中包含一个对象或两个空间连接的对象。

我们选择不具有多个具有显著运动的不同对象,以便能够公平地比较在单个对象上操作的分割方法与联合分割多个对象的分割方法。

此外,每个序列只有一个对象,可以消除由全自动方法执行的检测的歧义。(这个不理解,为嘛全自动执行的检测方法会出现歧义)

在[27]中做出的一个类似的设计选择已经成功地指导了显着目标检测的研究,从它的开始到目前的最先进的。为了确保足够的内容多样性(这是全面评估不同算法性能所必需的),数据集跨越四个均匀分布的类(人类、动物、车辆、对象)和多个动作。

3.4无约束视频的挑战

为了能够对算法的性能进行更深入的分析和理解,识别可能影响算法性能的关键因素和环境是至关重要的。

因此,受文献[50]的启发,我们定义一个扩展的视频属性集合,用于代表特殊情况,如快速运动,遮挡和杂乱背景这些典型的视频分割挑战。

对应的属性陈列在下表。

| ID | Description | 描述 |

| BC |

Background Clutter. The back- and foreground regions around the object boundaries have similar colors ( |

复杂的背景。在目标边界附近的背景前景区域有相似的颜色。 |

| DEF | Deformation. Object undergoes complex, non-rigid deformations. | 形变。目标存在复杂的非刚性的形变。 |

| MB | Motion Blur. Object has fuzzy boundaries due to fast motion. | 运动模糊。由于快速的运动,目标边界模糊。 |

| FM | Fast-Motion. The average, per-frame object motion, computed as centroids Euclidean distance, is larger than |

快速运动。目标平均的帧间运动距离大于20像素,距离定义为质心的欧几里得距离。 |

| LR | Low Resolution. The ratio between the average object bounding-box area and the image area is smaller than tlr = 0.1. | 低分辨率(小目标)。平均目标边框区域与图像区域的比值小于tlr = 0.1。 |

| OCC | Occlusion. Object becomes partially or fully occluded. | 遮挡。目标部分或全部被遮挡。 |

| OV | Out-of-view. Object is partially clipped by the image boundaries. | 视野之外。目标被图像边框裁剪了部分,即只有部分目标处于视野中。 |

| SV | Scale-Variation. The area ratio among any pair of boundingboxes enclosing the target object is smaller than |

尺度变化。存在一对包围目标对象的边界框(两帧),他们的面积比小于0.5。 |

| AC | Appearance Change. Noticeable appearance variation, due to illumination changes and relative camera-object rotation. |

外观变化。由光照变化和相对的相机-目标旋转导致的显著外观变化。 |

| EA | Edge Ambiguity. Unreliable edge detection. The average groundtruth edge probability (using [11]) is smaller than |

边沿模糊。不可靠的边沿检测。平均真值边界的概率小于0.5. |

| CS | Camera-Shake. Footage displays non-negligible vibrations. | 相机抖动。画面显示不可忽略的振动。 |

| HO | Heterogeneus Object. Object regions have distinct colors. | 颜色不均匀的目标。目标区域有不同的颜色。 |

| IO | Interacting Objects. The target object is an ensemble of multiple, spatially-connected objects (e.g. mother with stroller). |

交互的对象。目标对象是多个空间连接的对象(例如母亲和婴儿车)的集合。 |

| DB | Dynamic Background. Background regions move or deform. | 动态背景。背景区域移动或者形变。 |

| SC | Shape Complexity. The object has complex boundaries such as thin parts and holes. |

复杂形状。目标有复杂的边界,比如很细的部分或者洞。 |

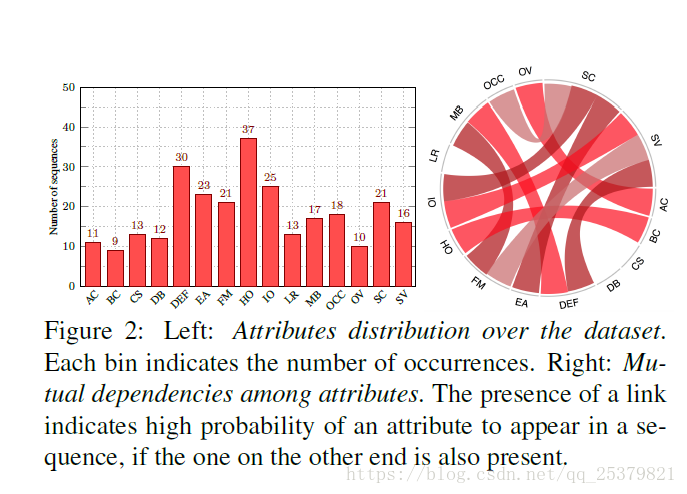

这些属性并不具备排他性,因此一个视频序列可以被标注多个属性。他们在数据集中的分布展示在下图左中,图右显示他们两两之间的依赖关系。注释使我们能够将性能分析解耦到具有主要特征的不同组中(例如遮挡),从而更好地理解每种方法的优缺点。

4.实验验证

为了判断分割的质量,如何选择合适的度量标准在很大程度上取决于最终应用程序的最终目标。

直观上讲,当视频分割主要用于更大处理管道中的分类器时,例如解析大型数据集时,强调错误标记的像素的最少数量是非常有意义的。

另一方面,在视频编辑应用中,轮廓的准确性和结果在时间域上的稳定性是最重要的,因为这些属性通常需要最艰苦和耗时的手工输入。

为了全面地涵盖上述方面,我们使用三个互补的误差指标来评估视频分割结果。

我们在4.1节中描述了度量标准,并在4.2节中对它们的互补属性进行了实证验证。

4.1度量标准选择

在有监督的评估框架中,给定一个特定帧上的groundtruth-mask G和一个输出的分割结果M,任何评估措施最终都必须回答一个问题,即M如何适合G。

在[37]中,对于图像,可以使用两个互补的观点,基于区域和基于轮廓的度量。

由于视频将静态图像的维数扩展到时间,因此还必须考虑结果的时间稳定性。

我们的评估基于以下测量。

区域相似度(Region Similarity  )

)

为了测量基于区域的分割相似度,即错别字像素的数量,我们使用Jaccard索引。

定义为估计分割和真值掩膜之间的IoU(Intersection over Union)。

自从在PASCAL VOC2008目标跟踪挑战中首次出现以后,Jaccard索引已经被广泛应用。

Jaccard索引提供了关于错误分类像素的、直观的和尺度不变的信息。

给定输出分割和真值掩膜

,Jaccard索引定义为:

。

边沿精度(Contour Accuracy  )

)

从基于轮廓的角度来看,可以将M解释为一组限定掩模空间范围的闭合轮廓c(M)。

因此,通过一个二分图匹配以提高对小误差的鲁棒性,我们可以比较和

的边缘点计算基于轮廓的精度

和召回

。

我们认为F-score 可以取得精度和召回之间较好的权衡,定义为:

为了提高效率,在我们的实验中,我们使用形态学算子近似替代了二分匹配。

时间稳定性(Temporal stability  )

)

直观地, 测度了两个掩膜间像素的匹配度,

测量了边缘的精度。

但是,结果的时域稳定性是视频对象分割中的一个相关重要的方面,由于对象形状的演化是识别和抖动的一个重要线索,不稳定的边界在视频编辑应用中是不可接受的。

因此,我们还引入了一种时间稳定性测量方法来惩罚这种不期望的效果。

关键的挑战是区分物体的可接受的运动和不需要的不稳定性和抖动。

为此,我们估计了在一帧掩码转换到下一帧所需的变形。直观地说,如果转换是平滑和精确的,结果可以认为是稳定的。

在形式上,我们将帧t的掩膜转换为代表其轮廓的多边形

。然后,我们使用形状上下文描(SCD)[3]述符描述每个点

。接下来,我们将匹配设置为动态时间扭曲(DTW)[39]问题,是我们寻找

和

之间的匹配,它最小化了匹配点之间的SCD距离,同时保持了点在形状中出现的顺序。

每匹配点的平均成本作为时间稳定性的度量。直观上,匹配将补偿运动和小的变形,但它不会补偿曲线的振荡和误差,这是我们想要测量的。遮挡和非常强的变形会被误解为轮廓不稳定,因此我们在没有这种影响的情况下计算序列子集的测量值。

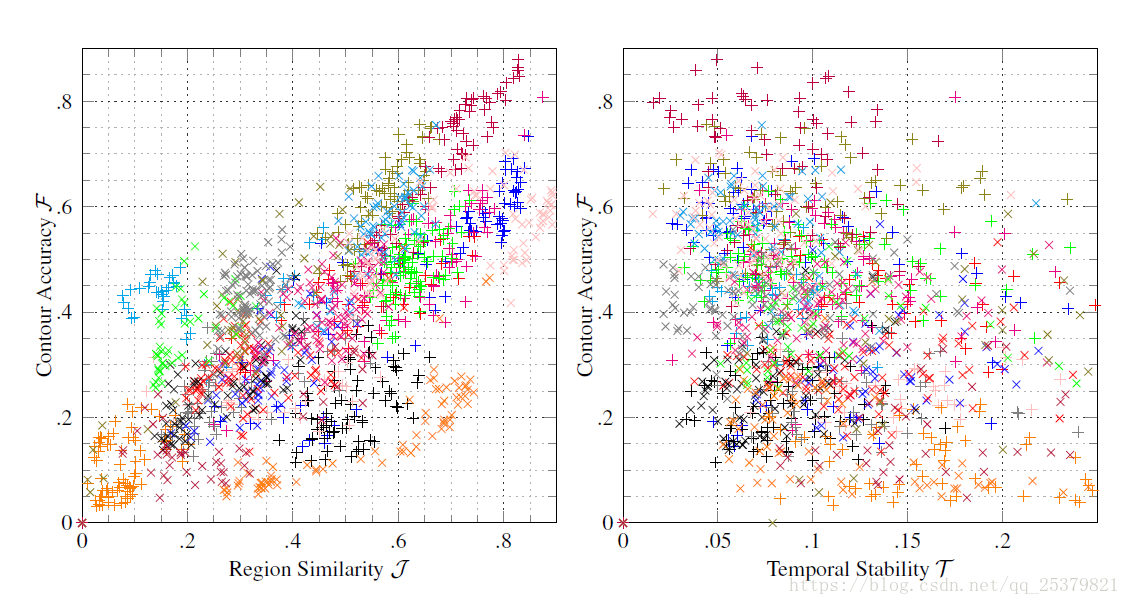

4.2指标之间的关系

相关性

从结果统计图中可以看出和

之间有明显的线性相关。

和

之间则没有。

差异性

左图结果低但

高,右图

高但

低