“Ensemble methods” is a machine learning paradigwhere multiple(homogenous/heterogeneous)individual leaners are generated and combined forthe same problem.

集成学习通过构建并结合多个学习器来完成学习任务,有时也被成为多分类器系统。

一、介绍

集成学习的一般结构:

1.先生成一组个体学习器

2.再用某种策略将他们结合起来。

集成学习分为同质和异质。同质的集成包含的同种类型的个体学习器,通常称为基学习器;异质的当然包含的是不同的个体学习器,通常称为组件学习器。

集成学习可显著提高“弱学习器”的泛化能力。

学习的关键:

个体学习器应该“好而不同”。即个体学习器有一定的“准确性”(错误率小一点),并且要有“多样性”,即学习器间具有差异。

根据个体学习器的生成方式,目前的集成学习方法大致分为两大类:

1.个体学习器之间存在强依赖关系、必须串行生成的序列化方法,比如Boosting

2.个体学习之间不存在强依赖关系(相对独立),可同时生成的并行化方法,比如Bagging和“随机森林”。

二、Boosting(串行生成)

1.机制:

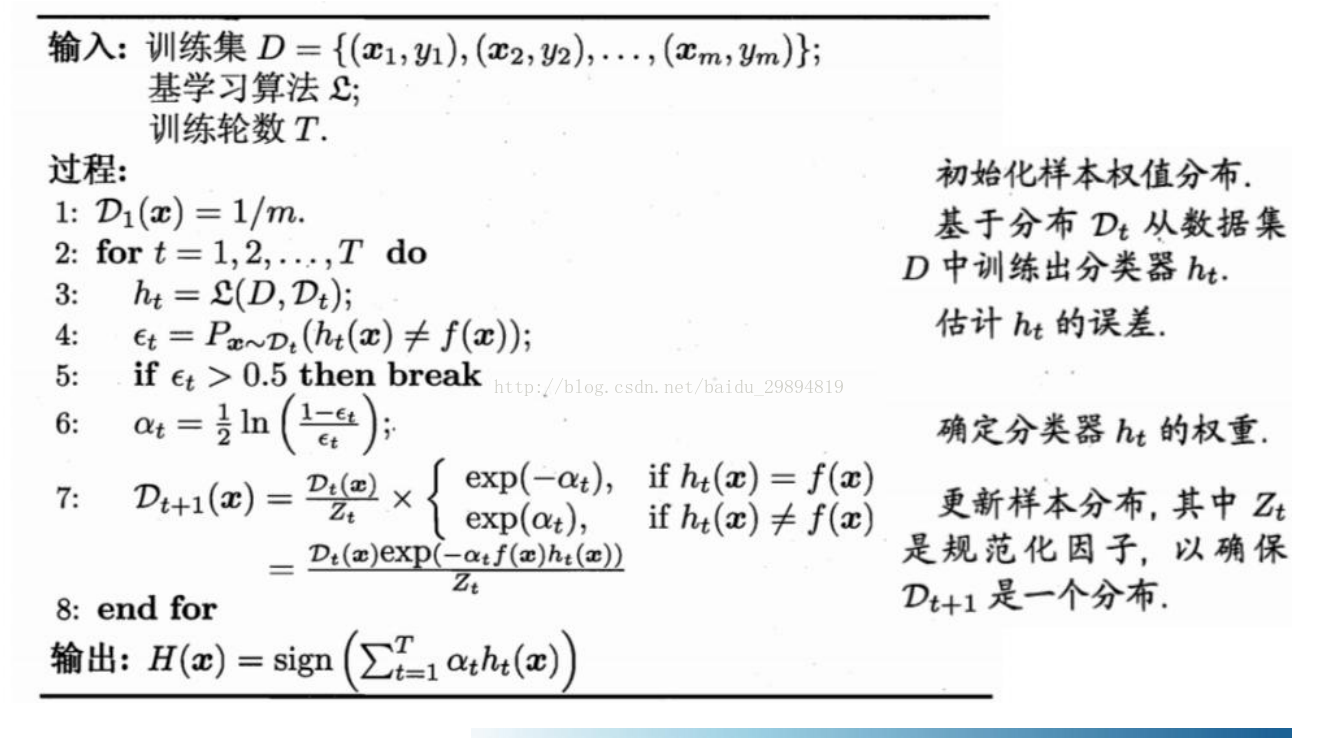

先从初始训练集训练出一个基学习器,再根据基学习器的表现对训练样本分布进行调整,使得先前学习器做错的训练样本受到更多的关注,然后基于调整后的样本分布来训练下一个基学习器;如此重复进行,直至得到T个学习器,最终将这T个学习器进行加权结合。

2.代表:adaboost

先给初始样本集一个分布,每个样本有一个初始权重

在使错误率最低的情况下得到一个学习器()

增大使用这个学习器学习,学习错误的样本的权值,得到一组新的样本权值

在新的样本上学的新的学习器,如此迭代下去。

2.分析优缺点:

从偏差-方差分解的角度看,boosting主要关注降低偏差,因此boosting能基于泛化能力相当弱的学习器构建出很强的集成。

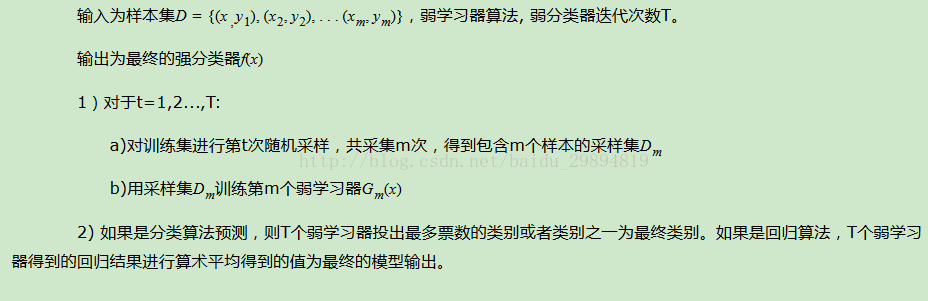

三、Bagging(并行生成)

1.机制:

基于自助采样法,给定包含m个样本的数据集,我们先随机取出一个样本放入采样集中,再放回

如此循环n次,得到一个训练集。初始训练集中约有63.2%的样本出现在采样集中。

循环上述两步T次,得到T个采样集,基于每个采样集训练出一个基学习器,再将这些学习器进行结合。

2.优缺点:

剩余的36.8%的样本可用于验证集来对学习器的泛化性能进行“包外估计”。

从偏差-方差来分析:关注降低方差,因此他在不剪支的巨额擦书、神经网络等易受样本扰动的学习器上效用更为明显。

四、随机森林(并行生成)

1.机制:

是bagging的一个扩展变形,在以决策树为基学习器构建bagging集成的基础上,进一步在决策树的训练过程中引入了随机属性的选择。具体来说,传统决策树在选择划分属性时是在当前节点的属性集合中选择一个最优属性,而在RF中,对及决策树的每个节点,先从该节点的属性集合中随机选择一个包含K个属性的子集,然后再从整个k个子集中选择一个最优属性用于划分。

五、结合策略

1.平均法

加权平均法

2.投票法

绝对多数投票法

相对多数投票法

加权投票法

3.学习法

通过另一个学习器进行结合。