机器学习-k近邻(KNN)

本篇主要是自己复习和总结机器学习算法中最基础入门的——k近邻(KNN)算法,内容由网上百度与摘抄唐宇迪老师的讲义。

k近邻介绍

——K最近邻(k-Nearest Neighbor,KNN),k近邻算法可以应用于分类场景与回归场景,是一个理论上比较不成熟的方法,也是最简单的机器学习算法之一。该方法的思路是:如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

——用官方的话来说,所谓K近邻算法,即是给定一个训练数据集,对新的输入实例,在训练数据集中找到与该实例最邻近的K个实例(也就是上面所说的K个邻居), 这K个实例的多数属于某个类,就把该输入实例分类到这个类中。

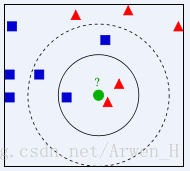

: 看图举例:

图形中有2种已知的图形,分别是蓝色的方块和红色的三角,绿色的未知图形。通过K近邻算法去判断未知的绿色图形是什么,取决于它周围距离最近的图形。

比如把K近邻的近邻参数设置成3(图中实线圆圈),那么未知的绿色图形就是三角。如果近邻参数设置成5(图中虚线圆圈),那么未知的绿色图形就是方块。

所以在K近邻算法中,设置近邻参数是会决定最后预测的结果准确性,那么怎么设置参数是多少呢?这个后面会给大家再进行介绍,本篇K近邻算法的实现主要是通过经典的机器学习库(sklearn)来完成。

K近邻在sklearn里面的API为sklearn.neighbors,在该模块下由细分了13个小的模块。本文主要使用neighbors.KNeighborsRegressor基于k-最近邻居的回归来进行说明官方教程链接

| 类型 | 描述 |

|---|---|

| neighbors.BallTree | BallTree用于快速广义N点问题 |

| neighbors.DistanceMetric | DistanceMetric类 |

| neighbors.KDTree | KDTree用于快速广义N点问题 |

| neighbors.KernelDensity([bandwidth, …]) | 核密度估计 |

| neighbors.KNeighborsClassifier([…]) | 实现k近邻的分类器投票 |

| neighbors.KNeighborsRegressor([n_neighbors, …]) | 基于k-最近邻居的回归 |

| neighbors.LocalOutlierFactor([n_neighbors, …]) | 使用局部异常因子(LOF)的无监督异常值检测 |

| neighbors.RadiusNeighborsClassifier([…]) | 在给定半径内的邻居之间实施投票的分类器 |

| neighbors.RadiusNeighborsRegressor([radius, …]) | 基于固定半径内的邻居的回归 |

| neighbors.NearestCentroid([metric, …]) | 最近的质心分类器 |

| neighbors.NearestNeighbors([n_neighbors, …]) | 用于实现邻居搜索的无监督学习者 |

| neighbors.kneighbors_graph(X, n_neighbors[, …]) | 计算X中点的k-邻居的(加权)图 |

| neighbors.radius_neighbors_graph(X, radius) | 计算X中各点的邻居(加权)图 |

k近邻参数

sklearn.neighbors.KNeighborsRegressor默认参数:

sklearn.neighbors.KNeighborsRegressor(n_neighbors = 5,weights =‘uniform’,algorithm =‘auto’,leaf_size = 30,p = 2,metric =‘minkowski’,metric_params = None,n_jobs = 1,** kwargs )

参数说明:

n_neighbors:int, optional (default = 5)

使用默认的邻居数量kneighbors查询,默认是5

weights : str or callable

权函数用于预测,可能的值

‘uniform’ :统一的重量。权重分在每个社区都是一样的

‘distance’ :重量分距离的倒数。在这种情况下,接近邻居查询的点会有一个更大的影响力远比邻居

[callable] :一个用户定义的函数接受一个数组的距离,并返回一个数组包含权重相同的形状

algorithm : {‘auto’, ‘ball_tree’, ‘kd_tree’, ‘brute’}, optional

算法用于计算最近的邻居

‘ball_tree’将使用BallTree

‘kd_tree’将使用KDTree

'brute’将使用蛮力搜索

‘auto’将试图确定最合适的算法基于价值观传递给合适的方法

leaf_size : int, optional (default = 30)

叶大小BallTree或KDTree传递。这可能影响施工和查询的速度,以及所需的内存存储树。最优值取决于问题的性质。

metric : string or callable, default ‘minkowski’

指标用于树的距离。默认度量是闵可夫斯基,p = 2相当于欧几里得度量的标准。看到的DistanceMetric类的文档的列表可用指标。

metric_params : dict, optional (default = None)

额外的关键字参数的度量函数

n_jobs : int, optional (default = 1)

并行工作的数量的邻居搜索。如果1,那么就业人数将CPU核的数量。不影响健康的方法。

官网例子

X=[[0],[1],[2],[3]] #建一个List

y=[0,0,1,1] #建一个List

from sklearn.neighbors import KNeighborsRegressor #导入K近邻回归模块

neigh=KNeighborsRegressor(n_neighbors=2) #近邻参数设置成2个相邻

neigh.fit(X, y) #使用X作为训练数据,y作为目标值

print(neigh.predict([[1.5]])) #给提供的数据预测对应的标签,当x=1.5的时候y应该是多少

#最终输出当x=1.5的时候y=0.5

| 类型 | 描述 |

|---|---|

| fit(X, y) | 使用X作为训练数据,y作为目标值(类似于标签)来拟合模型。 |

| get_params([deep]) | 获取估值器的参数。 |

| kneighbors([X, n_neighbors, return_distance]) | 查找一个或几个点的K个邻居 |

| kneighbors_graph([X, n_neighbors, mode]) | 计算在X数组中每个点的k邻居的(权重)图 |

| predict(X) | 给提供的数据预测对应的标签 |

| predict_proba(X) | 返回测试数据X的概率估值 |

| score(X, y[, sample_weight]) | 返回给定测试数据和标签的平均准确值 |

| set_params(**params) | 设置估值器的参数 |

k近邻实际应用

注:该实例出至唐宇迪老师,大家也可以百度查看

案例数据下载

案例背景:

自己在美国有一套房子想要在Airbnb平台上进行短租,但是不知道自己的房子能租多少钱?设置多少钱才是最合理的呢?

好吧,开始前我先说明一下我的房子情况:我的房子可以容纳6名旅客,有3个卧室,厕所每个卧室都有,有3张床,我想最短租1天我还是能接受的,最多租30天好像就差不多了。为了能收益最大我们直接来代码:

房租价格预测

导入所需要的Python模块

import pandas as pd #导入pandas库

from sklearn.neighbors import KNeighborsRegressor #导入机器学习库中的K近邻回归模型

from sklearn.metrics import mean_squared_error #导入机器学习库中的均方误差回归损失模型

导入数据及数据预处理

dc_listings=pd.read_csv(r'C:\Users\huangjunwen\Desktop\listings.csv') #将数据导入,路径请根据自己的文件路径设置

features = ['accommodates','bedrooms','bathrooms','beds','price','minimum_nights','maximum_nights','number_of_reviews'] #因数据太多设置只选取这8列

dc_listings = dc_listings[features] #获取只需要的数据列,并覆盖原始数据

dc_listings.head()#先查看一下数据情况,对数据有个初步了解

dc_listings['price']=dc_listings.price.str.replace("\$|,",'').astype(float) #将价格price变成数字类型

dc_listings=dc_listings.dropna() #过滤缺失数据

normalized_listings = dc_listings #复制一下数据

norm_train_df=normalized_listings.copy().iloc[0:2792] #创建训练集训练集取2792个样本

norm_test_df=normalized_listings.copy().iloc[2792:] #创建测试集取879个样本

数据列名说明 accommodates:可以容纳的旅客、bedrooms:卧室的数量、bathrooms:厕所的数量、beds:床的数量、price:每晚的费用、minimum_nights:客人最少租几天、maximum_nights:客人最多租几天、number_of_reviews:评论的数量

创建K近邻模型

cols = ['accommodates','bedrooms','bathrooms','beds','minimum_nights','maximum_nights','number_of_reviews'] #选择测试集的训练的列

knn = KNeighborsRegressor(10) #模型近邻值手动设置成10,其他为默认参数

knn.fit(norm_train_df[cols], norm_train_df['price']) #X放入训练集数据,Y放入目标输出数据

two_features_predictions = knn.predict(norm_test_df[cols]) #输出测试集结果

创建模型效果验证

two_features_mse = mean_squared_error(norm_test_df['price'], two_features_predictions)

two_features_rmse = two_features_mse ** (1/2)

print(two_features_rmse) #输出模型验证结果,根据结果调整近邻参数

调用模型设置实际值进行预测

print(knn.predict([[6,3,3,3,1,30,0]])) #设置自己房子的信息,预测出对应的价格

数字代表我房子与数量列对应的名称,容纳旅客数=6,卧室=3,厕所=3,床=3,最少租=1,最多租=30,评论=0

好了,我房子的一晚上价格大概能租192美元,哇!感觉自己好有钱。。。。好吧,能先给我来一套房子吗?