HDFS高可用分布式的搭建

注:此工作的搭建基于完全分布式的基础之上。

参考链接:https://mp.csdn.net/postedit/83003119

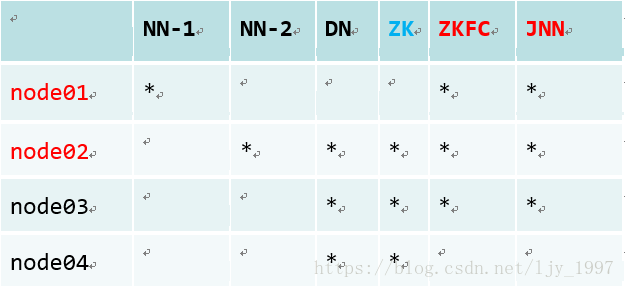

集群规划:

(1) 配置免密登录 (如果操作失败,搞乱了各个节点的密钥,删除 .ssh/目录下文件重新配置)

node01->node01 node01->node02 node01->node03 node01->node04

node02->node01

- 所有节点执行

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

- 在node01节点执行,将node01的公钥加入到其他节点的白名单中

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node02

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node03

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node04

- 在node02节点执行,将node01的公钥加入到其他节点的白名单中

ssh-copy-id -i ~/.ssh/id_rsa.pub root@node01

(2) 所有节点配置JDK(一台机器配置好后,直接推送到其余节点)

export JAVA_HOME=/opt/software/jdk/jdk1.8.0_151

export PATH=$PATH:$JAVA_HOME/bin

(3) 修改hdfs-site.xml配置文件

<property>

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<property>

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>node01:8020</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>node02:8020</value>

</property>

<property>

<name>dfs.namenode.http-address.mycluster.nn1</name>

<value>node01:50070</value>

</property>

<property>

<name>dfs.namenode.http-address.mycluster.nn2</name>

<value>node02:50070</value>

</property>

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node01:8485;node02:8485;node03:8485/mycluster</value>

</property>

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/var/sxt/hadoop/ha/jn</value>

</property>

<property>

<name>dfs.client.failover.proxy.provider.mycluster</name> <value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/root/.ssh/id_rsa</value>

</property>

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

(4) 修改core-site.xml配置文件

<property>

<name>fs.defaultFS</name>

<value>hdfs://mycluster</value>

</property>

<property>

<name>ha.zookeeper.quorum</name>

<value>node02:2181,node03:2181,node04:2181</value>

</property>

(5) 修改slaves配置文件

修改为(注意此处名称为竖排,不要留空格)

node02

node03

node04

(6) 关闭所有Java进程

killall java

(7) 格式化NameNode(创建目录以及文件)

① 在node01、node02、node03分别执行如下命令

hadoop-daemon.sh start journalnode

② 随机选择一台NameNode执行:

hdfs namenode –format

hadoop-deamon.sh start namenode

③ 另外一台NameNode执行:

hdfs namenode -bootstrapStandby

(8) 搭建zookeeper集群

1.node02节点上传zookeeper压缩包,点击下载

2.修改conf目录下的zoo_sample.cfg的名称,改为zoo.cfg

mv zoo_sample.cfg zoo.cfg

3.修改zoo.cfg(datadir可自行修改,其余三行需新增)

dataDir=/var/zfg/zookeeper

server.1=node02:2888:3888

server.2=node03:2888:3888

server.3=node04:2888:3888

4.在/var/zfg/zookeeper目录下创建一个myid文件

5.将配置好的zookeeper安装包拷贝到node03 node04

6.在node02节点 node03节点 node04节点的myid文件中写上当前节点ID号,node02写1,node03写2,node04写3;

(9)启动zookeeper

在node02、node03、node04的zookeeper文件的bin目录下启动 命令:

./zkServer.sh start

(10) 关闭所有节点上的进程

stop-dfs.h

(11) 启动HDFS

start-dfs.sh

(12) 操作HDFS文件系统

① 创建目录

hdfs dfs -mkdir -p /user/root

② 上传文件

hdfs dfs -D dfs.blocksize=1048576 -put