版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/qq_38906523/article/details/81556797

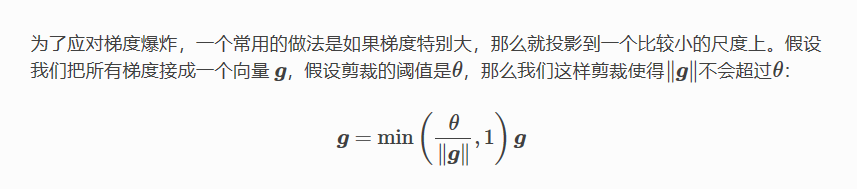

深度神经网络训练的时候,采用的是反向传播方式,该方式背后其实是链式求导,计算每层梯度的时候会涉及一些连乘操作,因此如果网络过深,那么如果连乘的因子大部分小于1,最后乘积的结果可能趋于0,也就是梯度消失,后面的网络层的参数不发生变化,后面的层学不到东西,那么如果连乘的因子大部分大于1,最后乘积可能趋于无穷,这就是梯度爆炸