本文介绍安装mac单机版的spark,和spark 集群安装 分以下步骤

- 安装scala

- 下载spark 压缩包并解压

- 修改spark的配置文件

- 配置环境变量

- 验证安装情况

安装Scala

下载spark压缩包并解压

到官网下载spark的安装包(我用的是spark-2.0.1-bin-hadoop2.7.tgz)

http://mirror.bit.edu.cn/apache/spark/

进入安装包存放目录,解压安装包

tar -zxvf spark-2.0.1-bin-hadoop2.7.tgz- 1

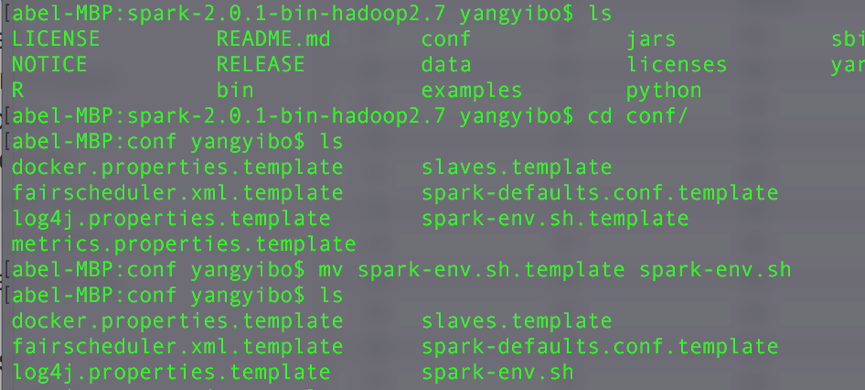

解压后进入conf 文件夹下将 spark-env.sh.template 改名为 spark-env.sh

mv spark-env.sh.template spark-env.sh- 1

操作如下图

单机版安装

修改spark的配置文件

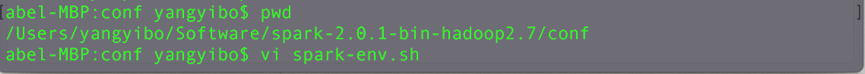

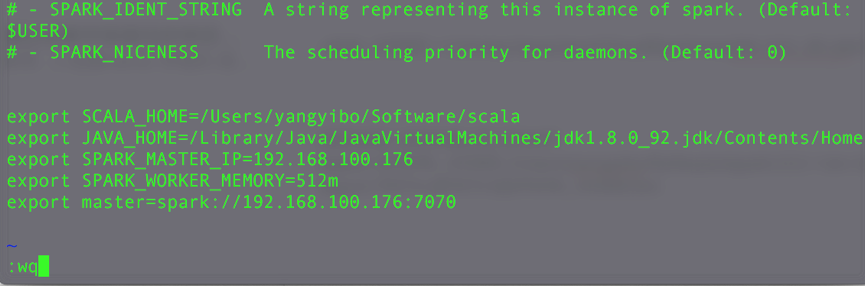

修改 spark-env.sh 文件添加信息

vi spark-env.sh

//添加如下信息

export SCALA_HOME=/Users/yangyibo/Software/scala

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_92.jdk/Contents/Home

export SPARK_MASTER_IP=192.168.100.176

export SPARK_WORKER_MEMORY=512m

export master=spark://192.168.100.176:7070

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

如下图

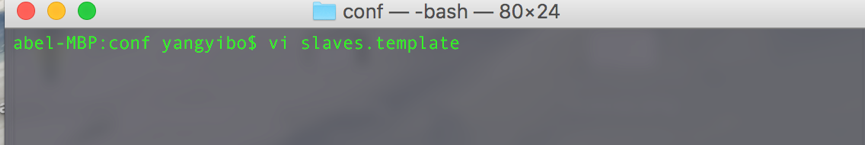

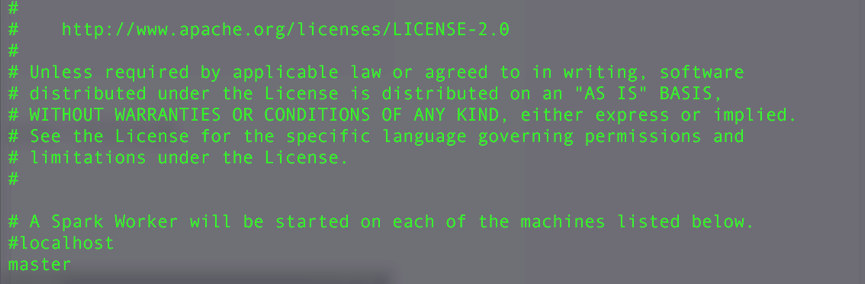

修改 slaves.template 添加信息

vi slaves.template

//添加如下信息

master- 1

- 2

- 3

如下图

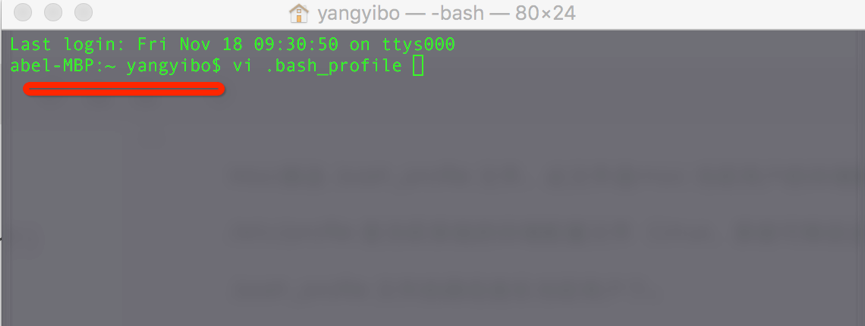

配置环境变量

Mac修改 .bash_profile 文件,此文件是mac 当前用户的环境配置文件。

/etc/profile 是当前系统的环境配置文件(Linux,系统可修改这个)

.bash_profile 文件的路径是在当前用户下。

操作如下:

新打开终端输入命令

vi .bash_profile

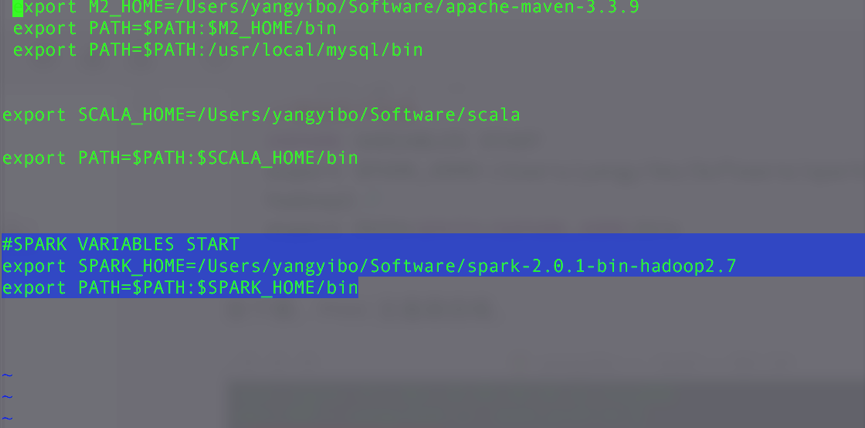

//添加如下信息

#SPARK VARIABLES START

export SPARK_HOME=/Users/yangyibo/Software/spark-2.0.1-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/bin- 1

- 2

- 3

- 4

- 5

如下图,mac 注意路径哦,

集群安装

修改slaves

集群安装与单机版安装相同 只是在修改 slaves.template 添加信息

vi slaves.template

//添加work 节点ip如下信息

192.168.100.23

192.168.100.24

192.168.100.25- 1

- 2

- 3

- 4

- 5

将配置好的单机版spark复制到work节点上

// 当然节点机器的 scala 和 jdk 的安装配置要和 master 相同

scp -rp /opt/apps/scala-2.11.7 root@work1IP:/opt/apps

scp -rp /opt/apps/jdk/current root@work1IP:/opt/apps

scp -rp /opt/apps/spark-2.2.1 root@work1IP:/opt/apps- 1

- 2

- 3

- 4

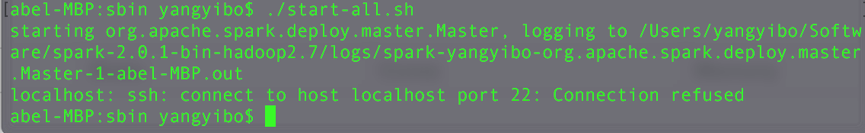

验证安装情况

此时就可以检验成果喽

进入安装包的sbin 目录执行 start-all.sh 脚本

./start-all.sh- 1

此时可能会出现这个情况,我们可以直接忽略

此时我们可以通过jps 命令 检验运行情况

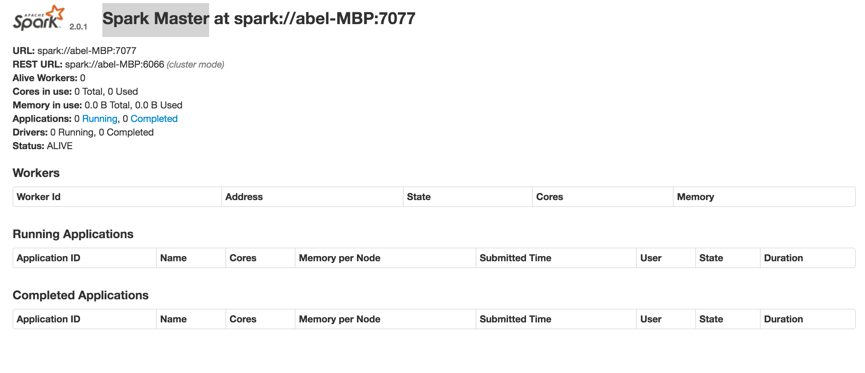

打开Spark Master 页面查看集群情况,我相信你会直接点击。

如图

停止spark

进入spark的sbin目录,执行命令

$ ./stop-all.sh- 1

如果要给已经启动的spark 集群附加 worker 节点的话 按照集群配置以后 进入sbin 目录以后:

通过start-slave.sh 脚本 启动一个 slave

sh start-slave.sh spark://192.168.100.xx:7077- 1

接下来就是spark 的小程序了

Spark进阶体验