很早就打算写这篇博客了,最近遇到的问题比较多,所以拖了又拖,今天问题似乎解决了,等着程序运行的时候再来回顾一下Batch Normalization算法。

Batch Normalization是2015年Google研究员在论文《Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift》一文中提出的,同时也将BN应用到了2014年的GoogLeNet上,也就是Inception-v2。

BN算法在很大程度上加速了训练过程,放宽了网络初始化的条件,论文中还提出有了BN可以在不使用Dropout,同时也可以在一定程度上提升网络的识别效果,在之后的ResNet等等新网络中有广泛的应用。

下面我们来详细的看一下BN算法。

1. 要解决的问题

自从2012年以来,CNN网络模型取得了非常大的进步,而这些进步的推动条件往往就是模型深度的增加。从AlexNet的几层,到VGG和GoogleNet的十几层,甚至到ResNet的上百层,网络模型不断加深,取得的效果也越来越好,然而网络越深往往就越难以训练。我们知道,CNN网络在训练的过程中,前一层的参数变化影响着后面层的变化(因为前面层的输出是后面的输入),而且这种影响会随着网络深度的增加而不断放大。在CNN训练时,绝大多数都采用mini-batch使用随机梯度下降算法进行训练,那么随着输入数据的不断变化,以及网络中参数不断调整,网络的各层输入数据的分布则会不断变化,那么各层在训练的过程中就需要不断的改变以适应这种新的数据分布,从而造成网络训练困难,难以拟合的问题。

(可以这样想,比如网络中每一层都是一个人,今天前面一层的人说要你往左走3,明天有让你往左走2,第三天又让你往右走5,结果三天下来,你还在原地,这样就让你的进度变慢了。PS:我是这样理解的,如有问题,请指出)

BN算法解决的就是这样的问题,他通过对每一层的输入进行归一化,保证每层的输入数据分布是稳定的,从而达到加速训练的目的。

2. BN算法流程

BN算法的理论推导我这里就不多说了(原因是理解的不透彻= =),这里只讲一下算法的流程。

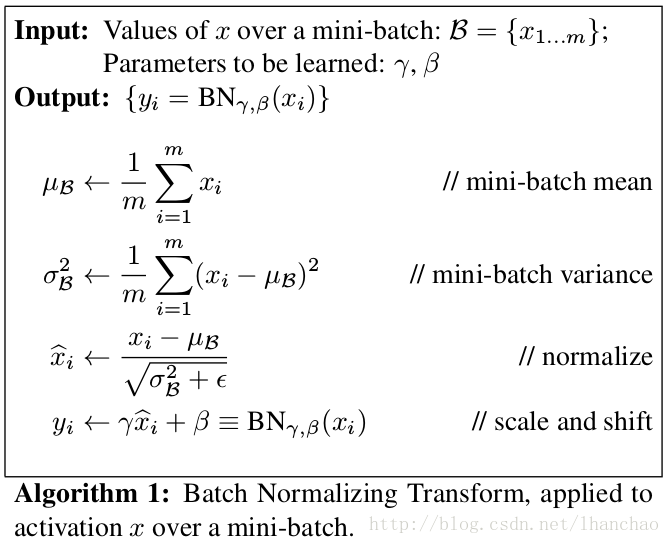

首先,BN算法在每一次iteration中的每一层输入都进行了归一化,将输入数据的分布归一化为均值为0,方差为1的分布,如下式:

但是这种做法有一个致命的缺点,尽管这样把每层的数据分布都固定了,但是这种分布不一定是前面一层的要学习到的数据分布,这样强行归一化就会破坏掉刚刚学习到的特征,BN算法的第二步就解决了这个缺点。

BN算法在第二步中设置了两个可学习的变量

2.1 BN算法在训练和测试时的应用

BN算法在训练时的操作就如我们上面所说,首先提取每次迭代时的每个mini-batch的平均值和方差进行归一化,再通过两个可学习的变量恢复要学习的特征。

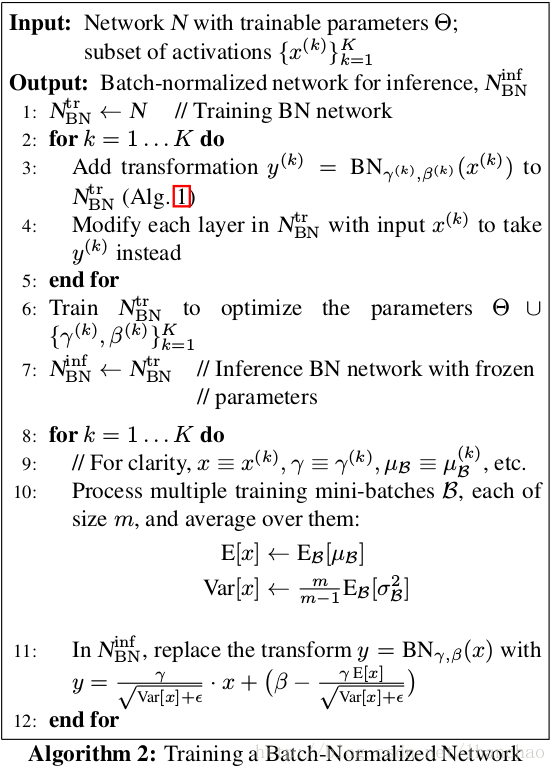

但是在实际应用时就没有mini-batch了,那么BN算法怎样进行归一化呢?实际上在测试的过程中,BN算法的参数就已经固定好了,首先进行归一化时的平均值和方差分别为:

最终BN算法的训练和测试的流程如下图所示:

2.2 BN算法在CNN中的应用

BN算法在CNN中往往放在每个卷积层之后,ReLU操作之前。在CNN中操作时,BN算法把每个特征图看作一个神经元,计算该特征图对应数据的均值和方差进行归一化,并且每个特征图对应两个学习变量

最后介绍一下BN在Caffe中的使用

layer {

bottom: "Convolution1"

top: "Convolution1"

name: "bn1"

type: "BatchNorm"

batch_norm_param {

use_global_stats: true

}

include {

phase: TEST

}

}

layer {

bottom: "Convolution1"

top: "Convolution1"

name: "bn1"

type: "BatchNorm"

include {

phase: TRAIN

}

}

layer {

bottom: "Convolution1"

top: "Convolution1"

name: "scale1"

type: "Scale"

scale_param {

bias_term: true

}

}Caffe中并没有实现BN层分为两个部分BatchNorm和Scale层,其中BatchNorm又根据use_global_stats的值分为两种,use_global_stats为true时该层的参数保持不变,这种应该应用在test的情况下,而train的过程中要保证use_global_stats一定不为true,当然,默认情况下use_global_stats为false。

——————————————————————————

关于Batch Normalization的更多介绍可以看原文也可以参考以下链接:

深度学习中 Batch Normalization为什么效果好?——知乎

深度学习(二十九)Batch Normalization 学习笔记

解读Batch Normalization