下面是自己对神经网络中batch_normalization(批标准特征化)的一个小结,很容易理解:

1.让每一层神经网络处理的数据更加具有规律性,从而神经网络也可以更加容易学习到数据中的规律。

2.对于一些激励函数,比如tan,激励函数只对一部分区间的数据比较敏感,其他地方的数据变化,做出的反应不大。

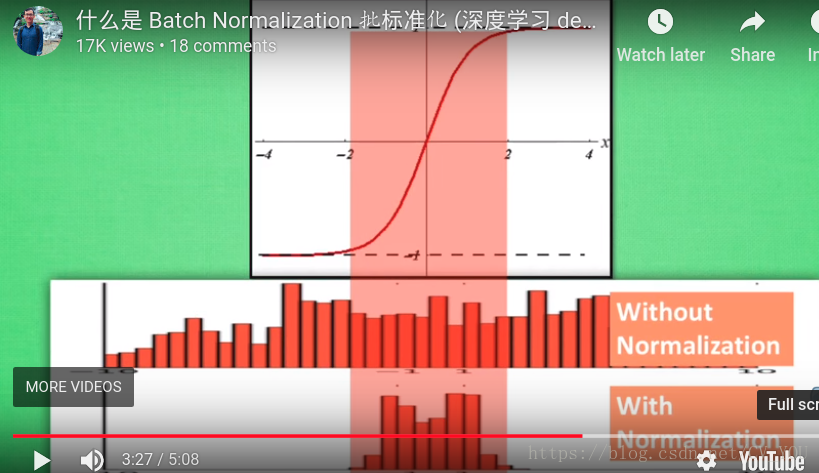

比如下面一个图:

数据只对图中红色区域比较敏感,而batch)normalization能把数据分布变到红色区域,发挥激活函数的作用。

3.BN层一般加在输出(比如全连接层)和激励函数之间,这样才起作用。

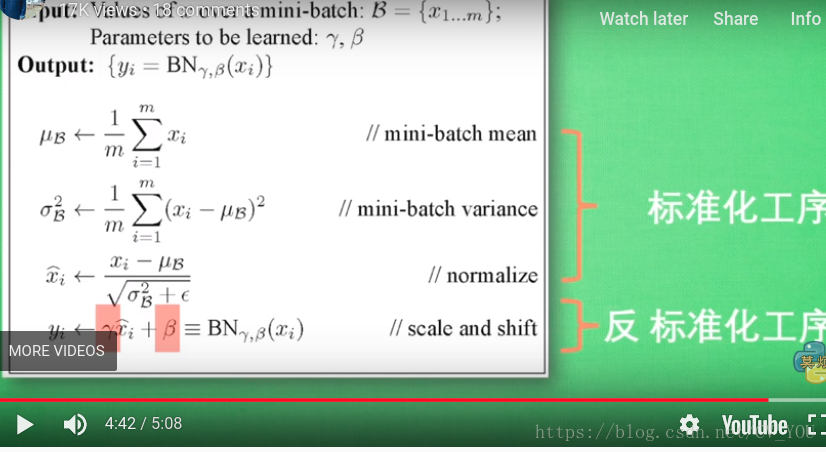

下面一个图是BN的简单数学原理:

最后一个公式是反标准化,主要是红色的两个参数,这两个参数可以进行训练,如果BN没有起到作用,可以缓解BN对数据处理造成的影响。