1.learning is impossible?

我们要通过给定的训练数据学习出一个g接近于f,首先我们学习出的g在给定的训练数据上结果与f一样,但是在我们给定的训练数据之外的数据,我们并不能保证g给出的输出是和f给出输出是一样的,因为我们并不知道f是什么,所以对于所学到的所有g,我们都有理由说g是错的,因为f不知道。这个问题被称为no free launch 即天下没有免费的晚餐。

2.probability to the Rescue

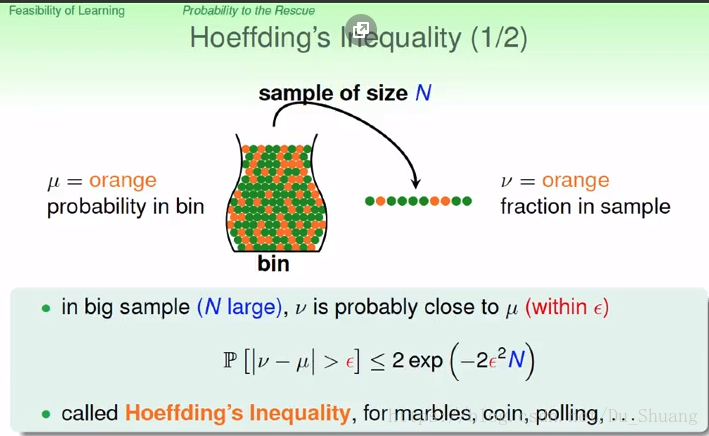

一个罐子里面orange和green球的比例是多少,我们不知道也不容易去计算,但是我们可以从罐子里面采样一部分出来然后计算出采样的orange和green球的比例,但是采样的球计算的比例和原比例差别大不大呢?

这个可以由上图的Hoeffding’s inequality来进行计算,当采样数越大,e越小,两个概率的差别就越小。

3.connection to learning

那么上面的规则怎么应用到机器学习中去呢?机器学习中的问题是我们怎么知道我们的假设h(x)是和f(x)有多接近呢?这可以类比于我们之前样本中的球的比例是否和罐子中的球的比例是一样的?

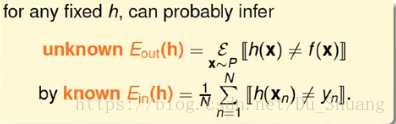

假设我们已经通过数据学得了一个h(x),我们现在要去判断这个h(x)和f(x)是不是接近的,我们假设我们对所有的数据都进行了判断并将这些数据当做球放到一个罐子里面去,h(x)和g(x)相同的数据当做绿球,不同的当做红球,红球与绿球的比例就是我们的相似度,然后我们对罐子里面的球进行采样并判断采样球的红球绿球比,然后根据采样球的红球绿球比推断出罐子里面的红球绿球比,即h(x)和f(x)的相似度。

我们将针对采样球的相似度称为Ein(h),针对整个罐子的相似度称为Eout(h).我们要做的就是根据Ein(h)推出Eout(h)。

4.connection to Real learning

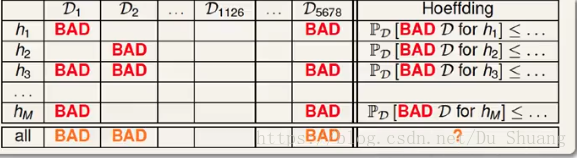

我们之前只是对其中一个h(x)进行判断,我们可以根据霍夫丁定理对该h(x)进行判定,即大部分情况下采样的数据的判定结果和罐子里面的结果是相差不多的,如果我们对多个h1(x),h2(x),h3(x),h4(x)…hi(x)进行判定我们需要选出最接近f(x)的h(x),但是这要求采样的数据对hi(x)的判定结果都和罐子里面的结果差不多,如果刚好一个采样结果判定h2(x)为最接近的(其实h2(x)不接近,只是这个采样结果刚好离正确结果很远而已)这就会导致最后的判断结果出错。

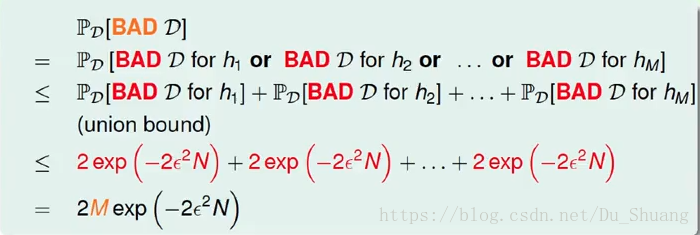

如上图所示,对一个假设进行判断的采样数据满足霍夫丁定理,即采样数据的结果与罐子里面的结果相差不大的概率较大,我们称相差比较大的采样为BAD(坏)数据,我们希望对于所有的假设都不要出现坏采样数据,而对于M个假设,不出现坏数据的概率计算如下:

即对有限个假设,我们的利用采样的方法进行评测选出的假设错误的概率是有上限值的即正确率是有下限的。