在上面博客中我们讨论了正则化的线性回归模型,下面我们来讨论一下正则化的逻辑回归模型。

前面我们讲述了两种常用于逻辑回归的方法:

- 基于梯度下降法的逻辑回归模型

- 基于高级优化的逻辑回归模型

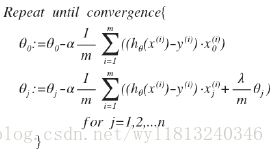

基于梯度下降法的逻辑回归模型:

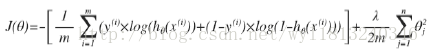

首先我们还是需要先设计加入正则化后的损失函数,与线性回归模型相似,我们只需要在原来逻辑回归损失函数的基础上加入正则化即可,于是,加入正则化后的损失函数为:

与线性回归模型相同,我们不对参数

值得注意的是:上面的式子看上去与线性回归的式子相同,但是由于假设的不同,所以与线性回归在本质上是不同的。同时不对参数

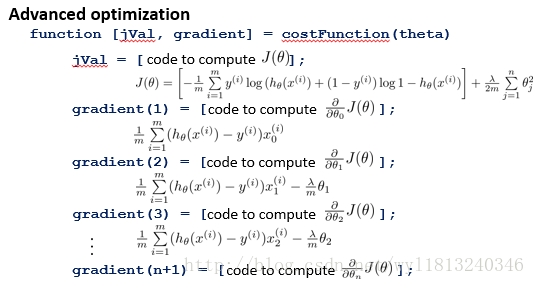

基于高级优化的正则化逻辑回归模型:

与原来讲述的额高级优化相同,在matlab中可以通过fminuc函数来实现最小化,值得注意的是参数

计算之后的损失函数,就可以使用fminuc函数进行最小化,具体的细节可以参考这里。