\documentclass{article}

\title{计算机视觉课堂报告}

\date{2018-4-25}

\author{姓名:xxx\\学号:xxxxxx}

\usepackage{CJKutf8}

\usepackage{amsmath}

\usepackage{graphicx}

\usepackage{indentfirst}

\setlength{\parindent}{2em}

\begin{document}

\begin{CJK}{UTF8}{gbsn}

\maketitle

\tableofcontents

\newpage

\section{Reading papers:Deep learning for edge detection}

\subsection{传统边缘检测算法概述}

\subsubsection{边缘的定义}首先介绍什么是边缘。在数字图像中,边缘是指图像局部变化最显著的部分,边缘主要存在于目标与目标,目标与背景之间,是图像局部特性的不连续性,如灰度的突变、纹理结构的图标、颜色的图标等。尽管图像的边缘点产生的原因各不相同,但他们都是图形上灰度不连续或灰度几句辩护的点,图像边缘分为阶跃状、斜坡状和屋顶状。

\subsubsection{边缘检测的基本方法}

\noindent一般图像边缘检测方法主要有如下四个步骤:\\

\indent1.图像滤波:传统边缘检测算法主要是基于图像强度的一阶和二阶导数,但导数的计算对噪声很敏感,因此必须使用滤波器来改善与噪声有关的边缘检测器的性能。需要指出的是,大多数滤波器在降低噪声的同时也造成了了边缘强度的损失,因此,在增强边缘和降低噪声之间需要一个折衷的选择。

\par2.图像增强:增强边缘的基础是确定图像各点邻域强度的变化值。增强算法可以将邻域(或局部)强度值有显著变化的点突显出来。边缘增强一般是通过计算梯度的幅值来完成的。

\par3.图像检测:在图像中有许多点的梯度幅值比较大,而这些点在特定的应用领域中并不都是边缘,所以应该用某种方法来确定哪些点是边缘点。最简单的边缘检测判断依据是梯度幅值。

\par4.图像定位:如果某一应用场合要求确定边缘位置,则边缘的位置可在子像素分辨率上来估计,边缘的方位也可以被估计出来。近20多年来提出了许多边缘检测算子,在这里我们仅讨论集中常见的边缘检测算子。

\subsection{论文中介绍的新颖边缘检测算法总结}

\subsubsection{Holistically-Nested Edge Detection}

\indent 这篇论文主要解决了两个问题:(1)基于整个图像的训练和预测;(2)多尺度和多水平的特征学习。该算法通过深度学习模型,完成了从图像到图像的预测,并通过学习到的丰富的分级特征,完成边缘检测中的细节问题。

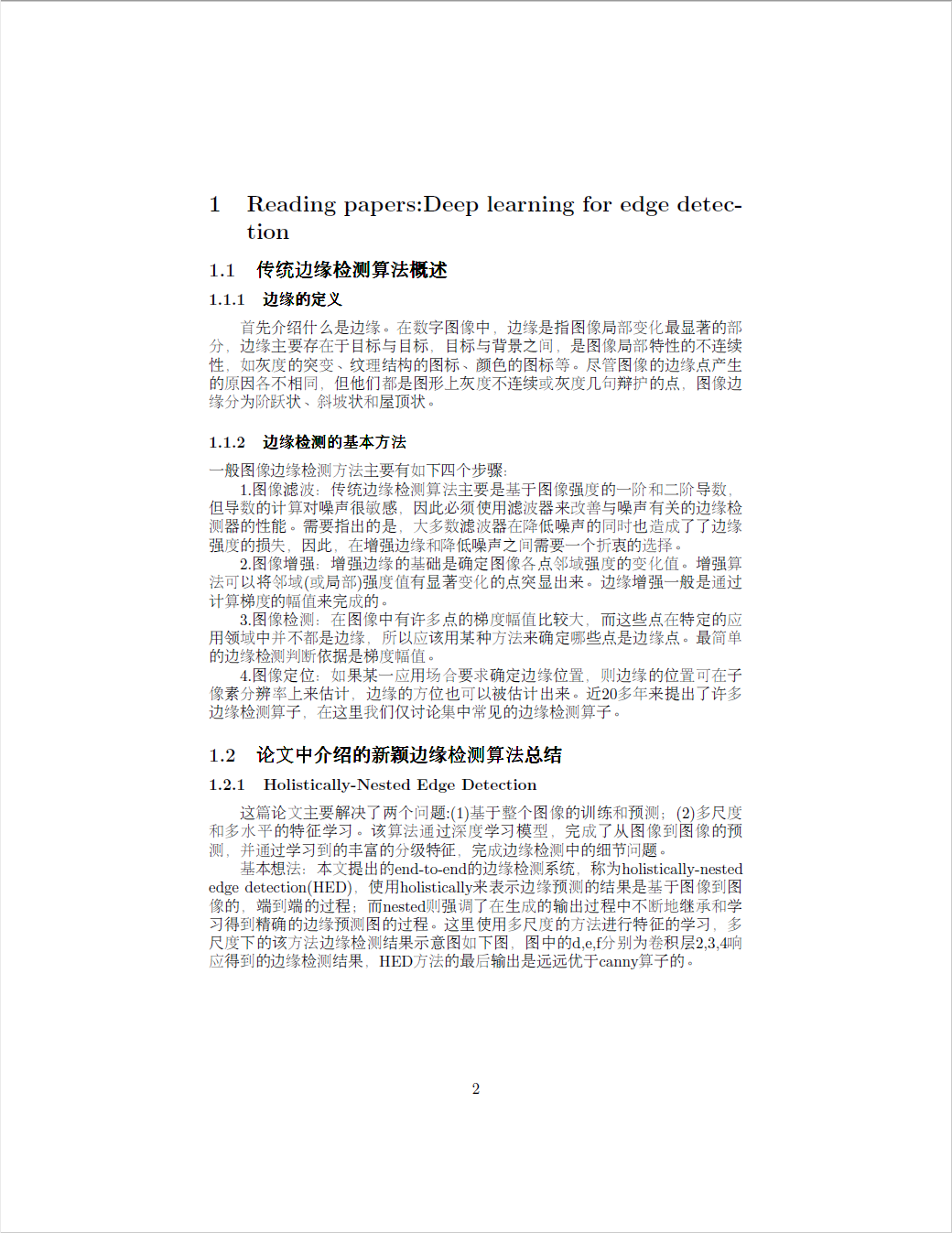

\par 基本想法:本文提出的end-to-end的边缘检测系统,称为holistically-nested edge detection(HED),使用holistically来表示边缘预测的结果是基于图像到图像的,端到端的过程;而nested则强调了在生成的输出过程中不断地继承和学习得到精确的边缘预测图的过程。这里使用多尺度的方法进行特征的学习,多尺度下的该方法边缘检测结果示意图如下图,图中的d,e,f分别为卷积层2,3,4响应得到的边缘检测结果,HED方法的最后输出是远远优于canny算子的。

\begin{figure}

\includegraphics[width=\linewidth]{20161010224856136.jpg}

\caption{边缘检测结果示意图}

\end{figure}

\subsubsection{DeepEdge}

\indent 本文主要是利用目标相关的特征作为线索来进行边缘检测,与传统的通过低层特征先检测边缘然后再用于高层的识别相关的任务反过来。

\par主要步骤:\\

\indent1.采用Canny边缘检测算法得到潜在的编译像素点\\

\indent2.利用ImageNet得到网络从不同尺度提取Patch的特征\\

\indent3.然后将所提取的Patch特征通过KNet的5个卷积层对模型进行训练\\

\subsubsection{DeepContour}

\indent 这篇文章证明了使用从CNNs中学习到的深度特征可以提高轮廓检测的准确度。对CNNs的训练采取二元变多元的策略,即提出把本来是二元分类问题的轮廓检测转化为一个多元分类问题,对每一个类使用不同的参数,区别对待。同时为了获得更加有区分度的特征,提出了一个positive-sharing loss的损失函数,该损失函数引入了一个额外的正则化因子来强调positive and negative classes(轮廓类和背景类)的区别。实验结果在Berkeley Segmentation Dataset和BSDS500数据集上达到了最好的准确率,同时在NYUD dataset上也取得了很高的准确度。传统的方法就是对每个图像像素,设计各种各样的梯度特征,再通过一个二元的分类器来决定该像素是否是轮廓。虽然传统的方法在过去的十几年当中,一直处于最好的准确率,但是对于语义上目标轮廓和急剧变化的纹理并没有很好的区分度。作者想让CNNs学习到具有辨别力的特征,为此作者考虑到轮廓具有不同的特征和结构,所以对于不同的轮廓特征进行分类,采用不同的模型参数来表征。由于轮廓之间的分类出错一般是可以忽略或者是容忍的,但是轮廓和背景之间分类出错是不可以容忍的,所以在loss function中强调了轮廓和背景出错所引起的费用,就是额外增加了轮廓错误分类到背景和背景错误分类到轮廓的费用。

\newpage

\section{Classification@affNIST dataset}

\subsection{affNIST数据说明}

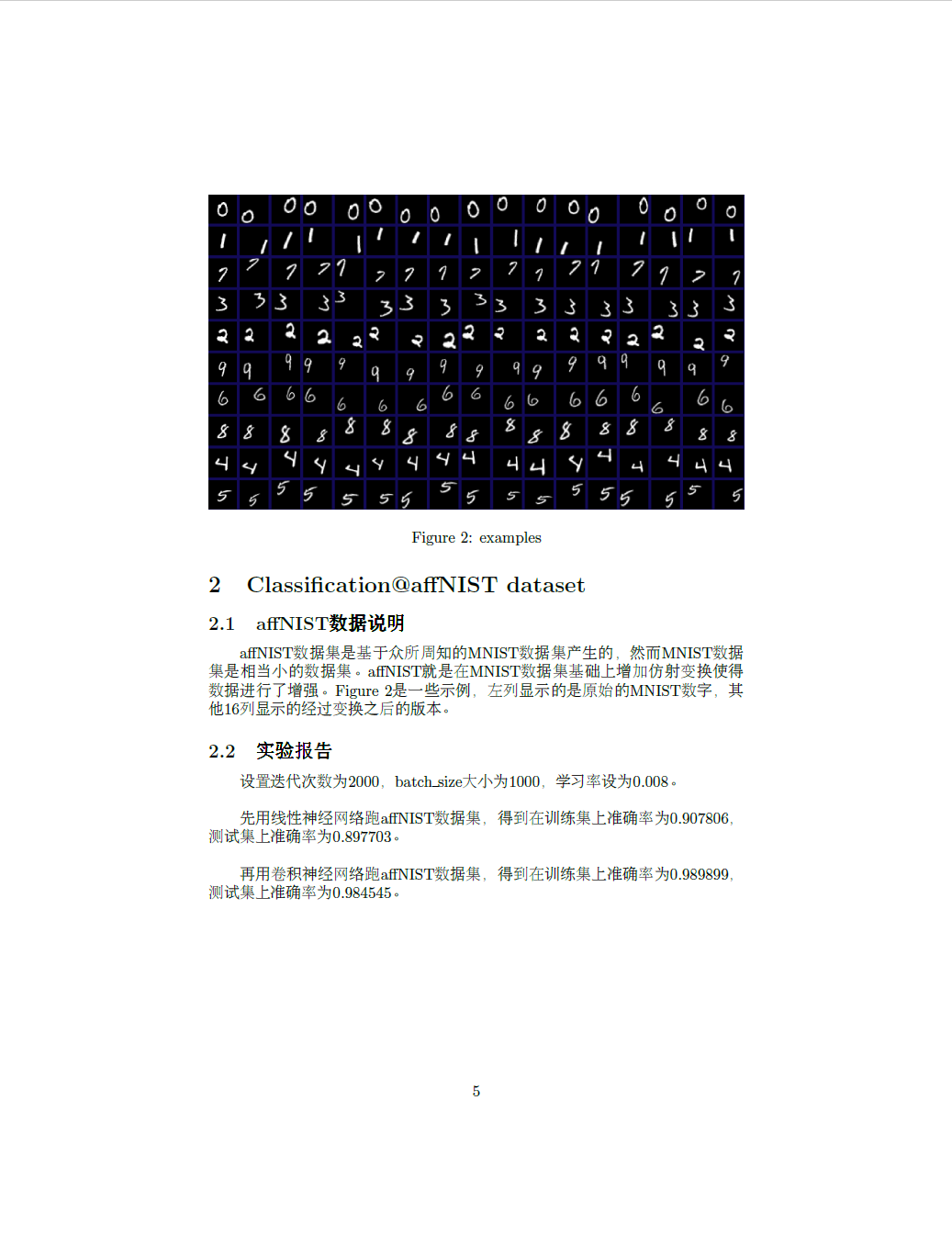

\indent affNIST数据集是基于众所周知的MNIST数据集产生的,然而MNIST数据集是相当小的数据集。affNIST就是在MNIST数据集基础上增加仿射变换使得数据进行了增强。Figure 2是一些示例,左列显示的是原始的MNIST数字,其他16列显示的经过变换之后的版本。

\subsection{实验报告}

\par 设置迭代次数为2000,batch\_size大小为1000,学习率设为0.008。\\

\par 先用线性神经网络跑affNIST数据集,得到在训练集上准确率为0.907806,测试集上准确率为0.897703。\\

\par 再用卷积神经网络跑affNIST数据集,得到在训练集上准确率为0.989899,测试集上准确率为0.984545。

\begin{figure}

\includegraphics[width=\linewidth]{examples.png}

\caption{examples}

\end{figure}

\newpage

\end{CJK}

\end{document}