今天讲解IEEE BigData 2023新鲜出炉的文章,一共4位作者,都是阿肯色大学计算机学院的老师和学生,对,就是下面这所大学。

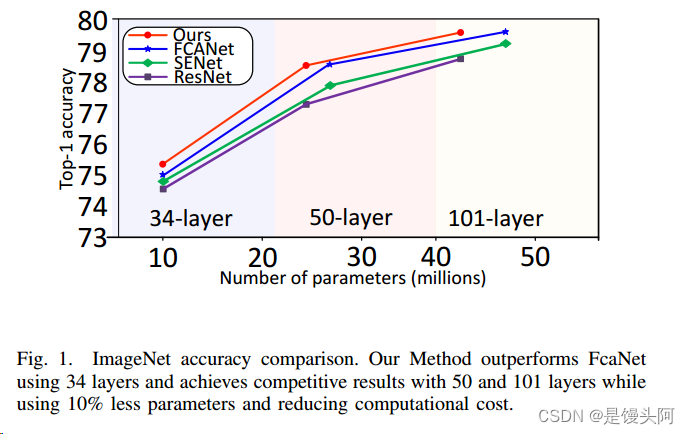

该文在2023.11.9日的期刊中发表,也就是前几天。提出了一种全新的注意力机制,论文中实验表明:OrthoNets网络性能超过了FacNet/ResNet/SENet/ECANet,是目前世界上最出色的、最先进的注意力模型,目前看到国内各个技术网站上还未有人对此模型做出讲解,我先做个讲解,占一个坑,做一个简要说明。具体如下。

1.前言:

设计有效的通道注意力机制需要寻找一种允许最佳特征表示的损失压缩方法。尽管该领域最近取得了进展,但仍然是一个开放性问题。FcaNet,目前的通道注意力机制最先进,试图使用离散余弦变换(DCTs)来寻找这样的信息丰富的压缩方法。FcaNet的一个缺点是DCT频率没有自然选择的余弦频率。

为了绕过这个问题,FcaNet在ImageNet上进行实验以找到最优频率。作者认为,频率选择只起辅助作用,而DCT核的余弦正交性是注意力滤波器有效性的主要驱动力。为了测试这个假设,作者使用随机初始化的正交滤波器构建了一个注意力机制。将这个机制集成到ResNet中,作者创建了OrthoNet。作者在Birds,MS-COCO和Places356上与FcaNet(和其他注意力机制)进行了比较,并显示出优越的性能。

在ImageNet数据集上,作者的方法与当前最先进的状态相竞争或超过。作者的结果表明,最优滤波器的选择是无法实现的,并且可以通过足够大的正交滤波器实现泛化。作者还进一步调查了实现通道注意力的一般原则,例如它在网络中的位置和通道分组。

可以看到,论文中此模型在34层、50层和101层深度时,都保持着最高的分类准确率。

2.引言:

深度卷积神经网络已成为实现许多计算机视觉任务(如分类、分割和目标检测)的标准工具。他们的成功归功于提取与底层任务相关的特征的能力。更高质量的特征允许在决策空间获得更好的输出。因此,改进这些特征的质量已成为机器学习社区的一个感兴趣的领域。在本论文中,作者研究通道注意力机制。

通道注意力机制是网络中的一个模块。每个模块输入一个具有个通道的特征,输出一个具有维度的注意力向量,其分量在之间。通过将这些输出与输入特征向量相乘,特征被调整以解决底层任务。

第一个通道注意力机制由SENet引入,它使用全局平均池化(GAP)将每个特征通道的空间维度压缩为单个标量。为了计算注意力向量,压缩表示经过多层感知机(MLP)和然后经过一个sigmoid函数。压缩阶段被称为挤压。正如在[1]中指出的,SENet的主要弱点是使用单一方法(即GAP)压缩每个通道。这个弱点被FcaNet所消除。他们认为GAP正在丢弃重要的低频信息,而在频率域中通过使用离散余弦变换(DCTs)一般化通道注意力,将获得更多的信息。这样做显著改进了通道注意力。基于强大的结果,FcaNet选择了要使用的离散余弦变换(DCTs),从而成为最先进的(SOTA)通道注意力机制。

作者假设FcaNet的成功与低频光谱信息的关系较少,实际上,是由于DCT压缩映射的正交性质。

为了测试这个假设,作者构建了一个使用随机正交滤波器压缩每个特征的空间信息的通道注意力机制。使用作者的注意力机制,作者生成了在目标检测和图像分割任务上超过FcaNet的网络。

与最先进的方法相比,作者的方法在ImageNet数据集上实现了具有竞争力的或优越的结果,并在Birds和Places365数据集上实现了注意力机制的最优性能。作者还进一步调查了实现通道注意力的其他一般原则。本工作的主要贡献如下:

-

提出了一种在努力使用正交滤波器提取更多信息的同时多样化通道压缩方法,并称之为OrthoNet。通过评估OrthoNet,作者证明了优质通道注意力的一个关键特性是滤波器多样性。

-

提出将通道注意力模块移动到ResNet-50和101瓶颈块的位置。作者的位置减少了模块使用的参数数量,并提高了网络的整体性能。

-

在Birds,Places365,MS-COCO和ImageNet数据集上运行许多实验,证明了OrthoNet是最先进的通道注意力机制。

3.方法:

在这个部分,作者回顾了通道注意力机制的一般公式。在这个公式中,作者简要回顾了SENet和FcaNet。在这些工作的基础上,作者介绍了作者的方法,即正交通道注意力,将在OrthoNet中实现。

正交通道注意力示意图。作者的方法分为两个阶段:零阶段是随机滤波器的初始化,这些滤波器的大小与特征层的大小匹配。然后作者使用Gram-Schmidt过程使这些滤波器正交。一阶段利用这些滤波器提取压缩向量,并使用SENet提出的激发方法得到注意力向量。将注意力向量与输入特征相乘,作者计算加权输出特征并加上残差。传统的通道和空间注意力机制在这不多说,老生常谈了,这里讲一下正交注意力通道。

正交通道注意力(OrthoNet):

作者注意到在FcaNet中使用的DCTs具有一个独特、基本、特性:它们是正交的。在本论文中利用正交性质对通道注意力进行利用。大致上首先随机选择适当维度的滤波器,即

![]()

然后应用Gram-Schmidt过程使其正交。有关初始化滤波器的详细描述请参见算法1。定义这些滤波器为:

![]()

作者的挤压过程可以表示为:

![]()

与其他方法一样,作者定义作者的通道注意力如下:

4.实验设置和结果:

作者首先描述实验的详细信息。然后,作者在图像分类、目标检测和实例分割任务上报告作者方法的有效性。

4.1 实现细节:

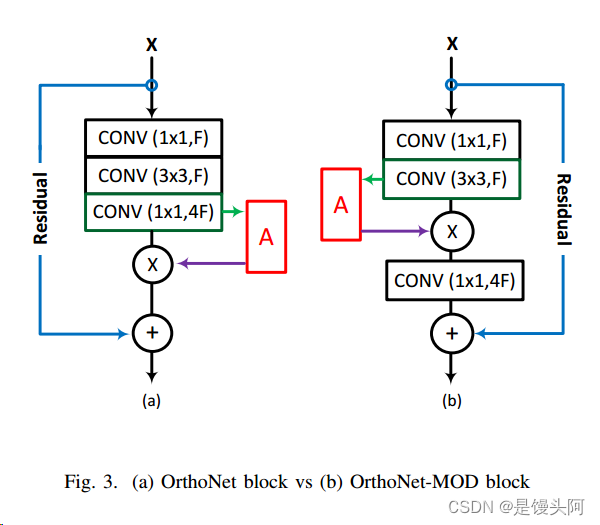

作者将作者提出的注意力模块添加到ResNet-34中,构建OrthoNet-34。基于ResNet-50和101,作者构建了两个版本的作者的网络,称为OrthoNet和OrthoNet-MOD。它们在ResNet块中的注意力模块位置不同。

通用规格作者采用了Nvidia APEX混合精度训练工具包和Nvidia DALI库以提高训练效率。作者的模型是基于PyTorch实现的,并且是基于FeaNet作者发布的代码。这些模型在两个Nvidia Quadro RTX 8000 GPU(设备真好哇!)上进行了测试。

4.2 分类:

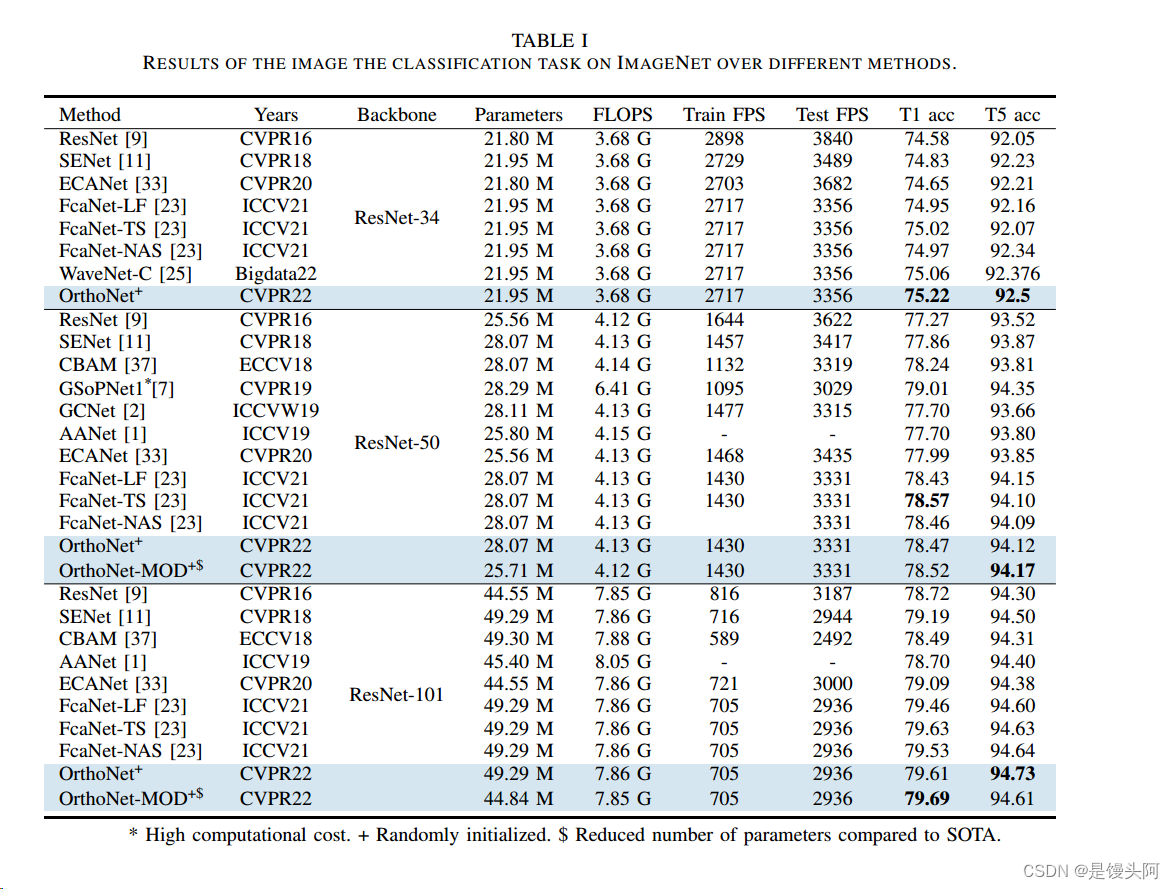

作者使用ImageNet,Places365和Birds数据集来测试和评估作者的方法。为了判断效率,作者报告每秒浮点运算次数(FLOPs)和每秒处理帧数(FPS)。为了展示方法的有效性,作者报告了Top-1和Top-5准确率(T1,T5 acc)。作者使用与[23]中找到的数据增强和超参数设置相同。具体来说,作者应用随机水平翻转,随机裁剪和随机宽高比。得到的大小为256x256的图像。

在训练期间,SGD优化器设置为具有动量0.9,学习率0.2,权重衰减1e-4,批量大小256。所有模型使用Cosine Annealing Warm Restarts学习进度和标签平滑进行100个epoch的训练。在每个十epoch开始时,学习率按前一个学习率的10%进行缩放。这样做有助于收敛,如[1]所示。

4.3 目标检测和分割

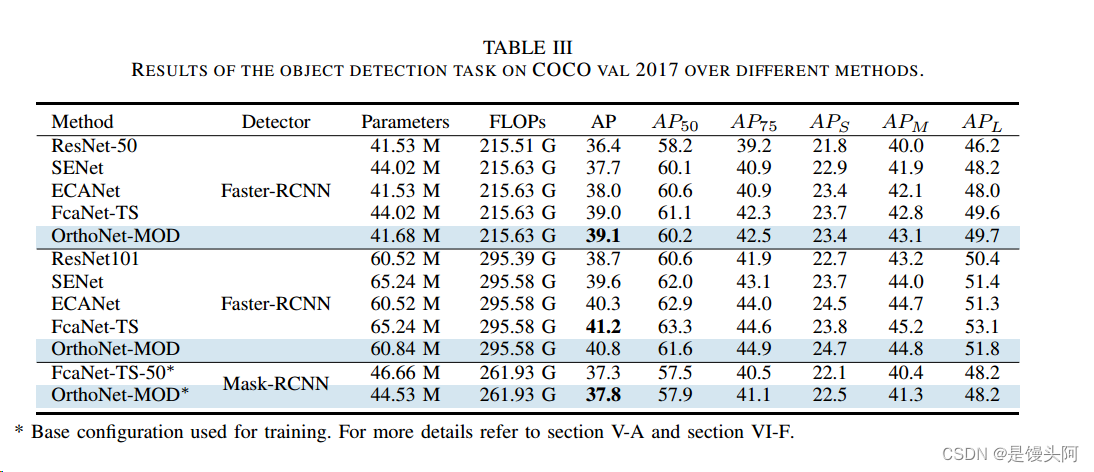

作者使用MS-COCO训练和评估目标检测和分割任务。作者报告平均精确度(AP)指标及其许多变体。

作者使用FasterRCNN与OrthoNet-50和101进行训练,其中有一个冻结阶段和可学习批标准化。作者使用与FeaNet相同的配置,基于MMDetection工具箱。

作者使用MaskRCNN与OrthoNet-50进行训练。作者有一个冻结阶段,没有可学习的批标准化。作者使用MMDetection工具箱中描述的ResNet-50的基础配置。

训练配置作者训练12个epoch。SGD优化器设置为具有动量0.9。作者使用具有动量0.9的SGD优化器,在第一500迭代时开始使用学习率0.0001,并每50迭代增长0.001。然后,作者在第一8个epoch中将学习率设置为0.01。在第9个epoch中,学习率衰减到0.001,在第12个epoch中衰减到0.0001。作者使用这种配置对FeaNet和作者的方法进行评估。

4.4 结果

分类结果获得的ImageNet上的准确率结果如下所示。最明显的特征是使用ResNet-34作为骨干网络时,OrthoNet的优越性能。表中的结果是在进行五次试验的平均值,标准差为0.12。即使在最坏的情况下,作者也实现了74.97,与FeaNet相当。作者在ResNet-50和101上的结果都优于FeaNet-LF和FeaNet-NAS。OrthoNet-50的结果是四次试验的平均值,标准差为0.07。

在ResNet-50上获得的结果验证了作者的初步假设。如果作者考虑SENet映射到零,FeaNet映射到一,作者的方法实现了0.93。由于SENet具有最少的正交滤波器(它们都是相同的),这证明了正交滤波器的重要性。

作者认为FeaNet在ResNet-50上的轻微改进是因为他们选择在ImageNet实验中表现最佳的特定滤波器。为了测试这个假设,作者在Places365和Birds分类数据集上评估了作者的模型。结果如下所示。作者可以看到,在作者的方法上,在Birds上的FeaNet-TF实现了0.18%的改进,在Places365上的实现了0.18%的改进。这些结果表明,作者的方法可以在不同的数据集上更好地泛化。

除了在ImageNet,Places365和Birds数据集上进行测试外,作者还评估了OrthoNet在MS COCO数据集上的性能,以评估其在不同任务上的表现。作者使用OrthoNet和FPN作为Faster R-CNN和Mask R-CNN的骨干网络。

正如表III所示,当OrthoNet-MOD-50被纳入Faster-RCNN和Mask-RCNN框架中时,性能超过了FeaNet,且计算成本降低了10%。

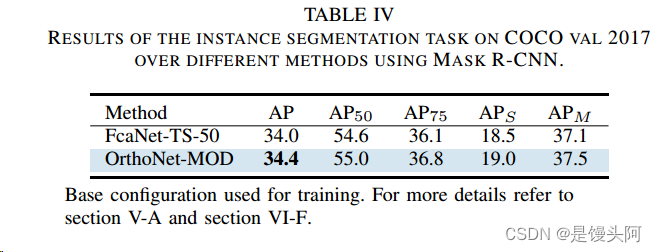

为了进一步测试作者的方法,作者在实例分割任务上评估OrthoNet-MOD-50。如表IV所示,在作者的方法上,在Mask-RCNN框架的ResNet-50基本配置下,作者的方法超过了FeaNet。这些结果验证了作者的方法的有效性。

5. 作者的成功可能的原因

尽管FcaNet认为离散余弦变换的频率选择是成功注意机制的主要因素,但作者的结果暗示,成功注意机制的关键驱动力是不同的(正交)注意滤波器。简而言之,作者认为FcaNet的成功主要是由于DCT核的正交性。

还记得卷积神经网络本身包含内置的冗余性(即具有强烈相关通道切片的隐藏特征)。在标准的SENet中,挤压方法将从这些冗余通道中提取相同的信息。实际上,通过适当地排列SENet的可学习参数,作者可以构建另一个网络,其中唯一的不同是中间特征中通道的顺序。然而,由于存在常数、正交的挤压滤波器,这种技巧无法应用于FcaNet和OrthoNet。这种排列方法的存在暗示着SENet在事先无法为其通道赋予意义。

当滤波器正交时,它们从特征空间的正交子空间中提取信息(即)。因此,它们专注于不同的特征。由于梯度信息沿着网络反向流动,挤压滤波器前面的卷积核可以适应其独特的映射。通过这样做,网络可以提取每个特征图更丰富的表示,然后激发可以在此基础上构建。

为了进一步支持作者的想法,作者使用随机滤波器训练OrthoNet-34和50,省略了Gram-Schmidt步骤,分别得到了74.63和76.77的准确率。作者可以明显看到正交滤波器在改进两网络的验证准确率方面的效果,与随机滤波器和GAP相比。

6. 正交通道注意力添加位置:

ResNet-50或101瓶颈块的整体结构如图3所示。为了构建OrthoNet,作者遵循标准的程序,在1x1卷积之后放置注意力模块。出于以下推理的动机,作者将这些网络中的注意力模块移动到3x3卷积之后,得到的网络是OrthoNet-MOD。

在OrthoNet-34中,注意力被放在每个块中的第二个3x3卷积上。现在让作者回顾一下ResNet 50和101的结构:这两个网络包含许多块,其中包含一个1x1卷积,然后是一个3x3卷积,再接着是一个1x1卷积(中间包含批量归一化和激活)。

由于1x1卷积只能考虑通道间关系,缺乏捕捉空间信息的能力,因此它们主要用于特征精炼和通道缩放。与激活相结合,一个1x1卷积可以被视为卷积MLP。由于3x3卷积是唯一考虑空间关系的模块,如果网络希望实现高精度,它必须提取丰富的空间信息。这些动机和OrthoNet-34的成功导致了OrthoNet-MOD的构建。

这种修改带来了许多好处。

-

首先,作者通过只创建与OrthoNet-34中相同大小的滤波器来减少了用于注意力模块的参数数量。具体参数数量可以在表V中找到。

-

其次,作者改进了标准OrthoNet的准确率。

-

第三,作者将注意力放在更有意义的卷积位置,在那里特征更富含空间信息。

7.总结:

在这项工作中,作者引入了SENet的一个变体,该变体利用SENet滤波器创建了一个有效的通道注意力模块,该模块可以集成到任何现有网络中。为了评估其性能,作者构建了OrthoNet并显示了在Birds,Places365和COCO上的最先进性能以及与ImageNet上的竞争或优越性能。

通过与最先进的进行比较,作者发现成功注意机制的关键驱动力是正交注意力滤波器。正交滤波器可以从任何相关特征中提取最大信息,并允许网络为每个通道赋予意义,从而产生更有效的注意力挤压。

作者的未来工作包括进一步研究可学习的正交滤波器,实现用于评估注意力机制的度量标准,以及进一步剪枝作者的注意力模块以降低计算成本并提高作者的方法准确性。作者还在寻找一个理论框架来解释通道注意力现象。

8.参考:

[0].OrthoNets: Orthogonal Channel Attention Networks.

[1].Zequn Qin, Pengyi Zhang, Fei Wu, and Xi Li. Fcanet: Frequency channel attention networks. In Proceedings of the IEEE/CVF International.Conference on Computer Vision (ICCV), pages 783–792, October 2021.

9.Cat.Black Attention Networks

最后,请让我放上鼎鼎大名的狗蛋*布莱克学者的照片,以表彰该学者在当代人工智能领域的卓越的贡献和进取的精神,狗蛋学者按时吃饭睡觉,和在做绝育过程中表现出的积极性和牺牲精神是值得我们学习和怀念的。

狗蛋:出场费一个小鱼干,记得打我账上