1 注意力机制

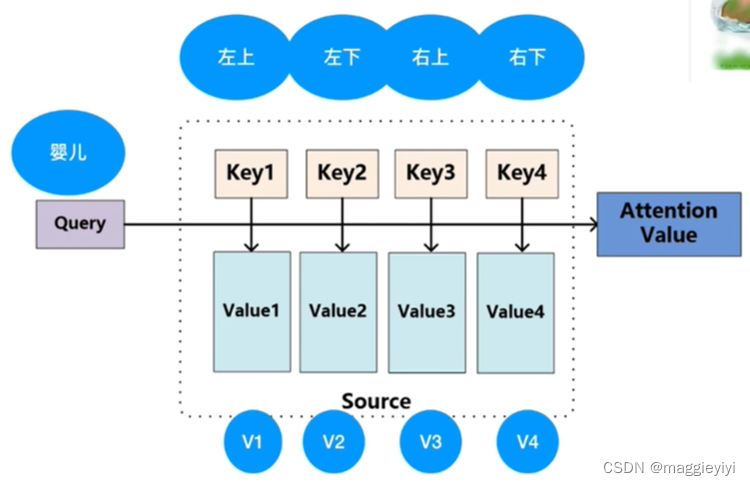

如下图所示,婴儿在干嘛吗?

判断婴儿再关注什么?颜色深表示主要注意力,颜色浅表示不那么注意。

注意力机制公式:

那么根据上述婴儿图篇可以抽象为:

将图片的区域划分为四块,分别为左上、左下、右上、右下 (Key1~4);(V1~4代表值向量)

step1: 首先Key和Query做点乘,点乘结果越大其相似度越大

step2: 将step1的结果和对应的V矩阵相乘,得到矩阵相加。即为注意力机制的和。

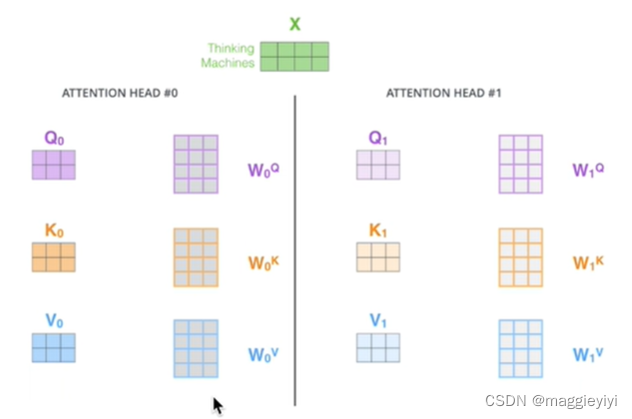

2 Transfomer中的注意力

2.1 在只有单词的向量的情况下,如何获取QKV?

如下图所示:输入向量X1、X2分别于 相乘-----》---》--》得到q、k、v

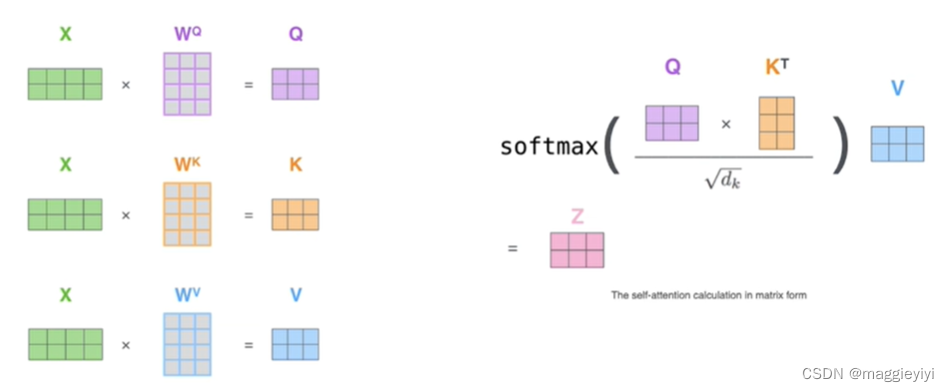

2.2 计算QK的相似度,得到attention

如上述注意力机制公式一样 ,点乘得到加权和

实际代码使用矩阵相乘,方便并行

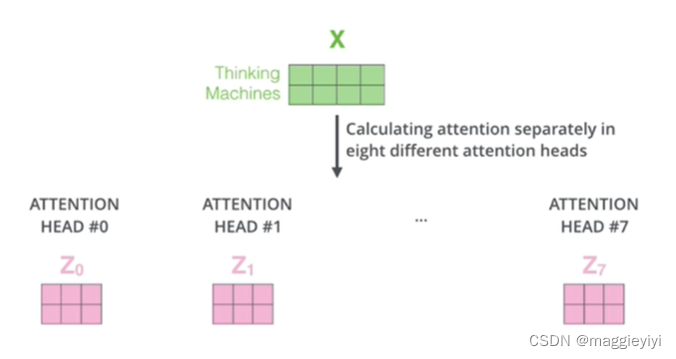

多头注意力机制,把原始数据分割为不同空间,分别计算再合在一起输出