本综述内容来自文献:

[1] Xu C, Ye R, Dong Q, et al. Recent Advances in Direct Speech-to-text Translation[J]. arXiv preprint arXiv:2306.11646, 2023.

目录

2.3 Non-autoregressive Modeling

1 Introduction

名词解释:

误差累积(error accumulation):指在连续的转录或翻译步骤中,由于前一步骤的错误会在后续步骤中积累,导致最终结果的质量逐渐下降的现象。这种误差累积通常在语音到文本(Automatic Speech Recognition, ASR)系统和文本到文本(机器翻译或文本转写)系统之间的多步骤流程中出现。在这些系统中,声音信号首先被转录成文本,然后文本再被翻译成目标语言或者以其他方式进行处理。如果在转录步骤中出现错误,这些错误将传递到后续步骤,影响最终的翻译或文本转写质量。

自回归(Autoregressive):在 E2E ST(End-to-End Speech Translation)模型中,"autoregressive" 表示模型会逐个生成翻译文本的每个词或子词,每次生成都会依赖于前一个时间步生成的内容。这是一种逐步、串行的生成过程。典型的 autoregressive 模型包括循环神经网络(RNN)、长短时记忆网络(LSTM)、和变换器(Transformer)等。

-

早期的语音翻译【Speech-to-text translation (ST)】解决方案是通过级联系统,使用多个子任务进行处理。

-

比如首先通过ASR(Automatic Speech Recognition)系统,将语音转录为文本,然后再使用 MT(Machine Translation)系统将文本翻译为另一种语言。

-

对于这样的级联系统,研究方向主要为解决误差累积(error accumulation)的问题。

-

-

端到端语音翻译【end-to-end speech translation (E2E ST)】有这样的好处:

-

能够减少误差累积

-

能够减少延迟

-

拥有更多的上下文建模

-

适用于不成文语言

-

-

基础建模:

-

ST 的语料库通常包含语音 s,转义文字 x,以及翻译结果 y

-

基础的 E2E ST 模型框架是基于 Encoder-Decoder 架构的

-

然而,E2E ST 模型的训练并不容易,其效果也只是接近于级联系统的结果,并不是性能最好的技术。

-

-

目前,E2E ST 模型研究方向主要为:

-

建模负担(Modeling Burden):

-

需要同时处理跨模态(声音到文本)和跨语言(源语言到目标语言)的问题,导致模型建模会很复杂

-

收敛困难,性能较差

-

-

数据稀缺(Data scarcity):

-

ASR、MT 的语料库非常多,且有些非常大

-

但是 ST 的语料库其标注难度较高,因此 ST 的数据很少

-

-

应用问题(Application issues):

-

需要考虑实际应用中的问题,如实时翻译,长格式音频分割等等。

-

-

-

综合上面问题与对应的解决方案,有了下面的分类图:

接下来的介绍将从这三个方面讲述。

第 2 节描述了如何减轻现有文献中的建模负担挑战。建模方法可以分为三类:Transformer 及其变体、多任务框架和非自回归建模。

第 3 节总结了解决数据稀缺问题的方法,包括数据增强、预训练、知识蒸馏和多语言训练。

第 4 节简要介绍了实践中的应用问题

第 5 节预测了未来 ST 研究的一些有希望的方向。

2 Tackling Modeling Burden

针对提出的问题,我们将从以下三个方面介绍:

在 2.1 进行介绍:对于语音信号这种长序列输入,我们采用高容量端到端模型,通常是 Transformer及其变种架构。

在 2.2 进行介绍:对于建模负担问题,通常采用多任务学习框架,对原始的 Transformer-based 模型进行修改。

在 2.3 进行介绍:对解码效率问题,我们采用非自回归模型,从而提高解码速度

2.1 Transformer and Variants

通常,ST 任务是像 Seq2Seq 这样的采用 Encoder-Decoder 架构的模型。模型的示意图如下。 而 Transformer 就是从这类模型中脱颖而出的一份子。下面介绍一些 Transformer模型的变种

Speech-Transformer

-

基于 text-to-text Transformer

-

主要改进点为 acoustic features 在进入自注意力编码器前,首先由卷积层(通常是步长为 2 的两层,将长度压缩 4 倍)压缩,然后再接一个归一化层

Conformer

-

主要改进点在于,在每个 encoder blocks 的 多头自注意力模块 和 前馈层 之间加入了 卷积模块

-

卷积模块包括了注意力和卷积组件,由两个 Macaron-net 风格的前馈层(feed-forward layers)和残差连接(residual connections)所包围。

SSL-Transformer

-

这是一种结合了自监督学习(self-supervised learning,SSL)得到的语音表示模型

-

SSL 已经被成功应用到了提取语音特征的任务中去

-

SSL-Transformer 主要就是将原始的音频波形输入到自监督学习模型中,通过多个卷积层和编码层的处理,从而提取语音特征。

-

SSL-Transformer 模型中,自监督学习模型可以被整合到解码器中:或者作为一个独立的编码器,或者作为一个语音特征提取器,然后与整个 Transformer 模型相连接。

2.2 Multitask Frameworks

针对模型负担的问题,多任务的核心思想是利用一些辅助工具来辅助目标任务的完成。比如ASR和MT。而有些任务模块和辅助模块的参数是可以共享的,这就导致了辅助任务的可行性。目前有三种类型的多任务框架:

Decoupled Decoder(解耦解码器)

额外的解码器用于引导模型学习文本转录(transcript),同时仍然以端到端的方式进行模型训练。主要思想有两种,一种是如何通过生成的文本转录来更好促进翻译,比如采用两遍解码器(two-pass decoder);还有一种是同时生成文本转录和翻译(dual decoder)

-

Two-pass decoder:先将声学特征通过这个Decoder,然后再把转录结果和解码器结果结合起来用于翻译工作。但由于采用的是顺序生成(sequential generation),失去了低延迟的固有优势。因此有人用非自回归方法进行第一段的解码。

-

Dual decoder:交互式解码(interactive decoding)使用两个解码器同步生成转录和翻译。与此同时还额外使用了交叉注意力模块(cross-attention module)来为两个解码器交换信息。wait-k 策略(wait-k policy)通过首先预测转录文本的标记,为翻译标记的解码(the decoding of the translation tokens)提供了更多有用的信息。

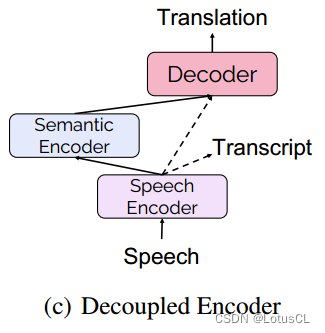

Decoupled Encoder(解耦编码器)

对于解耦解码器,当遇到多重推理的时候可能会导致设计与延迟问题。更好的解决方案是通过解耦编码器同时识别和理解原始语音输入的语义。因此我们采用下面这张图的方案,共有两个encoder,低级语音编码器首先对来自语音输入的声学信息进行编码,语义编码器进一步学习翻译解码所需的语义表示。

-

编码每个阶段都可以通过转录信息进行监督学习

-

转录也提供了语音的对齐,可以缓解 encoding 负担

Two-stream Encoder(双流编码器)

ASR 的数据可以用来增强组件,那么 MT 的数据也可以吗?在训练过程中,我们可以同时接收语音和文字的输入,其各自有各自的编码器,还有个共享编码器。这个结构通常通过多任务训练损失进行优化,例如用于语音翻译(ST)和机器翻译(MT)的负对数似然(NLL)损失。其中的优势在于,通过与 MT 编码器共享,可以学到更好的语义表示,以提高翻译性能。

在推断过程中,则是输入语音数据,通过语音编码器,共享编码器,解码器,最终生成翻译后的文本。

-

Speech encoder:其需要更有能力单独提取语音输入的声学特征。Wav2vec2 等预训练语音模型可用作语音编码器,以获得更好的 ST 性能

-

Text encoder:文本编码器可以是文本嵌入层(text embedding layer)或文本 Transformer 编码器的几层。同时,还可以用语音音素(phoneme)来代替原始转录作为文本输入,这样可以减少两种输入的模态差异。

-

Interaction:也有很多语音编码器和文本编码器交互的变种。

-

有使用对比学习法(contrastive learning method)来缩短语音和文字的表达差异的

-

有提出 Chimera model 来将语音和文字表达长度对齐的。

-

还有同时考虑到表达和长度差异,从而在共享编码器后面添加交叉注意力正则化模块(cross-attentive regularization module)的,正则化模块首先通过自注意力或交叉注意力从文本或语音编码器生成两个具有相同长度的重构序列,然后优化重构序列之间的L2距离。(我感觉这个不错)

-

2.3 Non-autoregressive Modeling

端到端模型相比于同等级的级联系统大大降低了计算时延,但是这种优势仅在自回归解码的情况下有效,这个技术研究有两条路线:

-

参考自动语音识别(ASR)和机器翻译(MT)任务中的方法,如条件掩码语言模型和重新评分技术,来开发非自回归语音翻译模型。

-

探索更高效的架构,依赖纯粹的CTC(Connectionist Temporal Classification)进行预测,以提高速度。CTC 是一种用于序列标签任务的损失函数,它可以用于训练模型,使其能够将输入序列映射到输出序列。

3 Tackling Data Scarcity

相较于 MT 或者 ASR,ST 的用于训练的数据非常少。现有的思路总共两条:

-

扩展数据集和数据增强:3.1 会介绍

-

从MT or ASR 的数据中挖掘有用信息:

-

预训练(pre-training):3.2 介绍

-

知识蒸馏(knowledge distillation):3.3 介绍

-

3.1 Data Augmentation

当训练数据非常稀少的时候,这是最直接的方法。

Expanding ST data

-

直接使用高质量的 MT 对大量 ASR 数据进行翻译,这个方法也被称为 “伪标签法(pseudo-labeling)” 或 “序列级知识蒸馏(SeqKD)”

-

还有就是双向的 SeqKD:包括正向SeqKD和反向SeqKD。这对于双语端到端语音翻译模型(bilingual E2E-ST models)非常有用

-

同时,反向的增强,也就是对语音数据的增强也是可以的:使用文本到语音(TTS)模型将机器翻译系统中的源语言文本扩展成语音。

Speech augmentation

-

SpecAugment:作用于 filter bank 的语音输入系数,包括对特征进行扭曲(warping),屏蔽频道块和时间步骤

-

SkinAugment:使用自动编码说话者转换来将原始说话者的声音转换为另一个说话者的声音。可以帮助模型适应不同说话者的声音

-

数据多样性:可以通过各种分割方法( segmentation methods )和重组方法(recombination)来增强原始语音翻译数据的实用性

3.2 Pre-training

预训练在AI领域的很多任务上都有非常好的效果。目前最先进的E2E ST模型基本上都涉及到预训练了。也是分为两大类

-

Separate pre-training:单独预训练是指对部分模型参数进行预训练或者通过不同的任务对不同的子模块进行预训练。早期的工作探索了更好的预训练方法来增强编码器在语义理解方面的能力。比如课程学习方法(curriculum learning method)、掩蔽声学建模 (Masked Acoustic Modeling,MAM) 的自监督方法、基于MAM的FAT。

-

Joint pre-training:联合预训练是指模型(包括编码器和解码器的所有模块)作为一个整体参与预训练。联合预训练通常采用多任务学习框架(即2.2所介绍内容)。通过在多任务预训练中构建统一模型,然后在具体任务上进行微调,可以提高多任务语音和文本相关任务的性能,同时降低数据标注的成本。

3.3 Knowledge Distillation

知识蒸馏(Knowledge Distillation)是一种用于训练深度神经网络的技术,其中一个神经网络(通常是大型、复杂的模型)通过传授其知识给另一个神经网络(通常是小型、简单的模型)。这个过程的目标是将大型模型的复杂性和性能传递给小型模型,从而使小型模型能够获得与大型模型相似的性能,同时具有更低的计算和内存要求。

知识蒸馏(KD)通常用于模型压缩,使用通常表现更好的较大教师模型的输出来指导学生模型的学习,期望学生模型将达到与教师模型相同的性能。数据有限,如何才能让ST表现接近MT老师呢?有下面几种方法

-

使用 ST 模型和 MT 模型分别预测翻译标记,以 MT 模型的预测概率作为老师来指导 ST 输出

-

使用双流编码器(two-stream encoder)框架,从双流编码器的混合序列(2.2有讲过,这是为了弥合语音和文本之间的表示差异)中,提取语音到文本翻译模块的知识。这种方法可以帮助改善语音到文本翻译模块的性能,使其更好地理解和转化语音输入。

3.4 Multilingual Training

多语言翻译是一个单独的研究门类。其与 MT 一样,向解码器添加语言指示符(例如 <2de>、<2fr>)是从双语 ST 演变为多语言 ST 的最直接、有效的方式。实际上,在每个翻译方向的数据有限的情况下,训练多对多多语言ST模型比单独训练双语ST模型更好,因为多语言模型可以捕获语言之间更多的发音相似性。

目前多语言ST的研究主要集中在:

-

预训练方面,比如如何构建统一的多语言语音文本预训练模型以及如何设计各种有效的预训练任务

-

高效微调(efficient fine-tuning),比如

-

仅微调层归一化(layer-norm)和注意力层(attention layers)的参数比微调所有参数更有效。这意味着只对这些特定层进行微调可以提高系统性能。

-

冻结预训练的ASR编码器和mBART解码器,然后仅通过微调语言特定的适配器模块来完成一对多的语音翻译任务。这是在一个多语言系统的基础上进行的,参数规模仅为数千万。这种方法也被证明在提高多语言语音翻译系统性能方面是有效的。

-

4 Tackling Application Issues

目前研究还是仅仅在手动分割,无噪声环境的情况下进行的,然而,实际应用需求也需要被讨论讨论。

Real-time

通过权衡质量与时延,从而能够达到实时翻译。关键目标是决定再等一些声音序列还是先翻译一些token。具体的技术有:

-

speech segmenter:基于CTC 标准,实时将语音进行分割

-

Continuous Integrate-and-Fire module(连续整合-放电模块):用以发挥自适应策略,在每个触发步骤都做出WRITE决策。

-

Cross Attention Augmented Transducer:扩展自 RNN-T,通过考虑所有可能的READ和WRITE动作路径来联合优化解码策略和翻译质量

Segmentation

ST 模型是不能处理非常长的语音序列的(如电影等),因此需要进行分割,分割为一个个小短剧。具体技术有:

-

Supervised Hybrid Audio Segmentation (SHAS):使用 Wav2vec2 并训练分类器来预测由手动分割信息监督的分割位置。

Named entity

即对命名实体的翻译。这是现实场景中的一个关键需求。具体研究有:

-

发现人名翻译失败的关键在于对方的国籍,因此提出了多语言模型来提高不同发音的鲁棒性。

-

也有设计了两个方法来同时进行ST模型翻译和NE识别的,内联(inline)方法生成NE标签和tokens,并行方法(parallel)来预测NE标签和tokens

Code-switching

就是指将不同语言(通常是两种或更多种语言)混合使用的语音翻译任务。例如,如果一个说话者在谈话中同时使用英语和法语,E2E ST模型需要能够处理这种语言的混合,将其转化为单一的目标语言(例如英语或法语)的文本或语音输出。

-

目前还在构建 CS 任务的语料库,并且探索级联系统和端到端结构在这一任务上的表现差别。

-

也有提出了一个统一的语言无关E2E ST模型(Language Agnostic E2E ST model (LAST))

Gender bias

emmm就是解决翻译中的性别偏见,确保语音识别和翻译系统不会因性别因素而引入不平等或偏见。

5 Future

讨论一些未来研究的课题

LLM(Large Language Model)

LLMs 包括 ChatGPT、Bloom等等,它们都有非常强大的能力,那么如何将LLM强大的生成能力融入到 ST 的任务中去,以及如何将语音数据也纳入LLM 的训练中去,是很值得研究的方向。

-

第一步我们可以先优化语音的表示,使得其能够与文本的表示相媲美。

-

伪语言——语音离散表示(speech discrete representations as pseudo-language)就是一个不错的方向。

-

-

此外,预训练大规模 acoustics-aware LLMs 也是一个很 promising 的方向。

Multimodality(多模态)

人工智能生成的文本、图像、语音、视频等多模态信息爆发,推动了ST领域去探索更加复杂的人机交互(HCI,human-computer interaction)场景的研究,比如交流翻译(speech-to-speech translation),视频翻译等等。

而多模态数据爆炸式的增长也致使在多模态数据上进行上下文学习(ICL,In-Context Learning)也成为了一个很有前途的研究方向,以更好地理解和利用不同模态数据之间的关联,从而实现更准确、更综合的多模态分析和应用。

多模态预训练也被证明在许多领域中都是有效的。

多模态之间的信息交互和关联也有待被发掘,比如视频中角色的语音和同一时间段角色的图像帧、韵律环境(prosodic environments,比如声调,音高,音量,语速,停顿等等,可以传达语言的情感、语气等)之间的关联。