1.引言

元宇宙大火之后迅速沉寂,主要原因是一些硬件达不到要求,缺乏虚实结合的有效载体,头显赛道降温,巨头热情随之消退。6月苹果发布的MR头显产品,又将元宇宙技术向前推进了一步,标志着苹果正式进军MR市场。

苹果公司认为,“如同Mac将我们带入个人计算时代,iPhone将我们带入移动计算时代,Apple Vision Pro将带我们进入空间计算时代”。所谓的空间计算,最初指地理空间定位和测量技术,元宇宙中的“空间计算层”拓展了出3D引擎、VR/AR/MR设备、地理信息映射等概念。为什么需要空间计算?元宇宙具备虚实融合的特性,存在虚实之间的一个结合点,这个结合点就需要通过空间计算完成。

现阶段苹果Apple Vision Pro作为最新一款强有力的头显产品被推出,紧接着6月22日,发布了VisionOS系统的软件开发包(SDK),让开发者们可以共同动手构建”空间计算时代“。苹果的一系列动作值得大家关注,本文将对Apple Vision Pro及其搭载的VisionOS SDK进行解读,介绍它的软硬件架构、主要特性、开发条件和应用场景,并对与GIS的结合场景进行简单的展望。

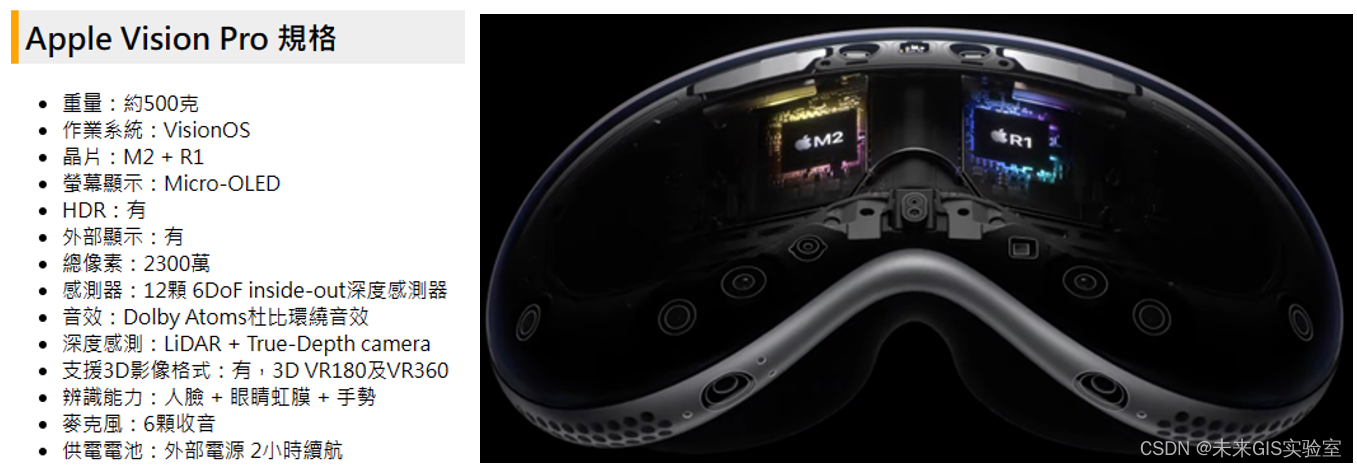

2.Vision Pro

Vision Pro 本质是一个 VR设备,用户无法用肉眼看到外界,通过遍布机身的十余枚镜头将外界画面透传给用户,这种视频透传计算是用户体验的基础。Vision Pro 的产品定位是类似Hololens 这样的 AR 设备,只不过 Hololens 使用了透镜方案,而 Vision Pro 使用了透传方案。VR头显一般看不到外在世界,在MR头显必須是能看到真实世界。Apple Vision Pro使用透传方案将虚拟现实和增强现实结合起来。

3.VisionOS SDK

3.1 VisionOS概述

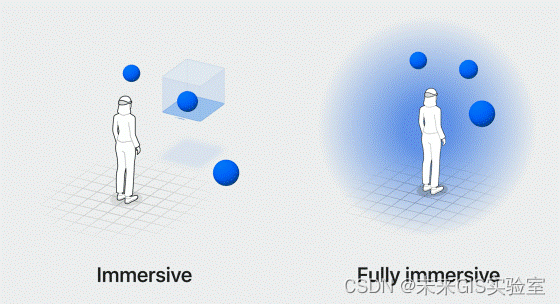

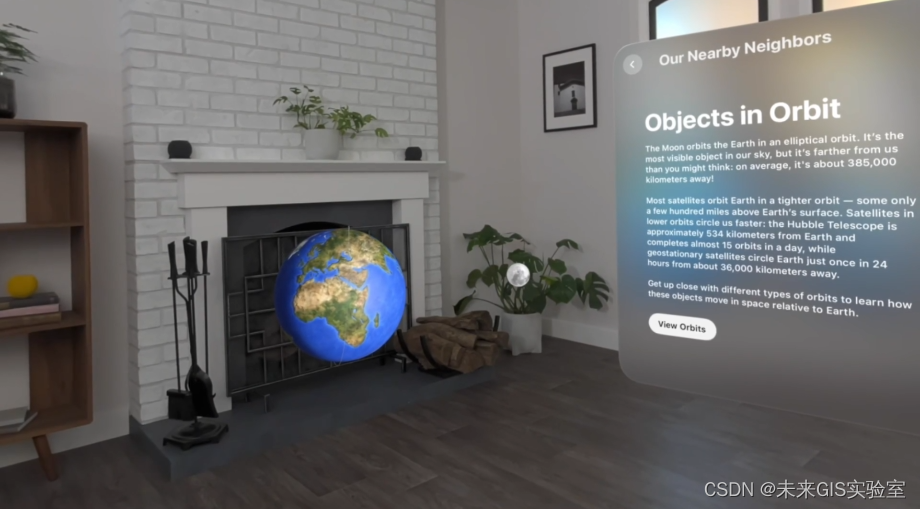

Apple Vision Pro 搭载最新的 VisionOS 的操作系统,就像iPhone的iOS、iPad的iPadOS和Macbook的MacOS一样,VisionOS适用于Vision Pro,被称为“世界上第一个空间操作系统”。与传统的桌面计算和移动计算不同,空间计算将工作环境悬浮在眼前,透过自然光线和阴影的变化来帮助用户理解比例与距离,让数字内容看起来就像真实世界的存在。用户可以在与周围环境保持联系的同时与应用程序互动,或者完全沉浸在创造的世界中。

VisionOS 建立在 macOS、iOS 和 iPadOS 的基础上,包括了 iOS 和空间框架、多应用 3D 引擎、音频引擎、专用渲染器子系统和实时子系统。在架构层面,VisionOS 与 MacOS 和 iOS 共享核心模块,新增加的“实时子系统”,用于处理 Apple Vision Pro 上的交互式视觉效果。VisionOS 将拥有一个全新的 App Store,并且 Vision Pro 也能够运行“数十万熟悉的 iPhone 和 iPad 应用程序。

3.2 内容展示形式

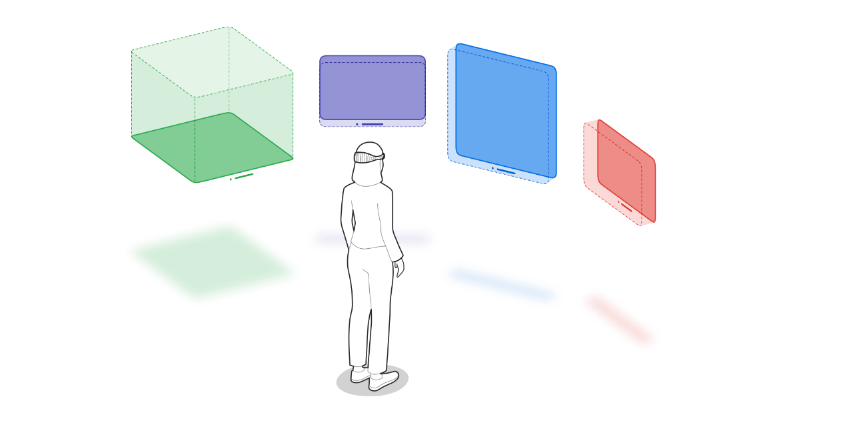

在VisionOS SDK中,苹果把它的应用UI分为三大基本元素,即:2D窗口(Windows)、3D体块(Volume)以及实体空间(Space)。

(1) Windows:2D窗口,用于创建基于SwiftUI的2D界面,这些窗口包含传统的视图和控件,可以通过添加3D内容来增加体验的深度。应用界面包含传统视图和操控机制,同时也可以显示3D模型,比如结合Model3D视图,在2D界面中嵌入动态的3D内容。Model3D可直接在应用中加载,并显示用RealityKit渲染的3D模型。

(2) Volumes:体块视图,是2D Windows的3D扩展,可全方位展示3D模型,允许用户从多角度查看。体块视图专为Shared Space界面设计,因此显示的3D模型都具有边界框。Volume可以使用RealityKit或Unity展示3D内容的SwiftUI场景。

(3) Spaces:实体空间,应用程序默认启动到Shared Space,应用程序可以基于窗口视图和体块视图来显示内容,用户可以在任何地方重新定位这些元素。Shared Space允许用户在使用时也能看到周围环境。而为了获得更身临其境的体验,应用程序也可以打开一个专用的Full Space,只显示该应用程序的内容。

3.3 主要特性

(1) visionOS可以兼容macOS、iOS和iPadOS上的应用程序

visionOS从根本上是iOS和iPad OS的延伸,因此容易无痛整合用户早以习惯的电脑和手机。用户可以直接用习惯的Apple Vision Pro大屏幕显示来观看手机或电脑画面,也可以用语音或实体键盘来进行工作,或者是用手机触控来当鼠标控制画面,没有随意跳脱熟悉的智能设备使用习惯。

(2) 所有应用程序都需要存在于3D空间中

所有visionOS应用程序都会在3D空间中“漂浮”,即使是从iOS或iPad OS移植过来的基本2D应用程序也会漂浮在空间中。传统的UI元素获得了新的Z偏移选项,这使开发者可以将面板和控件推入3D空间,使特定的界面元素浮在其他元素的前面或后面。

(3) 无手柄交互

实际使用Vision Pro 完全脱离了手柄,彻底摆脱了对于额外控制器的需求。Vision Pro 在眼镜内部配上了高精度视网膜传感器,眼睛本身就是伸出去的光柱,看到哪里,哪里的 UI 就会自动浮起。

(4) 视频透传

得益于十几个摄像头,外加内容眼球追踪系列传感器的精准追踪,实现了对VR和AR这两种模式的融合。通过对内部眼睛关注点的还原和建模,可以做到在看屏幕内容和在看外部内容时候,有穿透的效果,这将软件 UI 与现实世界融为一体。通过旋转数码旋钮,用户可以调整背景透视的程度,让UI在完全沉浸和完全透视之间自然过渡。

(5) 应用开发依托已有工具

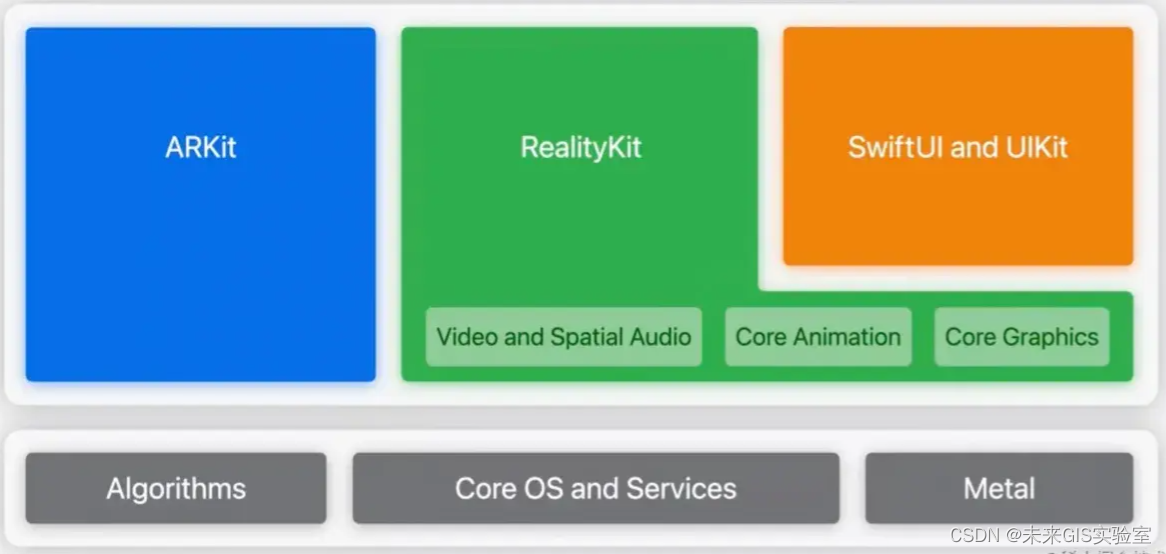

开发者将使用SwiftUI和UIKit构建用户界面,使用RealityKit显示3D内容、动画和视觉效果,使用ARKit实现真实世界得空间理解。同时,苹果与Unity的合作使所有基于Unity的内容在不需要进行太多转换工作的情况下迁移到基于VisionOS的应用程序中。这些都使得具有丰富旧有工具开发经验的开发者能够快速创建产品,降低了开发者的知识迁移成本,利于产品的快速推广。

3.4 开发方式

苹果的空间计算平台建立在开发者熟悉的SwiftUI、RealityKit、ARKit几大框架之上,Apple为VisionOS扩展了这些框架,增加了对新硬件和全空间支持:2D窗口——SwiftUI、3D场景——RealityKit/Unity3D、实体空间——ARKit。

SwiftUI是一套基于iPadOS、iOS的快速开发套件,帮助用户快速完成窗口界面的开发,可实现将iPhone、iPad上的应用无缝接入SwiftUI中。该套件允许一个应用在空间中展现多个窗口以及3D场景,并实现2D、3D中的联动;RealityKit是一个类似U3D的开发引擎,使用苹果的3D渲染引擎RealityKit在应用程序中呈现3D内容、动画和光影视觉效果;ARKit提供与周围空间互动的方式,让Vision Pro能够了解用户周边的环境,具备平面估计、场景重建、图像锚定、空间定位、头显运动追踪等能力。

SwiftUI + Xcode + Reality Composer 便可以完成新产品开发,同时全部 iOS、iPad App 等首发日都自动支持,缓解了早期内容不够的问题。

4.交互方式

VisionOS主要是围绕眼睛、手势和语音进行直接交互。

视觉交互:通过采用眼动追踪技术,实现视觉焦点导航。用户看着哪个按钮,这个按钮就进入备选状态;用户看着哪个窗口,这个窗口就进入活跃状态。用户从看到这个元素的那刻起,他就已经能用手势与其交互,在 GUI 层面消除了光标的概念。

语音交互:在视觉、触觉交互通道都被占用的时候,语音交互都能起到与系统交流并控制系统的作用,语音擅长扁平化菜单的结构,可提供用户所需的直接访问。

手势交互:当用户用目光选中按钮后,visionOS 将进一步根据用户的手势判断应当触发何种事件。比如,当用户单手捏合拇指和食指时,按钮就会触发“点击”事件,而当用户保持捏合并移动手部时,按钮就会触发“拖动”事件。visionOS 也支持自定义手势。

当用户用目光选中按钮后,visionOS 将进一步根据用户的手势判断应当触发何种事件。比如,当用户单手捏合拇指和食指时,按钮就会触发“点击”事件,而当用户保持捏合并移动手部时,按钮就会触发“拖动”事件。

VisionOS 也支持用户直接与虚拟物体交互,比如抓住一个模型,移动它的位置,改变它的大小,此时用户不再是隔空操作这个模型,而是实实在在地把手放在模型附近,这对对数字孪生应用很有实际意义。

5.使用场景

头显体积较大,原则上不太适合戴出室外,主要集中于室内的应用。官方宣传的应用场景主要包括沟通、协作、工作和娱乐这四大场景,每一个场景都将以3D空间的形式体现。这里主要对沟通场景和协作场景进行简单介绍。

5.1 沟通场景

融合现实和虚拟,沟通不只停留在二维的屏幕中,而是进入三维的空间,充分调用你所在的周围空间,让你可以在这个空间中与人进行内容分享,交流;每个人在这个空间里都以窗口的形式,进行互动,实现多人在一个空间里(不限场地)进行共享视频/电影/聊天;当现实世界有人与你互动的时候,也能清楚地看到周围环境,不会与现场脱节且能与他们保持交流,保持与周围一切事物的可互动性。

5.2 工作场景

VisionOS可以像在macOS那样,允许用户共享任何窗口。工作者可以在理想的工作空间里顺畅地使用mac,可以切换各种不同的视觉空间环境,将Vision Pro 中的其他app与Mac并排使用;在差旅工作中,实现与团队同事在一个空间里进行远程工作,彼此可以在同一个空间里处理文档,讨论工作,开会,包括AR快速查看内容。当人们共享3D模型时,visionOS会同步用户的方向,以及AR比例、动画和上下文信息,允许每个人获得相同的体验,实现远程可视化协作。

6.与GIS结合点

Vision Pro作为苹果的第一个3D相机,可以捕捉空间照片和空间视频,让用户可以以全新的方式记录和重现地理位置的场景和特征。它还可以实时分析三维空间数据,为GIS专业人员提供更高的效率和精度。例如,Vision Pro可以在现场快速测量建筑物的高度、面积、体积等参数,或者识别出地形的特征,如坡度、方向和曲率等。

Vision Pro支持多种输入方式,包括眼睛、手势、声音和配件,让用户可以灵活地与GIS数据进行交互和操作,用户可以通过语音、手势或触摸等方式,在同一张地图上进行沟通和交流。Vision Pro可以与苹果的其他设备和服务无缝集成,可以将GIS数据以三维形式投影到共享空间上,方便不同空间位置的用户从不同角度和距离观察和操作地图,实现诸如城市规划、抢险救灾、反恐防暴等指挥任务的多部门协作。

7.结论

Apple Vision Pro 和它搭载的visionOS系统亮点纷呈:首先,交互方式更加丰富和便捷,大FOV+清晰VST+超强算力的加持下赋予了更好的场景体验。同时,相比于微软的Hololens, visionOS基于视频透传技术将AR和VR融为一体,具有更强的沉浸感和交互性。第二,Apple Vision Pro能够无缝衔接macOS,iOS,和iPadOS,依托App Store应用平台,软件生态环境的发展有基本的保证。第三,VisionOS产品的开发依托于已有的成熟产品,降低了新产品开发的学习成本,便于开发者的快速开发。第四,共享空间处理在设备上进行,不使用云处理进行3D映射,房间的可视化和映射保持私密。

至于VisionOS与GIS应用的结合,目前在虚拟地理环境模拟仿真、空间环境增强和数字孪生等方面的应用潜力较大。空间计算涉及到物理环境和数字环境的结合,是元宇宙发展的基石,是未来的市场价值高地。从这个意义上来看,VisionOS作为第一个空间操作系统,值得长期的跟进和关注。

参考:

https://developer.apple.com/visionos/

https://juejin.cn/post/7243725358129561637

https://www.macrumors.com/roundup/visionos/

https://medium.com/@anishalok/beyond-screens-redefining-user-interfaces-and-experience

https://quan.ithome.com/content/sharedetail?id=274690

点评|AR/VR行业高管眼中的Vision Pro - 知乎

推出 Apple Vision Pro —— Apple 的首个空间计算设备 - Apple (中国大陆)

https://benic360.com/apple-vision-pro-introduction/

(部分素材来源于网络,版权归原作者所有。本文仅作分享解读,不用于商业用途,如涉及侵权请予以告知,我们会及时删除相关内容。谢谢!)

「未来GIS实验室」作为超图研究院上游科研机构,致力于洞见未来GIS行业发展方向,验证前沿技术落地可行性,以及快速转化最新研究成果到关键产品。部门注重科研和创新功底,团队气氛自由融洽,科研氛围相对浓厚,每个人都有机会深耕自己感兴趣的前沿方向。