6/5日苹果的"One more thing" Apple Vision Pro的发布,肯定是在XR/AR/VR发展中,值得载入史册的一天。很多人会说, Apple Vision Pro的很多能力都是业界早就很多人提出,并且已经在很多产品中落地了,比如眼动+全手势交互在几年前的MicroSoft Hololens上就已经实现,3维无限大屏也是目前很多Bird Base AR眼镜主打的应用场景,显示跟Oculus Quest是相同的方案。那Apple Vision Pro又有什么特别的呢?总结来说就两个字:极致。

XR/AR/VR的区别

Apple Vision Pro是一款混合现实(XR Mixed Reality)设备,是一种结合VR (Virtual Reality)和AR (Augmented Reality)能力的一种产品型态,VR产品主打的是虚拟世界的沉浸感,像是Oculous Quest, Pico...等,目前更常见的场景是VR游戏。而AR主打的是与现实世界虚实结合,比如:HoloLens,Nreal,李未可Meta Lens就属于这类型的眼镜。

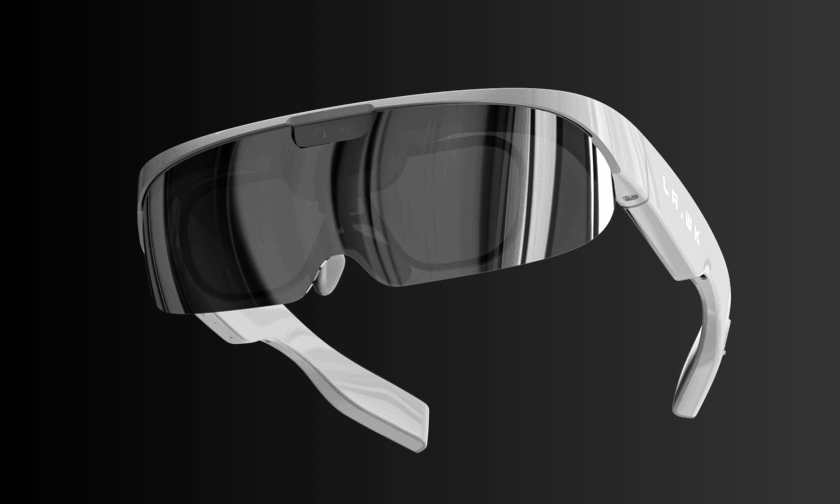

那XR又是一个什么样的产品型态呢?XR类型的出现主要就是为了弥补AR目前光学方案的不足,进而基于VR基础上扩增与现实交互的能力,从下面两张对比图可以看得出来Vision Pro的外观更接近。AR眼镜一般称之为OST(Optical See-Through)设备,为了达到既可以看清现实世界,又可以投影虚拟物体,业内通常使用反射或衍射原理进行成像,但是整体的良率,成像品质以及FOV都远不如VR 设备来的好,但是不管是重量或是可携带性都比VR设备好很多。根据供应链的小道消息,苹果也在深圳调研了很久AR光学方案,最后没找到合适的才转投XR型态的产品。

XR设备又称之为VST(Video See-Through)设备,简单来说就是既然没有办法透视看到外面的世界,那我就用个摄像头帮用户看世界,在用VR的显示技术把外界图像显示出来,这样不但能保证显示效果,FOV跟VR设备一样大 ,又能涵盖AR的应用场景。但也不是没有缺点,因为需要额外数个摄像头传输外界的图像并且高清渲染,所以在成本和功耗上一定会比一般的AR来的高。

苹果在Vision Pro的设计上也利用了XR的特点,主打了一个虚实切换的概念,可以透过旋钮改变真实跟虚拟的沉浸程度。

接下来重点介绍vision Pro到底突破了哪些业界老大难的问题

抛弃控制器:全眼动+手势控制

眼动加上手势控制其实在现有的主流VR设备上都默认搭载了这两项技术,但是都含存在比较大的场景限制,导致就算是最新的Meta Quest 3也还是没有放弃物理控制器进行操控。

眼动的部分目前普遍的技术瓶颈在于解析度不够高,只能定位到大概的位置,所以在VR设备上普遍主要是用来作注视点渲染(Eye Tracked Foveated Rendering ETFR),目的是将低功耗,只在注视点进行高清渲染,但是用作控制的话需要极高的精准度,尤其是图标很近的情况眼睛的移动是非常微妙的,很容易误触或是需要很努力注视才行,之前用过眼动控制相关技术的人第一的感受一定是太累了。

但是这是Vision Pro直接拿眼动来选择icon,根据现场体验的朋友说使用非常顺畅,单就这个体验来说都够业界追赶好几年了。

整体的交互大致上是使用眼动选择控制的组件,然后配合手势触发控制能力,包含点击,拖拽,拉伸...等等。但是基于传感器定位手势也是有很大的弊端就是受限于传感器的FOV,如果FOV太小那手势可工作的区域很容易出现不响应,或者是手太酸的问题。像是HoloLens的手势就需要在正前方才能比较好的操作。

这次苹果使用了单目结构光的方式去解决这个问题,从介绍中可以看到手放在非常低的地方也能够使用,体验上据说也是非常好上手。到底怎么使用单目结构光解决FOV以及角度导致的手势歧异暂时还没想明白。而且结构光很容易受到环境光照的影响,具体实用效果如何,可能还得拿到实际产品体验才行

12摄像头融合:实时虚实整合

讲到虚实整合,就不得不提到VR/AR/XR都必不可少的空间感知算法SLAM(Simultaneous localization and mapping),虽然手机上已经有不少成熟的sdk可以使用,比如: iOS ARKit,Android ARCore,但是在头显设备上就不太多,多半也都不开放。主要是因为头显为了跟上人眼的反应速度(太慢可能会导致晕眩,不贴合),对于算法的速度,准确性要求都比手机AR大的多。

为了解决这个问题,苹果不惜在Vision Pro上搭载了两款处理器M2与R1

为了实时处理12颗摄像头的数据,苹果专门使用了一个自研的R1多媒体处理器,据说整体数据同步延时只有16ms,除了处理速度的问题使用R1还有一个主要原因是因为一般操作系统都是非实时系统,如果直接拿主处理器M2做处理,哪怕是算力充足的情况下面,底层的传感器也无法实时同步,因此两个处理器的架构后续应该会成为业界标准方案。高通的AR2也是双处理器的架构,但高通最高等级的SOC也只能处理8路视频。说苹果一家公司干翻了全世界也不为过。

空间音频系统

从手机二维系统进化到三维系统,本质上感官上对虚实融合的本能追求。空间感之能力解决了是觉得需求。一项追求极致的苹果连三维的音频系统也不放过。

Vision Pro提出了一套空间音频系统,使用前需要使用Vision Pro扫描你的耳朵,知道每个人耳朵大概的收音范围,然后就能透四颗外放喇吧模拟整个空间不同方向的声源,有点像是到电影院的杜比环绕音响的感觉。但众所周知眼镜上的外放式喇吧一直有漏音的问题,这点就不知道苹果解决到什么程度了。

一點感想

Vison Pro的发布对于整个行业来说肯定是史诗级的冲击。重点不是Vision Pro有多创新跟其他产品有多么与众不同,甚至很多卖点都是相关行业早就用烂的点。

但是,最重要的是这个BUT!!! 能够做到这么完整,体验这么极致可能就只有 Vison Pro。做为一个相关行业的人,里面的很多细节只能用不可思议来形容,绝对不是行业没想过,但就是能力不允许啊。说的夸张一点,单拿一个点可能全世界也找不到第二个能做出来的公司。