分类目录:《深入理解强化学习》总目录

预测(Prediction)和控制(Control)是马尔可夫决策过程里面的核心问题。预测(评估一个给定的策略)的输入是马尔可夫决策过程 < S , A , R , P , γ > <S, A, R, P, \gamma> <S,A,R,P,γ>和策略 π \pi π,输出是价值函数 V π V_\pi Vπ。预测是指给定一个马尔可夫决策过程以及一个策略 π \pi π,计算它的价值函数,也就是计算每个状态的价值。

控制(搜索最佳策略)的输入是马尔可夫决策过程 < S , A , R , P , γ > <S, A, R, P, \gamma> <S,A,R,P,γ>,输出是最佳价值函数(Optimal Value Function) V ∗ V^* V∗和最佳策略(Optimal Policy) π ∗ \pi^* π∗。控制就是我们去寻找一个最佳的策略,然后同时输出它的最佳价值函数以及最佳策略。

在马尔可夫决策过程里面,预测和控制都可以通过动态规划解决。要强调的是,这两者的区别就在于,预测问题是给定一个策略,我们要确定它的价值函数是多少。而控制问题是在没有策略的前提下,我们要确定最佳的价值函数以及对应的决策方案。实际上,这两者是递进的关系,在强化学习中,我们通过解决预测问题,进而解决控制问题。

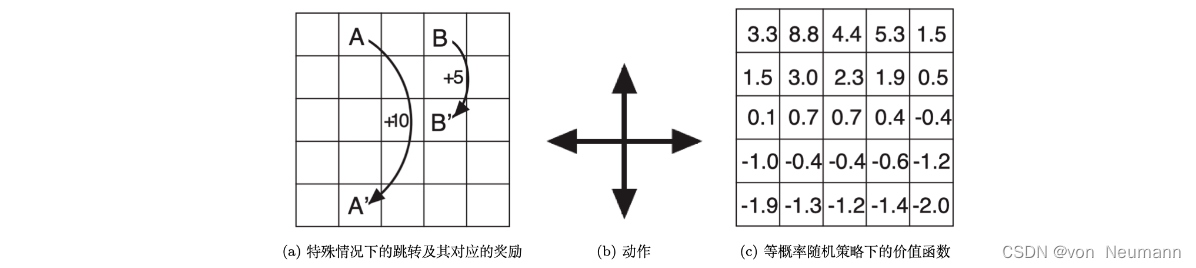

举一个例子来说明预测与控制的区别。首先是预测问题。在下图(a)的方格中,我们规定从 A → A ∗ A\rightarrow A^* A→A∗可以得到 + 10 +10 +10的奖励,从 B → B ∗ B\rightarrow B^* B→B∗可以得到 + 5 +5 +5的奖励,其他步骤的奖励为 − 1 −1 −1。如图下图(b)所示,现在,我们给定一个策略:在任何状态中,智能体的动作模式都是随机的,也就是上、下、左、右的概率均为 0.25 0.25 0.25。预测问题要做的就是,求出在这种决策模式下,价值函数是什么。图下图©是对应的价值函数。

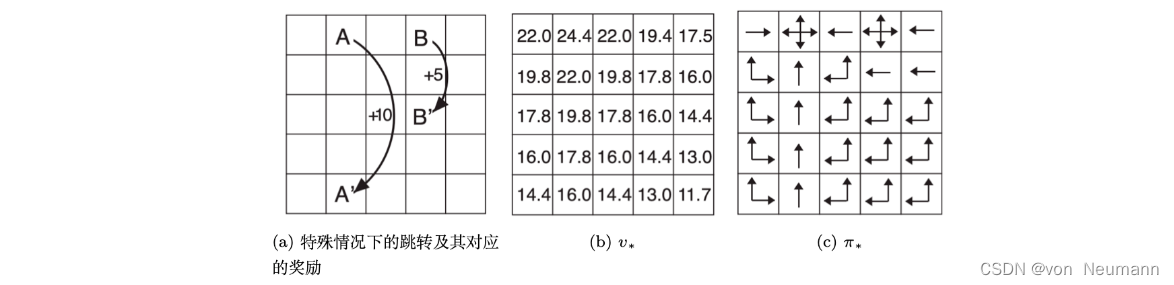

接着是控制问题。在控制问题中,问题背景与预测问题的相同,唯一的区别就是:不再限制策略。也就是动作模式是未知的,我们需要自己确定。 所以我们通过解决控制问题,求得每一个状态的最优的价值函数,如下图(b)所示;也得到了最优的策略,如下图©所示。 控制问题要做的就是,给定同样的条件,求出在所有可能的策略下最优的价值函数是什么,最优策略是什么。

参考文献:

[1] 张伟楠, 沈键, 俞勇. 动手学强化学习[M]. 人民邮电出版社, 2022.

[2] Richard S. Sutton, Andrew G. Barto. 强化学习(第2版)[M]. 电子工业出版社, 2019

[3] Maxim Lapan. 深度强化学习实践(原书第2版)[M]. 北京华章图文信息有限公司, 2021

[4] 王琦, 杨毅远, 江季. Easy RL:强化学习教程 [M]. 人民邮电出版社, 2022