一、引言

时间卷积网络 TCN 以 CNN 模型为基础,加入因果性,膨胀卷积与残差,使得网络训练得到大大增强。此网络中,需要满足如下两个条件即可符合因果卷积,实现膨胀卷积。

1、padding = (kernel – 1) * dilation

2、丢弃的神经元数 = padding

二、一维 TCN 模型

1. 因果卷积

当输入6个神经元时,dilation 为1,卷积核设为2,卷积后输出7个神经元,根据公式可以得出 padding=1,丢弃最后一列神经元,输入输出保持不变。这样以来就保持了因果性。

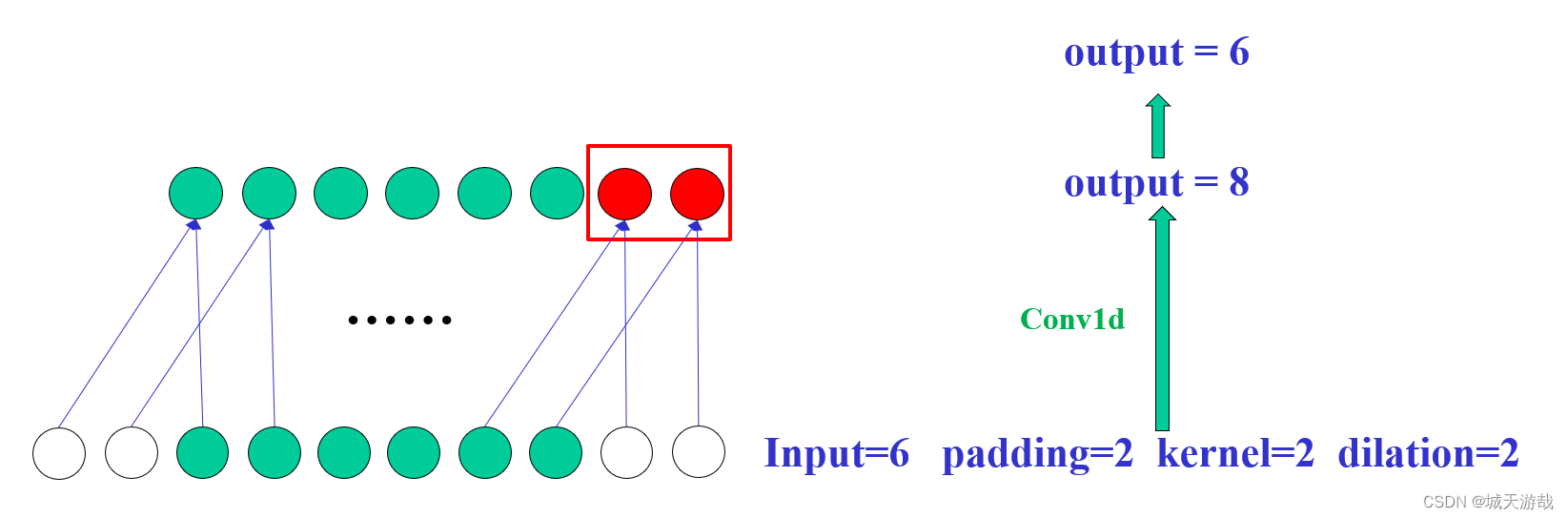

2. 膨胀卷积

当输入6个神经元时,卷积核为2,dilation 设为2,进行膨胀卷积后输出8个神经元,根据公式可以得出 padding=2,丢弃最后两个神经元,输入输出保持不变。

三、二维 TCN 模型

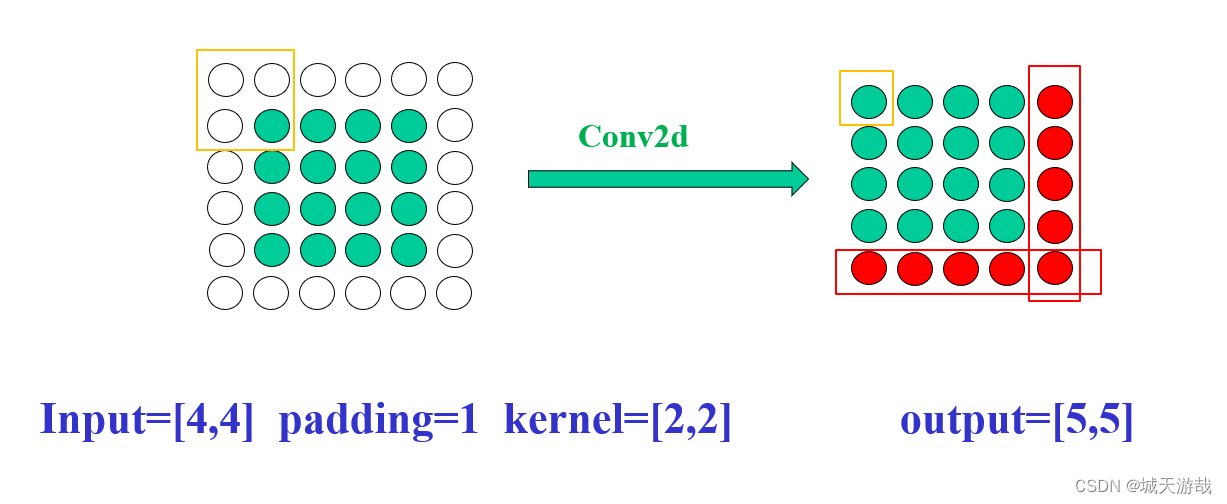

1. 因果卷积

卷积后,根据公式 padding=1,丢弃最后一行和最后一列。

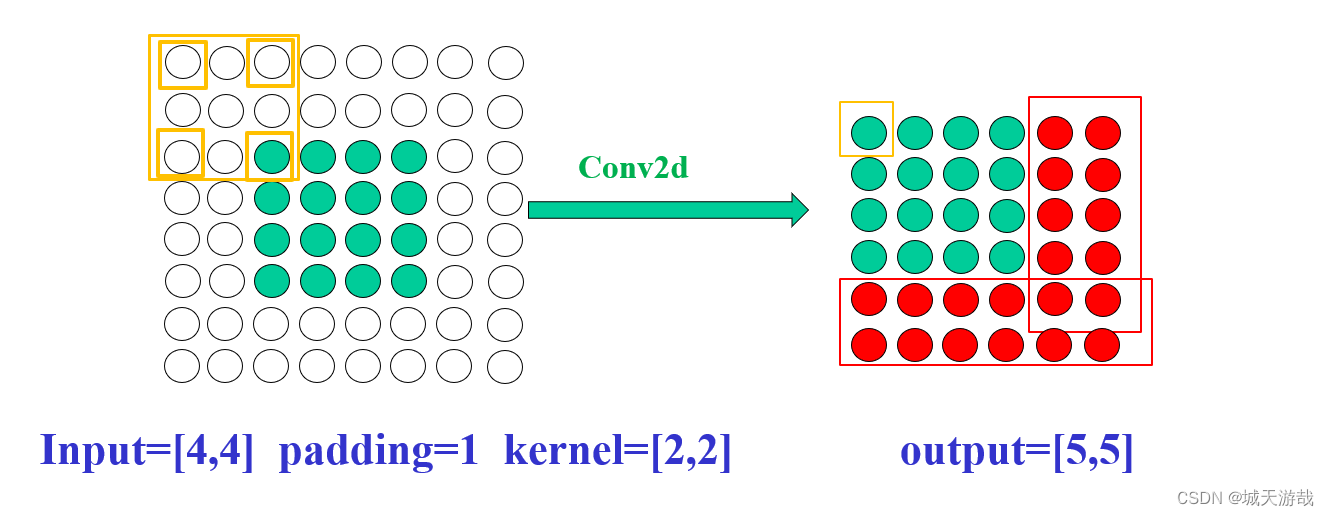

2. 膨胀卷积

dilation=2,膨胀卷积后,根据公式 padding=2,丢弃最后两行和最后两列。

四、总结

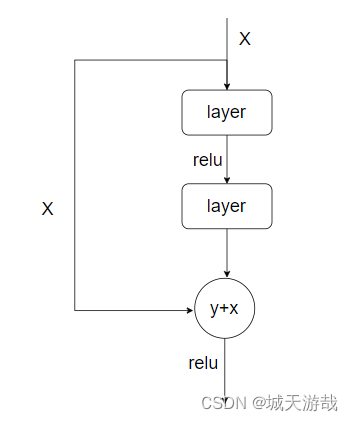

TCN 中的残差与 ResNet 网络中的无异,结构非常简单,如图所示

TCN训练时,需要具有良好的时间序列特性,一维数据比较容易处理,二维数据不好处理,故TCN比较适用于一维卷积,具有非常好的因果性,不过根据我处理的二维卷积,也能出现一些效果。最后如果你想使用二维卷积,就必须将二维数据处理的具有类似时间序列的特性。本文 TCN 二维卷积非常具有创造性,为本人所创,目前暂时不知道是否有其它类似的二维卷积版本。