一、什么是特征预处理

通过一些转换函数将特征数据转换成更加适合算法模型的特征数据过程

处理前,特征值是数值,处理后,进行了特征缩放

1、包含内容

数值型数据的无量纲化:

归一化

标准化

2、特征预处理API

sklearn.preprocessing

3、为什么我们要进行归一化/标准化

特征的单位或者大小相差较大,或者某特征的方差相比其他的特征要大出几个数量级,容易影响(支配)目标结果,使得一些算法无法学习到其它的特征

因为很多数据量纲不一致

可以看到里程数数值比较大,消耗时间比数值比较小

用KNN算法计算欧氏距离公式时,最终结果被里程数左右,学习不到其他特征了

(72993 - 35948) ^ 2 + (10.14 - 6.83) ^ 2 + (1.03 - 1.21) ^ 2

我们需要用到一些方法进行无量纲化,使不同规格的数据转换到同一规格

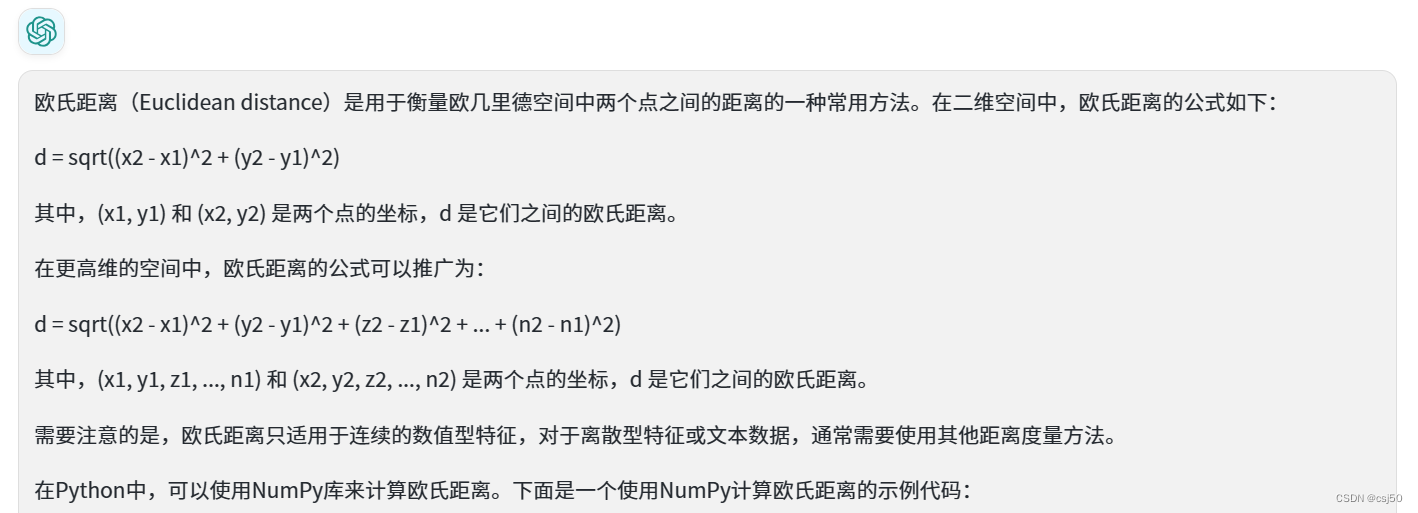

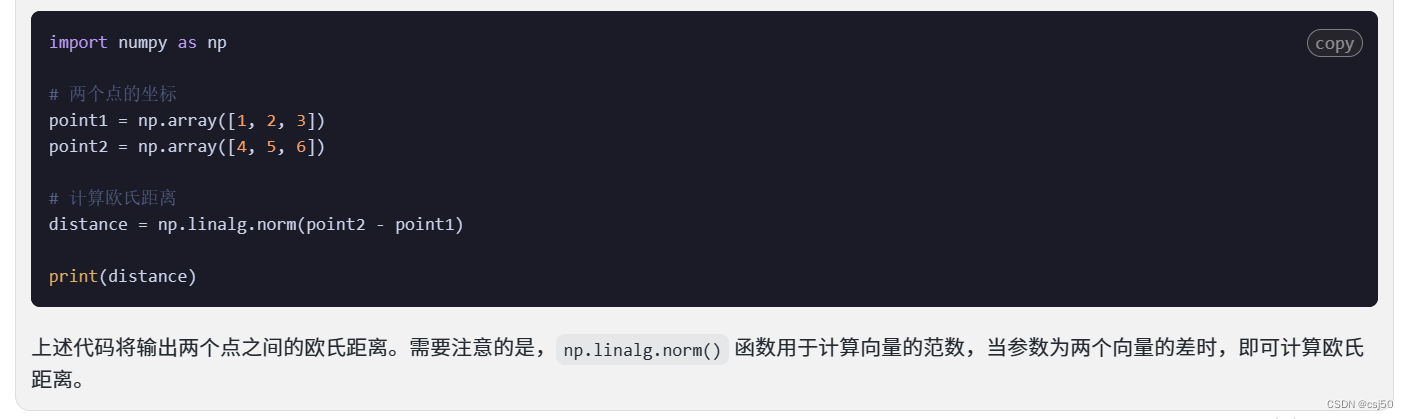

4、什么是欧氏距离公式

5、无量纲化

之所以要做无量纲化的处理,就是因为量纲不统一,导致了里程数数值非常的大。为了让特征同等重要,要做归一化/标准化

二、归一化

1、定义

通过对原始数据进行变换把数据映射到(默认为[0,1])之间

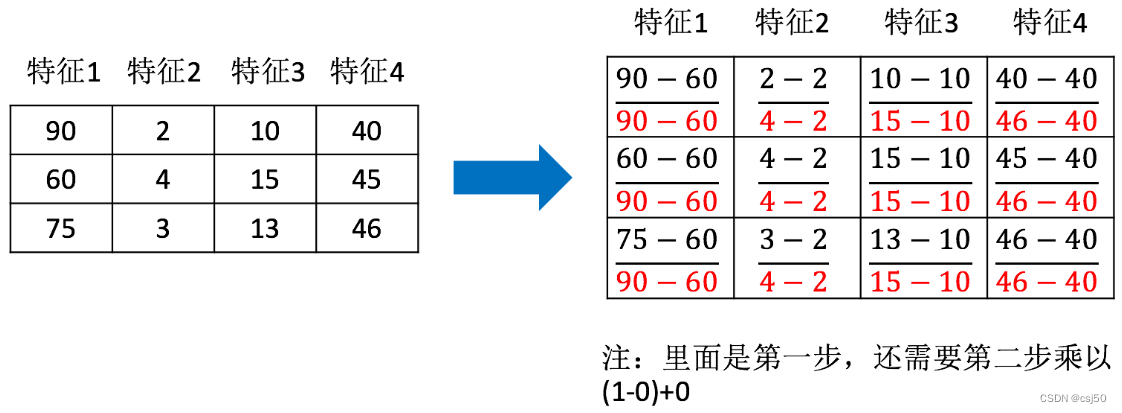

2、公式

3、API函数

sklearn.preprocessing.MinMaxScaler(feature_range=(0, 1)...)

4、MinMaxScaler.fit_transform(X)

X:numpy array格式的数据[n_samples, n_features]

n_samples:有几行数据,样本数

n_features:有几个特征,有几列

返回值:转换后的形状相同的array

5、归一化处理dating.txt中的数据

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction import DictVectorizer

from sklearn.feature_extraction.text import CountVectorizer, TfidfVectorizer

from sklearn.preprocessing import MinMaxScaler

import jieba

import pandas as pd

def datasets_demo():

"""

sklearn数据集使用

"""

#获取数据集

iris = load_iris()

print("鸢尾花数据集:\n", iris)

print("查看数据集描述:\n", iris["DESCR"])

print("查看特征值的名字:\n", iris.feature_names)

print("查看特征值几行几列:\n", iris.data.shape)

#数据集的划分

x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.2, random_state=22)

print("训练集的特征值:\n", x_train, x_train.shape)

return None

def dict_demo():

"""

字典特征抽取

"""

data = [{'city': '北京','temperature':100},{'city': '上海','temperature':60},{'city': '深圳','temperature':30}]

# 1、实例化一个转换器类

transfer = DictVectorizer(sparse=False)

# 2、调用fit_transform()

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new)

print("特征名字:\n", transfer.get_feature_names())

return None

def count_demo():

"""

文本特征抽取

"""

data = ["life is short,i like like python", "life is too long,i dislike python"]

# 1、实例化一个转换器类

transfer = CountVectorizer()

# 2、调用fit_transform()

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def count_chinese_demo():

"""

中文文本特征抽取

"""

data = ["我 爱 北京 天安门", "天安门 上 太阳 升"]

# 1、实例化一个转换器类

transfer = CountVectorizer()

# 2、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new.toarray());

print("特征名字:\n", transfer.get_feature_names())

return None

def cut_word(text):

"""

进行中文分词

"""

return " ".join(list(jieba.cut(text))) #返回一个分词生成器对象,强转成list,再join转成字符串

def count_chinese_demo2():

"""

中文文本特征抽取,自动分词

"""

# 1、将中文文本进行分词

data = ["今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。",

"我们看到的从很远星系来的光是在几百万年前之前发出的,这样当我们看到宇宙时,我们是在看它的过去。",

"如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。"]

data_new = []

for sent in data:

data_new.append(cut_word(sent))

print(data_new)

# 2、实例化一个转换器类

transfer = CountVectorizer()

# 3、调用fit_transform()

data_final = transfer.fit_transform(data_new)

print("data_final:\n", data_final.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def tfidf_demo():

"""

用tf-idf的方法进行文本特征抽取

"""

# 1、将中文文本进行分词

data = ["今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。",

"我们看到的从很远星系来的光是在几百万年前之前发出的,这样当我们看到宇宙时,我们是在看它的过去。",

"如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。"]

data_new = []

for sent in data:

data_new.append(cut_word(sent))

print(data_new)

# 2、实例化一个转换器类

transfer = TfidfVectorizer()

# 3、调用fit_transform()

data_final = transfer.fit_transform(data_new)

print("data_final:\n", data_final.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def minmax_demo():

"""

归一化

"""

# 1、获取数据

data = pd.read_csv("dating.txt")

#print("data:\n", data)

data = data.iloc[:, 0:3] #行都要,列取前3列

print("data:\n", data)

# 2、实例化一个转换器

transfer = MinMaxScaler()

# 3、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new)

return None

if __name__ == "__main__":

# 代码1:sklearn数据集使用

#datasets_demo()

# 代码2:字典特征抽取

#dict_demo()

# 代码3:文本特征抽取

#count_demo()

# 代码4:中文文本特征抽取

#count_chinese_demo()

# 代码5:中文文本特征抽取,自动分词

#count_chinese_demo2()

# 代码6: 测试jieba库中文分词

#print(cut_word("我爱北京天安门"))

# 代码7:用tf-idf的方法进行文本特征抽取

#tfidf_demo()

# 代码8:归一化

minmax_demo()

运行结果:

data:

milage liters consumtime

0 40920 8.326976 0.953952

1 14488 7.153469 1.673904

2 26052 1.441871 0.805124

3 75136 13.147394 0.428964

4 38344 1.669788 0.134296

.. ... ... ...

984 11145 3.410627 0.631838

985 68846 9.974715 0.669787

986 26575 10.650102 0.866627

987 48111 9.134528 0.728045

988 43757 7.882601 1.332446

[989 rows x 3 columns]

data_new:

[[0.44832535 0.39805139 0.56233353]

[0.15873259 0.34195467 0.98724416]

[0.28542943 0.06892523 0.47449629]

...

[0.29115949 0.50910294 0.51079493]

[0.52711097 0.43665451 0.4290048 ]

[0.47940793 0.3768091 0.78571804]]

三、标准化

1、归一化有什么缺点

归一化结果是根据最小值和最大值求出来的,如果数据中异常点较多,最大值和最小值非常容易受异常点影响

所以这种方法鲁棒性(健壮性)较差,只适合传统精确小数据场景

2、定义

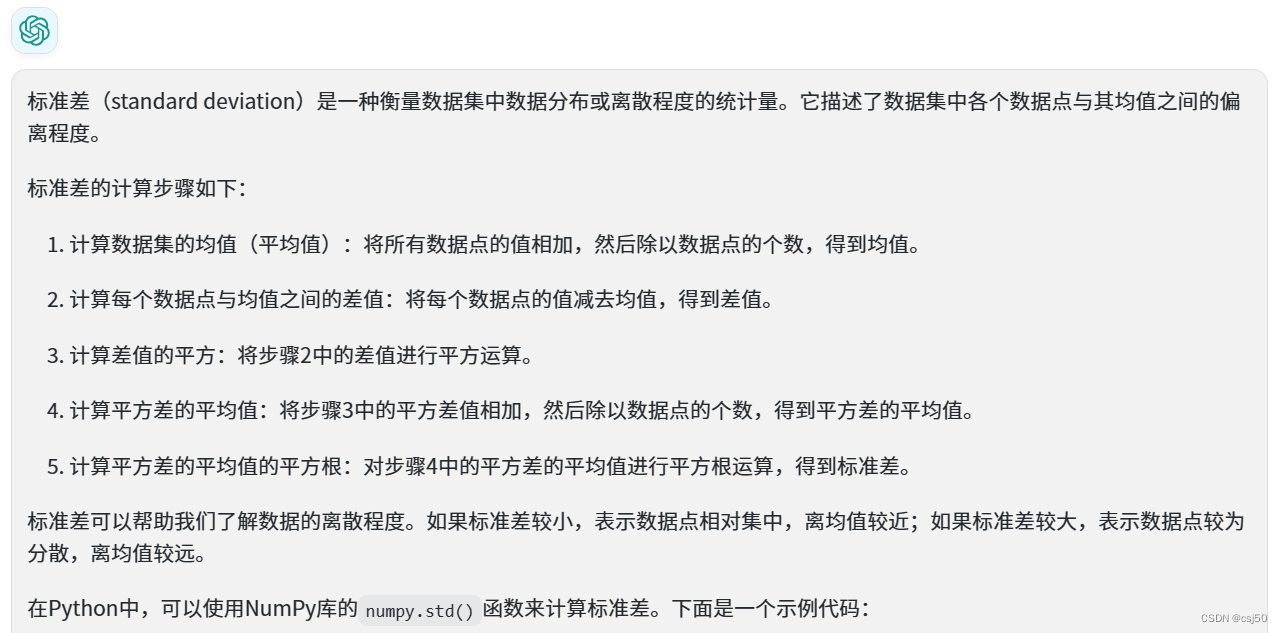

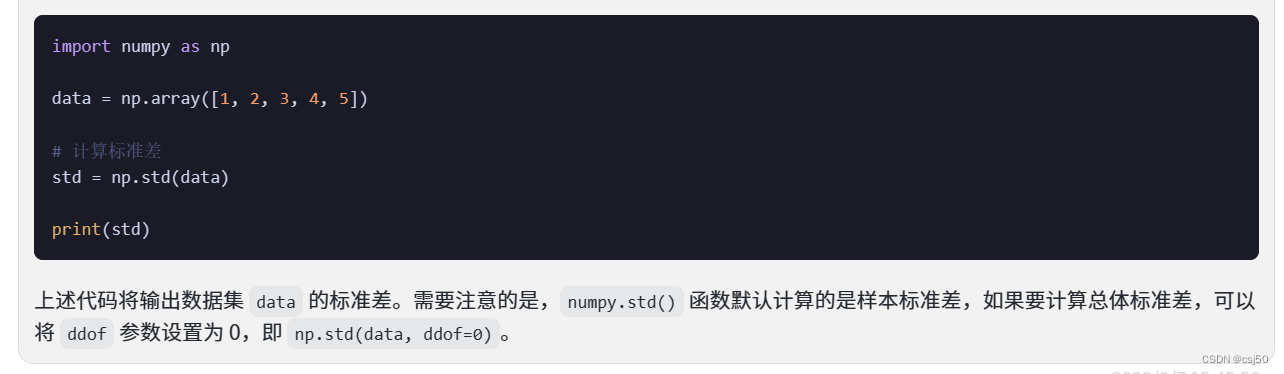

通过对原始数据进行变换把数据变换到均值为0,标准差为1范围内

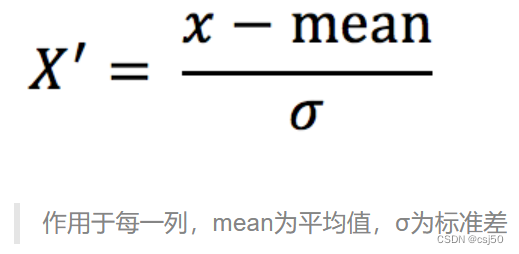

3、公式

用数据减去这一列的平均值,除以标准差

4、什么是标准差

5、API函数

sklearn.preprocessing.StandardScaler()

处理后,对每列来说,所有数据都聚集在均值为0附近,标准差为1

6、StandardScaler.fit_transform(X)

X:numpy array格式的数据[n_samples, n_features]

返回值:转换后的形状相同的array

7、标准化处理dating.txt中的数据

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction import DictVectorizer

from sklearn.feature_extraction.text import CountVectorizer, TfidfVectorizer

from sklearn.preprocessing import MinMaxScaler, StandardScaler

import jieba

import pandas as pd

def datasets_demo():

"""

sklearn数据集使用

"""

#获取数据集

iris = load_iris()

print("鸢尾花数据集:\n", iris)

print("查看数据集描述:\n", iris["DESCR"])

print("查看特征值的名字:\n", iris.feature_names)

print("查看特征值几行几列:\n", iris.data.shape)

#数据集的划分

x_train, x_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.2, random_state=22)

print("训练集的特征值:\n", x_train, x_train.shape)

return None

def dict_demo():

"""

字典特征抽取

"""

data = [{'city': '北京','temperature':100},{'city': '上海','temperature':60},{'city': '深圳','temperature':30}]

# 1、实例化一个转换器类

transfer = DictVectorizer(sparse=False)

# 2、调用fit_transform()

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new)

print("特征名字:\n", transfer.get_feature_names())

return None

def count_demo():

"""

文本特征抽取

"""

data = ["life is short,i like like python", "life is too long,i dislike python"]

# 1、实例化一个转换器类

transfer = CountVectorizer()

# 2、调用fit_transform()

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def count_chinese_demo():

"""

中文文本特征抽取

"""

data = ["我 爱 北京 天安门", "天安门 上 太阳 升"]

# 1、实例化一个转换器类

transfer = CountVectorizer()

# 2、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new.toarray());

print("特征名字:\n", transfer.get_feature_names())

return None

def cut_word(text):

"""

进行中文分词

"""

return " ".join(list(jieba.cut(text))) #返回一个分词生成器对象,强转成list,再join转成字符串

def count_chinese_demo2():

"""

中文文本特征抽取,自动分词

"""

# 1、将中文文本进行分词

data = ["今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。",

"我们看到的从很远星系来的光是在几百万年前之前发出的,这样当我们看到宇宙时,我们是在看它的过去。",

"如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。"]

data_new = []

for sent in data:

data_new.append(cut_word(sent))

print(data_new)

# 2、实例化一个转换器类

transfer = CountVectorizer()

# 3、调用fit_transform()

data_final = transfer.fit_transform(data_new)

print("data_final:\n", data_final.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def tfidf_demo():

"""

用tf-idf的方法进行文本特征抽取

"""

# 1、将中文文本进行分词

data = ["今天很残酷,明天更残酷,后天很美好,但绝对大部分是死在明天晚上,所以每个人不要放弃今天。",

"我们看到的从很远星系来的光是在几百万年前之前发出的,这样当我们看到宇宙时,我们是在看它的过去。",

"如果只用一种方式了解某样事物,你就不会真正了解它。了解事物真正含义的秘密取决于如何将其与我们所了解的事物相联系。"]

data_new = []

for sent in data:

data_new.append(cut_word(sent))

print(data_new)

# 2、实例化一个转换器类

transfer = TfidfVectorizer()

# 3、调用fit_transform()

data_final = transfer.fit_transform(data_new)

print("data_final:\n", data_final.toarray())

print("特征名字:\n", transfer.get_feature_names())

return None

def minmax_demo():

"""

归一化

"""

# 1、获取数据

data = pd.read_csv("dating.txt")

#print("data:\n", data)

data = data.iloc[:, 0:3] #行都要,列取前3列

print("data:\n", data)

# 2、实例化一个转换器

transfer = MinMaxScaler()

# 3、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new)

return None

def stand_demo():

"""

标准化

"""

# 1、获取数据

data = pd.read_csv("dating.txt")

#print("data:\n", data)

data = data.iloc[:, 0:3] #行都要,列取前3列

print("data:\n", data)

# 2、实例化一个转换器

transfer = StandardScaler()

# 3、调用fit_transform

data_new = transfer.fit_transform(data)

print("data_new:\n", data_new)

return None

if __name__ == "__main__":

# 代码1:sklearn数据集使用

#datasets_demo()

# 代码2:字典特征抽取

#dict_demo()

# 代码3:文本特征抽取

#count_demo()

# 代码4:中文文本特征抽取

#count_chinese_demo()

# 代码5:中文文本特征抽取,自动分词

#count_chinese_demo2()

# 代码6: 测试jieba库中文分词

#print(cut_word("我爱北京天安门"))

# 代码7:用tf-idf的方法进行文本特征抽取

#tfidf_demo()

# 代码8:归一化

#minmax_demo()

# 代码9:标准化

stand_demo()

运行结果:

data:

milage liters consumtime

0 40920 8.326976 0.953952

1 14488 7.153469 1.673904

2 26052 1.441871 0.805124

3 75136 13.147394 0.428964

4 38344 1.669788 0.134296

.. ... ... ...

984 11145 3.410627 0.631838

985 68846 9.974715 0.669787

986 26575 10.650102 0.866627

987 48111 9.134528 0.728045

988 43757 7.882601 1.332446

[989 rows x 3 columns]

data_new:

[[ 0.33984938 0.42024644 0.2460588 ]

[-0.86581884 0.14356328 1.69344575]

[-0.338339 -1.2030865 -0.05314407]

...

[-0.31448289 0.96798056 0.07050117]

[ 0.66785937 0.61064669 -0.2081032 ]

[ 0.46925618 0.31547409 1.00698075]]

8、标准化小结

在已有样本足够多的情况下比较稳定,适合现代嘈杂大数据场景