目录

LSTM(Long Short-Term Memory)网络模型是一种递归神经网络,被广泛应用于自然语言处理、语音识别、图像处理等领域。本文将从LSTM的基础结构、训练方法、应用场景等方面进行详细介绍

LSTM(Long Short-Term Memory)介绍

在人工智能领域,递归神经网络(Recurrent Neural Network,RNN)是一种重要的神经网络模型。它具有记忆性,可以处理序列数据,被广泛应用于自然语言处理、语音识别、图像处理等领域。LSTM(Long Short-Term Memory)网络是一种特殊的RNN,它能够解决传统RNN中存在的梯度消失和梯度爆炸问题,从而更好地处理长序列数据。本文将从LSTM的基础结构、训练方法、应用场景等方面进行详细介绍。

LSTM的基础结构

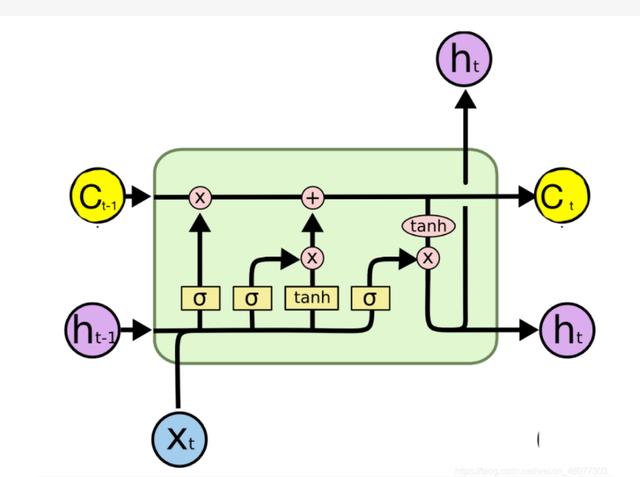

LSTM网络模型是由Hochreiter和Schmidhuber于1997年提出的。相比于传统的RNN,LSTM网络模型引入了三个门控单元,分别是输入门、遗忘门和输出门,从而实现了对信息的选择性记忆。下面我们来详细介绍一下LSTM的基础结构。

1. 记忆细胞(Memory Cell)

LSTM网络模型的核心是记忆细胞,它负责存储和传递信息。记忆细胞由一个线性单元和一个非线性单元组成。线性单元是一个简单的加法器,用于将上一时刻的记忆细胞和当前时刻的输入相加。非线性单元是一个sigmoid函数,用于控制信息的流动。

2. 输入门(Input Gate)

输入门用于控制信息的输入。它由一个sigmoid函数和一个点乘操作组成。sigmoid函数用于将输入的信息转化为0~1之间的值,点乘操作用于将输入的信息与sigmoid函数的输出相乘。输入门的输出将会被加入到记忆细胞中。

3. 遗忘门(Forget Gate)

遗忘门用于控制信息的遗忘。它由一个sigmoid函数和一个点乘操作组成。sigmoid函数用于将上一时刻的记忆细胞和当前时刻的输入转化为0~1之间的值,点乘操作用于将上一时刻的记忆细胞与sigmoid函数的输出相乘。遗忘门的输出将会被从记忆细胞中减去。

4. 输出门(Output Gate)

输出门用于控制信息的输出。它由一个sigmoid函数和一个点乘操作组成。sigmoid函数用于将当前时刻的记忆细胞和当前时刻的输入转化为0~1之间的值,点乘操作用于将当前时刻的记忆细胞与sigmoid函数的输出相乘。输出门的输出将会被作为当前时刻的输出。

LSTM的训练方法

LSTM网络模型的训练方法与传统的RNN相似,都是采用反向传播算法。在反向传播算法中,我们需要计算损失函数对网络参数的梯度。但是由于LSTM网络模型中存在门控单元,导致梯度的计算比较复杂。为了解决这个问题,我们可以采用一种称之为“反向传播加权”的方法。

反向传播加权的核心思想是将门控单元的梯度乘以一个权重,从而使其对梯度的贡献更大。具体来说,我们可以将门控单元的输出与门控单元的输入相乘,从而得到一个权重,将其乘以门控单元的梯度即可。

LSTM的应用场景

LSTM网络模型被广泛应用于自然语言处理、语音识别、图像处理等领域。下面我们来介绍一下LSTM在这些领域中的应用场景。

1. 自然语言处理

在自然语言处理中,LSTM网络模型可以用于文本分类、情感分析、机器翻译等任务。通过对文本序列进行建模,LSTM能够捕捉到文本中的长期依赖关系,从而提高模型的准确率。

2. 语音识别

在语音识别中,LSTM网络模型可以用于声学模型和语言模型的建模。通过对语音信号和语言模型进行联合建模,LSTM能够提高语音识别的准确率。

3. 图像处理

在图像处理中,LSTM网络模型可以用于图像标注、图像生成等任务。通过对图像序列进行建模,LSTM能够捕捉到图像中的长期依赖关系,从而提高模型的准确率。

总结

LSTM网络模型是一种特殊的RNN,它能够解决传统RNN中存在的梯度消失和梯度爆炸问题,从而更好地处理长序列数据。本文从LSTM的基础结构、训练方法、应用场景等方面进行了详细介绍。希望本文能够为读者提供全面的LSTM知识体系,从而更好地应用于实际场景中。