感知机与神经网络基础知识(入门)

先看定义:

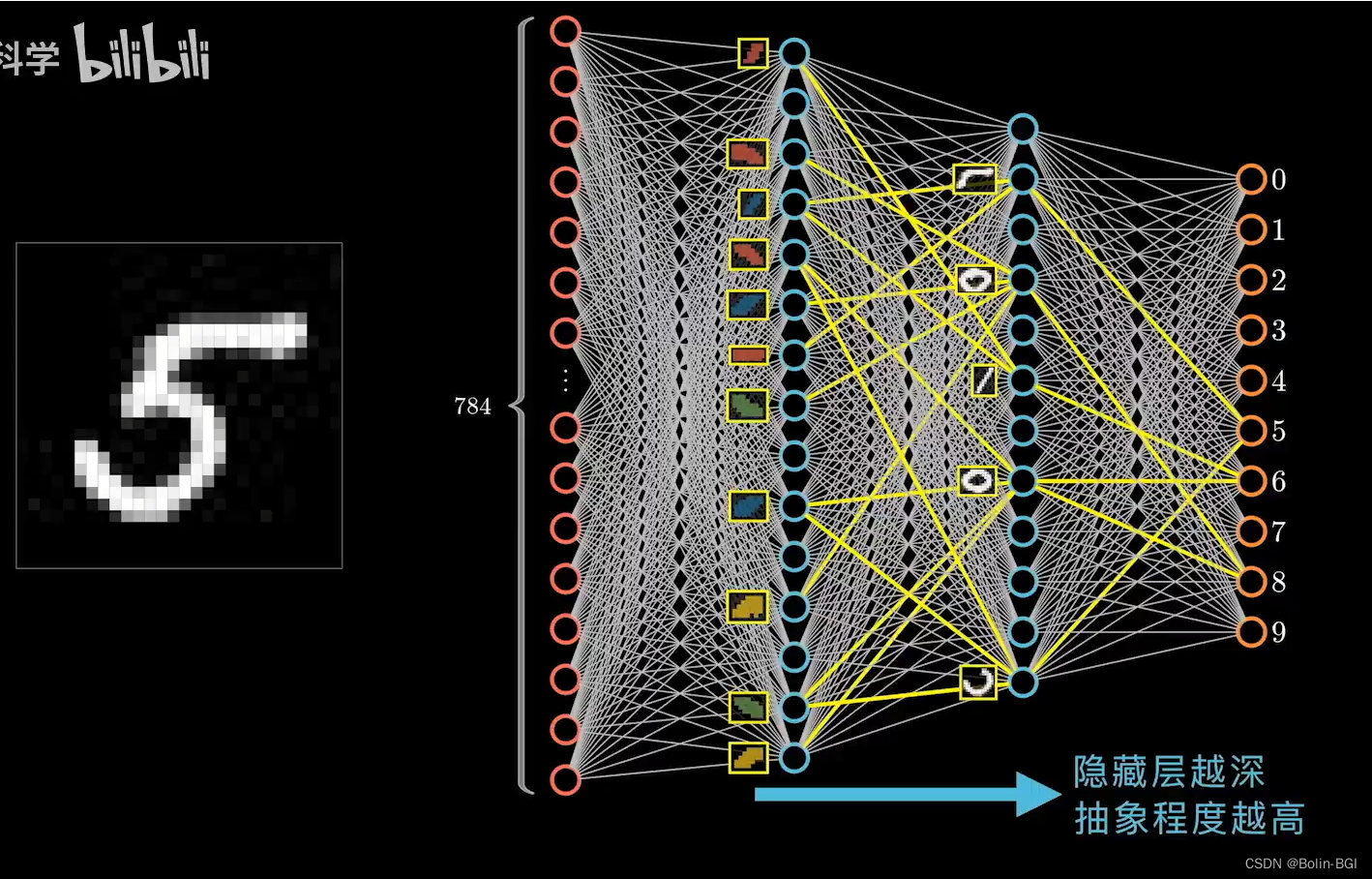

人工神经网络(Artificial Neural Networks,简写为ANNs) 也简称为神经网络(NNs)在这里插入图片描述

或称作连接模型(Connection Model),它是一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。

- 人类神经网络基本单元是——神经元

- 人工智能神经网络基本单元是——感知机

什么是感知机?

先看定义

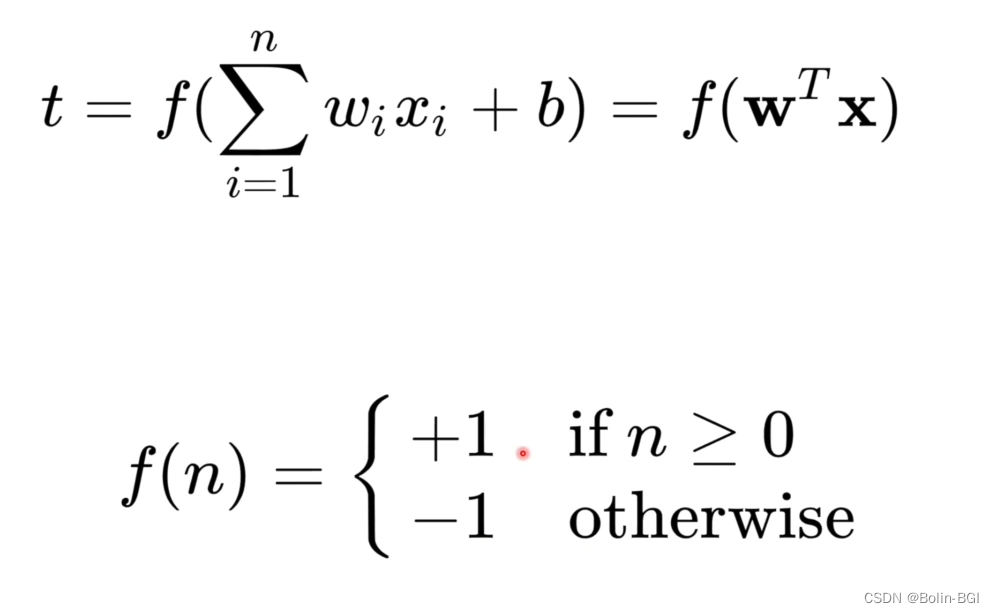

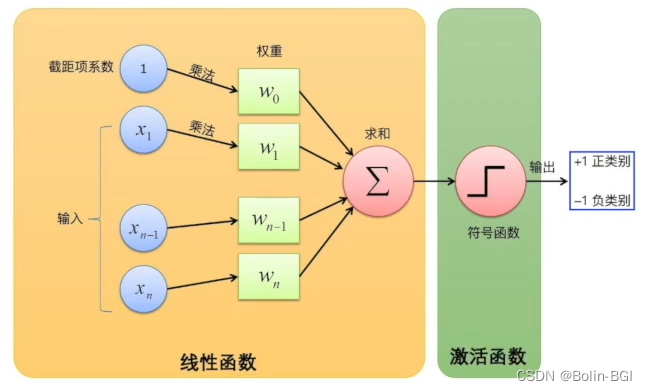

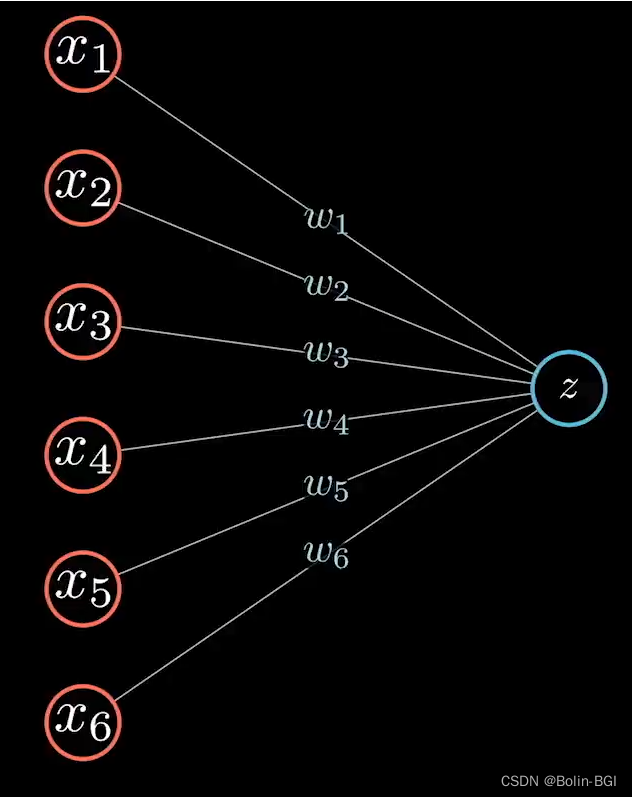

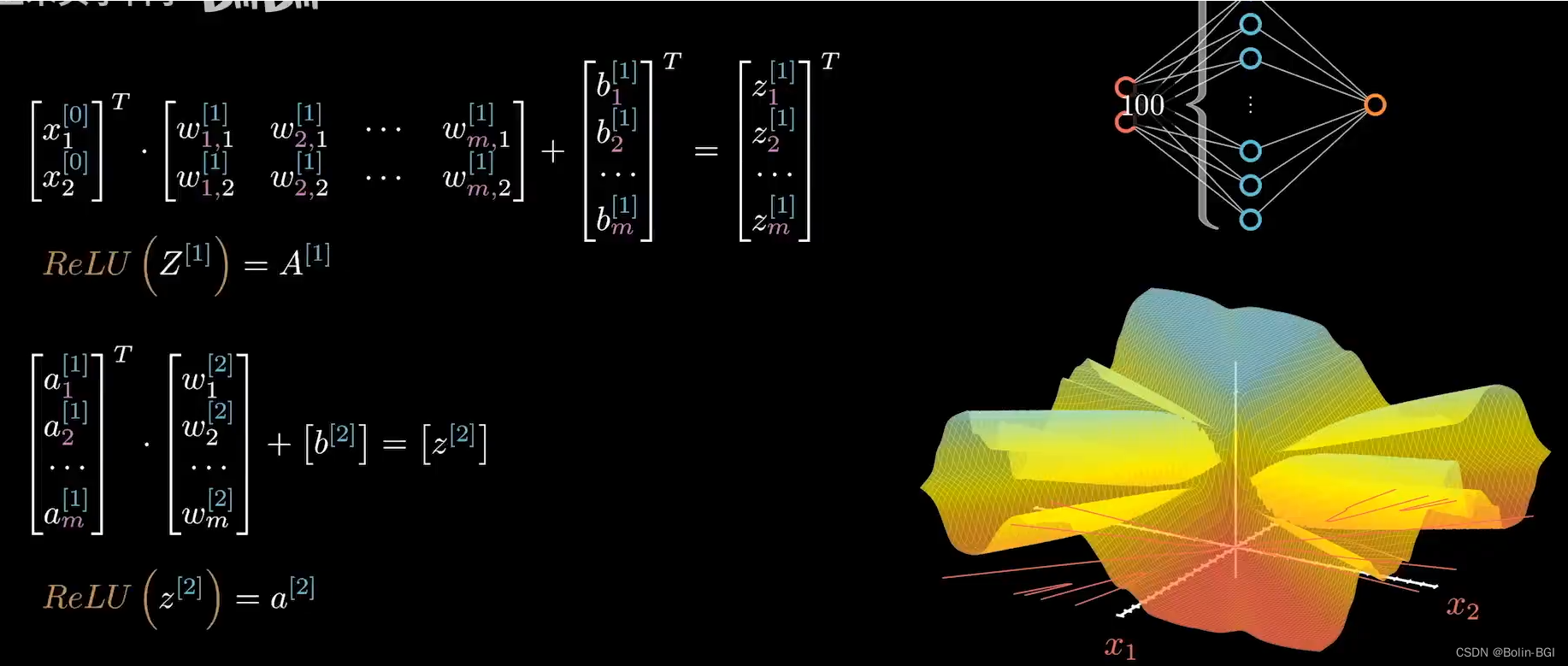

公式如下图所示

感知机由线性函数和激活函数构成,我们举例如下:

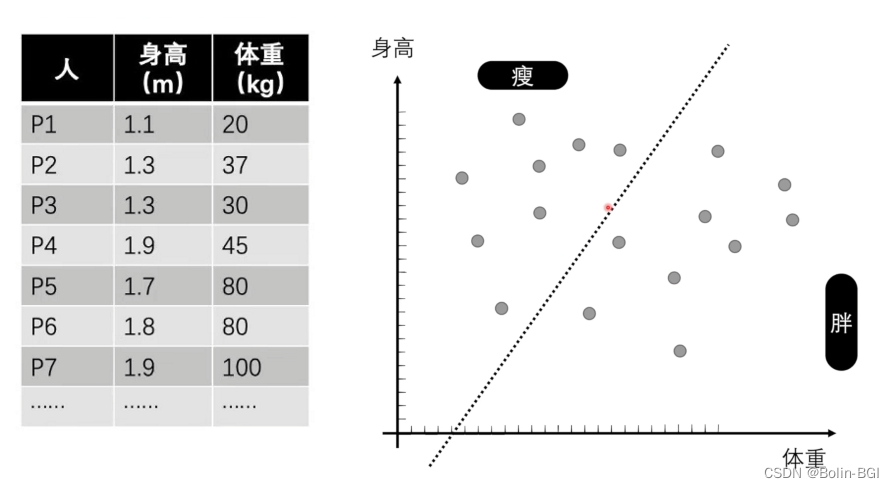

我们有一组身高体重的二维数据,在直角坐标系标点,随着数据增多我们可以看出数据大致分为两块儿,左上角 “瘦” 的和右下角 “胖” 的。那我我们是不是可以对该数据建模,找出平面中一条直线 y = kx + b,用来区分这些数据呢?假如有这样一条直线或者我们称之为线性函数被拟合出来,那么我们以后只要有一组身高体重数据,带入进去判断函数值是否 >0或者<0,就可以知道是 “胖” 的 or “瘦” 的。这就构成了最基本的感知机 。通过构建线性函数ax+by+c=0,将二维数据带入,判断正负,进而将直角坐标系的二维空间切割分类,如上图所示,线性函数左边是“瘦” 的,右边是 “胖” 的。fn=(WTT)我们称之为激活函数,用来把线性函数判断出的结果分类。

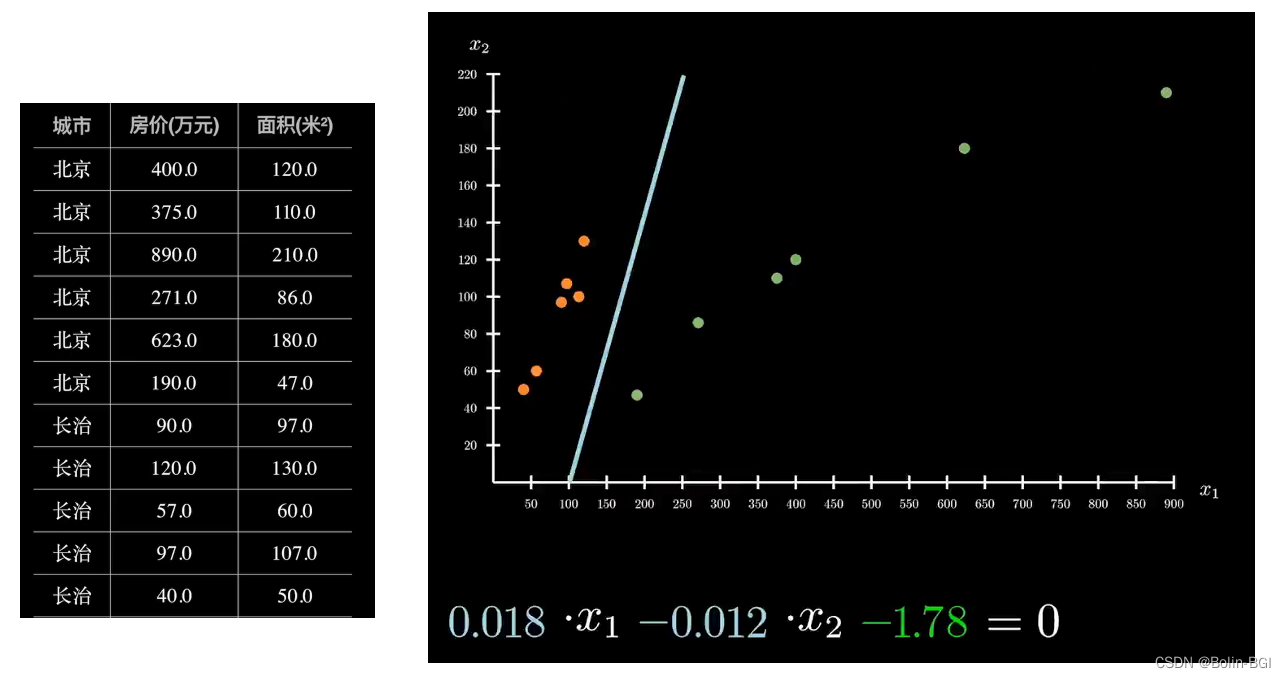

再举个例子

同样是在二维空间中构建线性函数ax+bx+c=0,然后用激活函数将房价区分开来。

同理可得

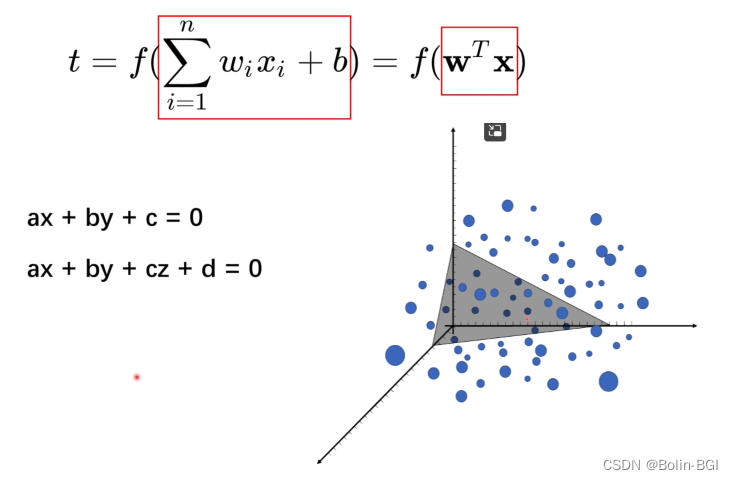

我们前两个例子都是在平面中划分空间,将实际的现实问题,变形为抽象的数学问题,将现实问题投影到空间中进行分类解决。

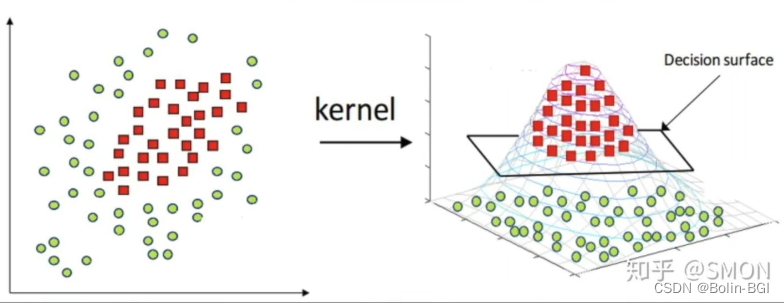

但实际问题可能比这个复杂的多,比如下图的三维问题:

当输入数据为三维数据时,线性函数构建出来三维的空间,激活函数将数据在空间中分类;

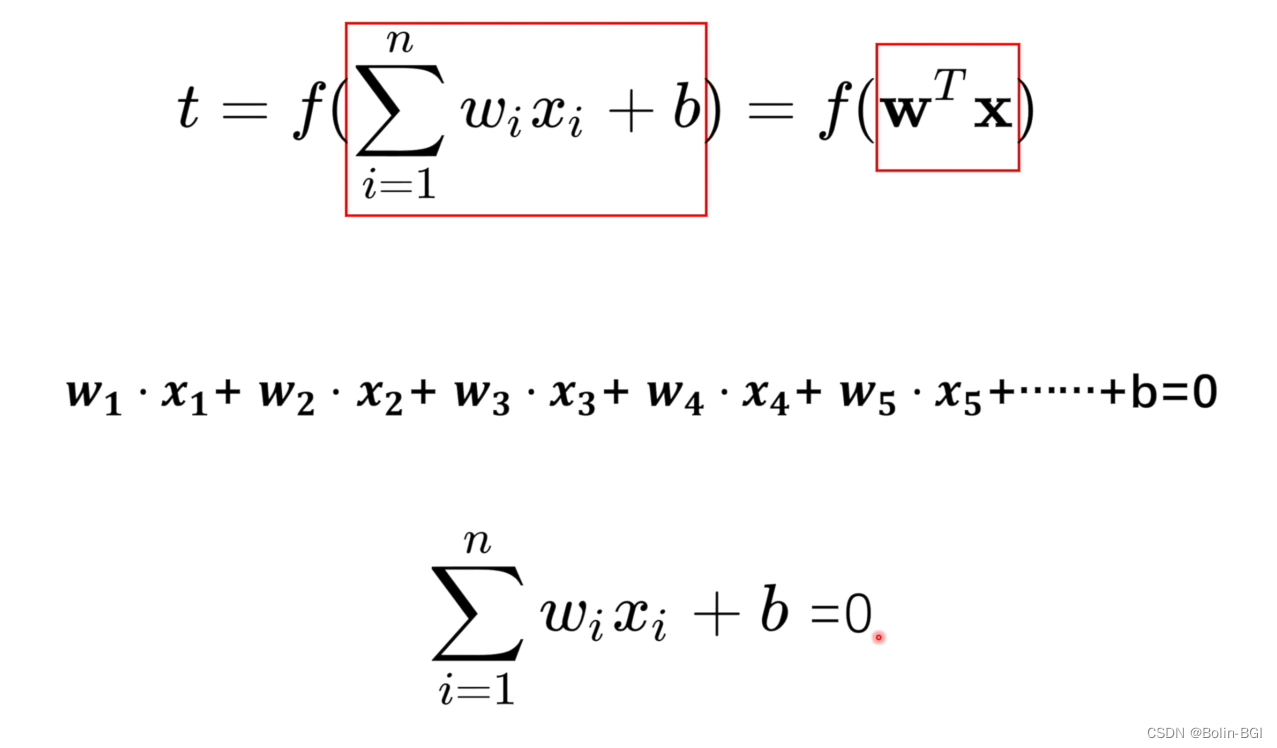

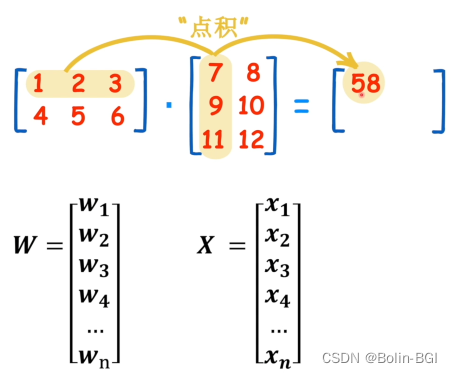

大家如果线性代数基础不好的话,可能对这个公式不太理解,说明如下:

WT矩阵是线性函数的参数矩阵,用WT*X两个矩阵内积的形式,表示了N维的线性函数。

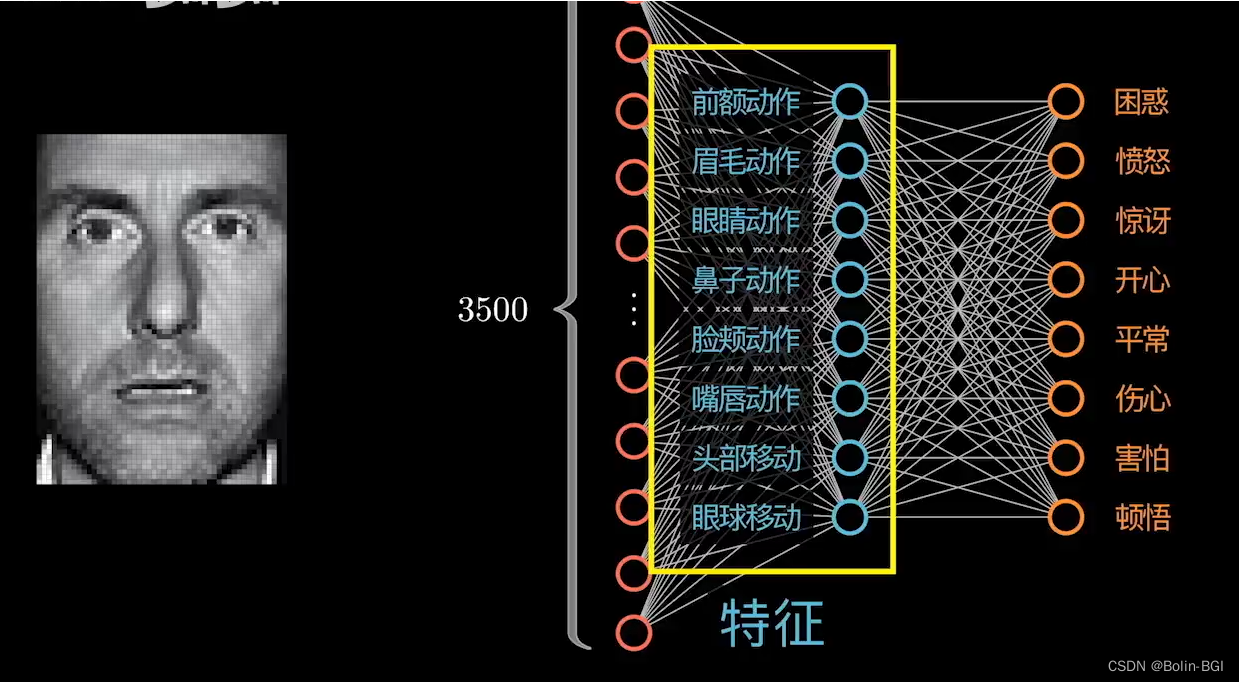

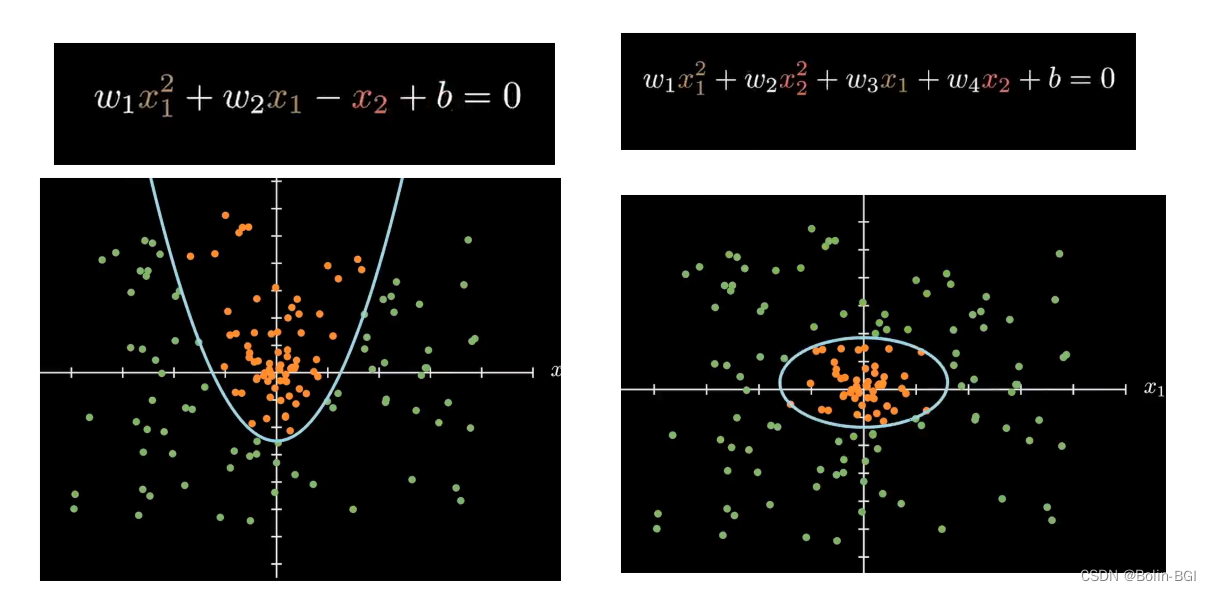

那么感知机维度上升会怎样呢?不仅仅是二维、三维?

举例如下,类似的还有很多:

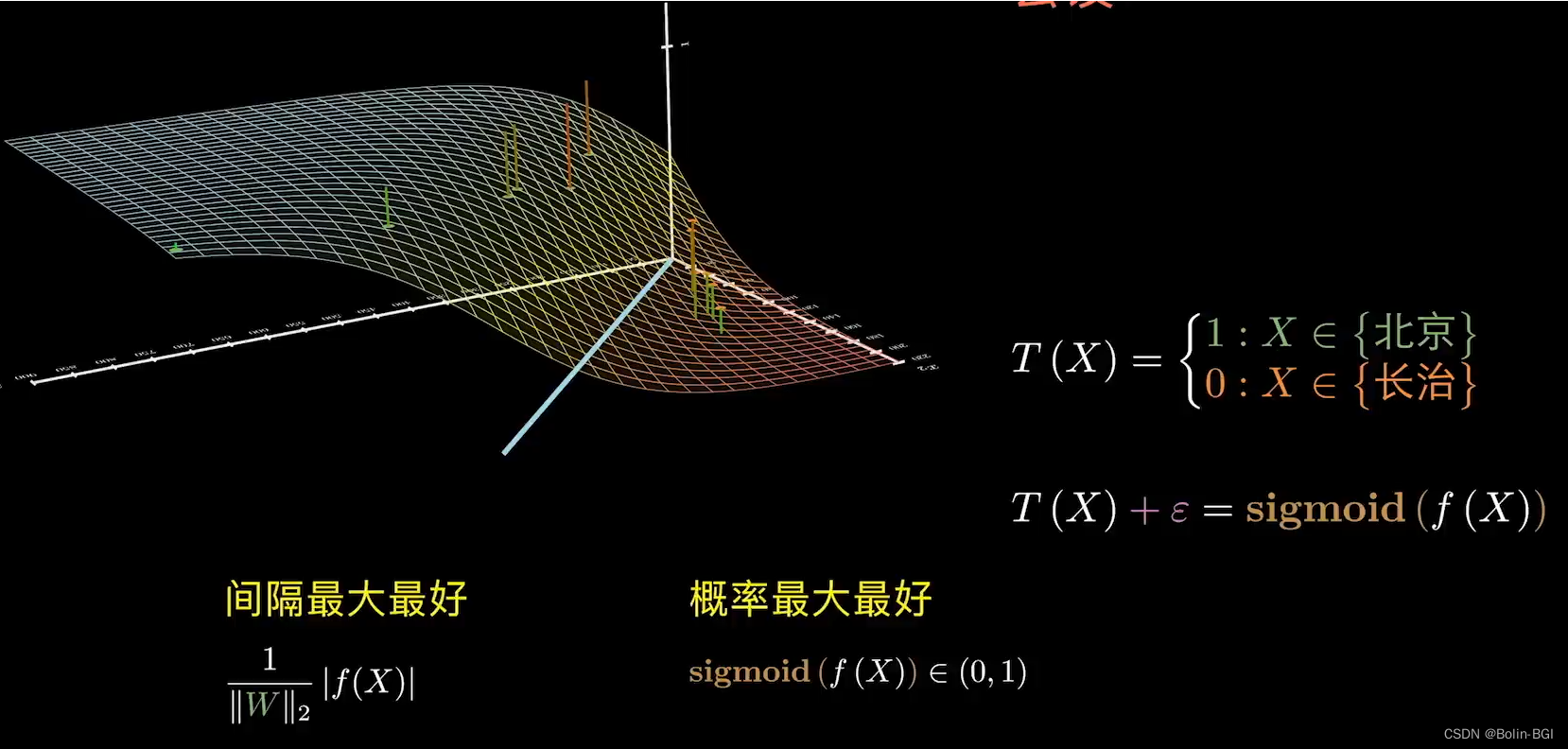

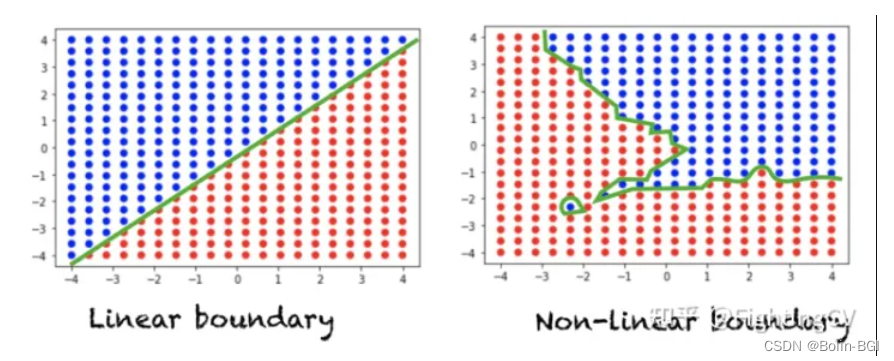

但我们到现在发现一个问题,一个是目前我们的线性函数解决的只是线性分类问题(直线or平面),无法处理更复杂的分类,而且激活函数判断只有(+1 or -1)即(“是” or “否”)的问题,而真实情况并不简单的非黑即白。比如说,我们输入房价数据,希望的出的结论是,这个数据更可能是“北京” or “长治” 的房价。

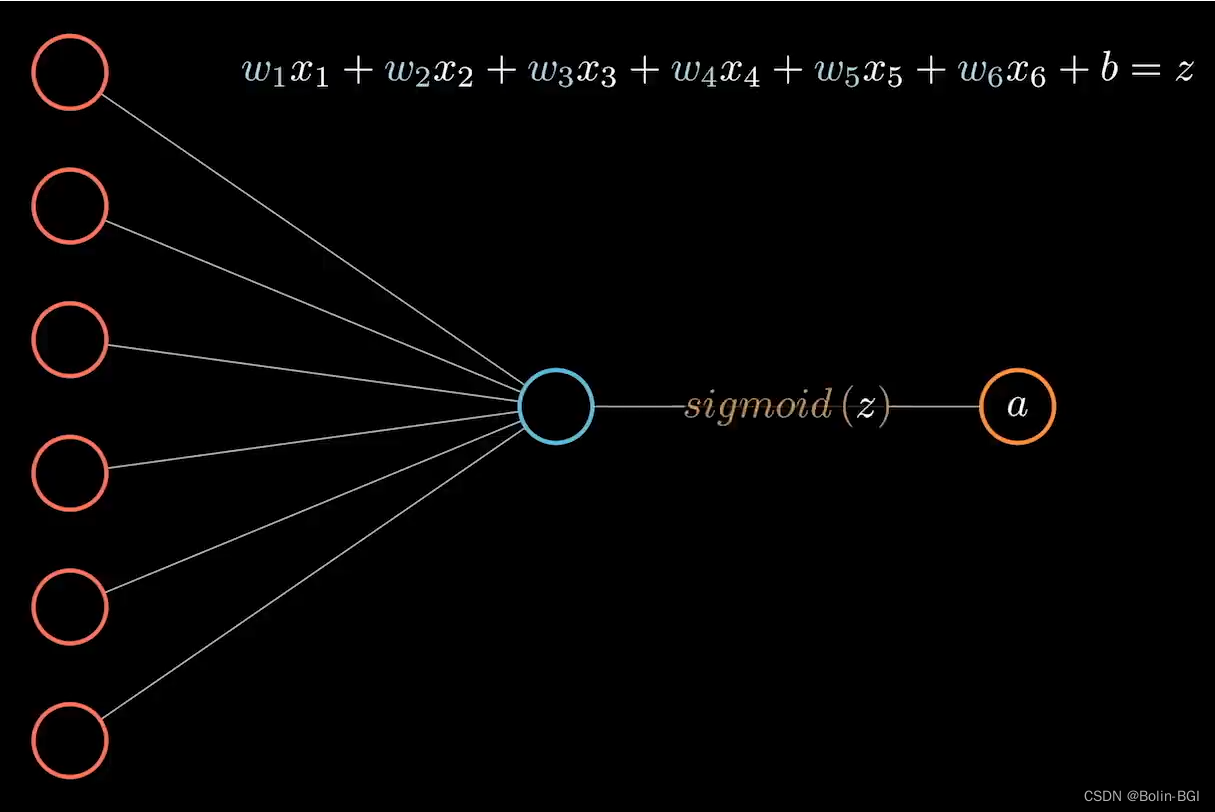

因此,为了解决这个问题,我们引入了全新的激活函数,这是感知机的一次超进化!

**如下图所示:**我们引入了全新的激活函数sigmoid

- Sigmoid函数是理解神经网络如何学习复杂问题的关键,解决了非线性可分问题

- Sigmoid函数也可以作为压缩函数,因为它的域是所有实数的集合,它的范围是(0,1)。因此,如果函数的输入是一个非常大的负数或非常大的正数,则输出总是介于0和1之间。在-∞和 + ∞之间的任何数字也是如此。

- Sigmoid函数被用作神经网络中的激活函数。为了回顾什么是激活函数神经元,下面的图显示了激活函数神经元在神经网络的一个层中所起的作用。输入的加权和通过一个激活函数,这个输出作为下一层的输入。

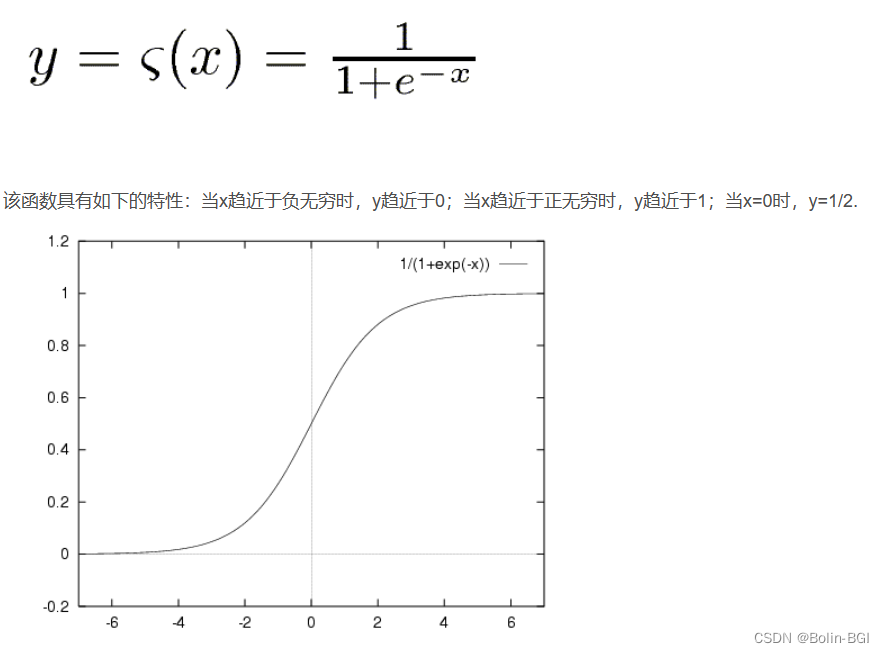

sigmoid函数公式

解决非线性可分问题

那么说了这么多,跟神经网络有什么关系呢?

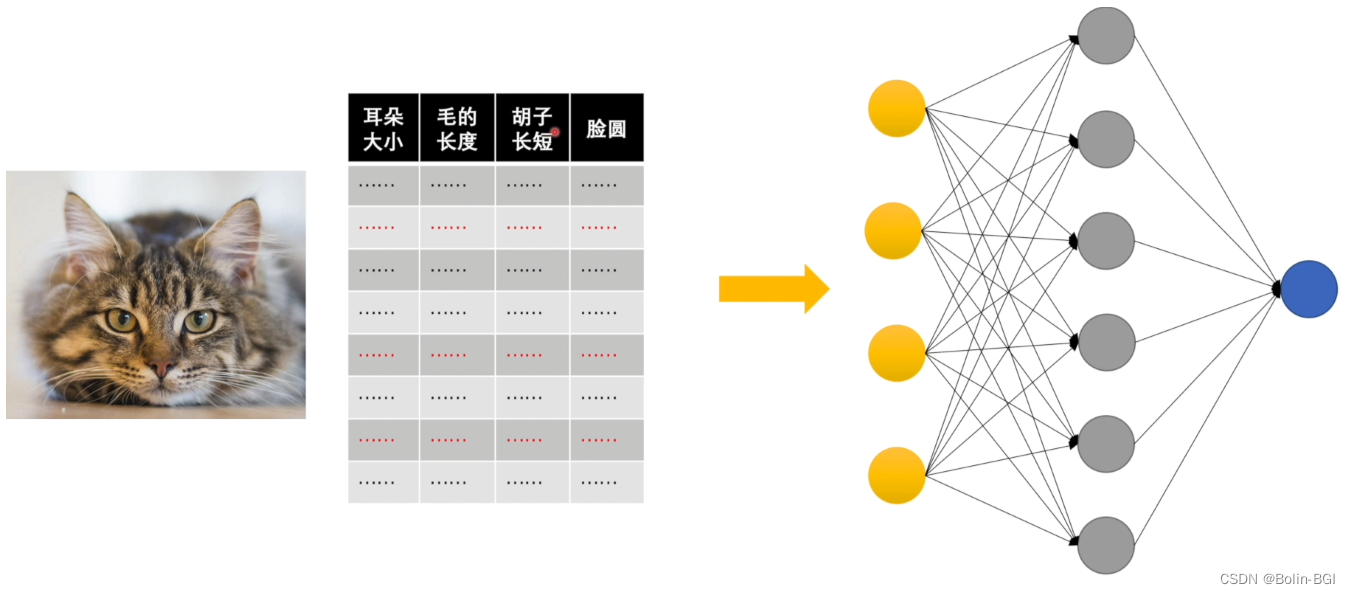

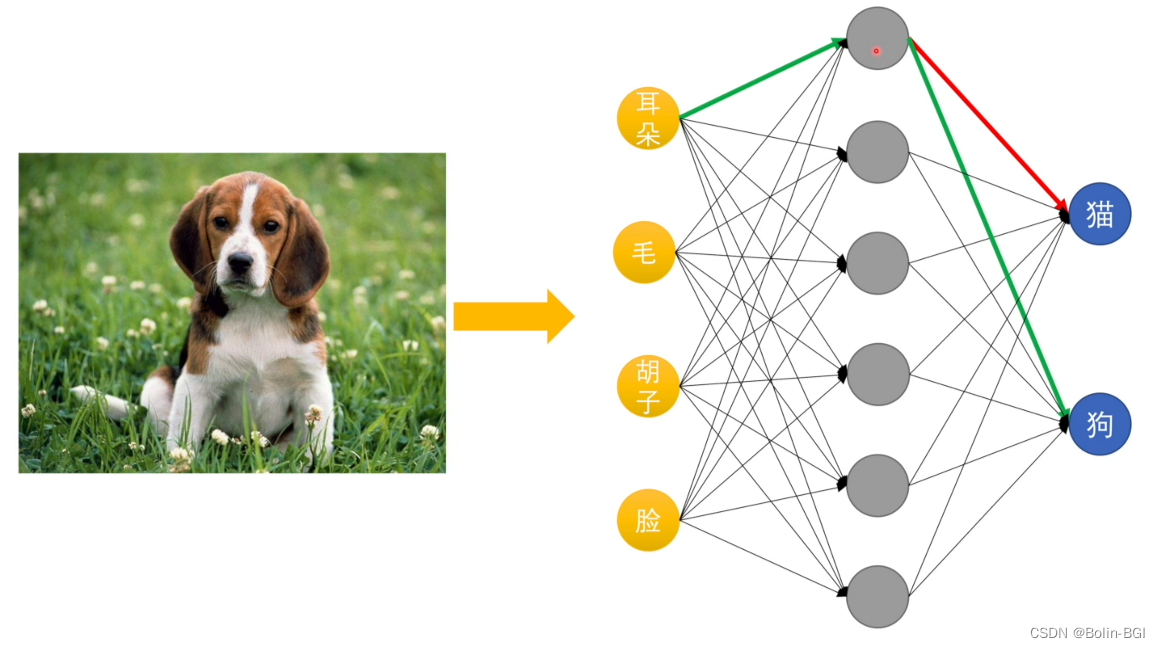

我们继续举例:

是不是有点像神经网络了呢?

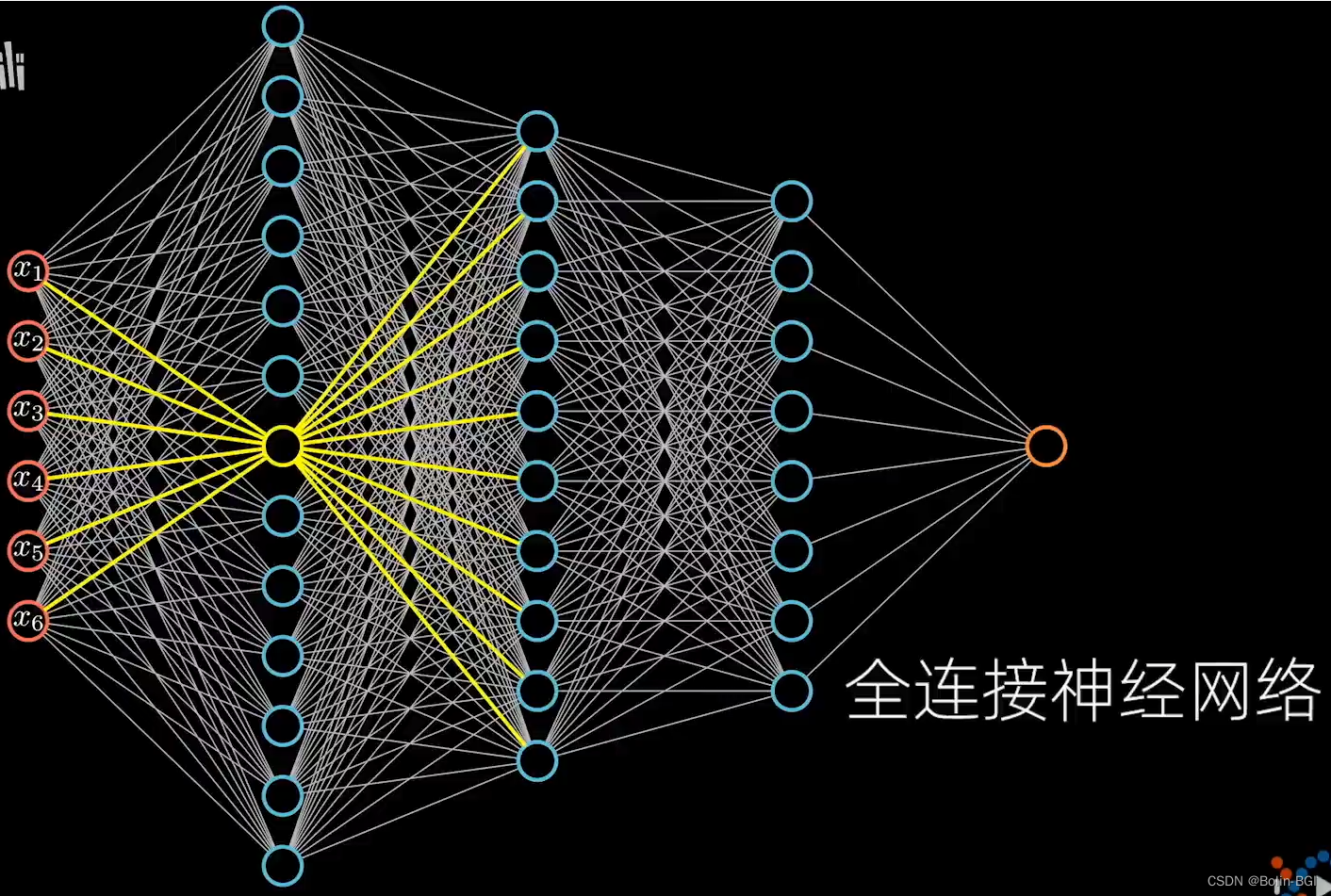

把输入的N维的X数据,投影到对应高维空间中分类!

那么我们发现了机器学习的本质:y=σ(wx+b)

y=σ(wx+b),将现实世界中的某个复杂问题,通过非线性变换,投射高高维空间进行分类判别!(把一个看起来不合理的东西,通过某个手段(训练模型),让这个东西变得合理)

非线性变换的本质又是什么?

改变空间上的位置坐标,任何一个点都可以在维度空间上找到,通过某个手段,让一个不合理的点(位置不合理),变得合理

举例如下:

神经网络

输入数据,层层分类,最后判别!