1. 扩张卷积

Dilated Convolutions,翻译为扩张卷积或空洞卷积。扩张卷积与普通的卷积相比,除了卷积核的大小以外,还有一个扩张率(dilation rate)参数,主要用来表示扩张的大小。扩张卷积与普通卷积的相同点在于,卷积核的大小是一样的,在神经网络中即参数数量不变,区别在于扩张卷积具有更大的感受野。感受野是卷积核在图像上看到的大小,或者说卷积后的图像上,一个像素点对应着原图中的多少像素点。例如3*3卷积核的感受野大小为9。

2. 示意图

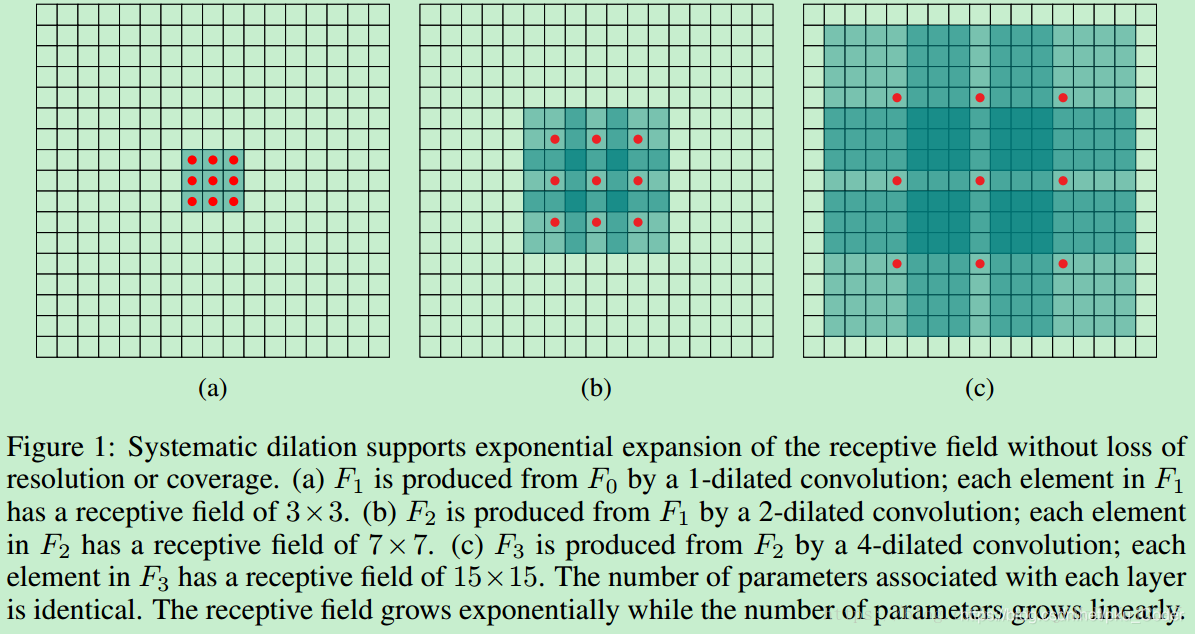

下图是扩张卷积的示意图。

(a) 普通卷积,1-dilated convolution,卷积核的感受野为3×3=9。

(b) 扩张卷积,2-dilated convolution,卷积核的感受野为7×7=49。

(c) 扩张卷积,4-dilated convolution,卷积核的感受野为15×15=225。

从上图中可以看出,卷积核的参数个数保持不变,感受野的大小随着“dilation rate”参数的增加呈指数增长。

3. 优点

扩展卷积在保持参数个数不变的情况下增大了卷积核的感受野,同时它可以保证输出的特征映射(feature map)的大小保持不变。一个扩张率为2的3×3卷积核,感受野与5×5的卷积核相同,但参数数量仅为9个,是5×5卷积参数数量的36%。

增大感受野的方法还有pooling层,多层卷积等。pooling每次会减少特征图的尺寸。这样在上采样的时候,会丢失很多信息。连续多层卷积,比如连续很多层使用3*3, step_size=1的卷积核,虽然也能在增大感受野的同时保证特征图尺寸,但感受野线性增长,而扩张卷积感受野指数增长。

4. 应用

扩张卷积在图像分割、语音合成、机器翻译、目标检测中都有应用。