目录

梗概

本博客用于记录机器学习理论学习与优化问题推导所需的各种前置知识。

1、拉格朗日函数

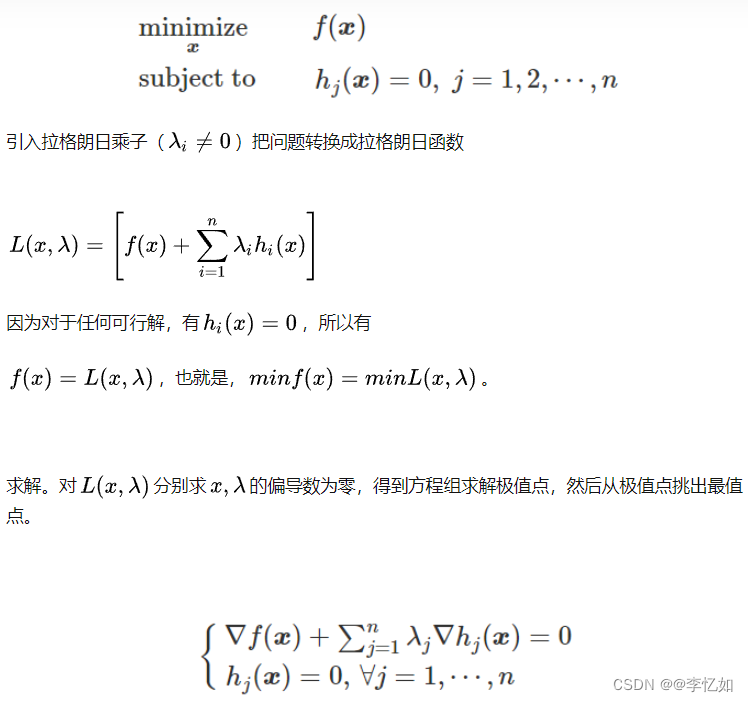

在最优化问题中,求得方法的优化问题与约束条件后,时常要求出对应的拉格朗日函数并求解,以下给出常见的几种情况下的拉格朗日函数构造方法。

1.等式约束最优化(eg. llp)

1.1 无求和

定义其拉格朗日函数为:

对对应要求解未知数求偏导(此处为α)

再对上式使用特征分解即可求解原最优化问题。

1.2 有求和

2.不等式约束最优化(eg. svm)

定义其拉格朗日函数为:

对对应要求解未知数求偏导,令其为0即可。

3.无约束(eg. ls)

直接对应要求解未知数求偏导,令其为0即可。

2、范数

1.F范数

F范数是一种矩阵范数,假设A为mxn矩阵,对应F范数定义如下:

2.l2范数

l2范数即为欧氏距离,常用于度量“误差”,定义如下:

对矩阵而言,l2范数定义如下:

Tips:参数为对应的最大特征值绝对值。

3.l1范数

l1范数即为绝对值之和,定义如下:

4.l2,1范数

l2,1范数即为先按列求l2范数再按行求l1范数,定义如下:

定义对应D矩阵,l2,1范数可改写为:

其中D为对角矩阵,对角线为1/行的二范数的平方。

3、偏导

常用对矩阵的迹求偏导如下:

详情参考:矩阵的 Frobenius 范数与 trace (迹)的关系及其求偏导法则_热爱生活的菇凉的博客

汇总详解:矩阵的迹以及迹对矩阵求导_CV_ML_DP的博客-CSDN博客_矩阵的迹求导

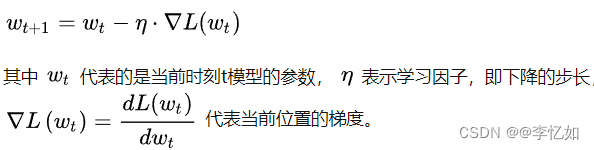

1.梯度下降法

梯度下降法常用在迭代与优化,计算公式可简单理解为即求对应偏导,具体如下:

梯度下降的目的在于,通过不断更新权重参数w,从而使得损失函数L的值不断变小。

2.迹的常用定义与性质

1.tr(AB) = tr(BA)

2.tr(A) = tr(A^T)

3.tr(A + B) = tr(A) + tr(B)

4.tr(rA) = r tr(A) = tr(rA * I)(i为单位矩阵)

4、克罗内克积

克罗内克积是两个任意大小的矩阵间的运算,结果是一个矩阵,记作![]() 。克罗内克积是张量积的特殊形式,具体如下:

。克罗内克积是张量积的特殊形式,具体如下: