文章目录

前言

例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

一、高斯混合模型(Gaussian Mixed Model,GMM) 是什么?

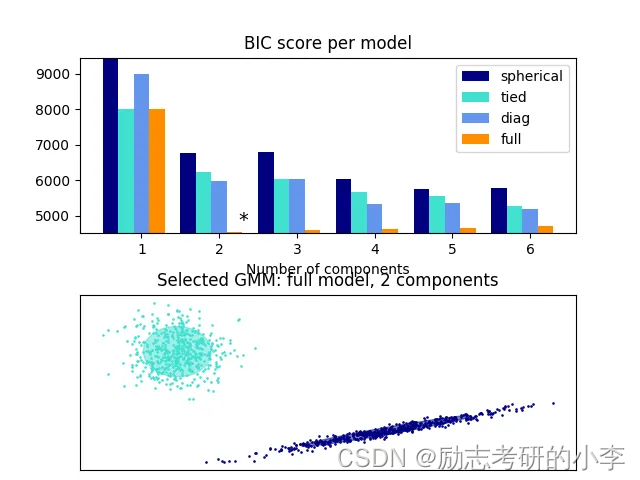

首先高斯混合模型(GMM) 其实也是一种常见的聚类算法,跟K均值算法类似,同样使用了EM算法进行迭代计算。

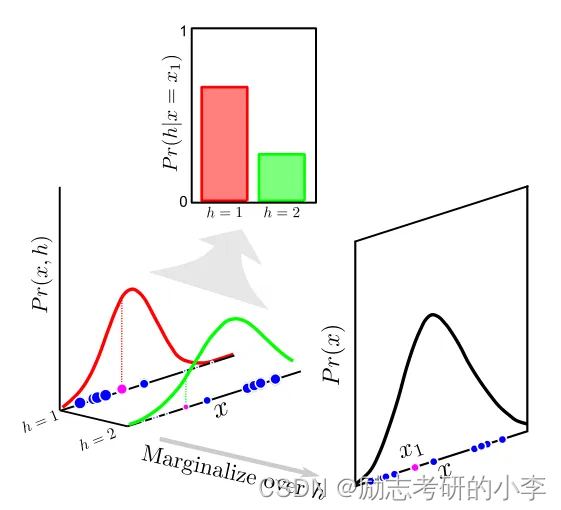

高斯混合模型最核心的思想就是线假设每个簇的数据都是符合高斯分布(又叫正态分布)的,当前数据呈现的分布就是各个簇的高斯分布叠加在一起的结果。它就是用多个高斯分布函数的线形组合来对数据分布来进行拟合,理论上它是可以拟合出任意类型的分布。

二、详解GMM

1.初步原理

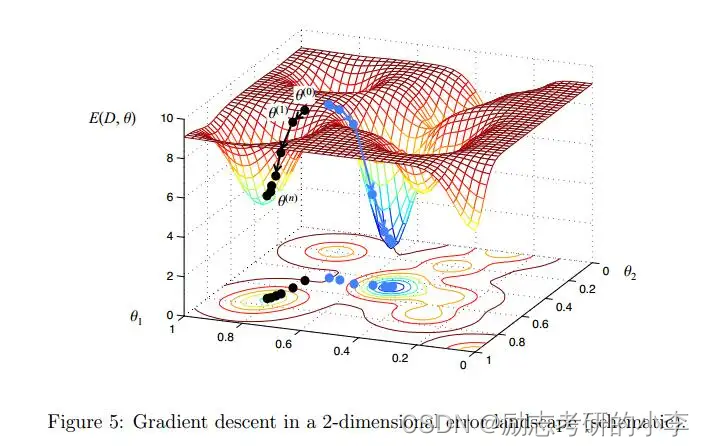

通常我们没办法直接拿到模型的参数,是通过观察数据点,给出了类别数量后,然后通过极大似然估计算法来计算的,但是得到的是一个非常复杂的非凸函数,目标函数是和的对数,难以展开和对其求偏导。这种情况下我们通过EM(最大期望)算法先固定一个变量让整体的函数变为凸优化函数,求导得到最值,然后利用最优参数更新被固定的变量,进入下一个循环进行实现。

2.EM算法

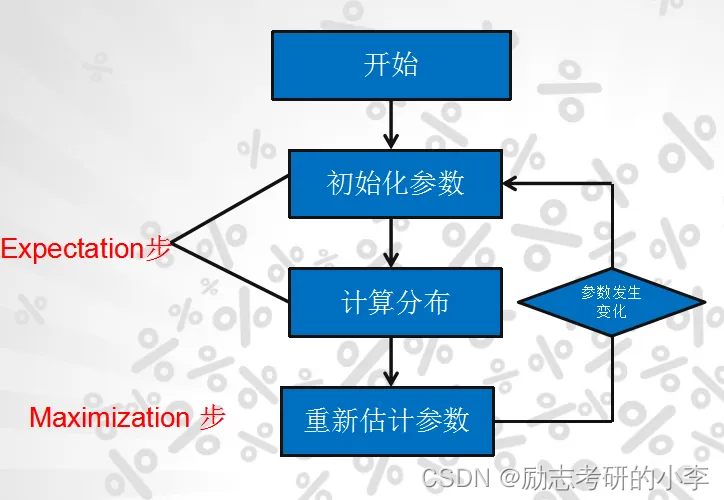

EM算法就是三步:

①E步就是计算期望(E),利用对隐藏变量的现有估计值,计算它的最大似然估计(用期望来消除隐变量);

②M步就是最大化(M),最大化在E步上求得的最大似然值来计算参数的值。

③然后就是迭代。

3.深读原理

高斯混合模型其实是一个生成式模型,刚开始不知道高斯分布的三个参数(均值μ,方差Σ、权重π),也不知道每个数据是哪个高斯分布产生的。所以每次循环的时侯,先固定当前的高斯分布不变,获得每个数据点由各个高斯分布生成的概率。然后固定该生成概率不变,根据数据点和生成概率,获得一个组更佳的高斯分布。循环往复,直到参数的不再变化,或者变化非常小时,然后我们就得到了比较合理的一组高斯分布。

3.GMM(高斯混合模型)和K-means的比较

3-1.相同点:

①都是聚类的算法;

②都需要指定聚K个类;

③都是用EM最大期望来求解;

④一般都只能收敛到局部最优。

3-2.不同点:

①GMM给出一个样本属于某类的概率是多少;

②GMM不仅能做聚类,还能进行概率密度的估计;

③其实GMM还可以用来生成新的样本点。

总结

以上就是今天要讲的内容,本文仅仅简单介绍了GMM的使用