YOLO

使用单个神经网络,在一次评估中直接从完整图像上预测边界框和类别概率。由于整个检测流程仅用一个网络,所以可以直接对检测性能进行端到端的优化。

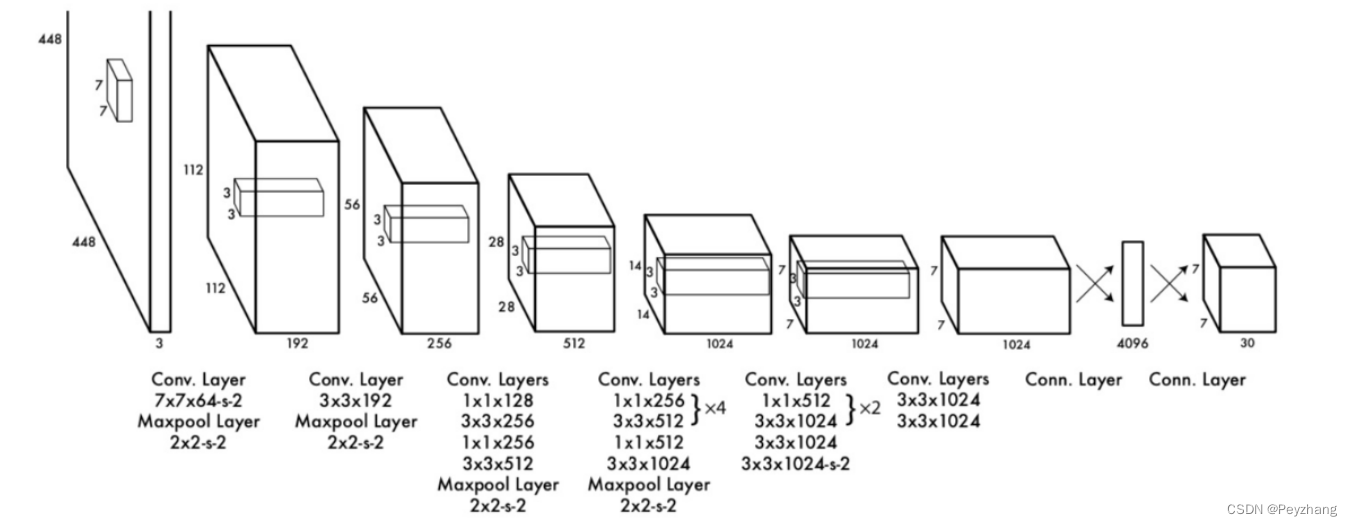

YOLO结构: ---- GoogleNet + 4个卷积 + 2个全连接层

- 1、把图像缩放到448X448

- 2、在图上运行卷积网络

- 3、根据模型的置信度对检测结果进行阈值处理

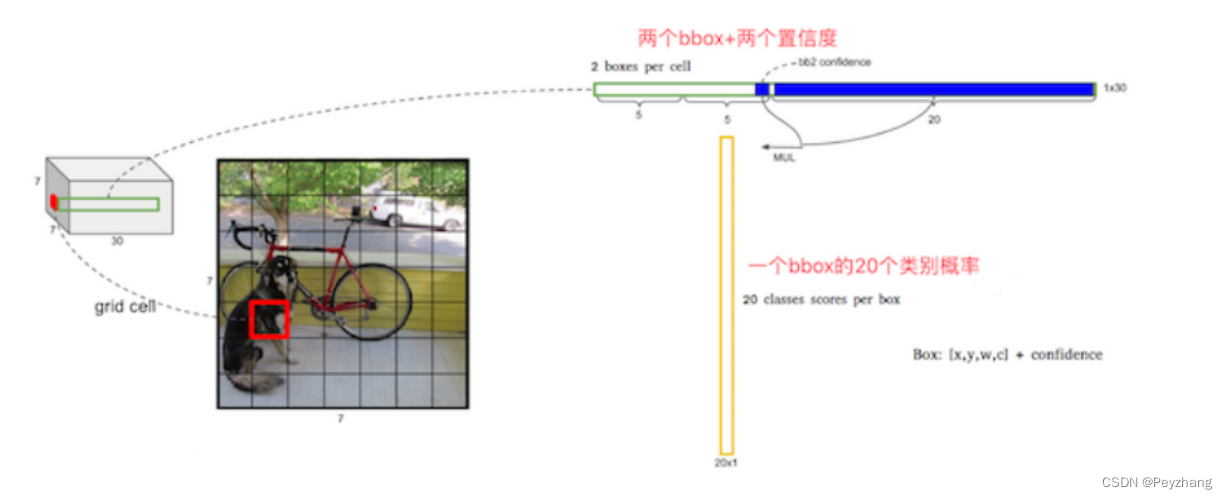

单元格(cell)

7 x 7=49个像素值,理解成49个单元格,每个单元格可以代表原图的一个方块。单元格需要做的两件事:

- 每个边界框包含两个目标预测,每个目标包括5个预测值:x,y,w,h和置信度

- 每个单元格预测两个(默认)bbox位置,两个bbox置信度(confidence) : 7 x 7 x 2=98个bbox。30=(4+1+4+1+20), 4个坐标信息,1个置信度(confidence)代表一个bbox的结果, 20代表 20类的预测概率结果

-

一个网格会预测两个Bbox,在训练时我们只有一个Bbox专门负责(一个Object 一个Bbox)

-

20 个类别概率代表这个网络中的一个bbox

-

confidence

-

如果grid cell里面没有object,confidence就是0

-

如果有,则confidence score等于 预测的box和ground truth的IOU乘积,(每个cell 中两个bbox 都与真实值比较,确定最终的bbox)

-

训练损失

- 三部分损失 bbox损失+confidence损失+classfication损失

YOLO V2

针对YOLO算法,改进:(训练机制,网络改变–Darknet-19,k-means聚类算法对训练集中的边界框做了聚类分析,直接位置预测)

YOLO V3

改进:(网络Darknet-53,逻辑回归替代softmax作为分类器)