之前一直用iphone摄像头给导入UE5的metehuman做面捕,效果还是很不错的。最近有个需求,要求用电脑摄像头做面捕。从网上查了一下,可以通过mefamo来实现。

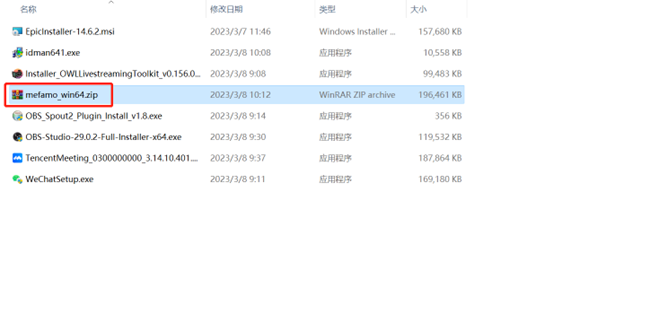

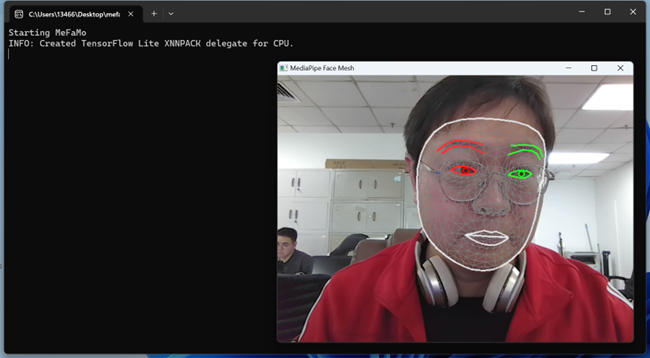

先去GitHub找一下,发现搜到的是源码(https://github.com/JimWest/MeFaMo),有python的源码真是太好了。可是今天我没时间搞代码,想找个现成的先试试效果,看到有个release的程序,直接下载过来。如下图:

执行这个文件就行了。

现在去UE5里面,在顶部菜单中点击【窗口】,下拉菜单中选择【虚拟制片】,然后点击二级菜单中的【Live Link】。怎么打开Live Link插件这里就不讲了,如果没有打开可以参考我前面的几篇文章。如果没有问题的话,可以在Live Link窗口中发现多了一项Python_LiveLinkFace的源。如果能用的话,后面会有一个绿色的点。如下图:

然后在【大纲】里点击已经导入好的人物,我的人物叫【BP_OldMan】,在下面【细节】窗口里的【Live Link】中把ARKit Face Subj改成Python_LiveLinkFace,再把ARKit Body Subj也改成Python_LiveLinkFace。人物面捕就完成了。如下图: