引用自:Why LSTMs Stop Your Gradients From Vanishing: A View from the Backwards Pass

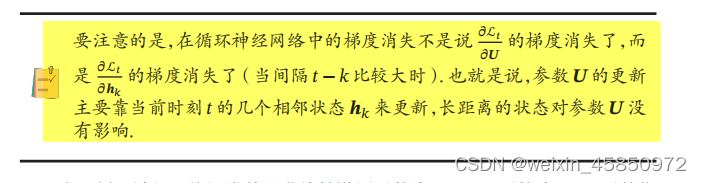

最近在学习邱锡鹏老师的《神经网络与深度学习》,看到了循环神经网络。书中写道:

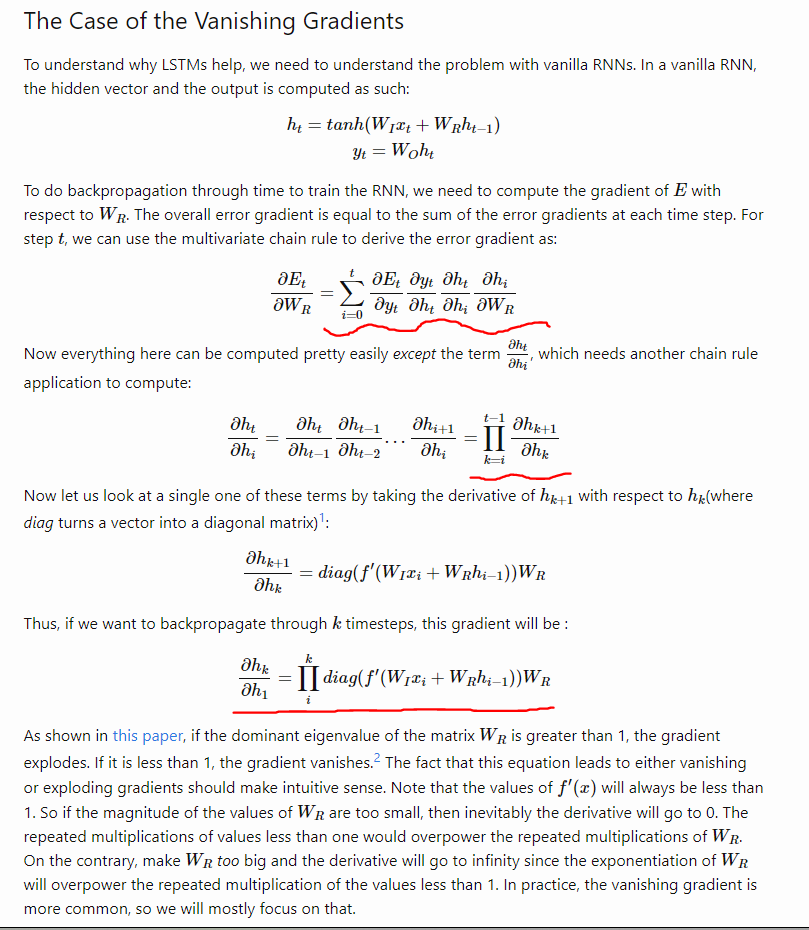

为什么隐藏层系数的梯度没有消失?这篇博客写的非常清楚,故记录一下:

W R W_R WR的梯度是影响不到的,但是他的梯度更多地来自于当前时间步的几个相邻状态(公式中体现的是累加)。

而对于 h k h_k hk而言,若 k < < t k<<t k<<t,那么 h k h_k hk是更新不动。

引用自:

Why LSTMs Stop Your Gradients From Vanishing: A View from the Backwards Pass

邱锡鹏《神经网络与深度学习》