一、RNN中为什么会出现梯度消失?

在RNN(循环神经网络)中出现梯度消失问题是由于RNN的结构和激活函数的特性所引起的。具体来说,以下几个因素可能导致梯度消失问题:

-

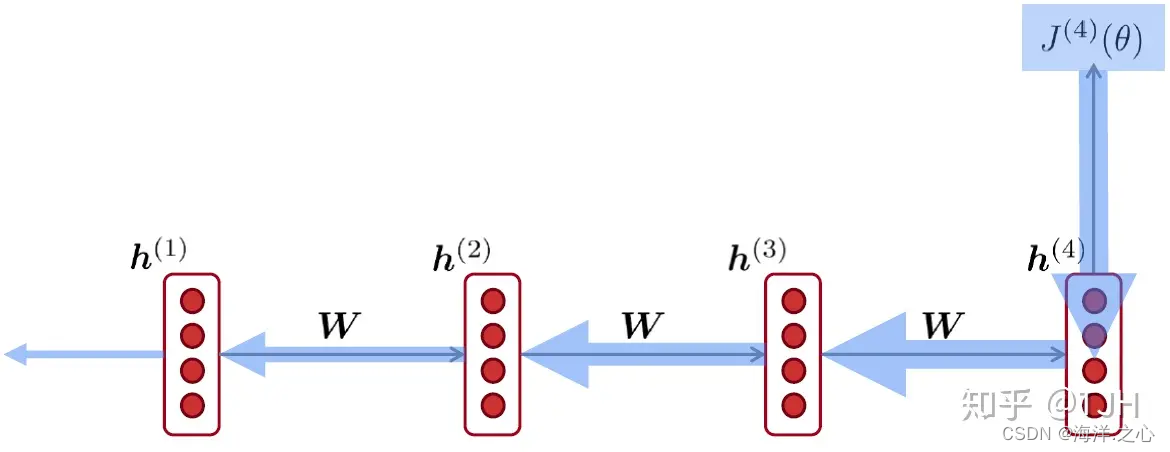

链式法则: RNN在进行反向传播时需要计算关于权重的梯度,这涉及到多次应用链式法则。每个时间步的梯度计算都需要将之前时间步的梯度乘以一个权重矩阵(循环权重),这会导致梯度值在反复相乘时逐渐减小,从而可能消失到接近零。

-

Sigmoid激活函数: 传统的RNN中常使用Sigmoid激活函数,其输出范围在0到1之间。当激活函数的输出接近0或1时,其导数会趋近于0,这意味着在反向传播过程中,梯度会趋向于消失。

-

长序列依赖: RNN的一个主要用途是捕捉序列数据中的长期依赖关系。然而,当序列较长时,由于梯度反复相乘,梯度值可能逐渐变小并消失,导致无法捕捉到长期依赖。

-

权重初始化: 如果RNN的权重初始化较小,或者Sigmoid激活函数的初始参数接近0或1,那么网络在初始阶段就可能遇到梯度消失问题。

这些因素的相互作用可能导致RNN训练过程中出现梯度消失问题,这会使得模型难以捕捉到长期依赖关系,影响其性能。为了解决梯度消失问题,出现了一些改进型的RNN结构,如长短时记忆网络(LSTM)和门控循环单元(GRU),它们引入了门控机制,能够更好地捕捉长期依赖关系,从而缓解了梯度消失问题。

二、如何解决RNN中的梯度消失问题?

梯度消失问题是在训练RNN(循环神经网络)时常见的一个挑战,尤其是当处理较长序列数据时。这会导致模型难以捕捉长期依赖关系,从而影响其性能。以下是一些常用的方法来解决梯度消失问题:

-

使用改进的RNN结构: 长短时记忆网络(LSTM)和门控循环单元(GRU)是专门设计用来解决梯度消失问题的改进型RNN结构。它们引入了门控机制,能够更好地处理长期依赖关系,从而减轻梯度消失问题。

-

梯度剪裁(Gradient Clipping): 设置一个梯度范数的阈值,在反向传播过程中,如果梯度的范数超过了阈值,就对梯度进行缩放,从而避免梯度爆炸问题,同时也有助于缓解梯度消失问题。

-

权重初始化: 使用适当的权重初始化方法,如Xavier初始化(也称为Glorot初始化),可以帮助避免梯度消失问题。这种初始化方法根据输入和输出维度来合理初始化权重,从而更好地传播梯度。

-

批量标准化(Batch Normalization): 将批量标准化应用于RNN的输入数据,可以减少梯度消失问题。这会使得每个时间步的输入在均值和方差上保持一致,有助于稳定梯度的传播。

-

层归一化(Layer Normalization): 类似于批量标准化,层归一化可以在每个时间步对隐藏状态进行归一化,有助于减轻梯度消失问题。

-

跳跃连接(Skip Connections): 在网络中引入跳跃连接,允许梯度直接从较深层传播到较浅层,从而减少梯度消失的影响。

-

使用更浅的网络: 在某些情况下,使用更浅的RNN结构可能更有利于避免梯度消失问题,尤其是当处理较长序列数据时。

综合考虑问题的性质和数据的特点,选择合适的方法或它们的组合来解决梯度消失问题是非常重要的。在实际应用中,也可能需要进行一些实验和调试来找到最佳的方法组合。