上个博客里阐述了梯度消失的原因,同时梯度消失会造成RNN的长时记忆失效。所以在本博客中,会阐述梯度消失的解决方案:①梯度裁剪(Clipping Gradient)②LSTM(Long Short-Term Memory)。

梯度裁剪(Clipping Gradient)

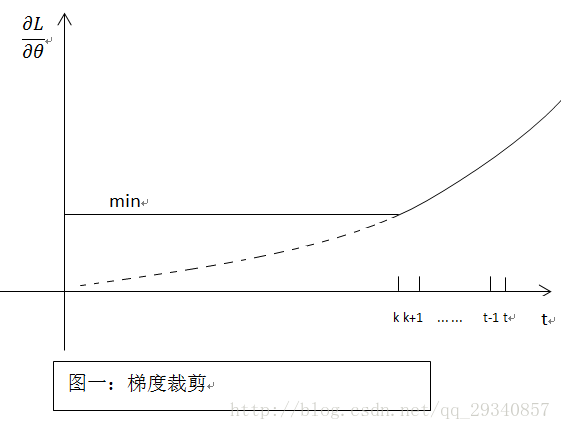

既然在BP过程中会产生梯度消失(就是偏导无限接近0,导致长时记忆无法更新),那么最简单粗暴的方法,设定阈值,当梯度小于阈值时,更新的梯度为阈值,如下图所示:

优点:简单粗暴

缺点:很难找到满意的阈值LSTM(Long Short-Term Memory)

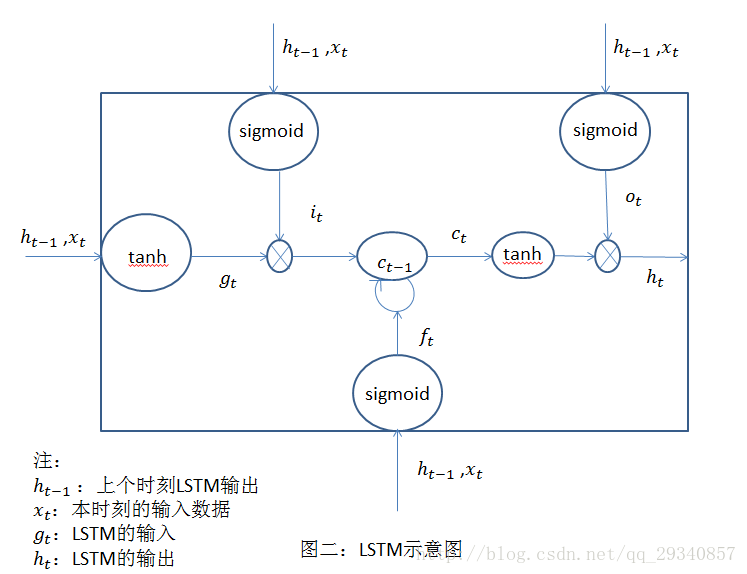

一定程度上模仿了长时记忆,相比于梯度裁剪,最大的优点就是,自动学习在什么时候可以将error反向传播,自动控制哪些是需要作为记忆存储在LSTM cell中。一般长时记忆模型包括写入,读取,和忘记三个过程对应到LSTM中就变成了input_gate,output_gate,forget_gate,三个门,范围在0到1之间,相当于对输入输出进行加权的学习,利用大量数据来自动学习加权的参数(即学习了哪些错误可以用BP更新参数),LSTM的示意图如下:

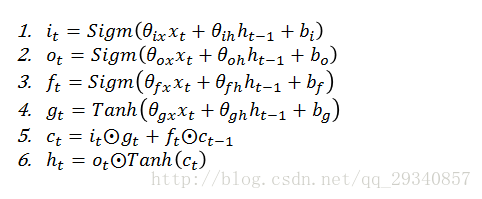

具体的公式表达:

优点:模型自动学习更新参数