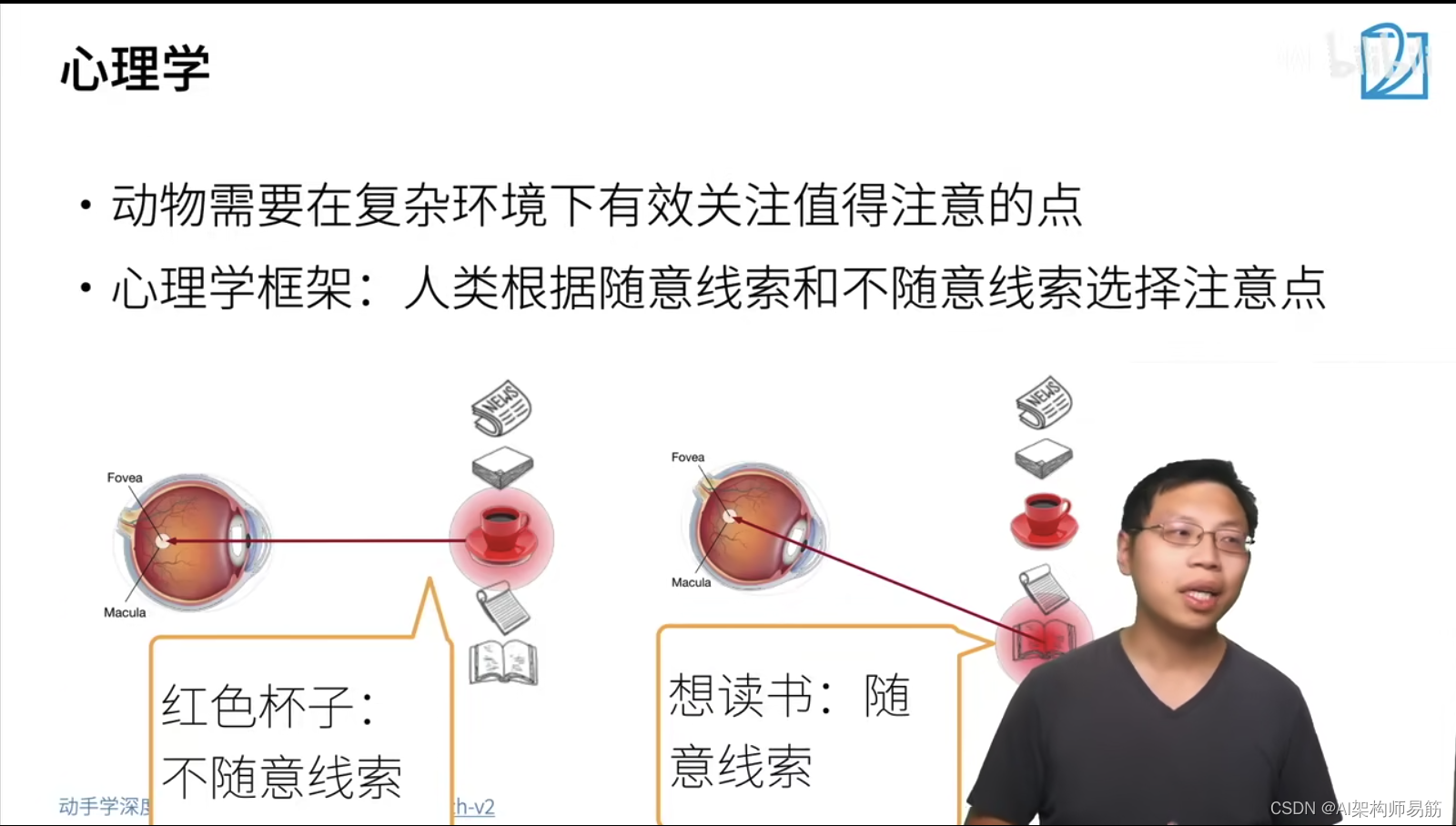

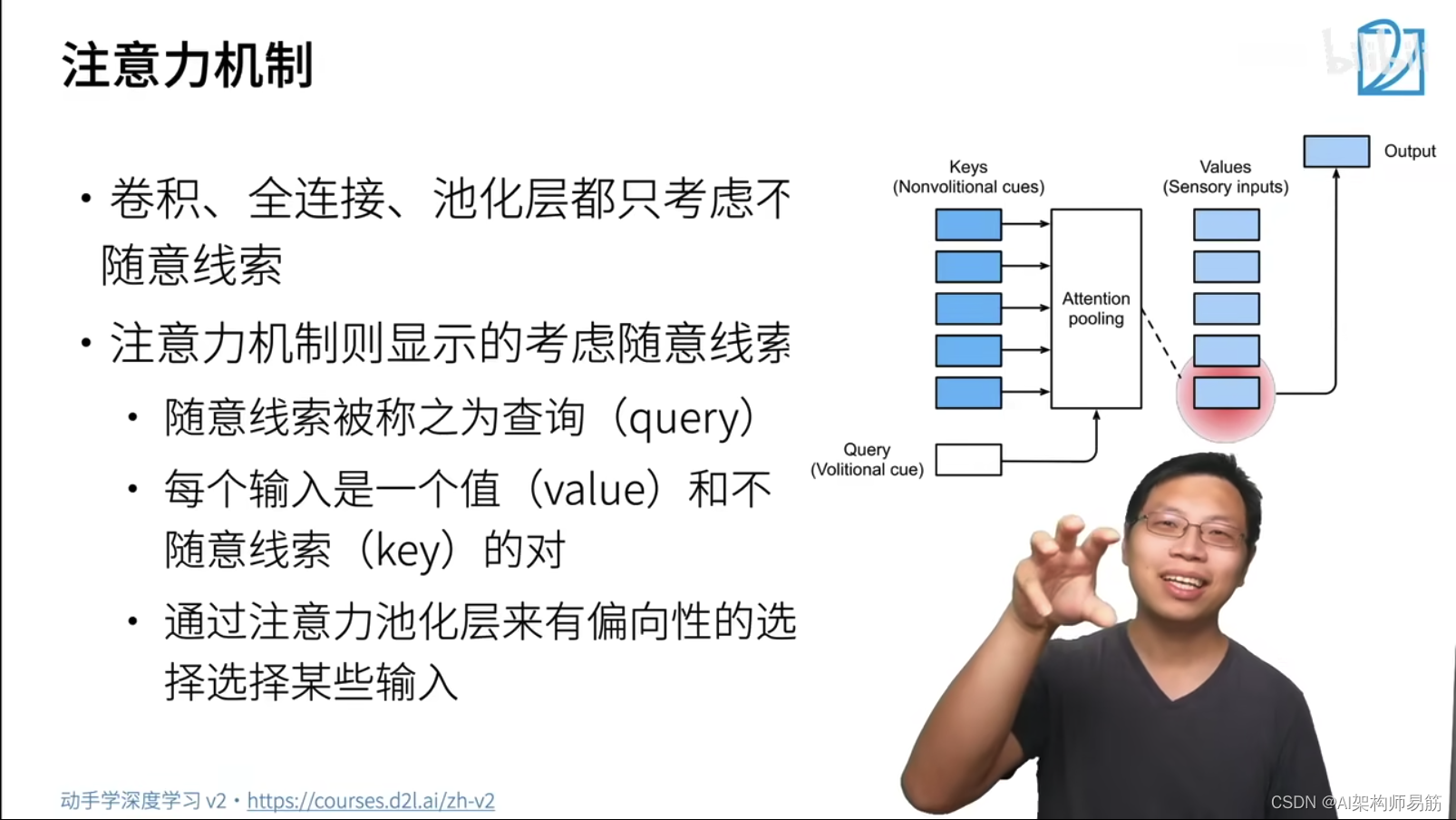

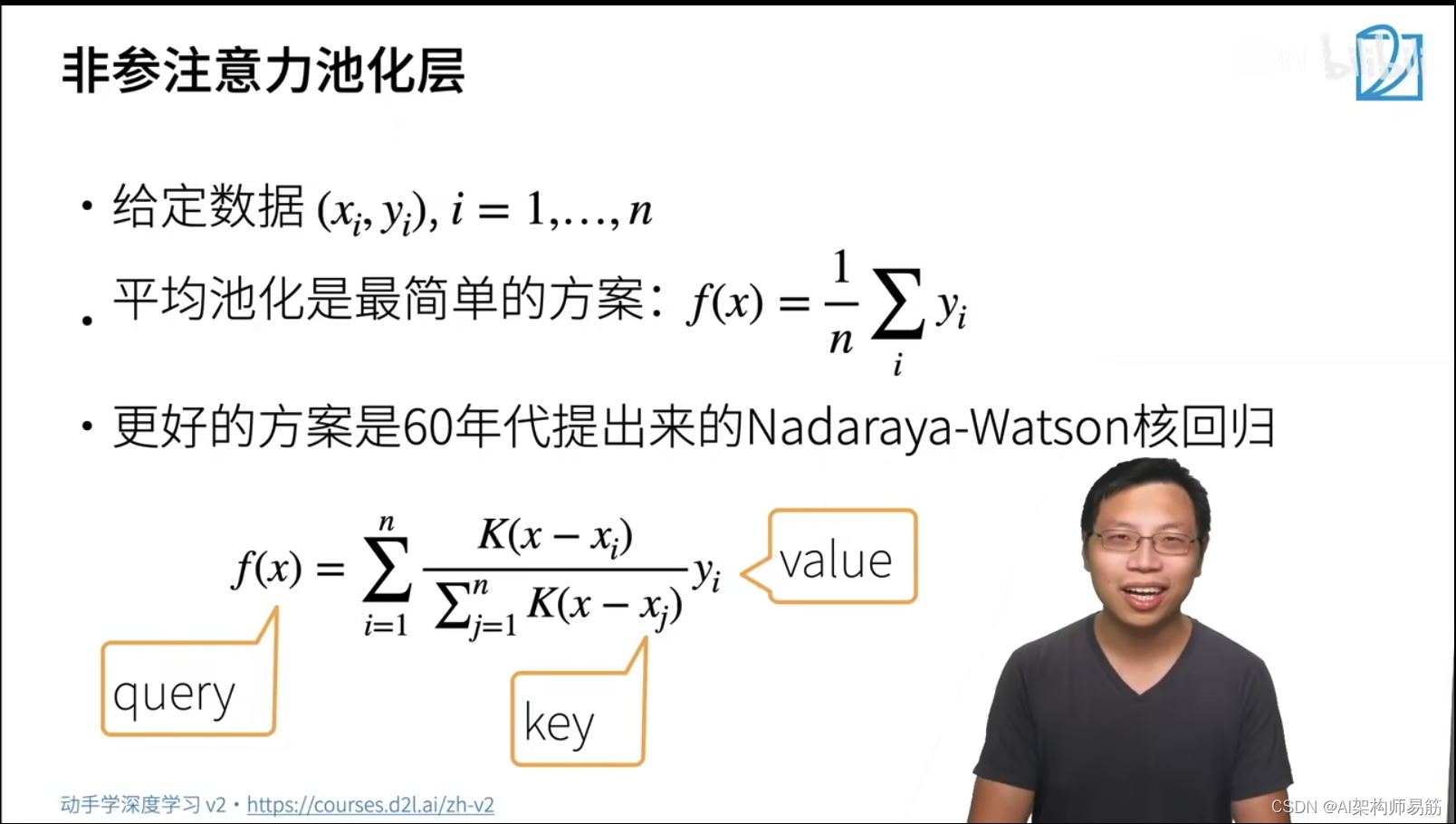

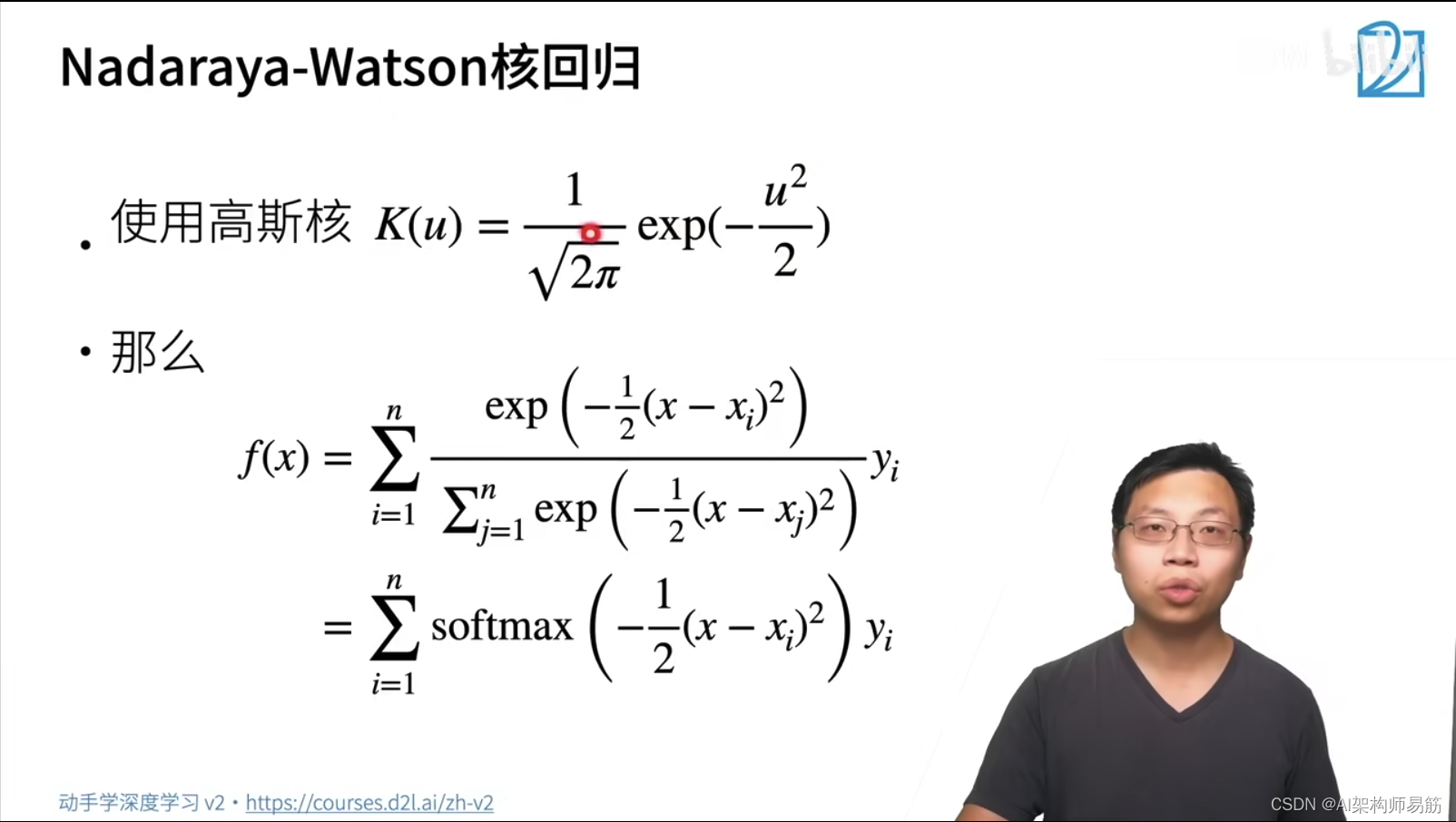

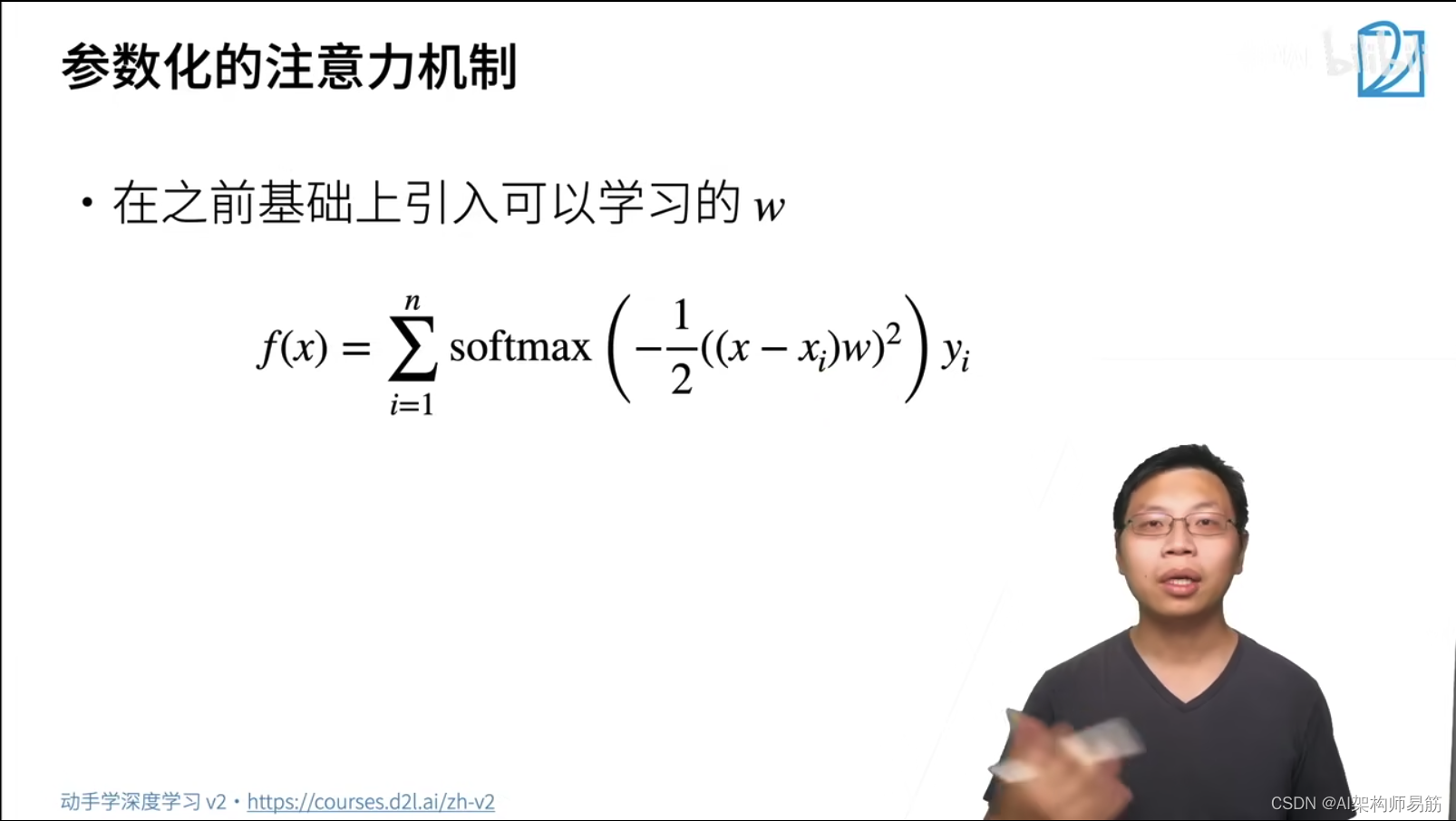

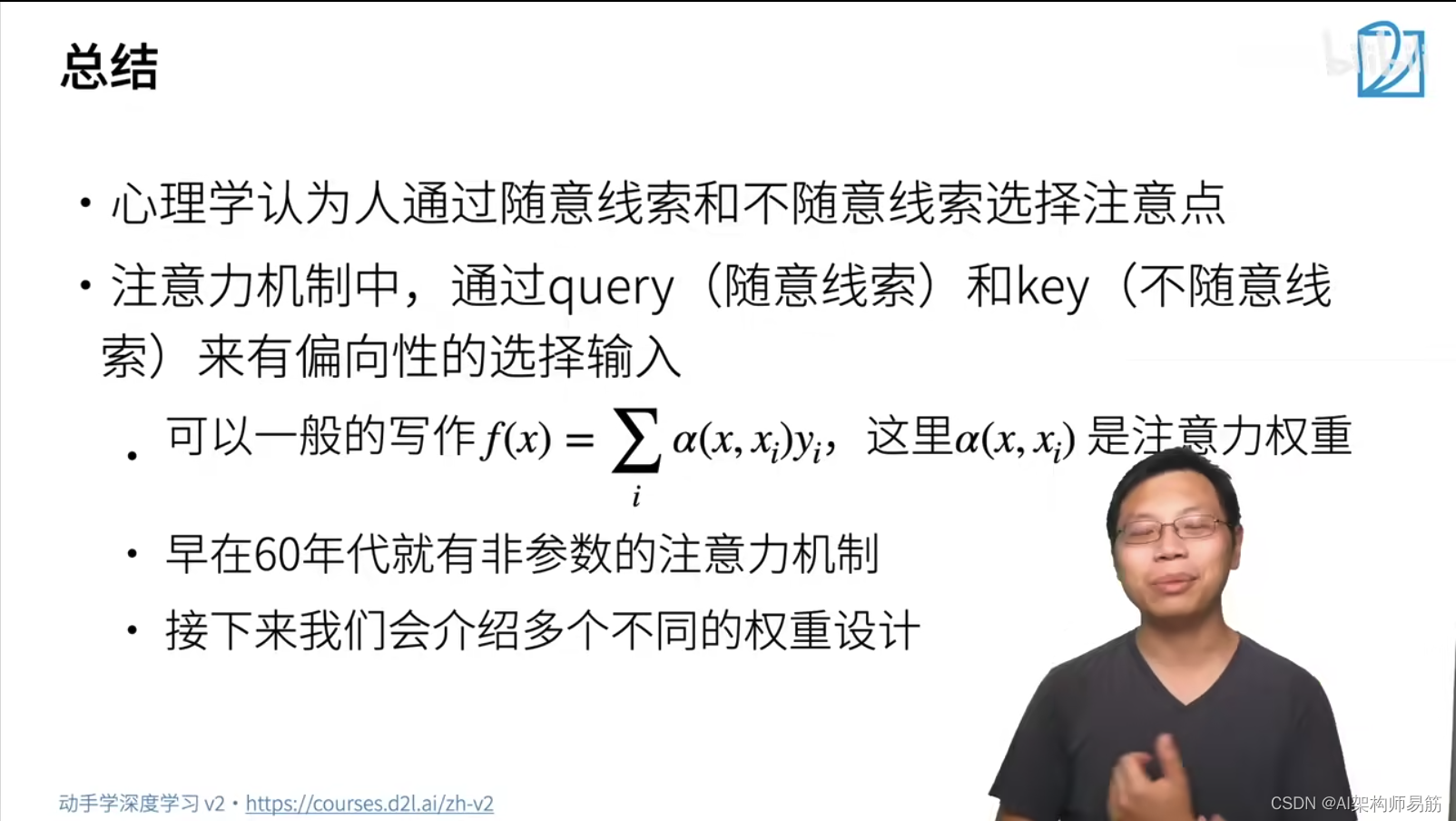

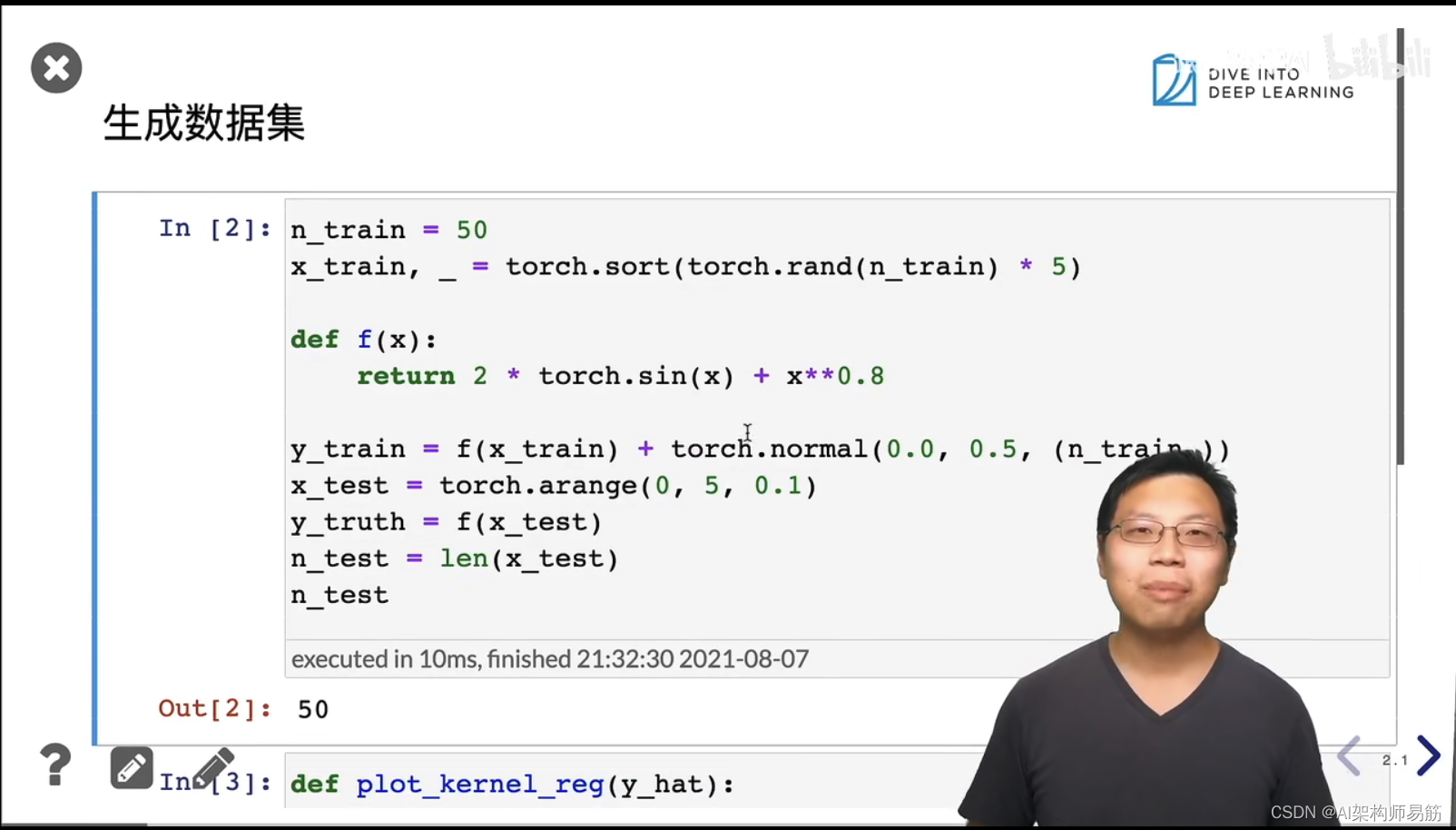

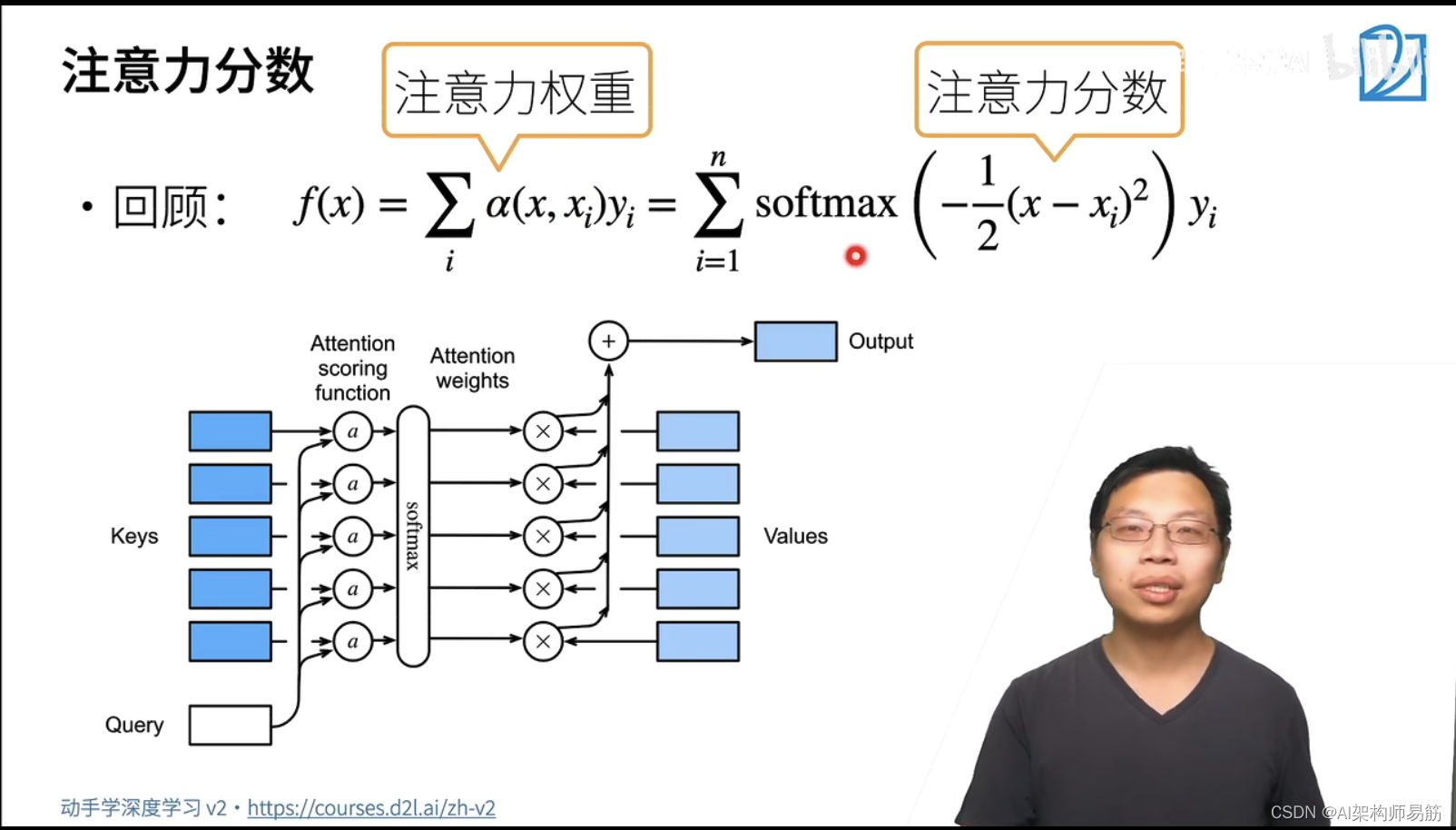

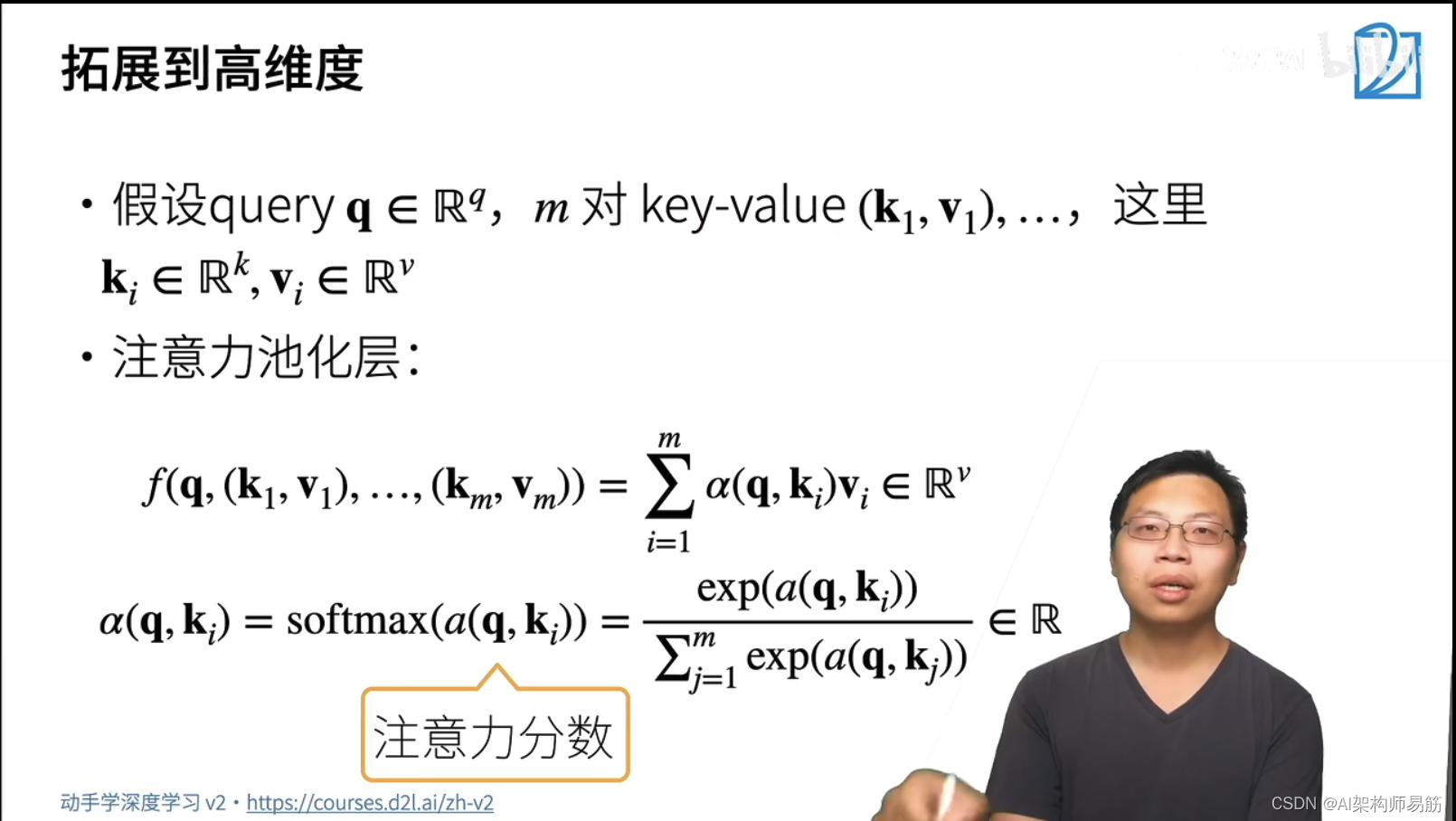

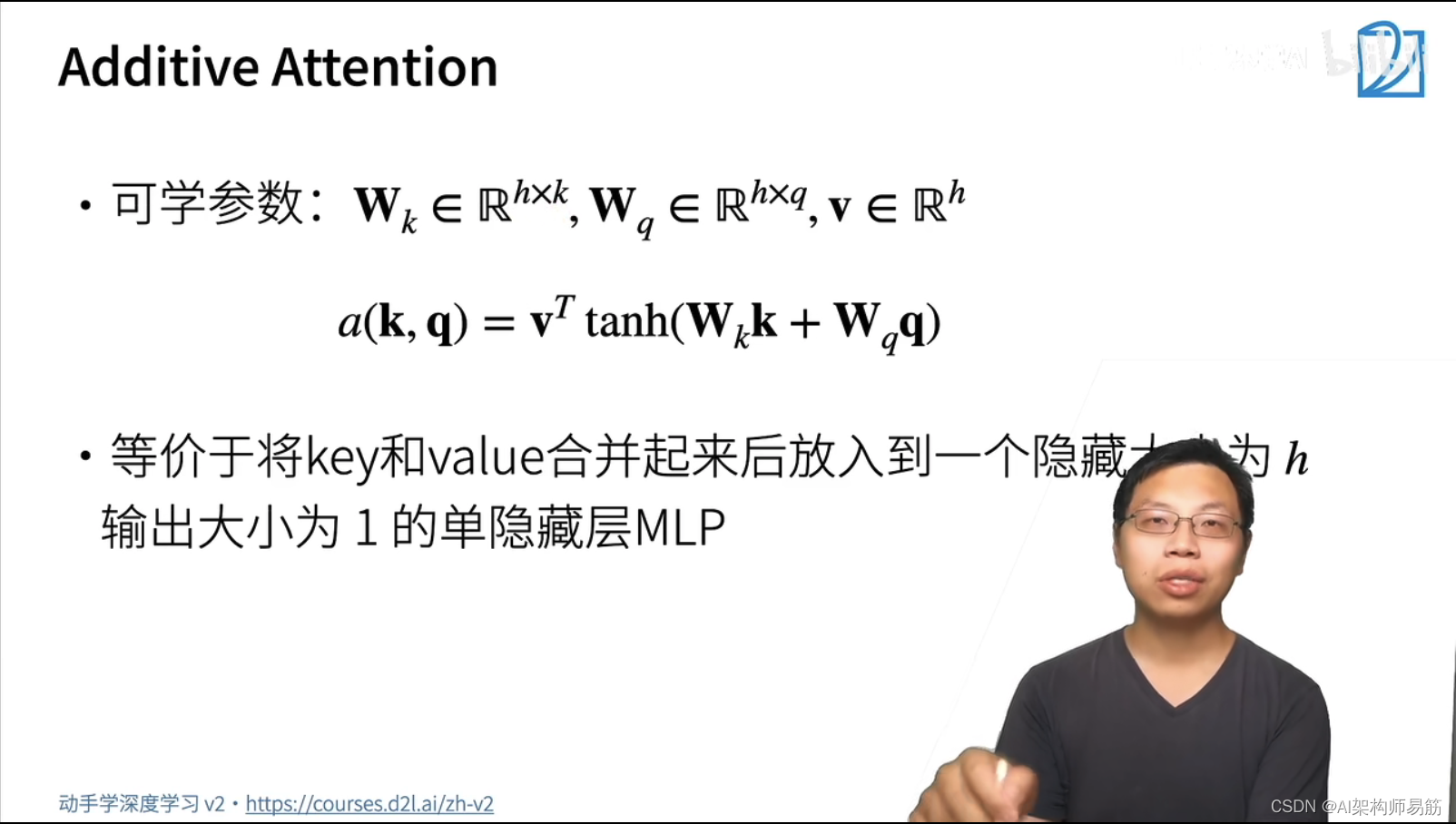

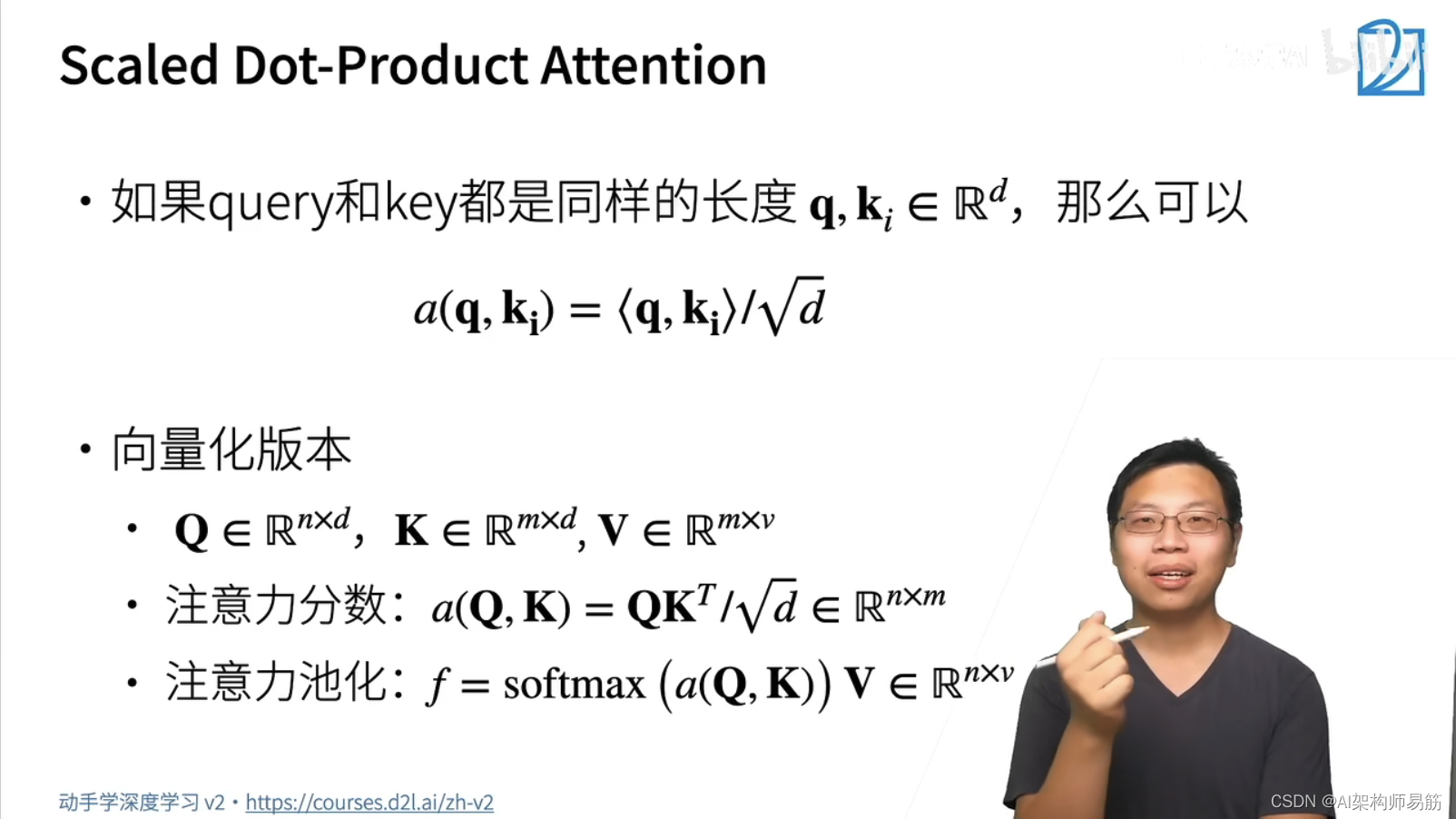

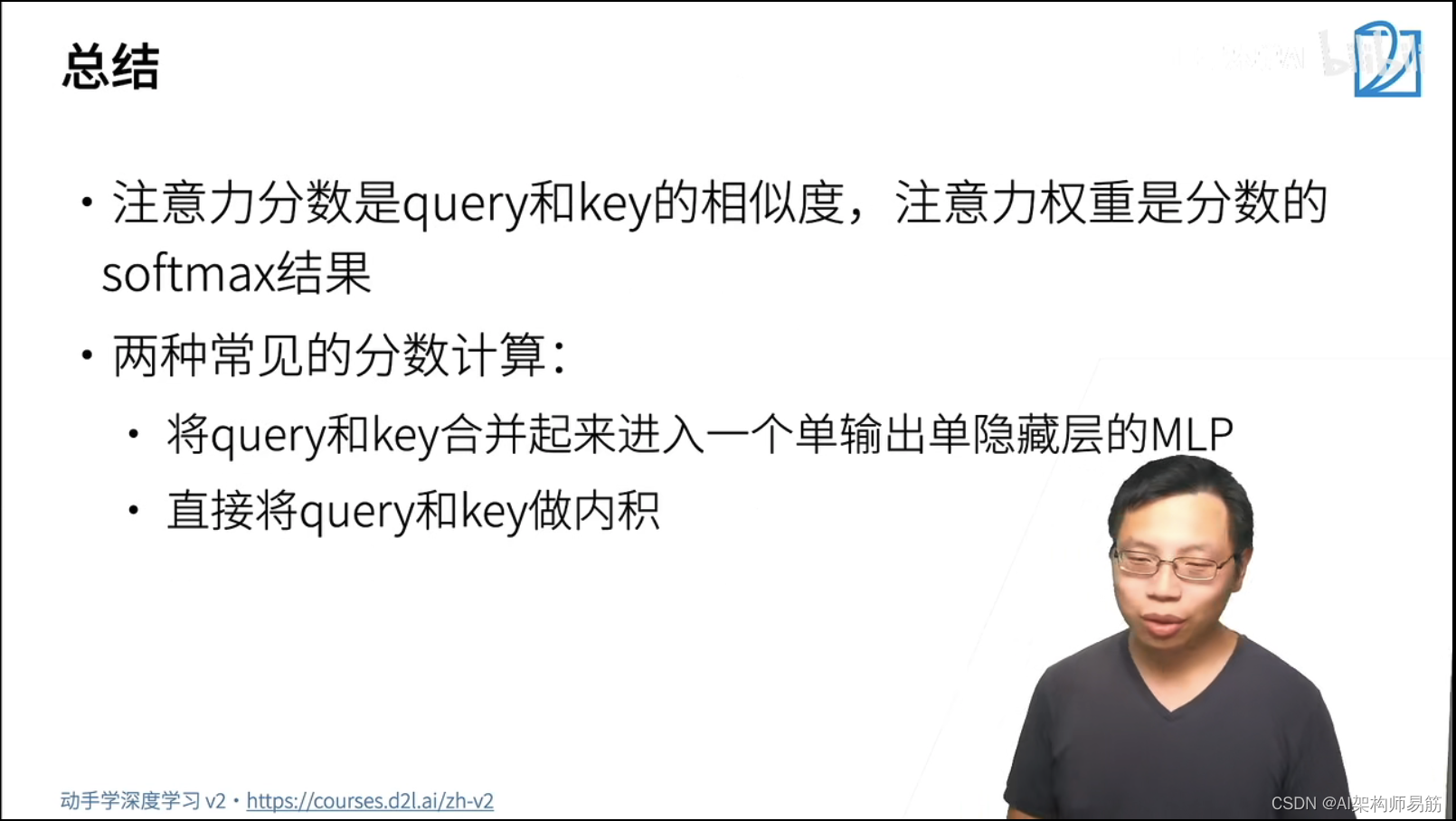

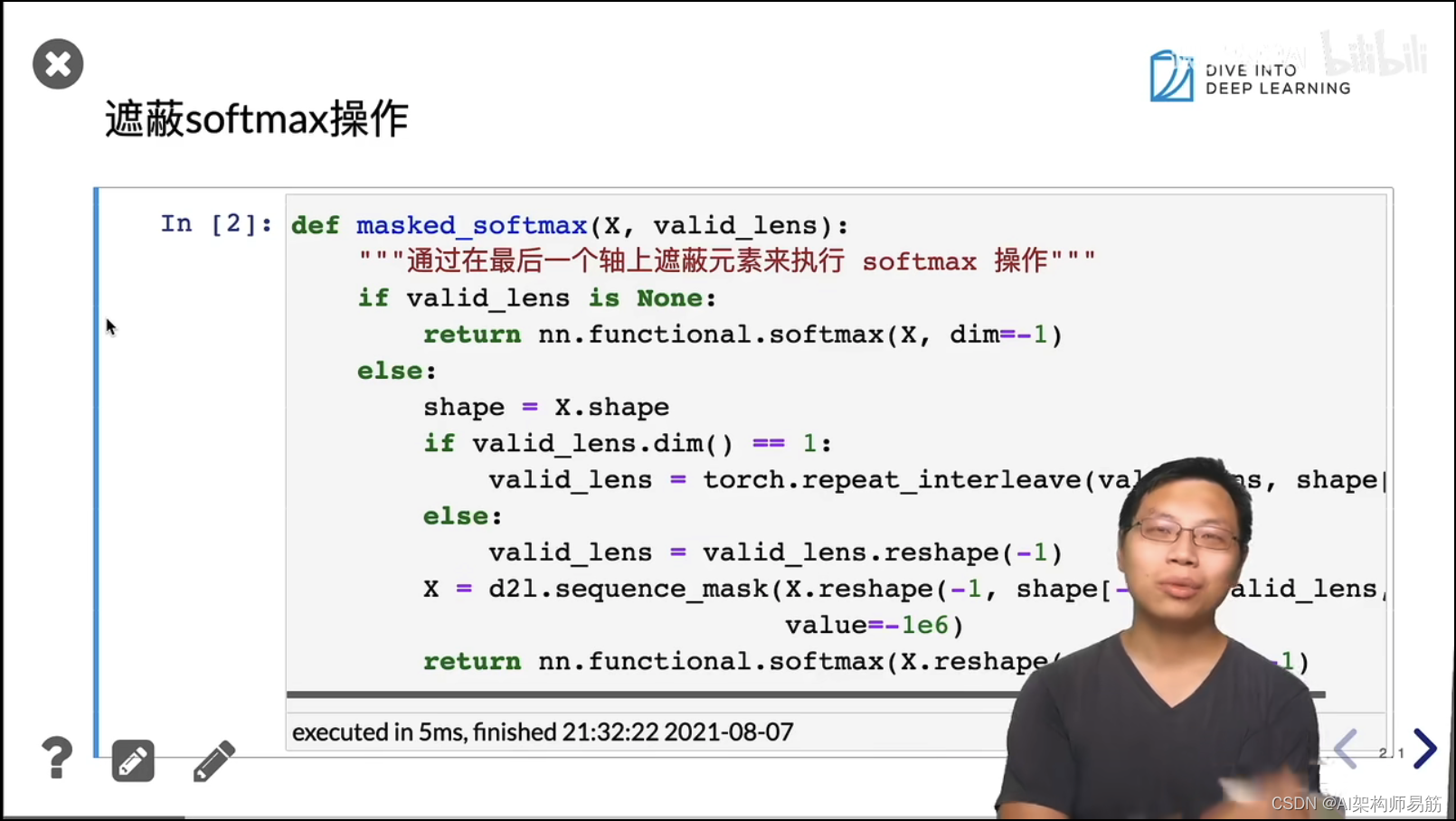

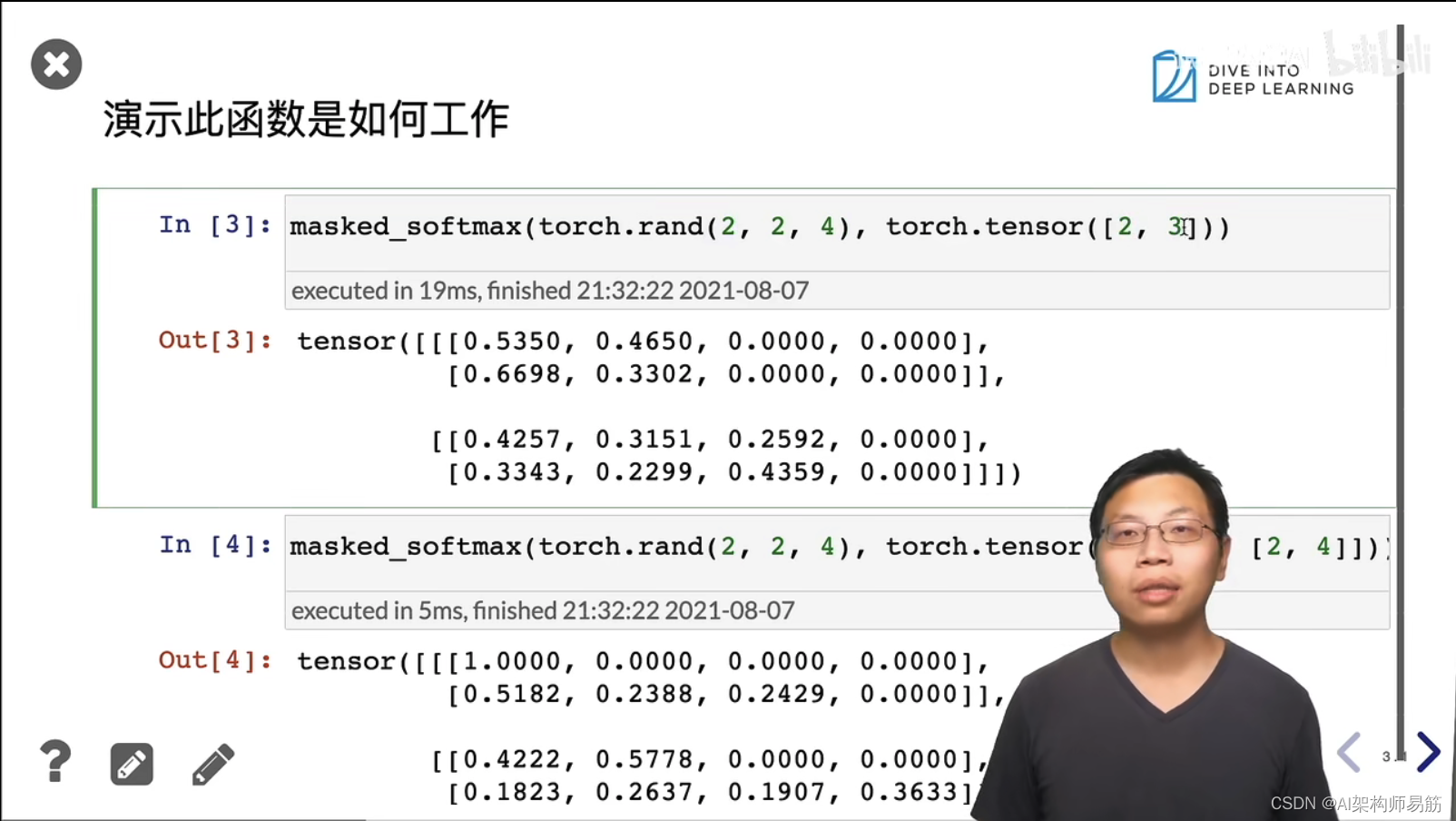

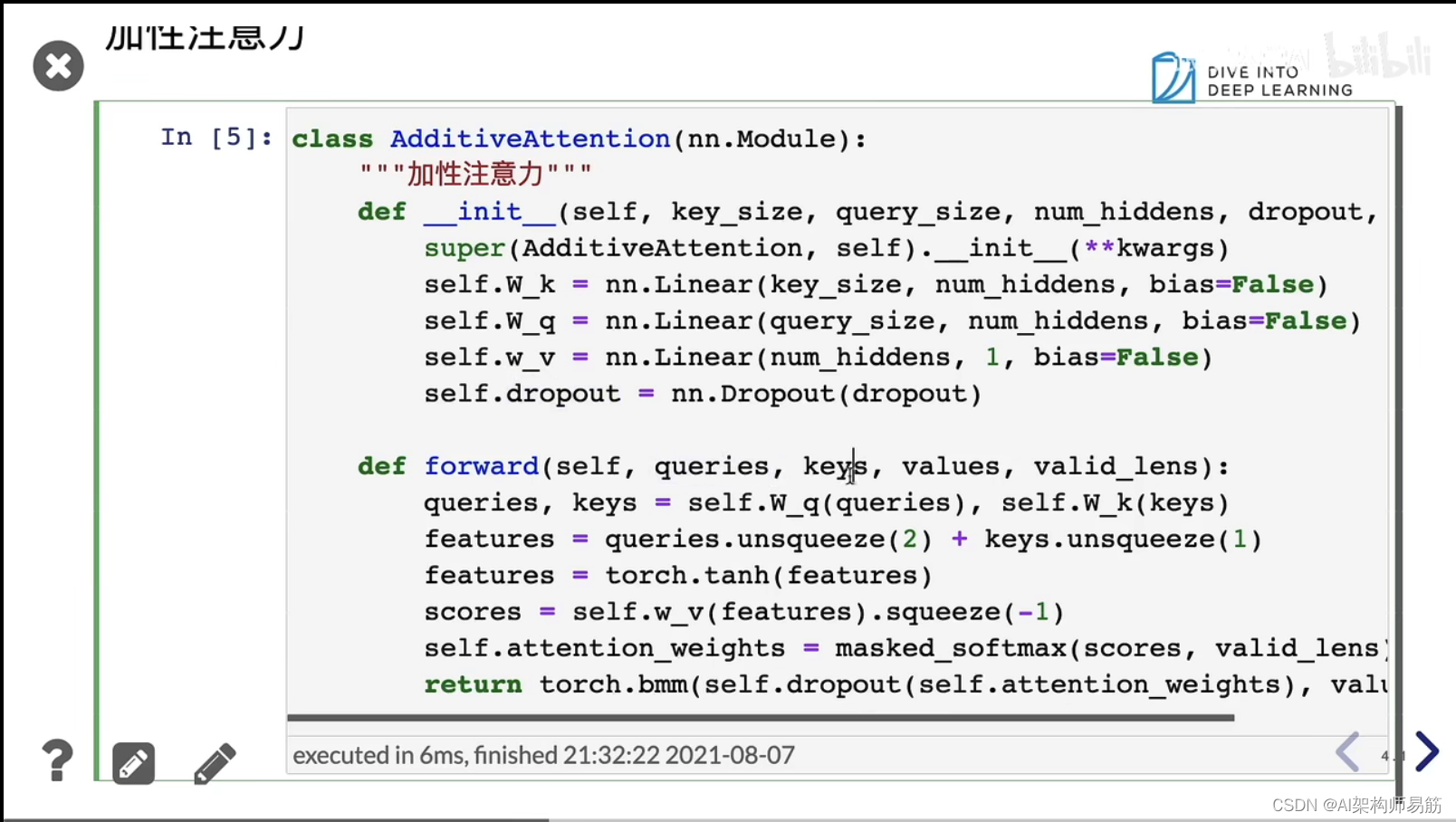

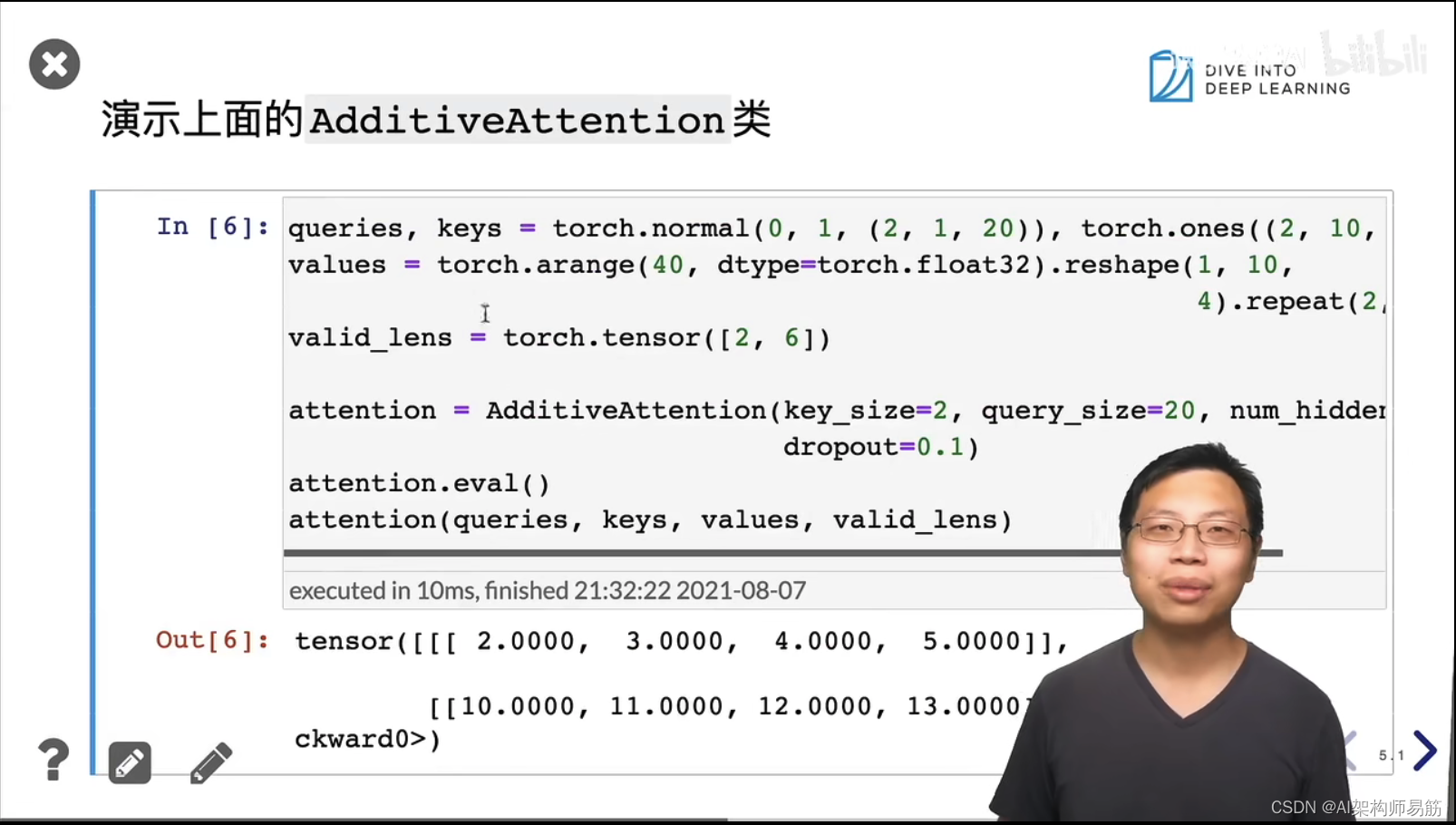

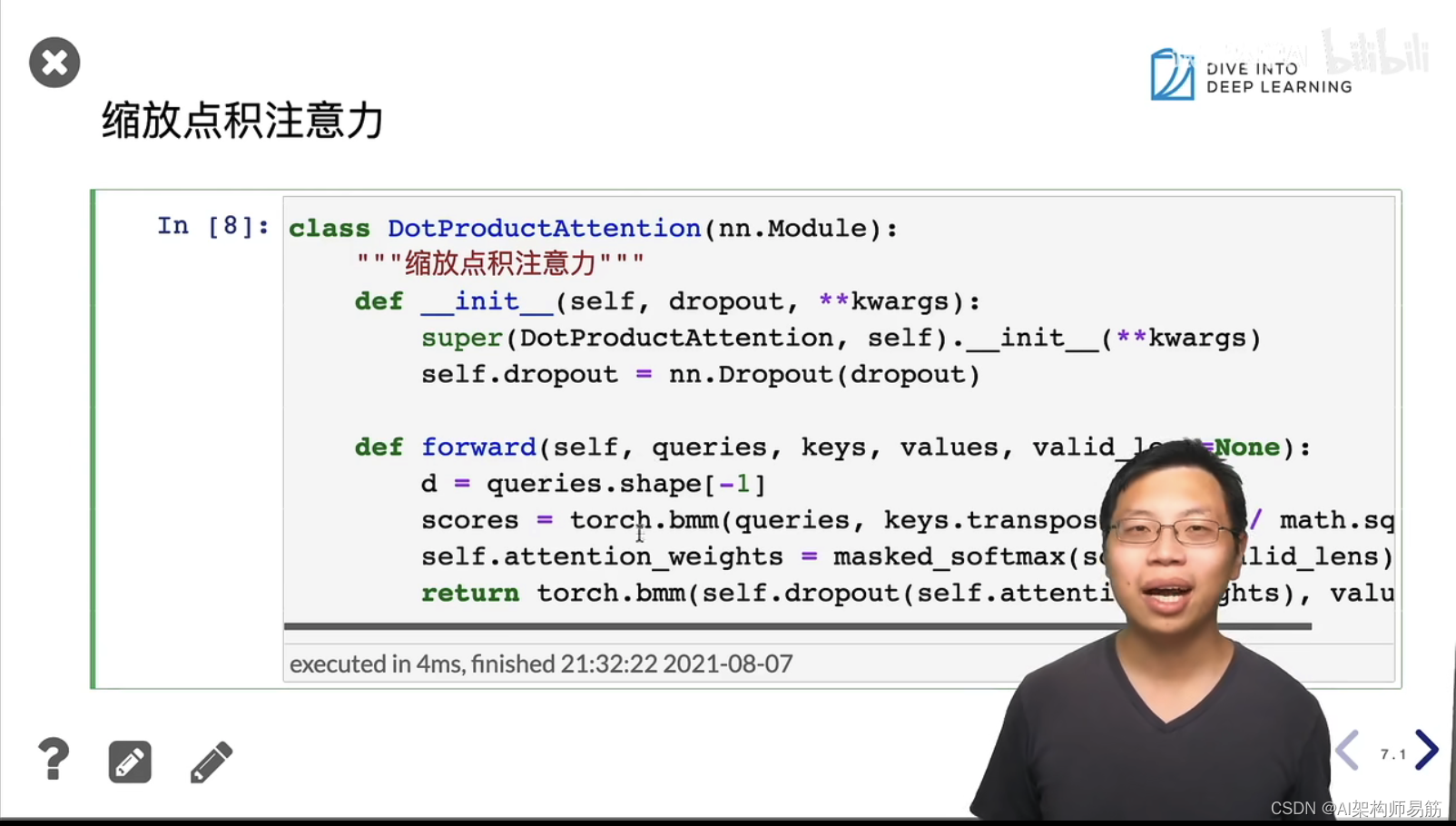

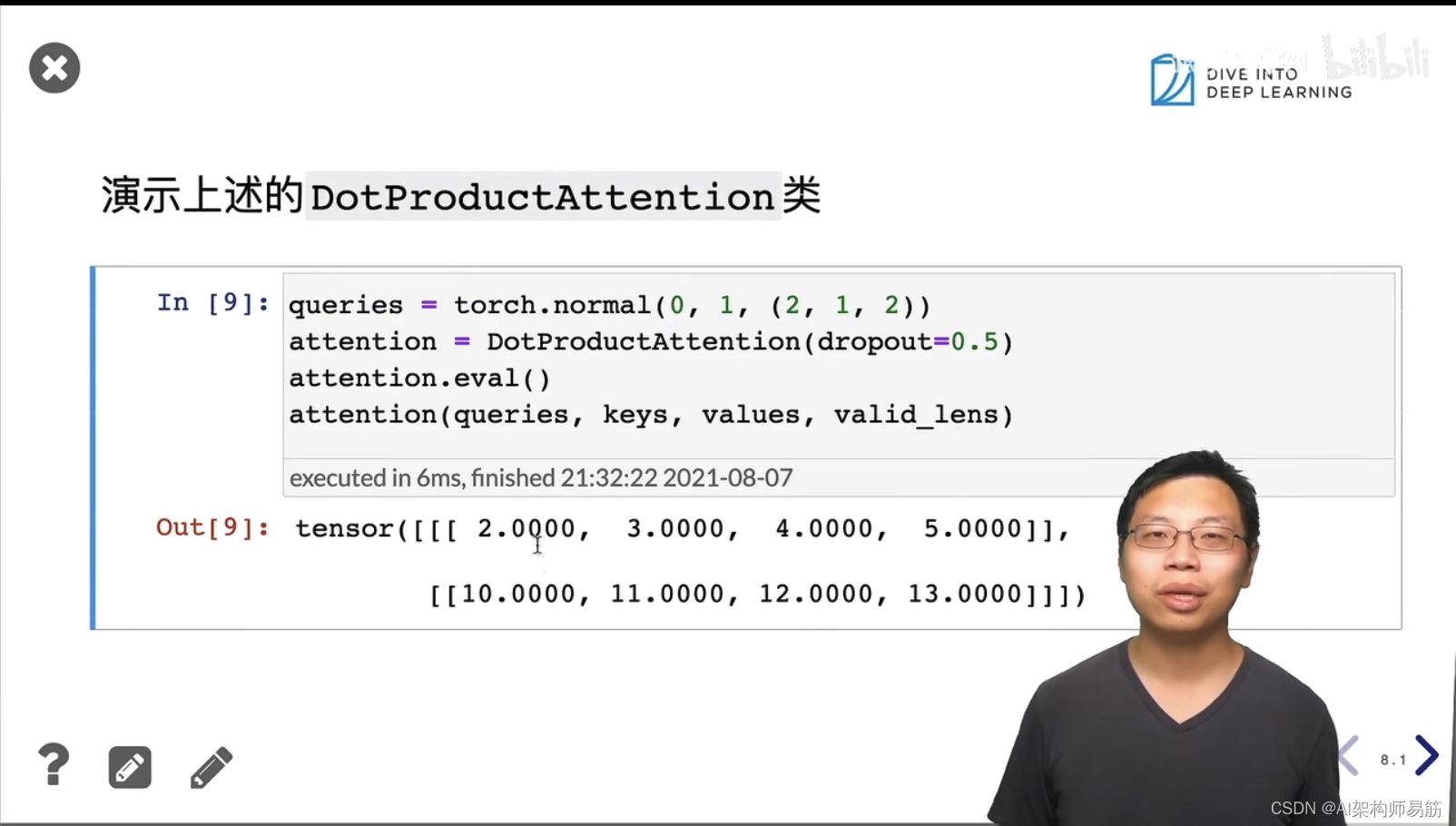

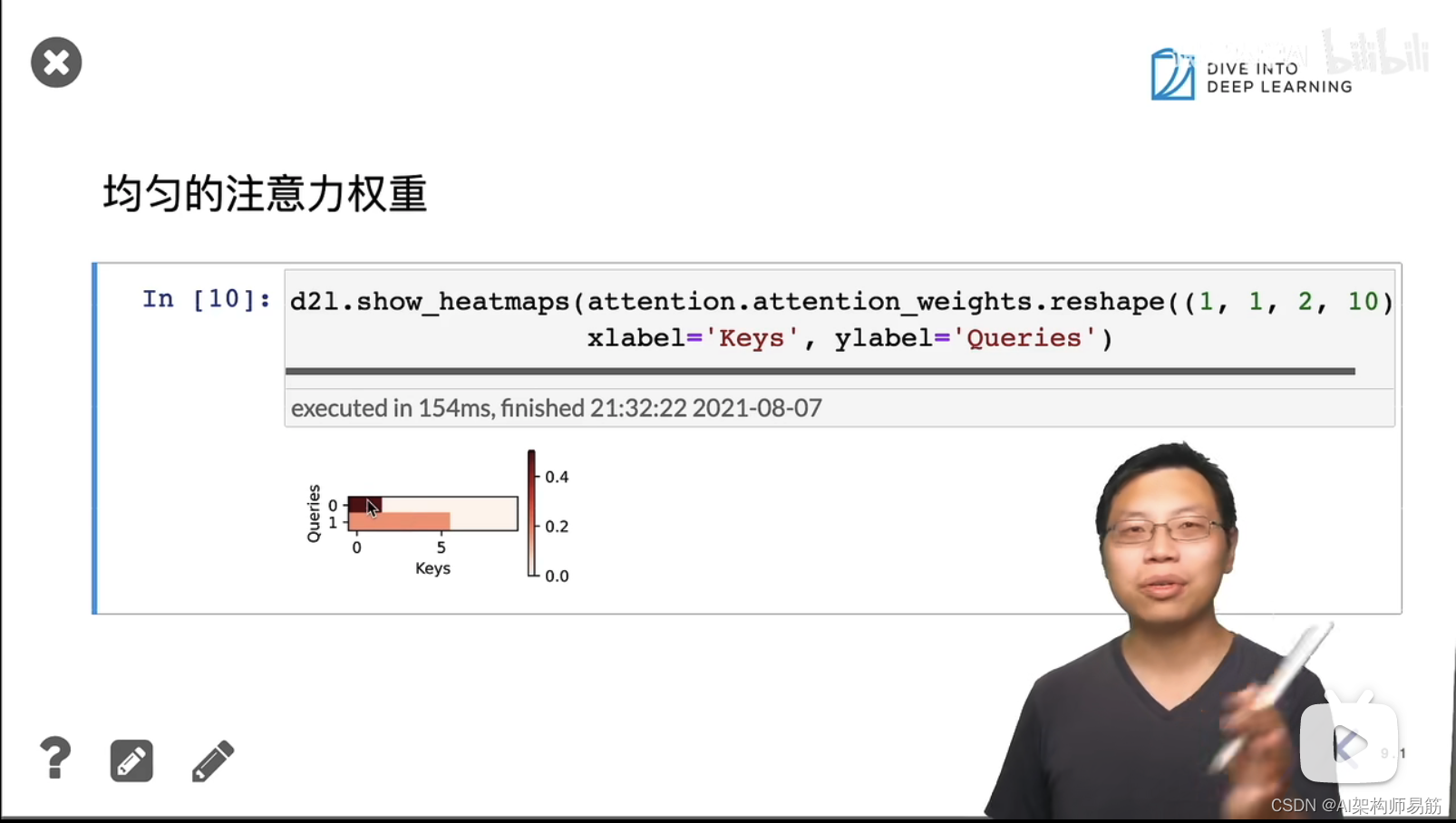

注意力机制 attention 注意力分数 动手学深度学习v2

猜你喜欢

转载自blog.csdn.net/zgpeace/article/details/124777958

今日推荐

周排行