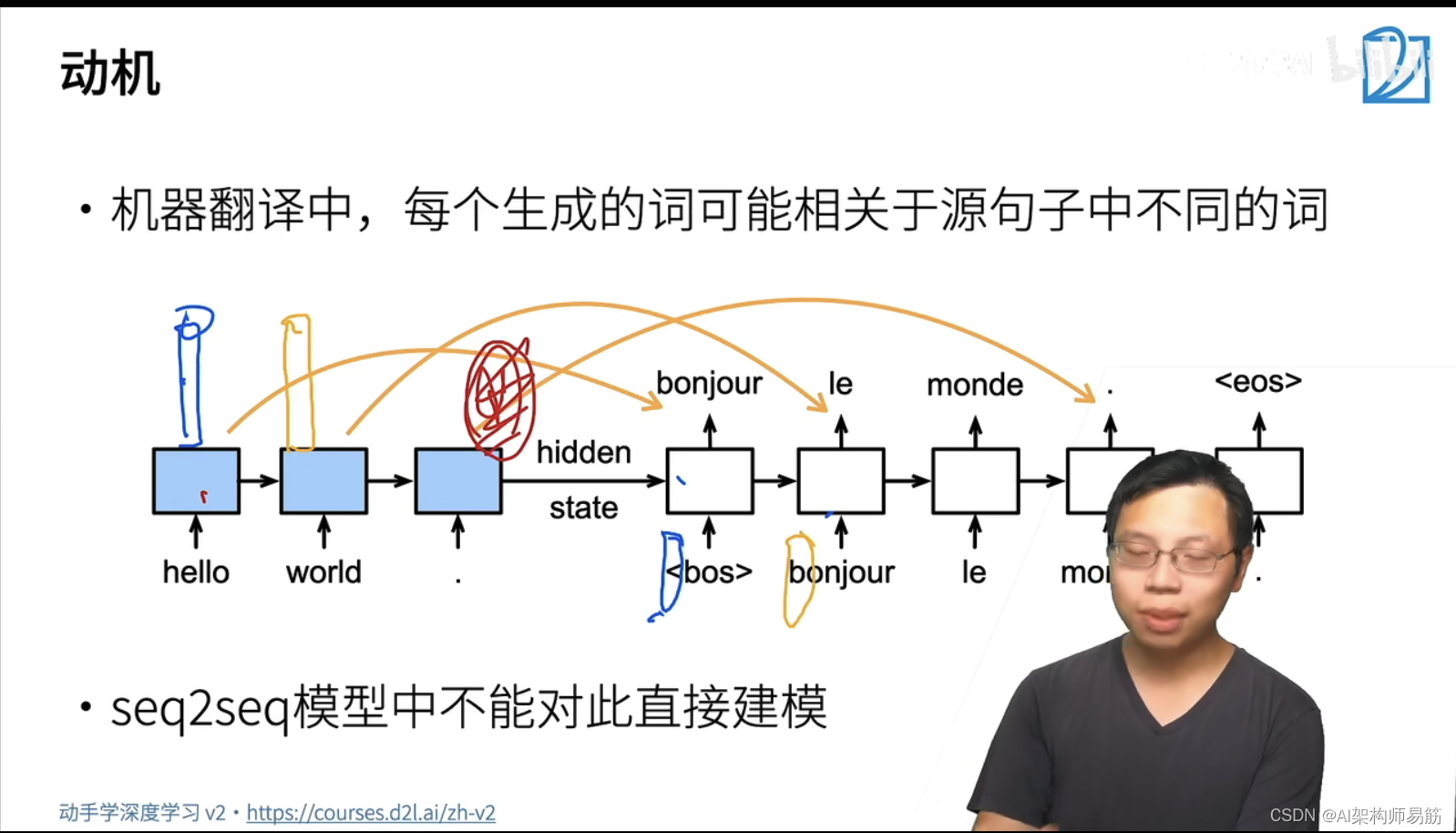

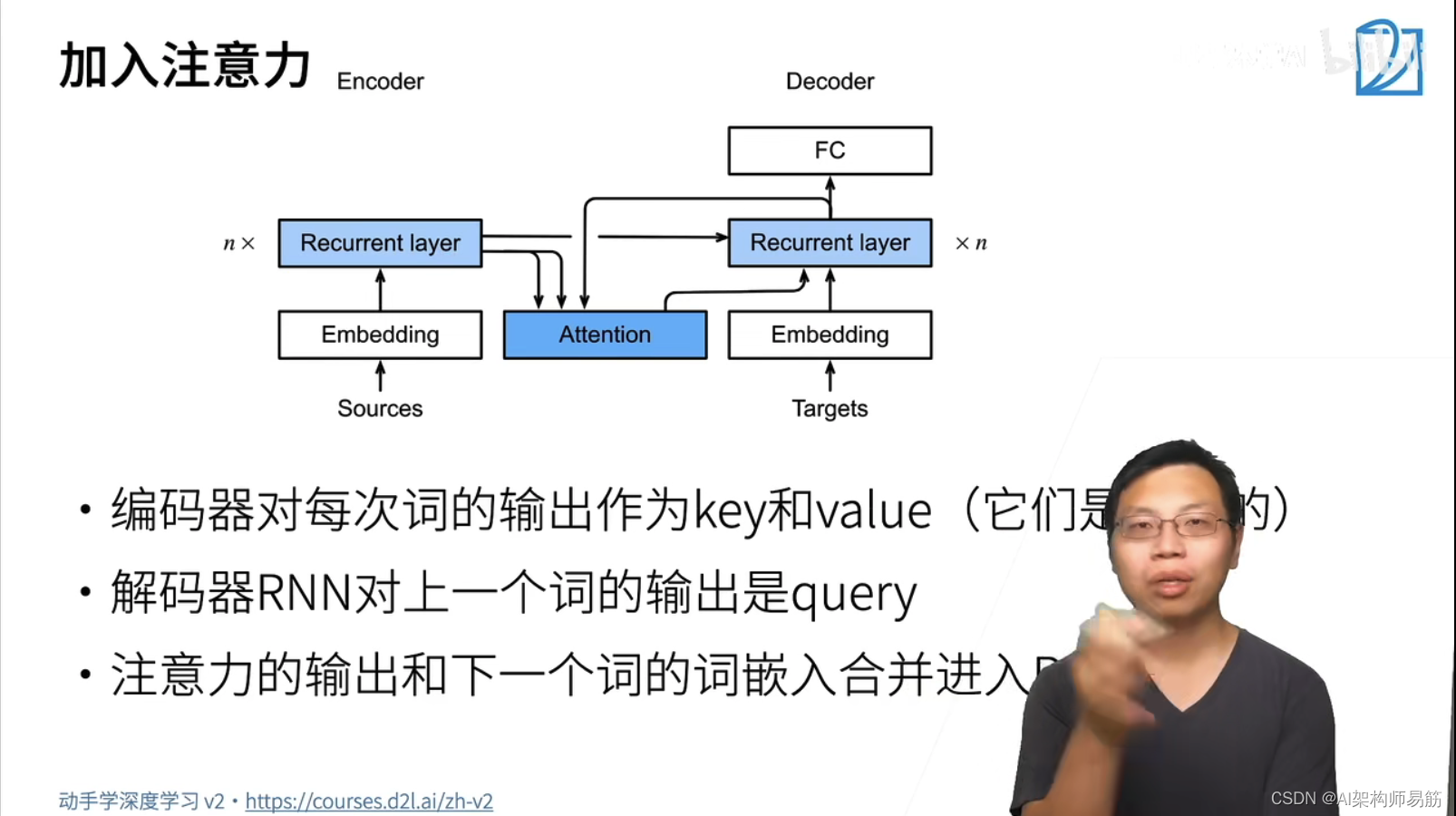

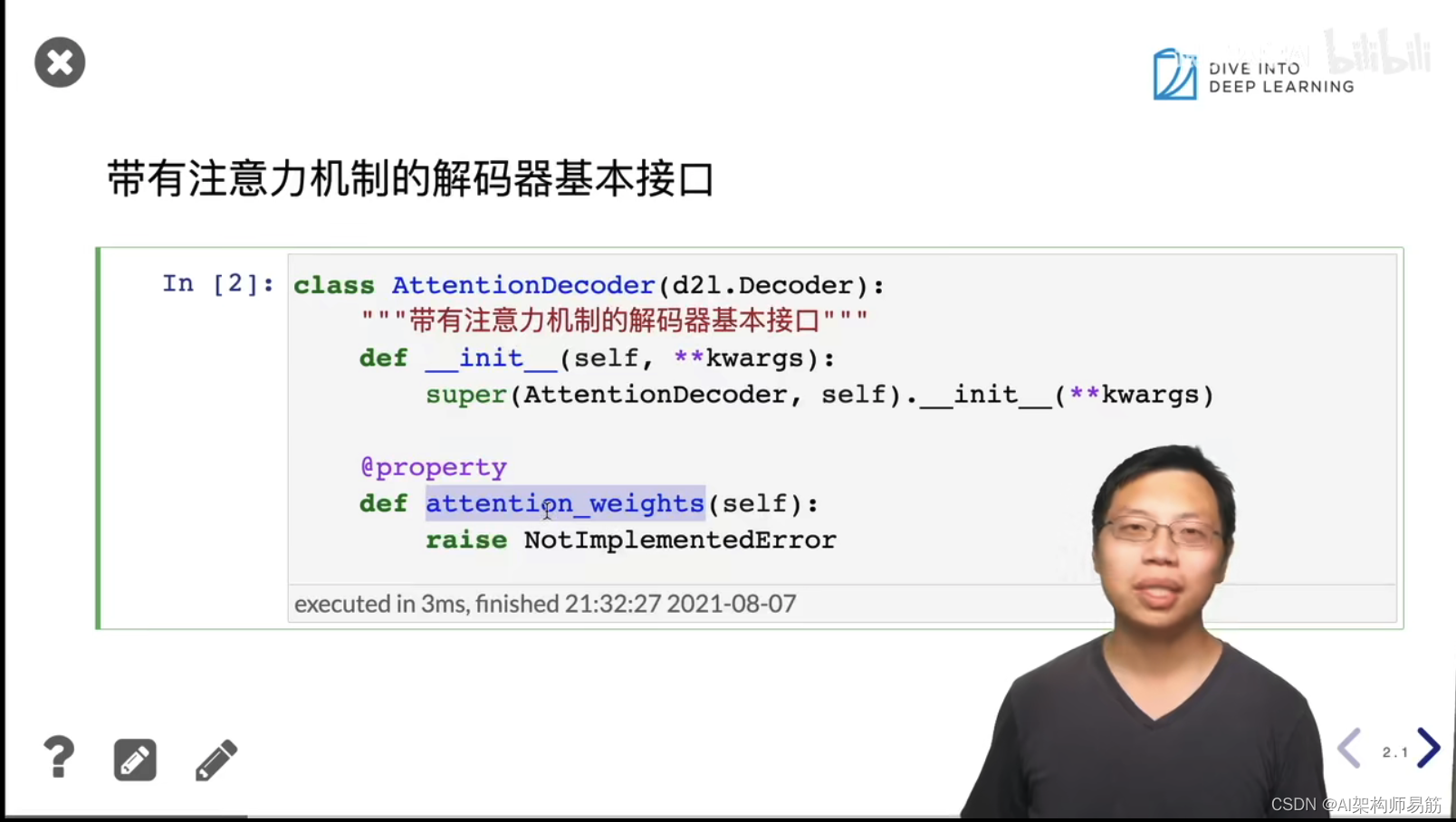

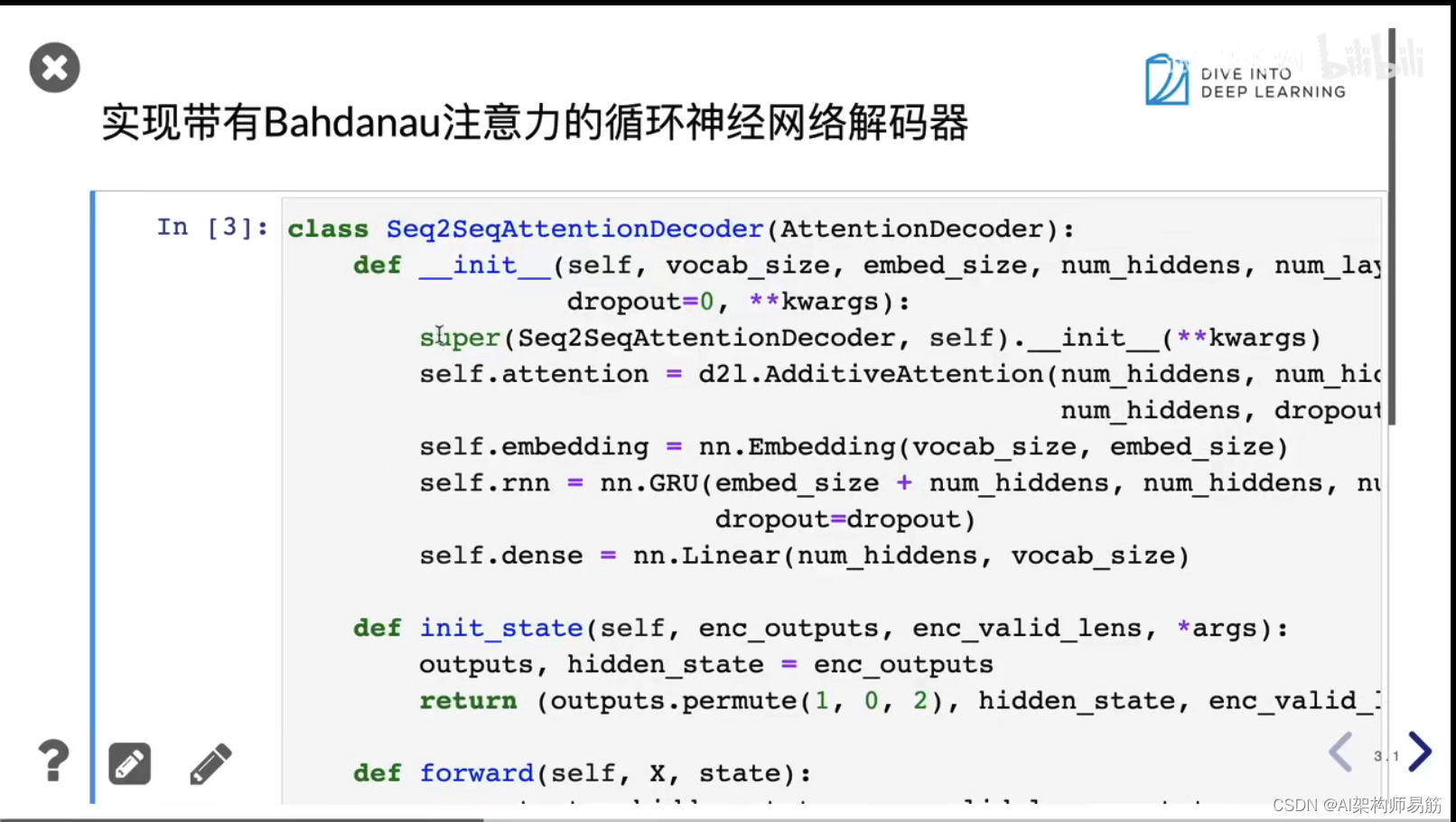

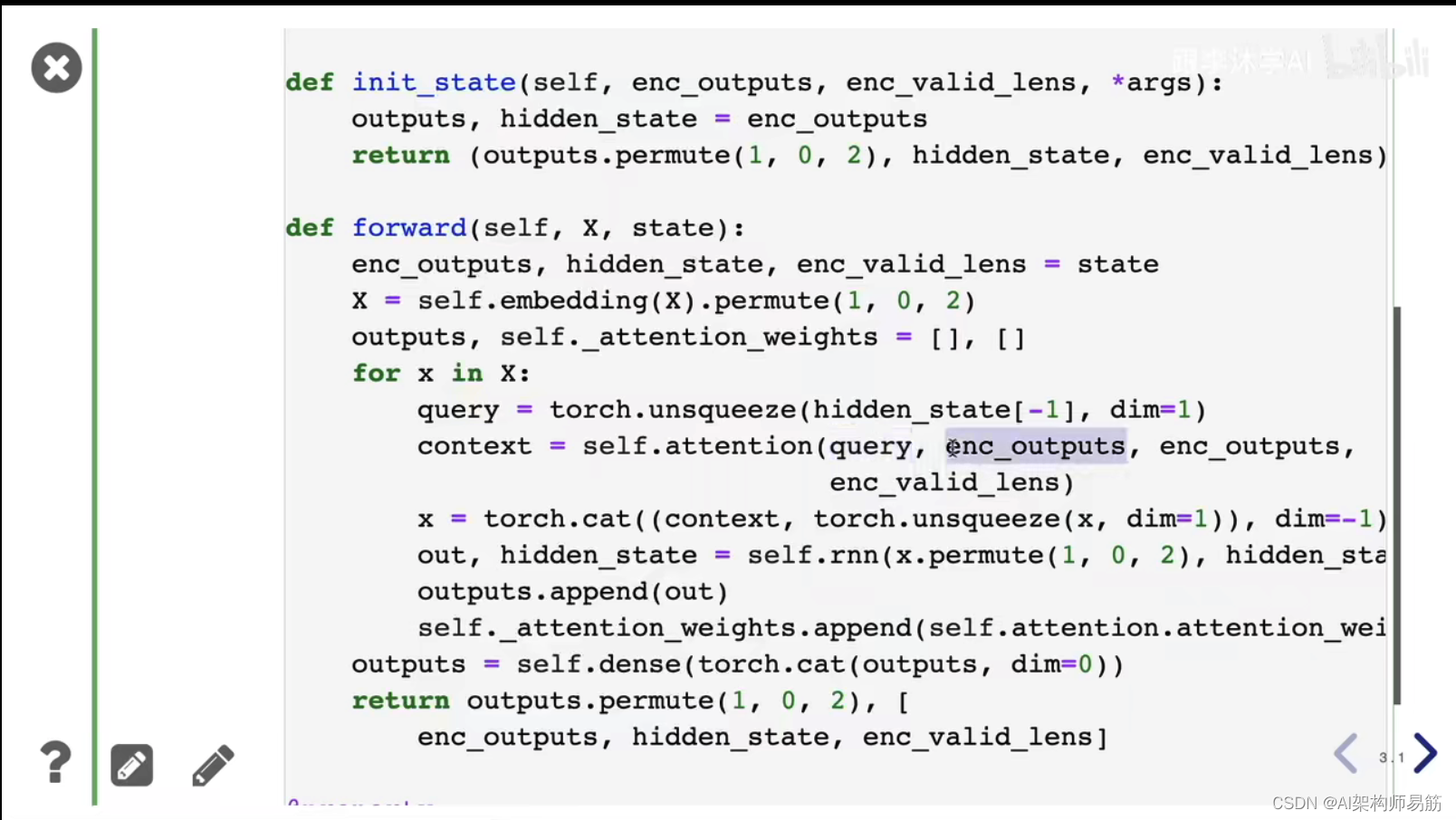

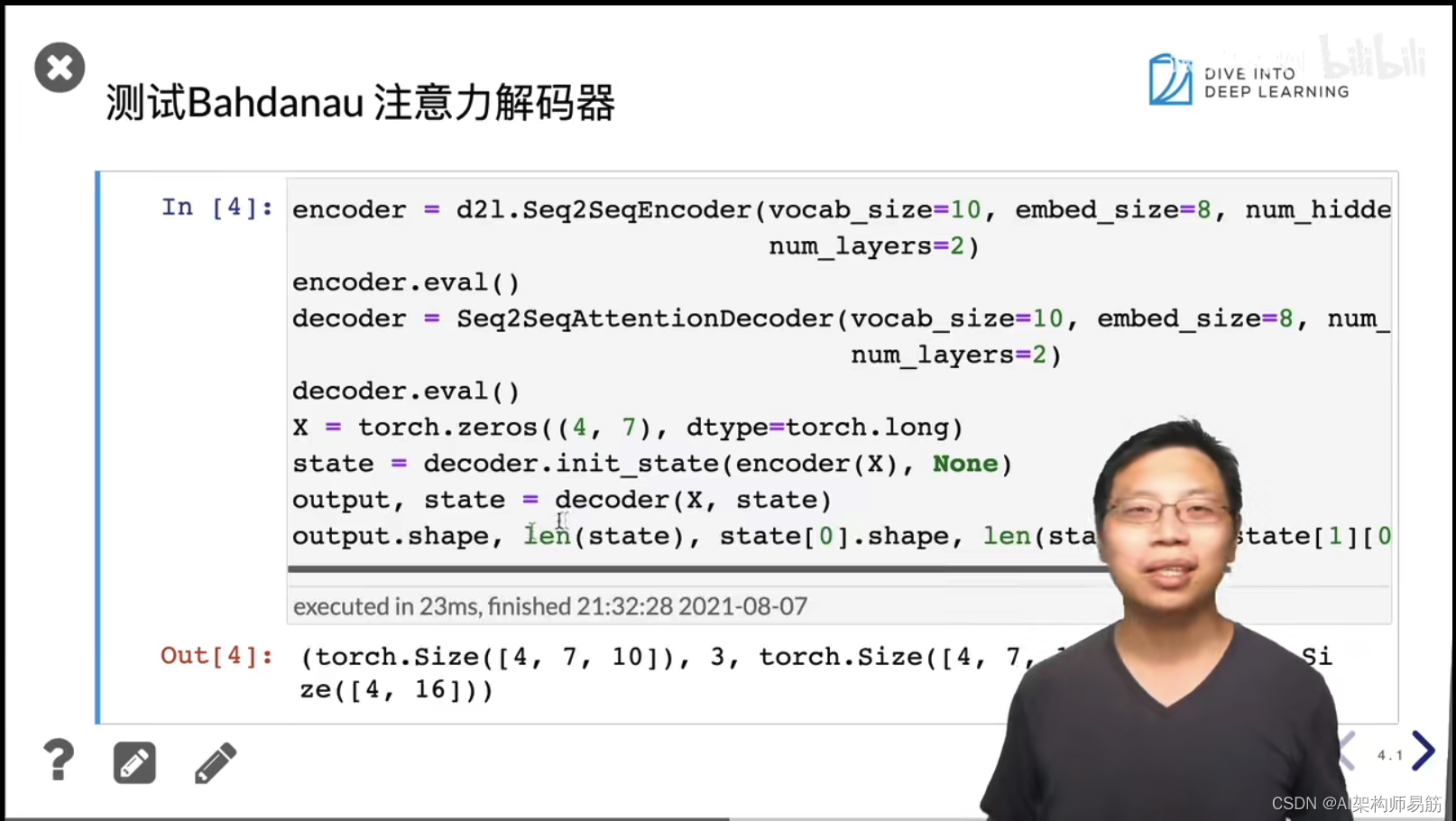

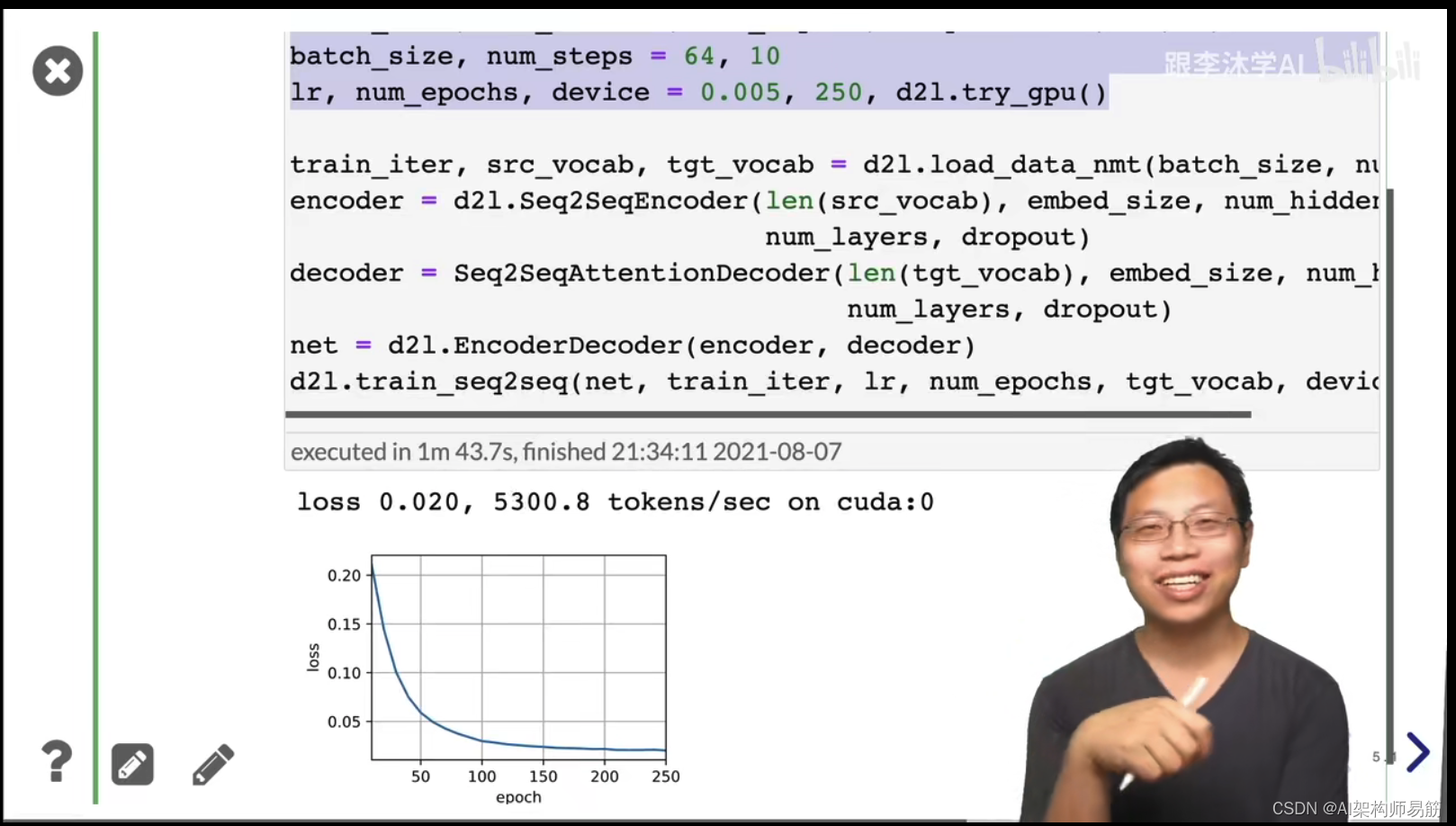

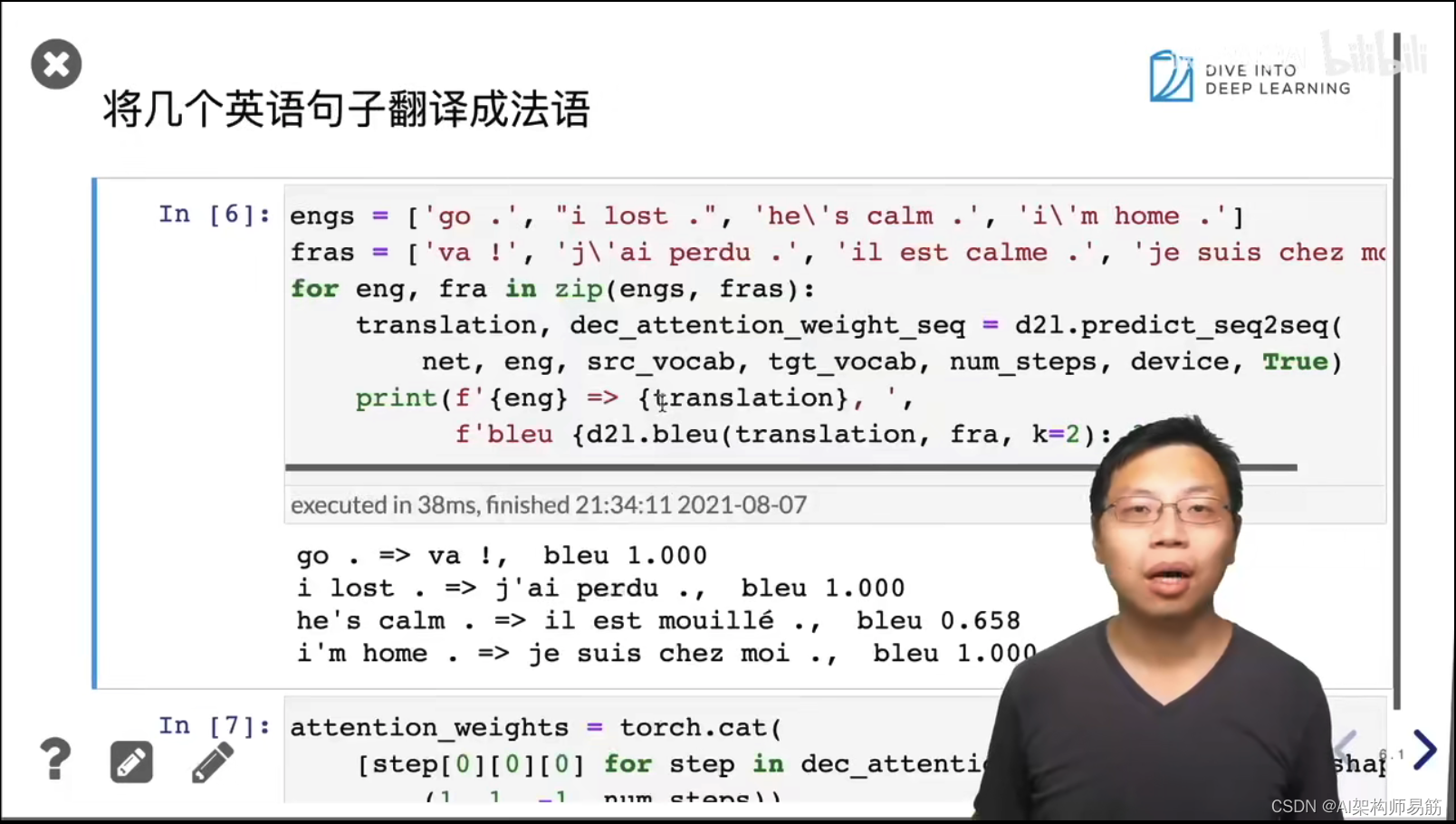

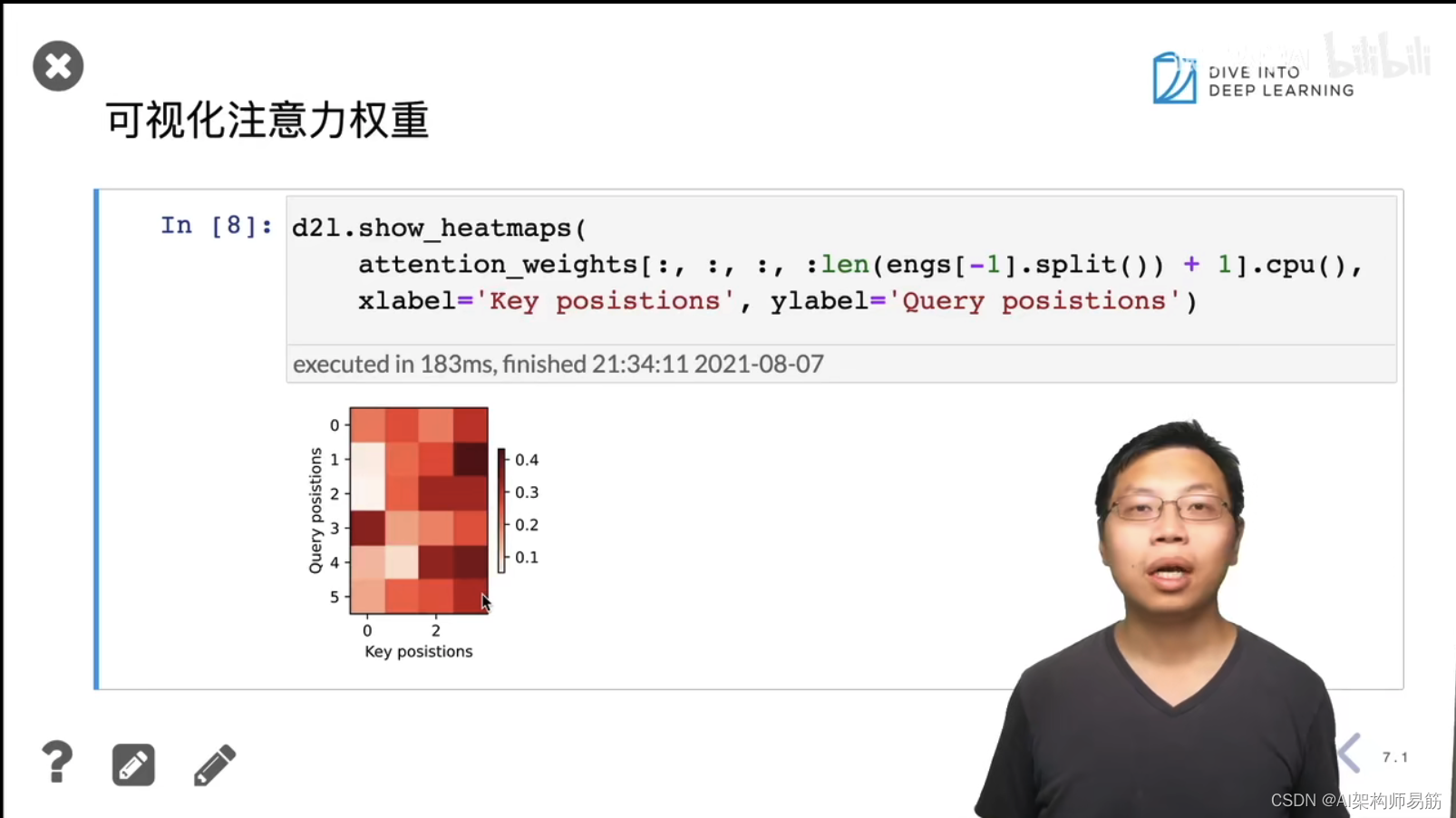

Attention使用注意力机制的seq2seq 动手学深度学习v2

猜你喜欢

转载自blog.csdn.net/zgpeace/article/details/124778059

今日推荐

周排行