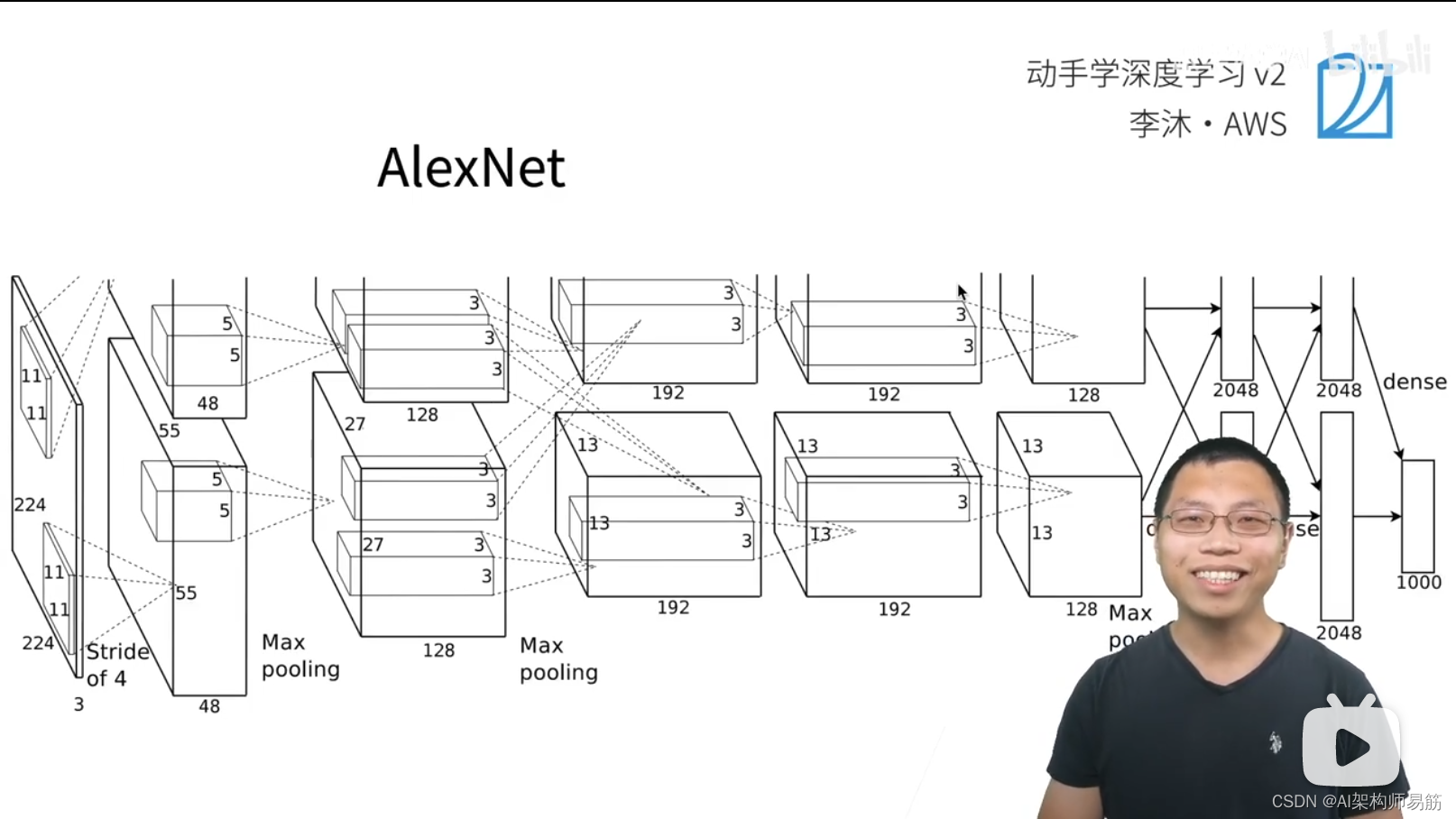

深度卷积神经网络 AlexNet

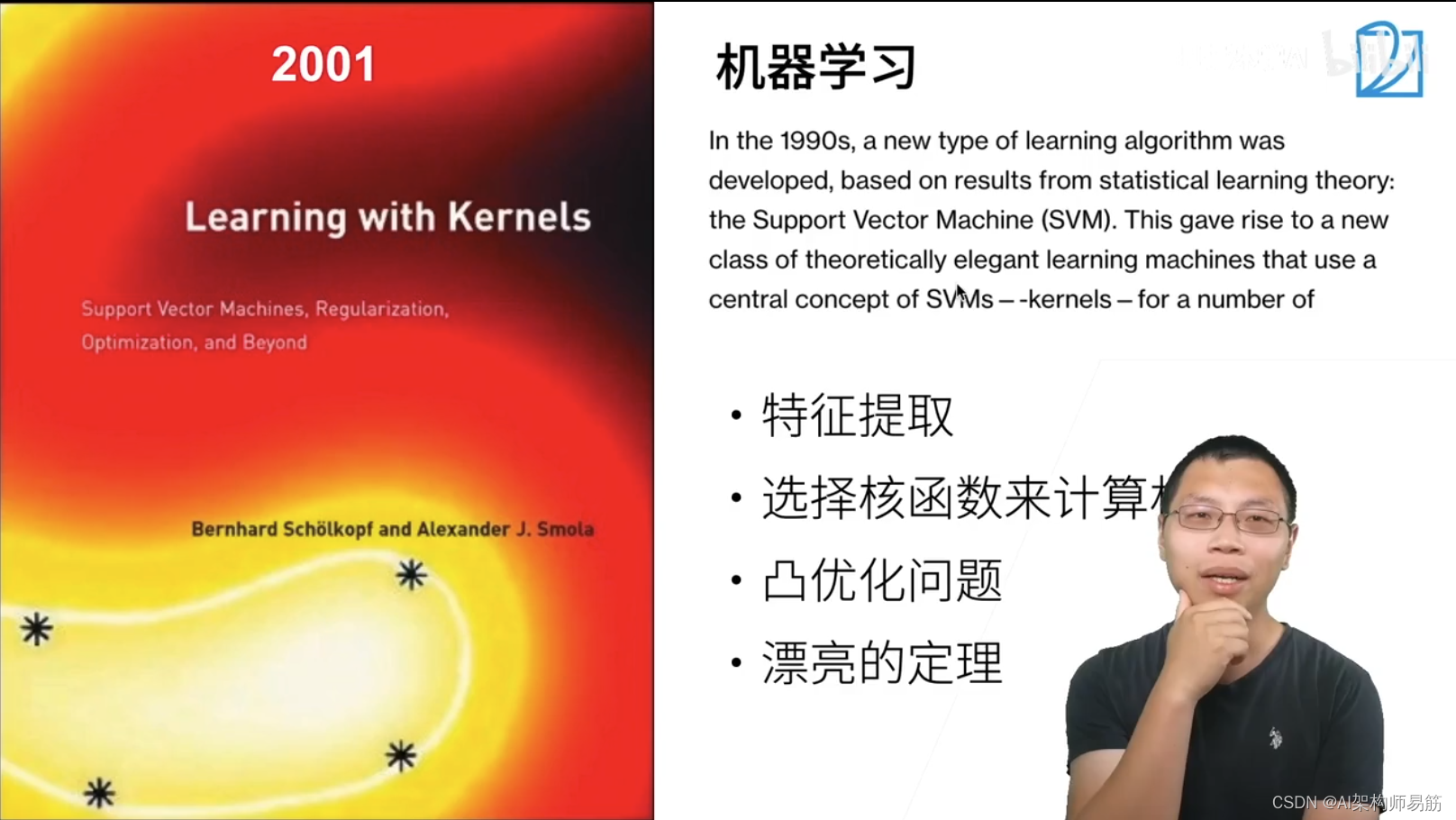

在1990~2001年,SVM Support Vector Machine是最主流的方法

- 特征提取

- 选择核函数计算相似性

- 凸优化问题

- 漂亮的定理

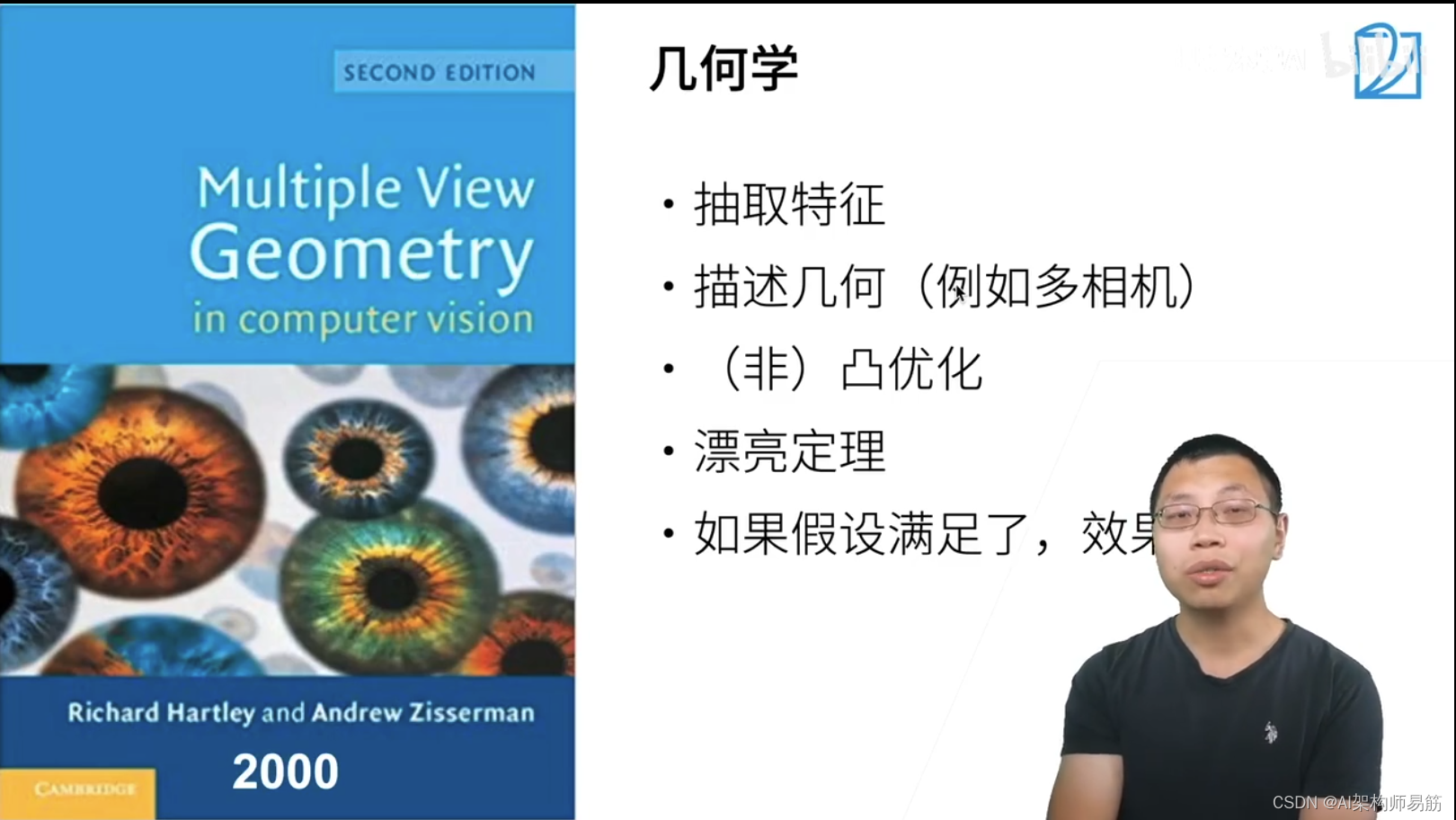

计算机视觉的问题描述成几何学问题 - 抽取特征

- 描述集合(例如多相机)

- 非凸优化

- 漂亮定理

- 如果假设满足了,效果很好

2005年左右最出名的方法是特征工程 - 特征工程是关键

- 特征描述子:SIFT,SURF

- 视觉词袋(聚类)

- 最后用SVM

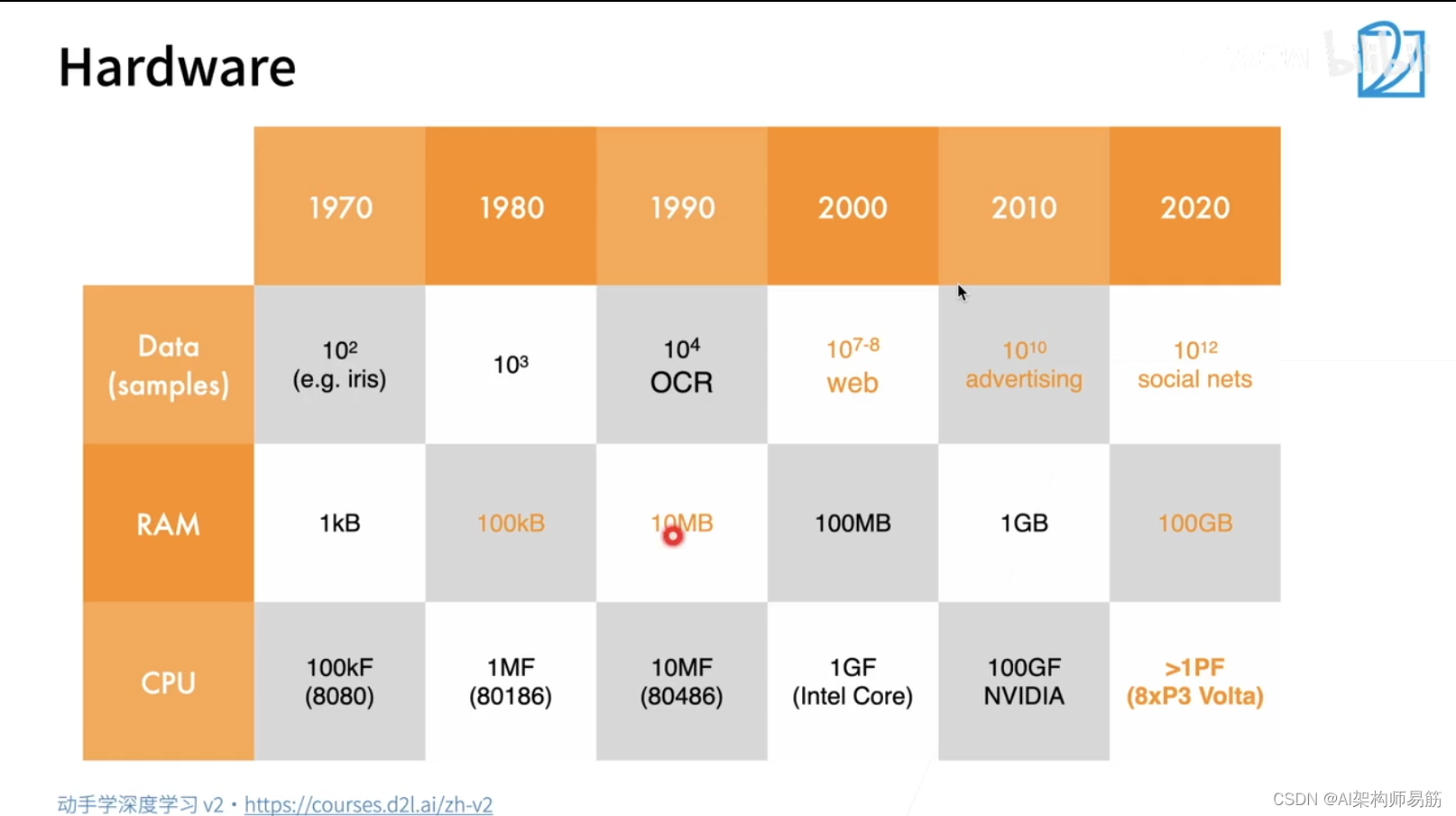

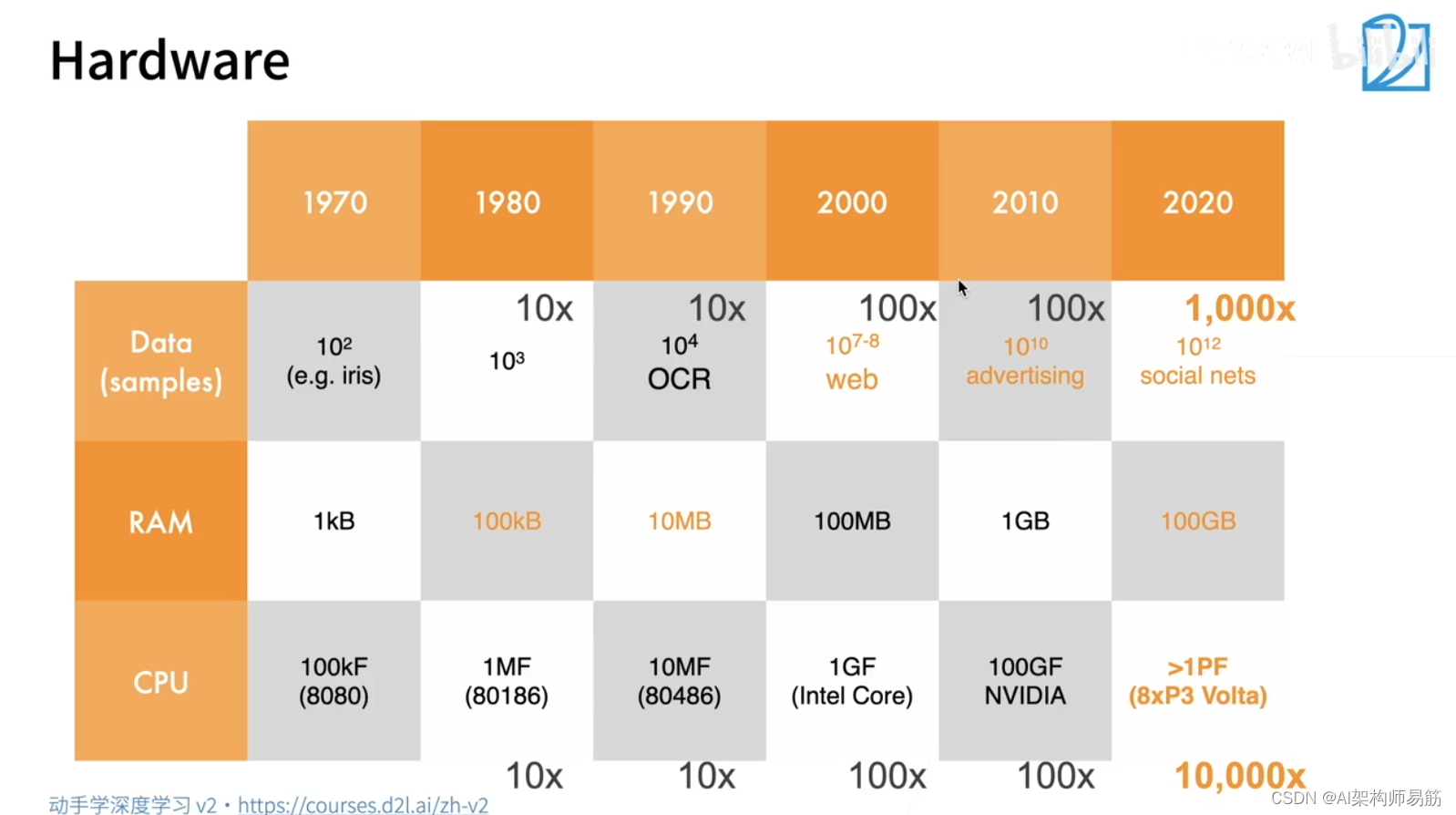

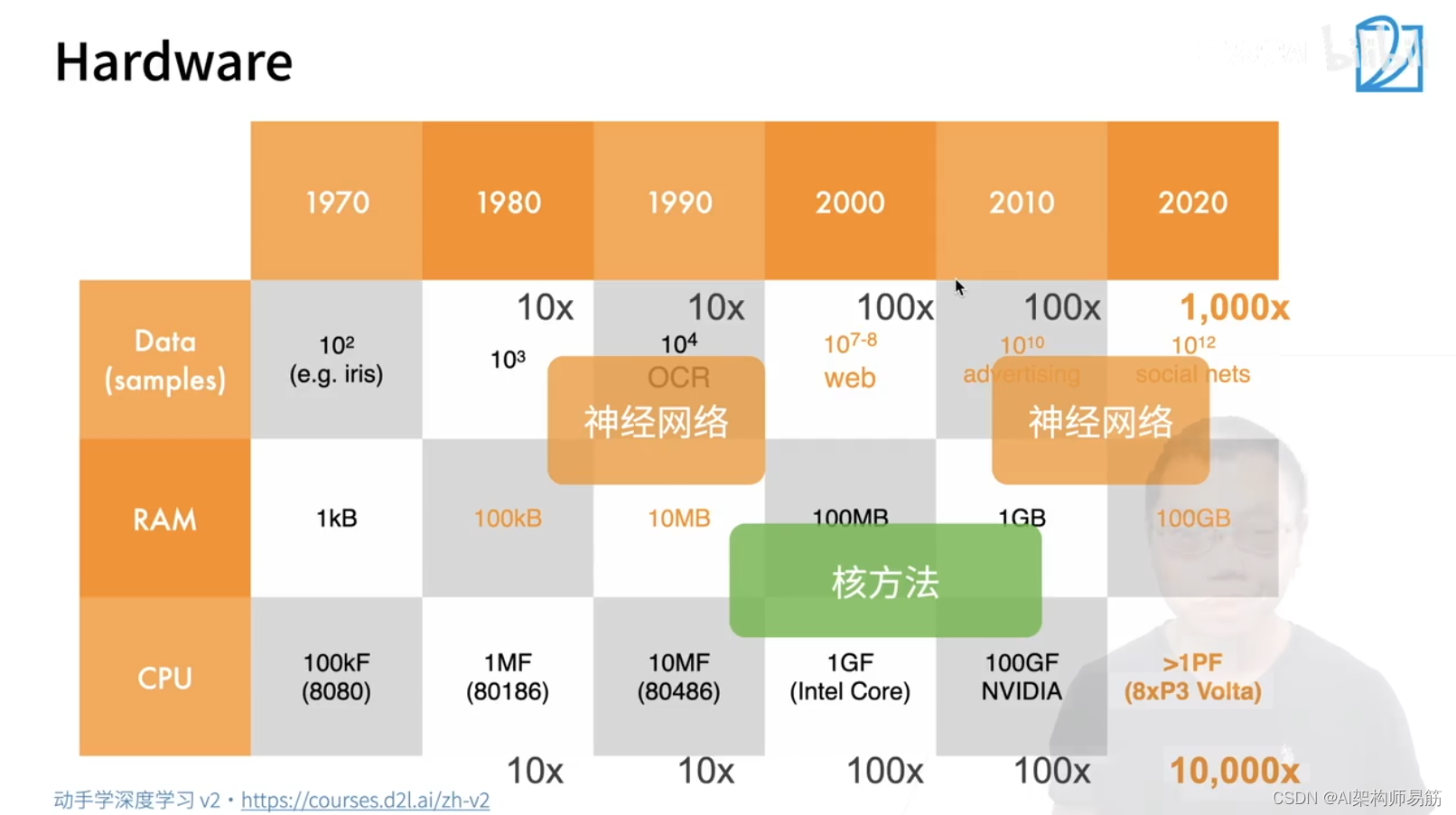

机器学习从1920~2020年数据,内存,CPU增长的变化

数据和计算能力的增长,导致大家对网络方法的选取有不同的偏好,说不定再过段时间,神经网络又没落,核方法或者新的方法再次火起来。一般的升级网络也就火了10年~20年。

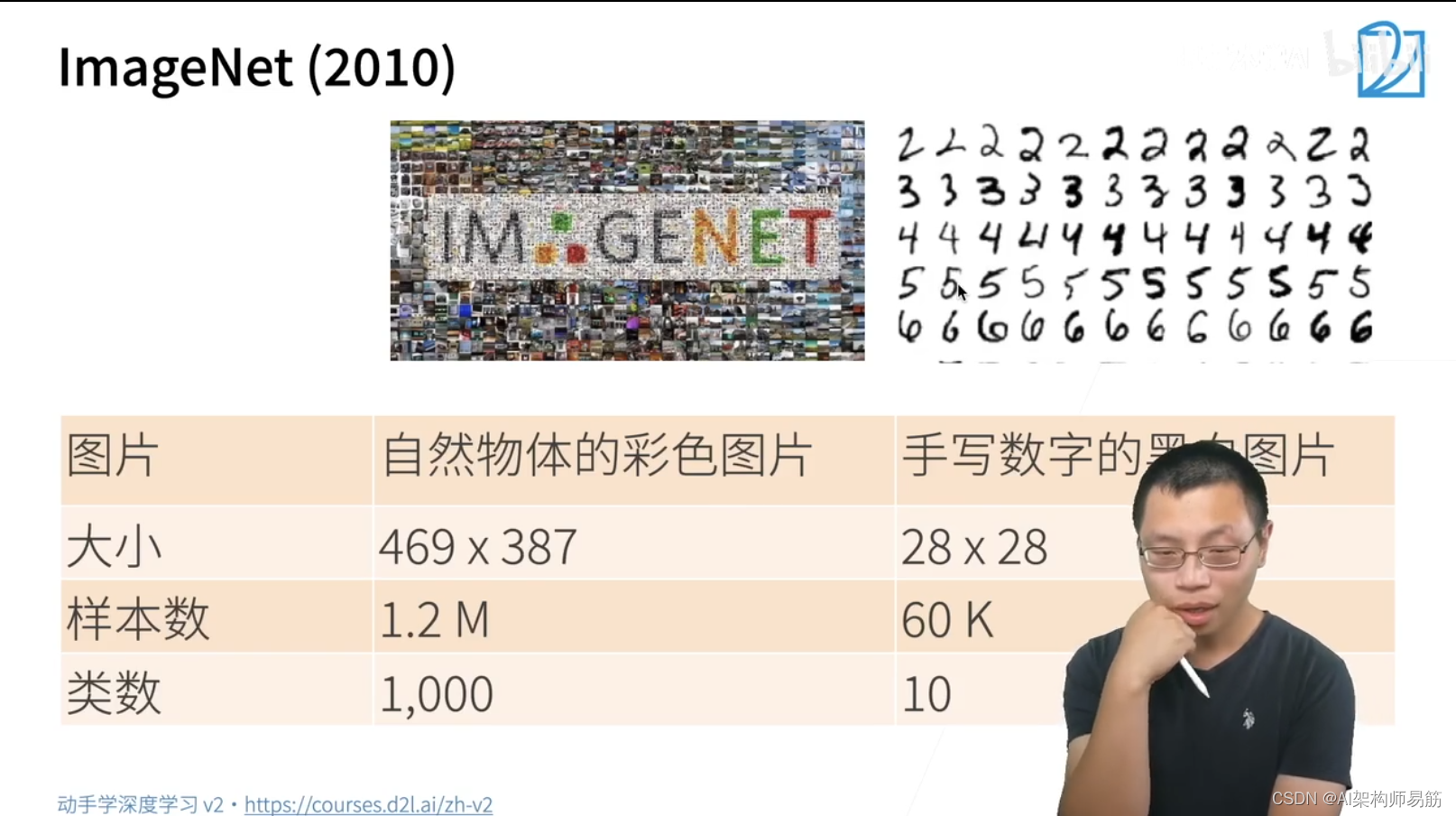

ImageNet 2010年李飞飞在StandFord 发起的项目,单张图片更大,数据集更大。

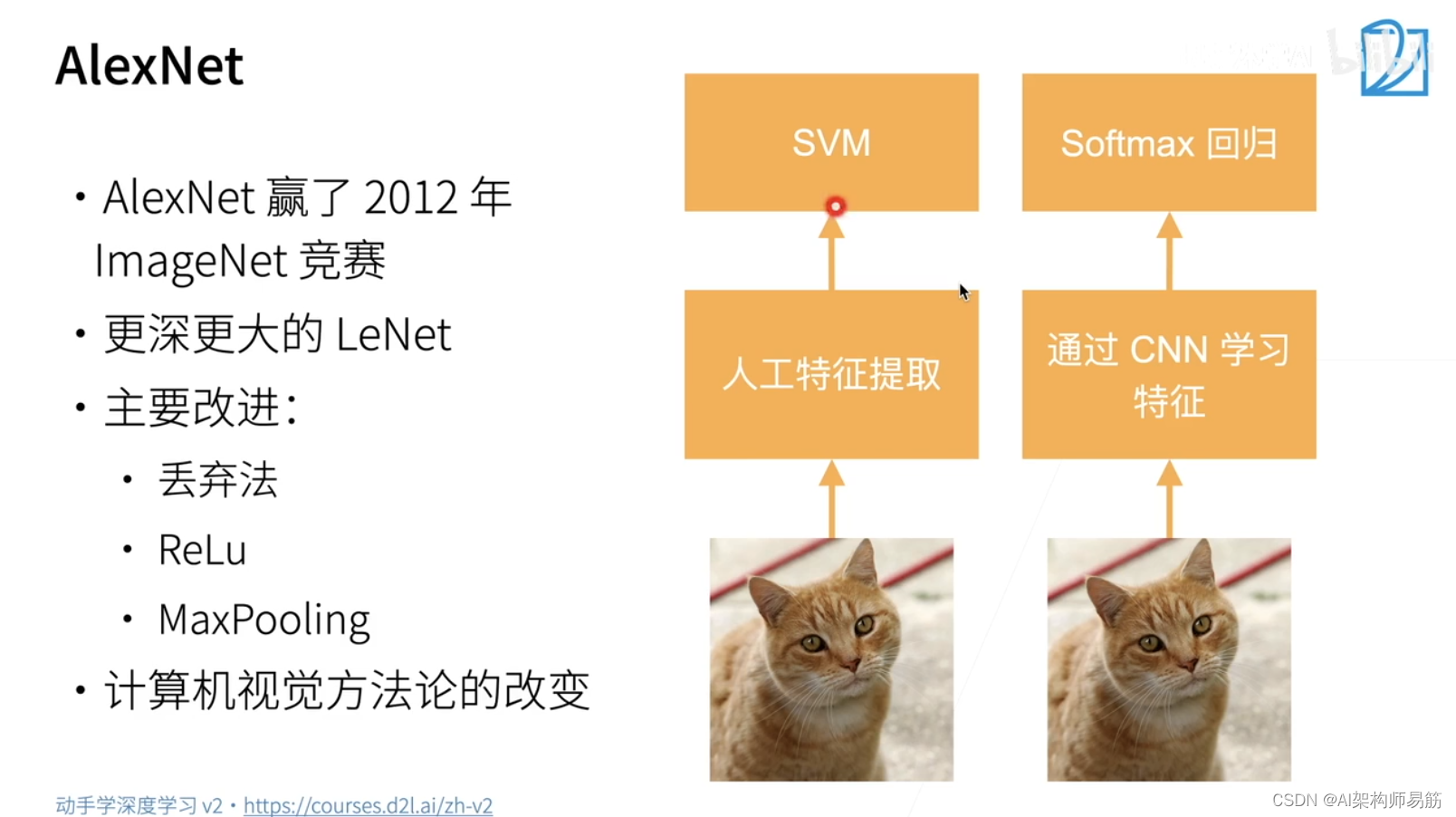

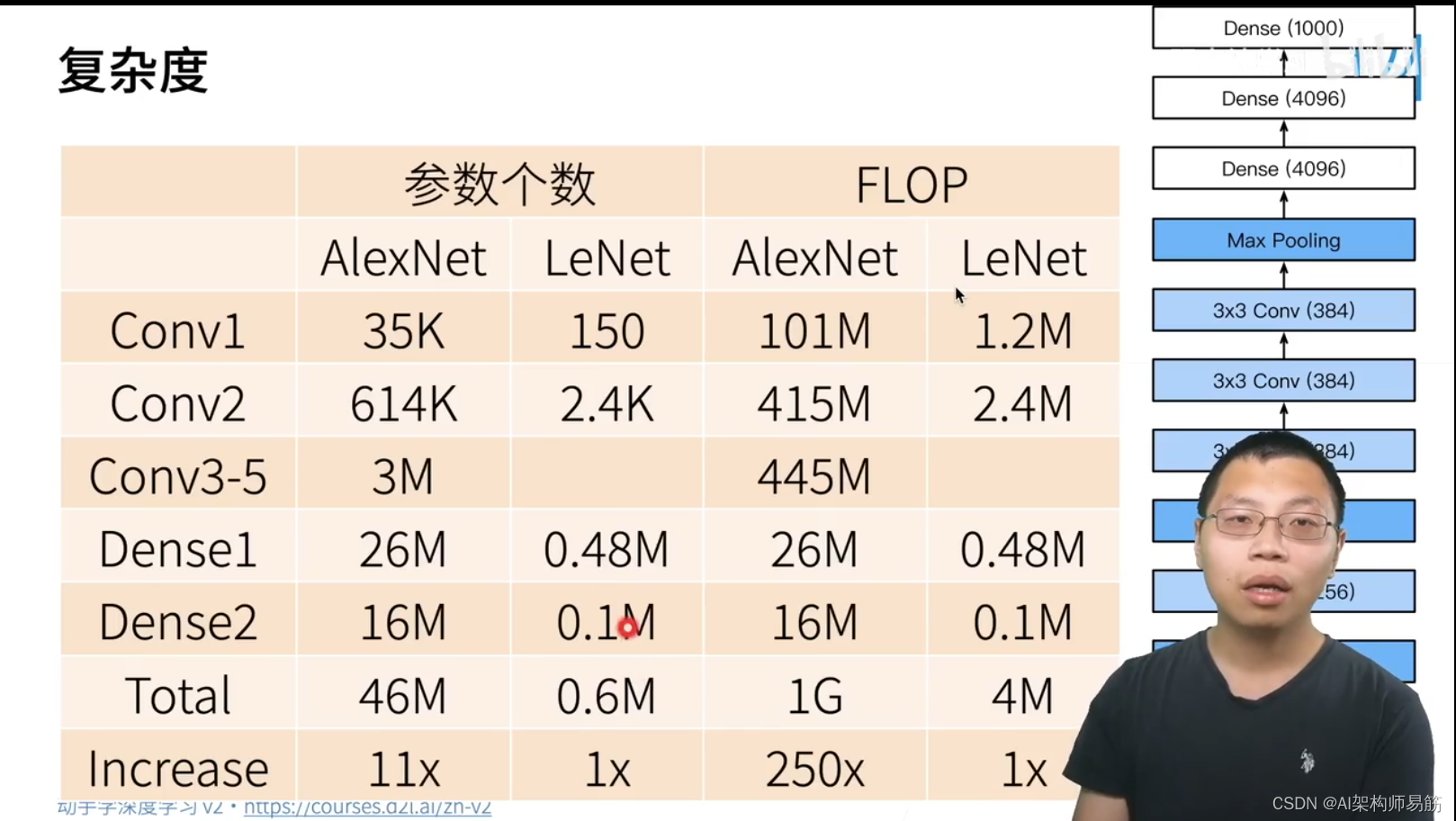

AlexNet - AlexNet 赢了2012年ImageNet竞赛

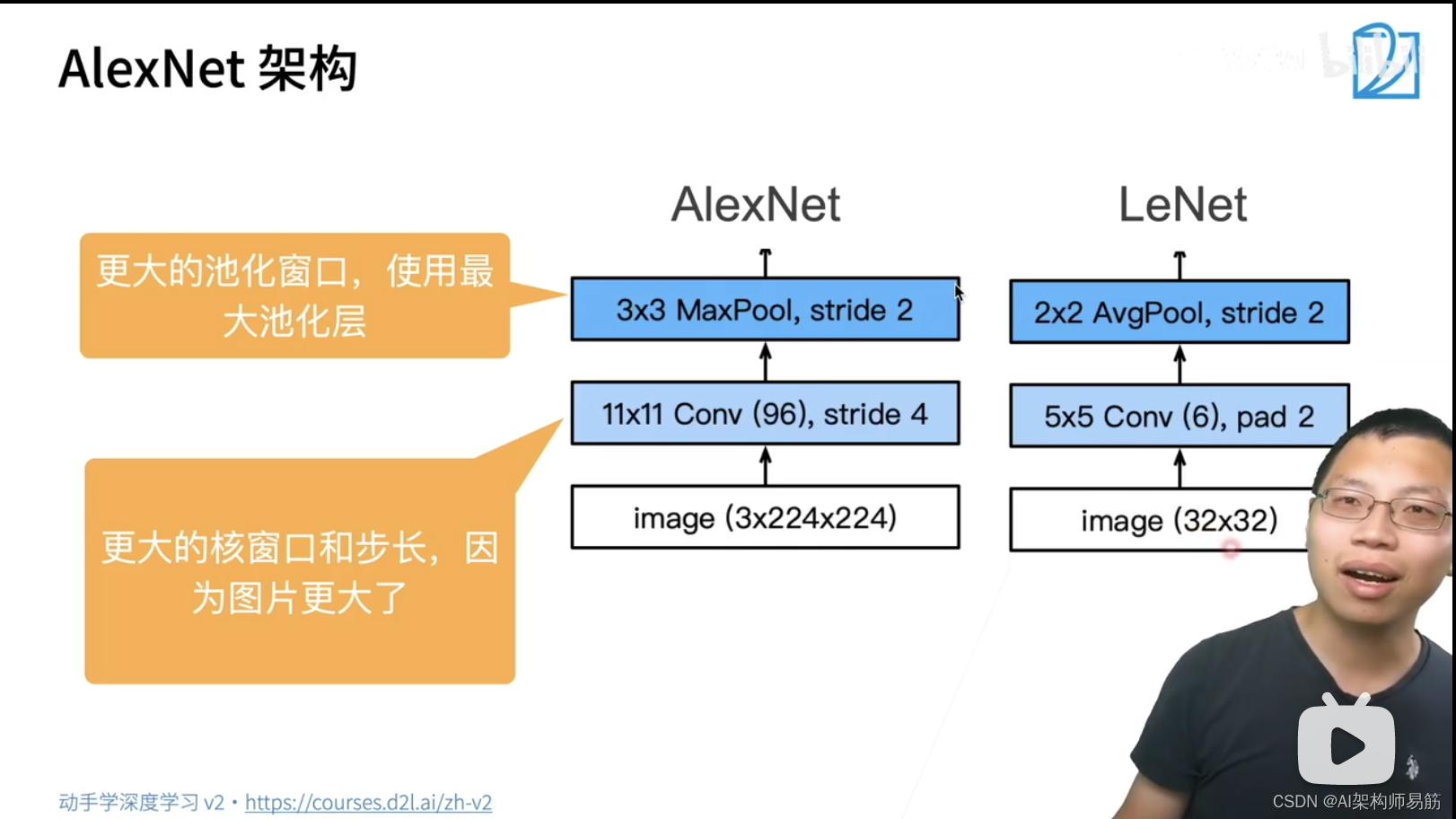

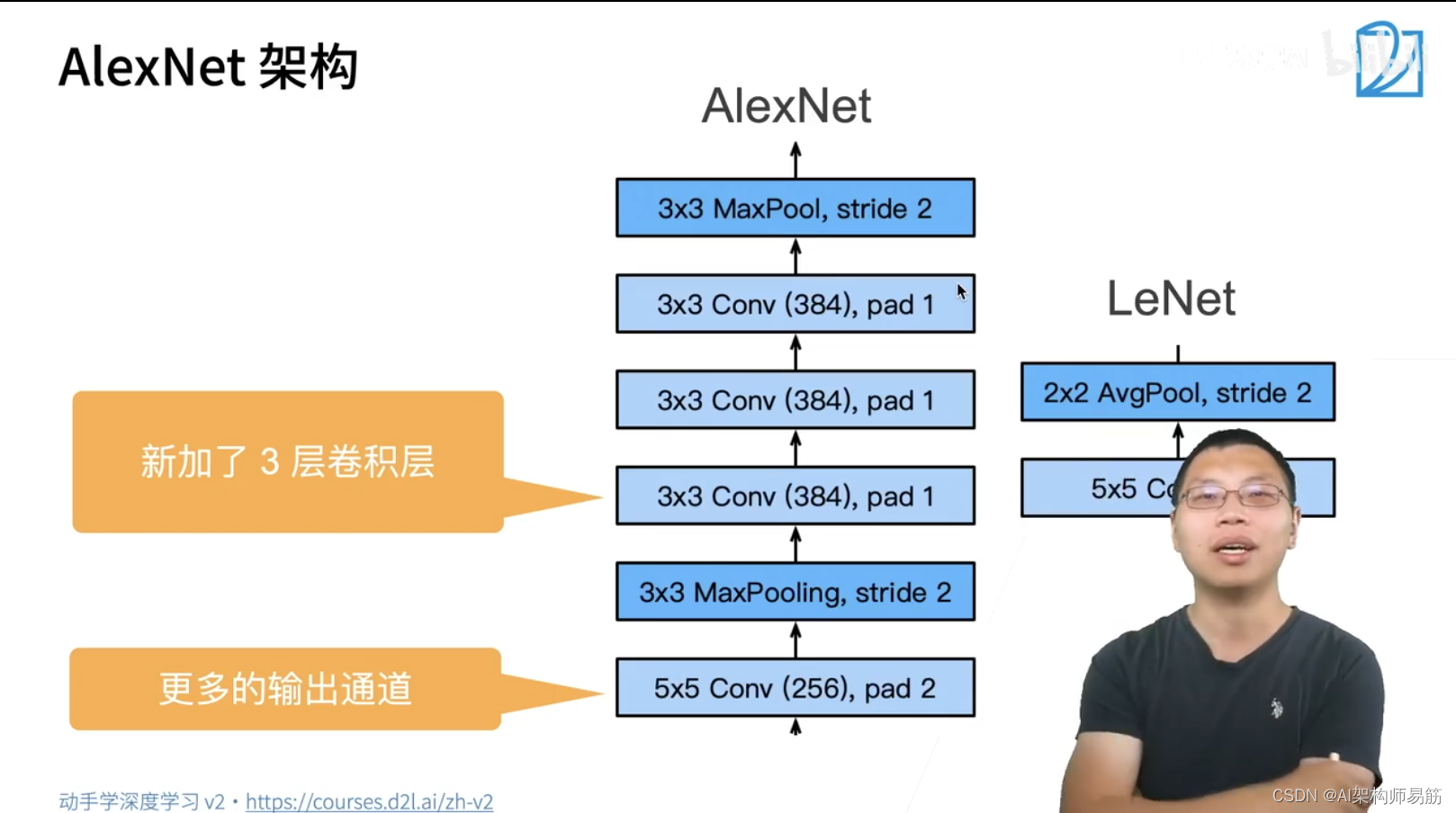

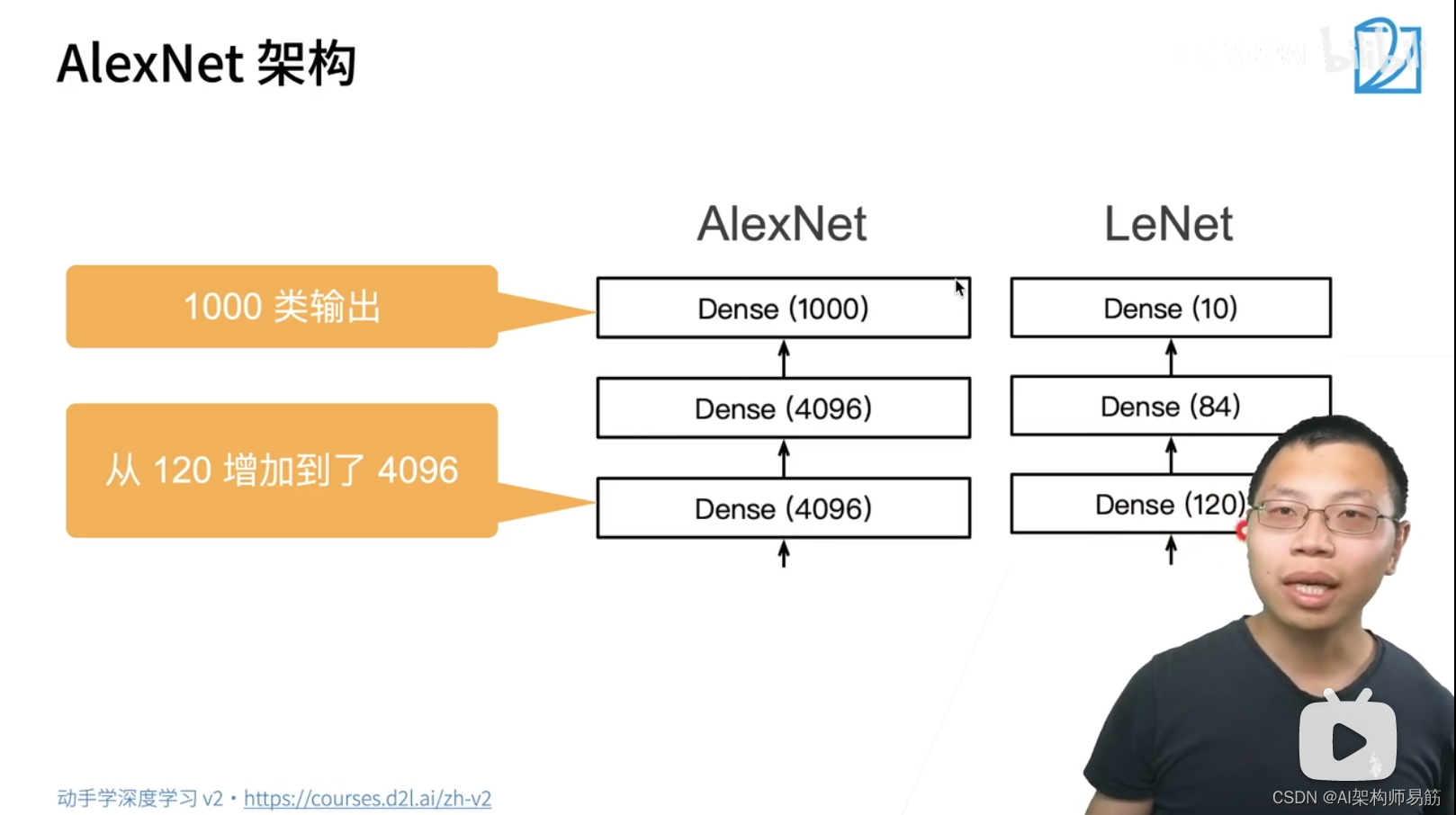

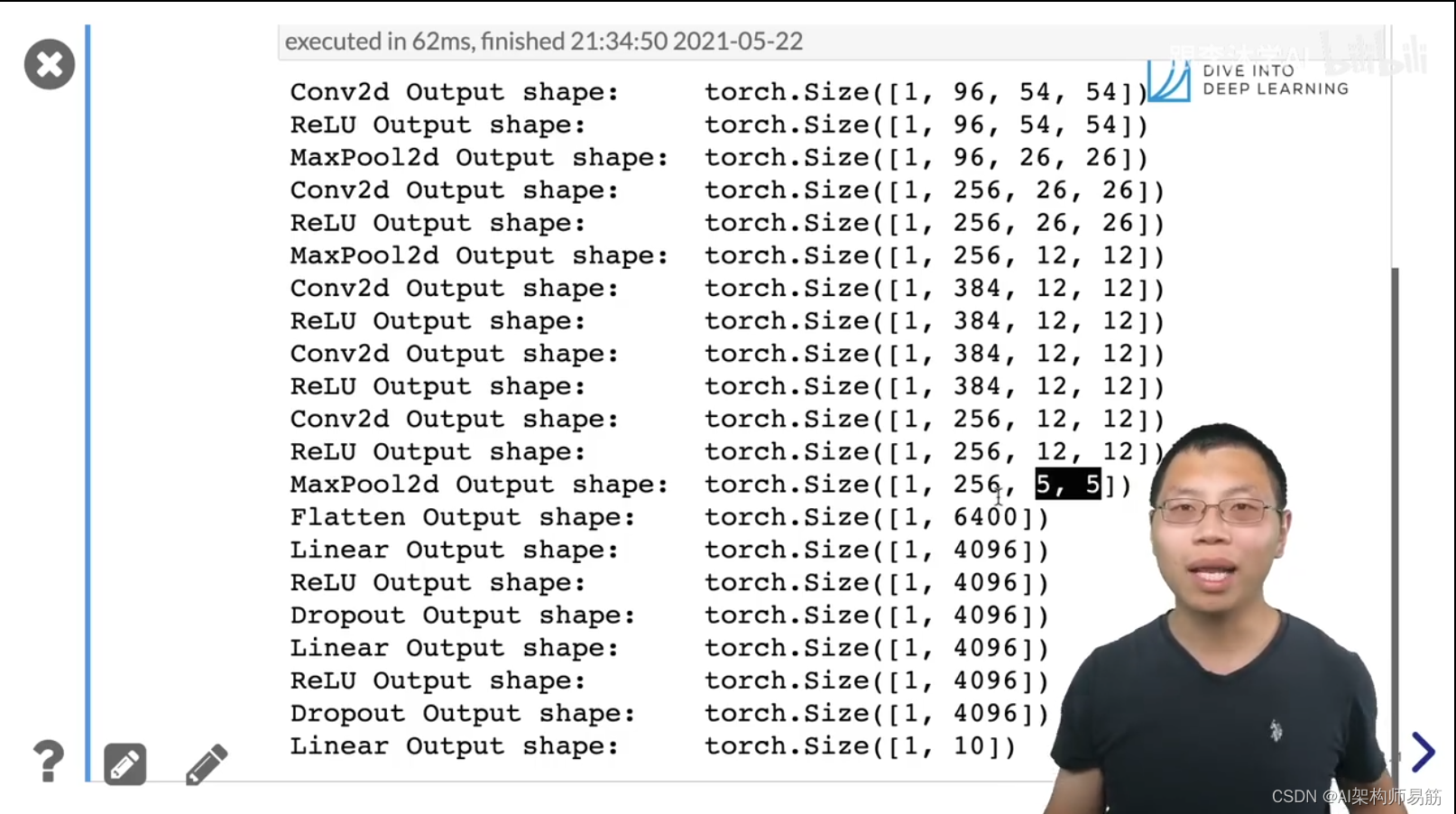

- 更深更大的LeNet

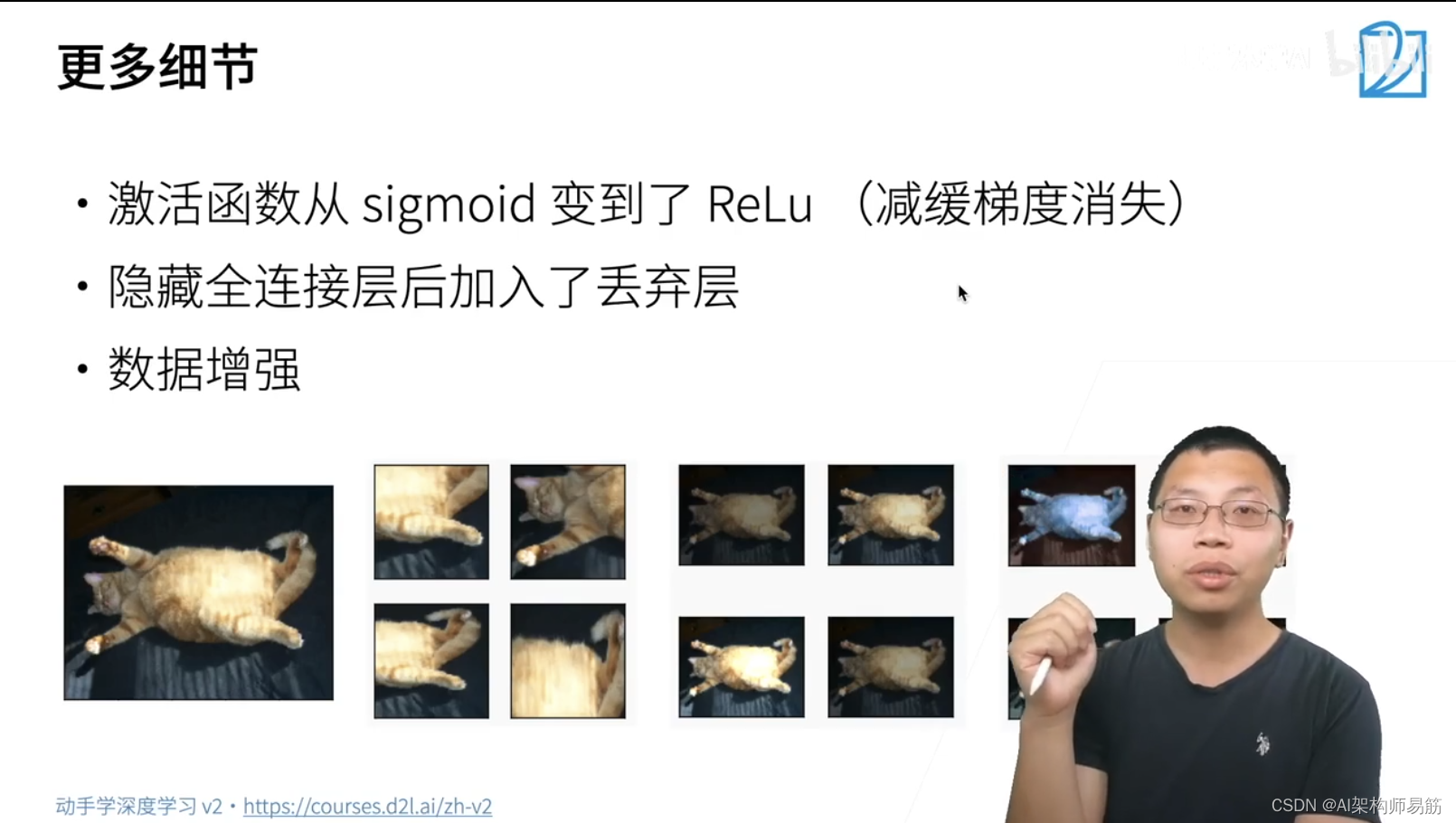

- 主要改进:丢弃法Dropout,ReLu, MaxPooling

- 计算机视觉方法论的改变。从SVM 转向 深度学习,深度学习不需要关心太多计算机视觉的知识。

AlexNet对LeNet小小的改变,用了20年时间。

更多细节

- 激活函数从sigmoid变到了ReLu(减缓梯度消失)

- 隐藏全连接层后加入了丢弃层

- 数据增强

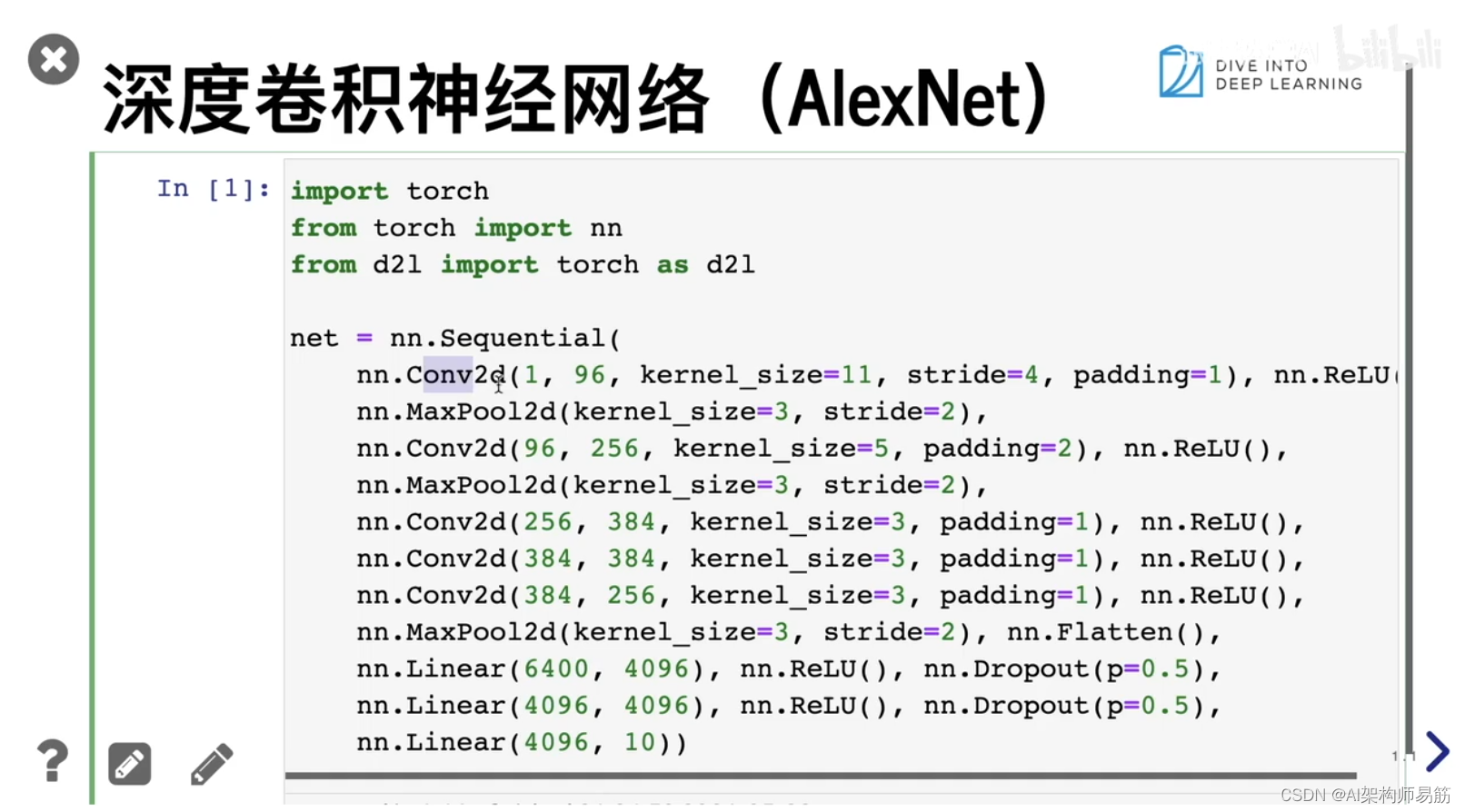

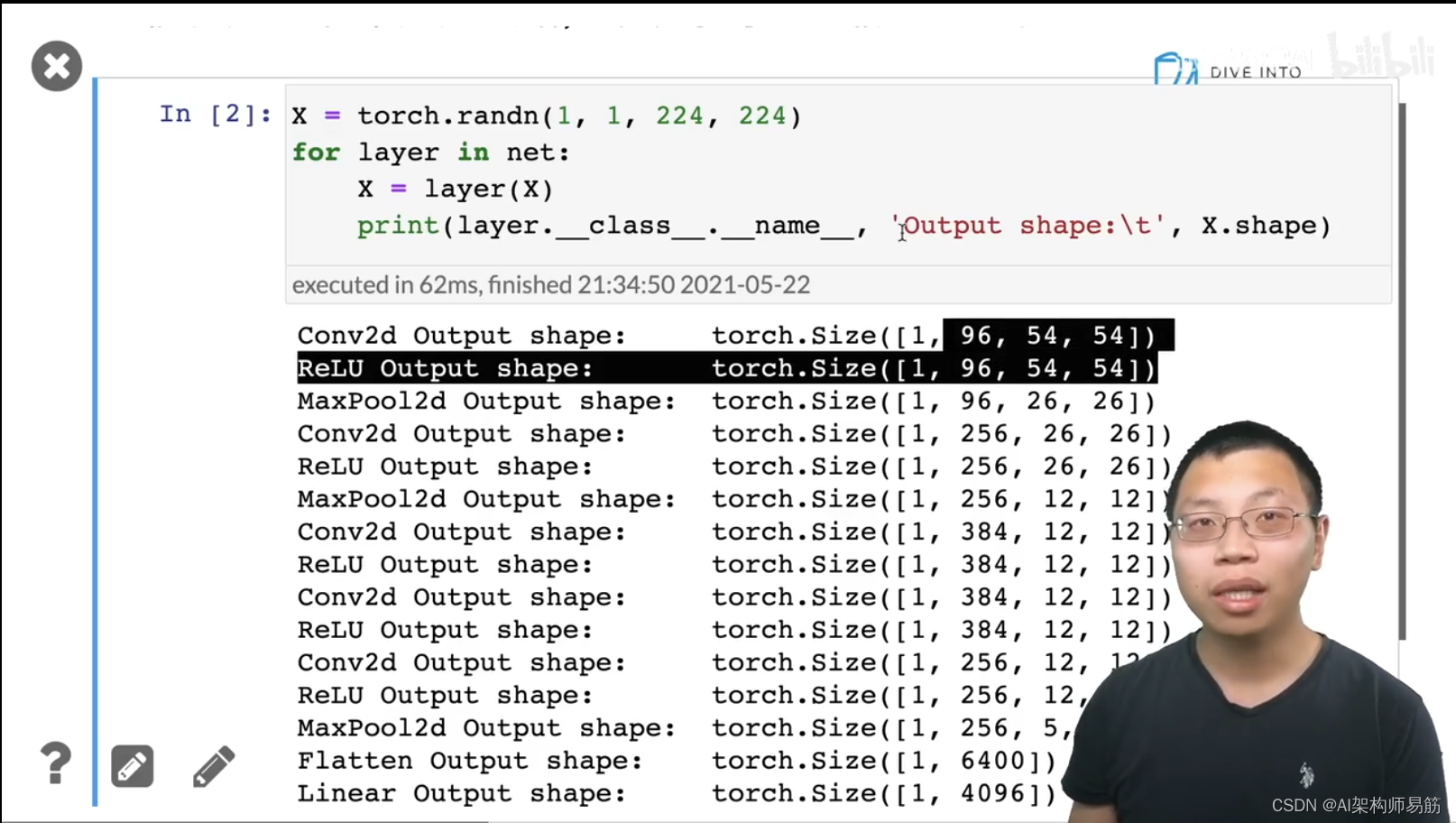

2. 代码实现

这边用的FashionNIST, MNIST 灰度图片做实现,所以只有一个Channel 通道。

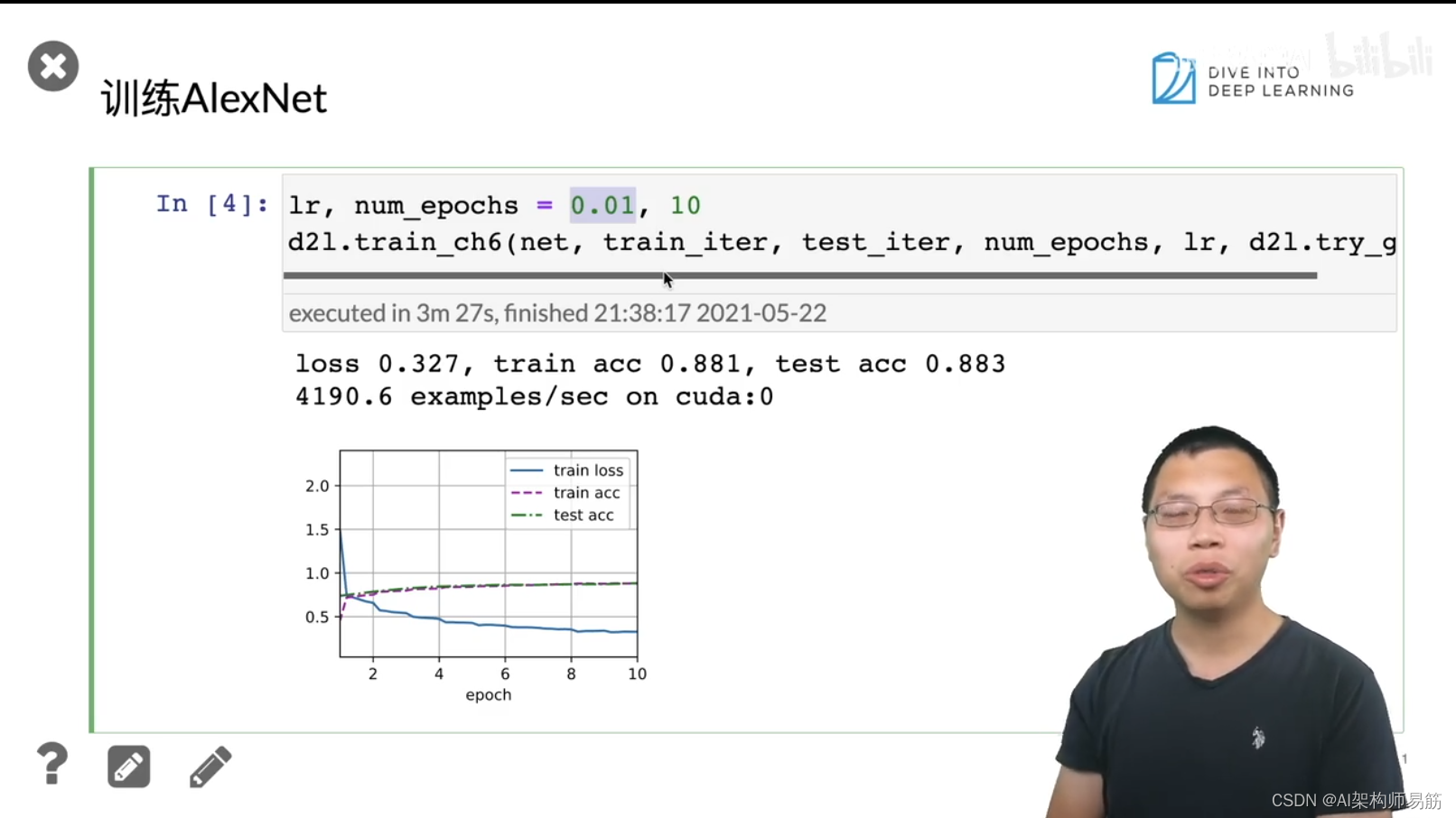

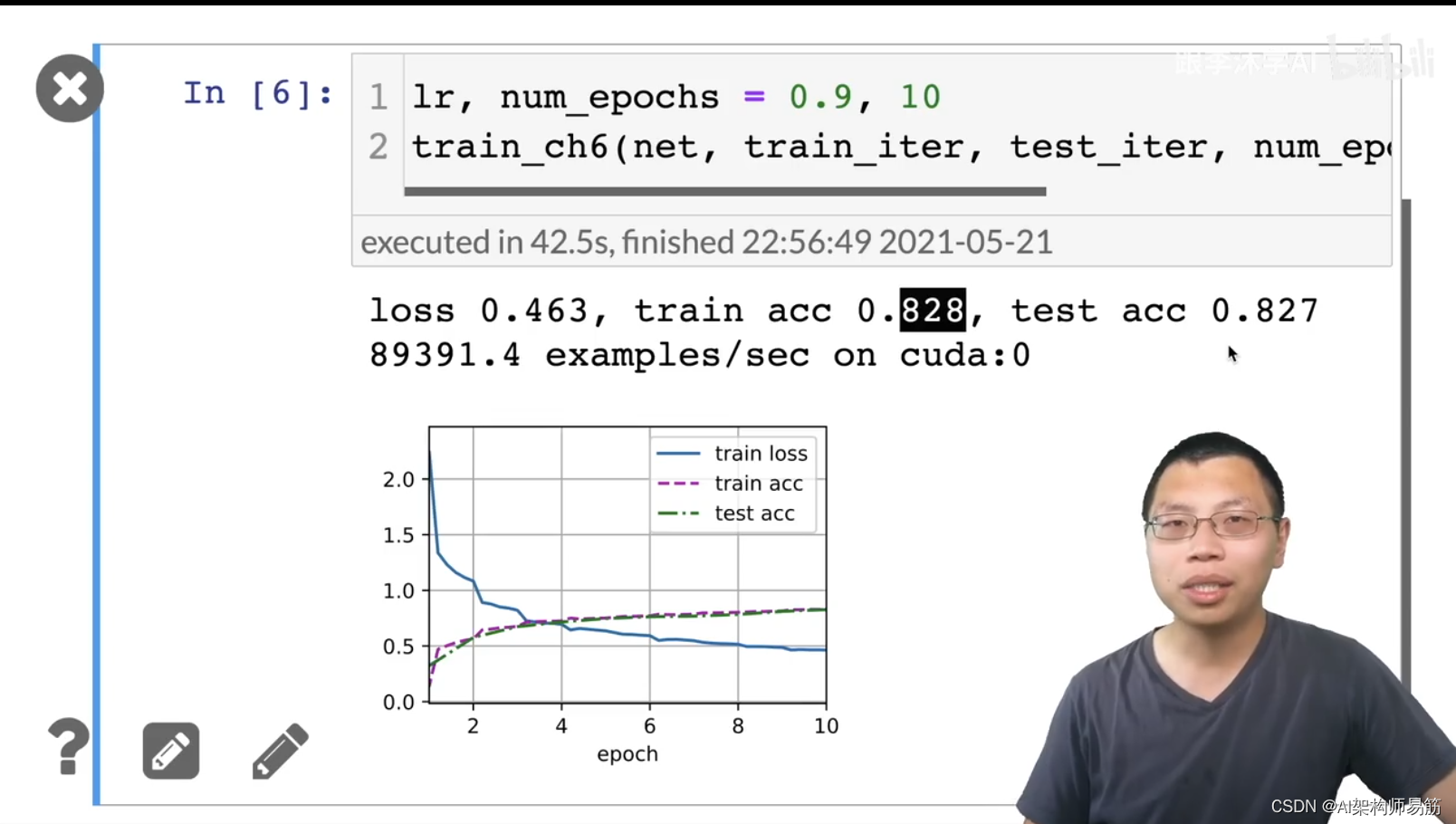

- AlexNet test acc 0.883

- LeNet test acc 0.827

LeNet test acc 0.827

3. Q&A

-

- AlexNet中Local Response Normalization 就是对数据泛化,但是后面证明作用不大。

-

- 为什么LeNet不属于深度卷积神经网络?因为那个时候SVM更火,跟当时的数据量级,和算力能力有很大的关系。

参考

https://www.bilibili.com/video/BV1h54y1L7oe?p=1