目录

前言

决策树(decision tree):是一种基本的分类与回归方法。

在分类问题中,表示基于特征对实例进行分类的过程,可以认为是 if-then 的集合,也可以认为是定义在特征空间与类空间上的条件概率分布。

决策树学习的目标:根据给定的训练数据集构建一个决策树模型,使它能够对实例进行正确的分类

决策树通常有三个步骤:特征选择、决策树的生成、决策树的修剪

同时 我们接下来还需要了解 熵,条件熵,信息增益,信息增益比,基尼指数 这些概念

决策树由下面几种元素构成

- 根节点:包含样本的全集

- 内部节点:对应特征属性测试

- 叶节点:代表决策的结果

决策树学习的算法通常是一个递归地选择最优特征,并根据该特征对训练数据进行分割,使得各个子数据集有一个最好的分类的过程

划分数据集的最大原则是:将无序的数据变得更加有序

被选中的维度的特征具体在哪个值上进行划分呢?

接下来 我们将实现以下3种方法

ID3 算法

ID3 是最早提出的决策树算法,他就是利用信息增益来选择特征的。

C4.5 算法

他是 ID3 的改进版,他不是直接使用信息增益,而是引入“信息增益比”指标作为特征的选择依据。

CART(Classification and Regression Tree)

这种算法即可以用于分类,也可以用于回归问题。CART 算法使用了基尼系数取代了信息熵模型

使用决策树做预测需要以下过程:

收集数据:可以使用任何方法。比如想构建一个相亲系统,我们可以从媒婆那里,或者通过参访相亲对象获取数据。根据他们考虑的因素和最终的选择结果,就可以得到一些供我们利用的数据了。

准备数据:收集完的数据,我们要进行整理,将这些所有收集的信息按照一定规则整理出来,并排版,方便我们进行后续处理。

分析数据:可以使用任何方法,决策树构造完成之后,我们可以检查决策树图形是否符合预期。

训练算法:这个过程也就是构造决策树,同样也可以说是决策树学习,就是构造一个决策树的数据结构。

测试算法:使用经验树计算错误率。当错误率达到了可接收范围,这个决策树就可以投放使用了。

使用算法:此步骤可以使用适用于任何监督学习算法,而使用决策树可以更好地理解数据的内在含义。

如何构造一个决策树

def createBranch():

'''

此处运用了迭代的思想。 感兴趣可以搜索 迭代 recursion, 甚至是 dynamic programing。

'''

检测数据集中的所有数据的分类标签是否相同:

If so return 类标签

Else:

寻找划分数据集的最好特征(划分之后信息熵最小,也就是信息增益最大的特征)

划分数据集

创建分支节点

for 每个划分的子集

调用函数 createBranch (创建分支的函数)并增加返回结果到分支节点中

return 分支节点后面算法使用的数据集(泰坦尼克号)

数据集:cystanford/Titanic_Data: Titanic乘客生存预测 (github.com)

ID3 (信息增益)算法

ID3算法的核心是在决策树各个节点上应用信息增益准则来选择特征,递归的构建决策树。 具体方法是:从根节点开始,对节点计算所有可能的特征的信息增益,选择信息增益最大的特征作为节点的特征,由该特征的不同取值建立子节点:再对子节点递归的调用以上方法,构建决策树:直到所有的特征信息增益均很小或没有特征可以选择为止。

公式

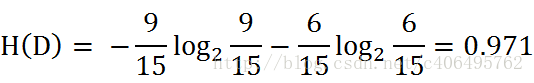

根据此公式计算经验熵H(D),分析贷款申请样本数据表中的数据。最终分类结果只有两类,即放贷和不放贷。根据表中的数据统计可知,在15个数据中,9个数据的结果为放贷,6个数据的结果为不放贷。所以数据集D的经验熵H(D)为:

def calcShannonEnt(dataSet):

#返回数据集行数

numEntries=len(dataSet)

#保存每个标签(label)出现次数的字典

labelCounts={}

#对每组特征向量进行统计

for featVec in dataSet:

currentLabel=featVec[-1] #提取标签信息

if currentLabel not in labelCounts.keys(): #如果标签没有放入统计次数的字典,添加进去

labelCounts[currentLabel]=0

labelCounts[currentLabel]+=1 #label计数

shannonEnt=0.0 #经验熵

#计算经验熵

for key in labelCounts:

prob=float(labelCounts[key])/numEntries #选择该标签的概率

shannonEnt-=prob*log(prob,2) #利用公式计算

return shannonEnt #返回经验熵计算出熵值

信息增益

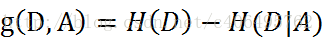

信息增益是相对于特征而言的。所以,特征A对训练数据集D的信息增益g(D,A),定义为集合D的经验熵H(D)与特征A给定条件下D的经验条件熵H(D|A)之差,即

信息增益 = entroy(前) - entroy(后)

代码如下

from math import log

import operator

def calcShannonEnt(dataSet):

#返回数据集行数

numEntries=len(dataSet)

#保存每个标签(label)出现次数的字典

labelCounts={}

#对每组特征向量进行统计

for featVec in dataSet:

currentLabel=featVec[-1] #提取标签信息

if currentLabel not in labelCounts.keys(): #如果标签没有放入统计次数的字典,添加进去

labelCounts[currentLabel]=0

labelCounts[currentLabel]+=1 #label计数

shannonEnt=0.0 #经验熵

#计算经验熵

for key in labelCounts:

prob=float(labelCounts[key])/numEntries #选择该标签的概率

shannonEnt-=prob*log(prob,2) #利用公式计算

return shannonEnt #返回经验熵

def createDataSet():

# 数据集

dataSet=[[0, 0, 0, 0, 'no'],

[0, 0, 0, 1, 'no'],

[0, 1, 0, 1, 'yes'],

[0, 1, 1, 0, 'yes'],

[0, 0, 0, 0, 'no'],

[1, 0, 0, 0, 'no'],

[1, 0, 0, 1, 'no'],

[1, 1, 1, 1, 'yes'],

[1, 0, 1, 2, 'yes'],

[1, 0, 1, 2, 'yes'],

[2, 0, 1, 2, 'yes'],

[2, 0, 1, 1, 'yes'],

[2, 1, 0, 1, 'yes'],

[2, 1, 0, 2, 'yes'],

[2, 0, 0, 0, 'no']]

#分类属性

labels=['年龄','有工作','有自己的房子','信贷情况']

#返回数据集和分类属性

return dataSet,labels

def splitDataSet(dataSet,axis,value):

#创建返回的数据集列表

retDataSet=[]

#遍历数据集

for featVec in dataSet:

if featVec[axis]==value:

#去掉axis特征

reduceFeatVec=featVec[:axis]

#将符合条件的添加到返回的数据集

reduceFeatVec.extend(featVec[axis+1:])

retDataSet.append(reduceFeatVec)

#返回划分后的数据集

return retDataSet

def chooseBestFeatureToSplit(dataSet):

#特征数量

numFeatures = len(dataSet[0]) - 1

#计数数据集的香农熵

baseEntropy = calcShannonEnt(dataSet)

#信息增益

bestInfoGain = 0.0

#最优特征的索引值

bestFeature = -1

#遍历所有特征

for i in range(numFeatures):

# 获取dataSet的第i个所有特征

featList = [example[i] for example in dataSet]

#创建set集合{},元素不可重复

uniqueVals = set(featList)

#经验条件熵

newEntropy = 0.0

#计算信息增益

for value in uniqueVals:

#subDataSet划分后的子集

subDataSet = splitDataSet(dataSet, i, value)

#计算子集的概率

prob = len(subDataSet) / float(len(dataSet))

#根据公式计算经验条件熵

newEntropy += prob * calcShannonEnt((subDataSet))

#信息增益

infoGain = baseEntropy - newEntropy

#打印每个特征的信息增益

print("第%d个特征的增益为%.3f" % (i, infoGain))

#计算信息增益

if (infoGain > bestInfoGain):

#更新信息增益,找到最大的信息增益

bestInfoGain = infoGain

#记录信息增益最大的特征的索引值

bestFeature = i

#返回信息增益最大特征的索引值

return bestFeature

def majorityCnt(classList):

classCount={}

#统计classList中每个元素出现的次数

for vote in classList:

if vote not in classCount.keys():

classCount[vote]=0

classCount[vote]+=1

#根据字典的值降序排列

sortedClassCount=sorted(classCount.items(),key=operator.itemgetter(1),reverse=True)

return sortedClassCount[0][0]

def createTree(dataSet,labels,featLabels):

#取分类标签(是否放贷:yes or no)

classList=[example[-1] for example in dataSet]

#如果类别完全相同,则停止继续划分

if classList.count(classList[0])==len(classList):

return classList[0]

#遍历完所有特征时返回出现次数最多的类标签

if len(dataSet[0])==1:

return majorityCnt(classList)

#选择最优特征

bestFeat=chooseBestFeatureToSplit(dataSet)

#最优特征的标签

bestFeatLabel=labels[bestFeat]

featLabels.append(bestFeatLabel)

#根据最优特征的标签生成树

myTree={bestFeatLabel:{}}

#删除已经使用的特征标签

del(labels[bestFeat])

#得到训练集中所有最优特征的属性值

featValues=[example[bestFeat] for example in dataSet]

#去掉重复的属性值

uniqueVls=set(featValues)

#遍历特征,创建决策树

for value in uniqueVls:

myTree[bestFeatLabel][value]=createTree(splitDataSet(dataSet,bestFeat,value),

labels,featLabels)

return myTree

if __name__=='__main__':

dataSet,labels=createDataSet()

featLabels=[]

myTree=createTree(dataSet,labels,featLabels)

print(myTree)

结果如下

C4.5 算法

def choose_best_feature(dataset):

num_of_features = len(dataset[0]) - 1

# 计算当前数据集的信息熵

current_entropy = compute_entropy(dataset)

# 初始化信息增益率

best_information_gain_ratio = 0.0

# 初始化最佳特征的下标为-1

index_of_best_feature = -1

# 通过下标遍历整个特征列表

for i in range(num_of_features):

# 构造所有样本在当前特征的取值的列表

values_of_current_feature = [example[i] for example in dataset]

unique_values = set(values_of_current_feature)

# 初始化新的信息熵

new_entropy = 0.0

# 初始化分离信息

split_info = 0.0

for value in unique_values:

sub_dataset = create_sub_dataset(dataset, i, value)

p = len(sub_dataset) / len(dataset)

# 计算使用该特征进行样本划分后的新信息熵

new_entropy += p * compute_entropy(sub_dataset)

# 计算分离信息

split_info -= p * log(p, 2)

# 计算信息增益

# information_gain = current_entropy - new_entropy

# 计算信息增益率(Gain_Ratio = Gain / Split_Info)

information_gain_ratio = (current_entropy - new_entropy) / split_info

# 求出最大的信息增益及对应的特征下标

if information_gain_ratio > best_information_gain_ratio:

best_information_gain_ratio = information_gain_ratio

index_of_best_feature = i

# 这里返回的是特征的下标

return index_of_best_feature

可视化:

在数据处理的时候出现了点问题 只能先用sklearn计算出结果和可视化决策树

。。。