熵的含义:

在信息论中,熵(英语:entropy)是接收的每条消息中包含的信息的平均量,又被称为信息熵、信源熵、平均自信息量。这里,“消息”代表来自分布或数据流中的事件、样本或特征。(熵最好理解为不确定性的量度而不是确定性的量度,因为越随机的信源的熵越大。)——维基百科。

我们可以直观地把熵理解为一个事件的结果的不确定性,或者信息量,其单位为 bit。

熵的计算:

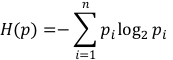

熵描述的是个事件的不确定性,如果某个事件有 n 个结果,每个结果的概率为 pn。那么这个事件的熵 H§ 的定义式为

例子:

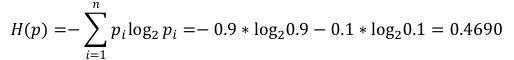

假设有一场足球赛,巴西队对战中国队。假设巴西队获胜的概率为 0.9,不胜的概率为 0.1。那么这场比赛结果的熵就是:

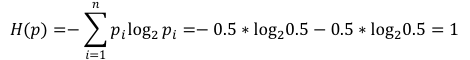

假设有另一场足球赛,英国队对战法国队。假设英国队获胜或不胜的概率都是0.5。那么这场比赛结果的熵就是:

后者的熵比前者大,可见结果的不确定更大,比赛结果的信息量就更大。

条件熵:

熵是对事件结果不确定性的度量,但在某些条件下,这个不确定性会变小。

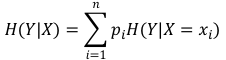

条件熵衡量的就是在某个条件 X 下,事件 Y 的不确定性,记作 H(Y|X) 。其定义式为:

条件熵可以理解为,X 事件每个可能性的结果的熵乘以发生概率的求和。

信息增益:

熵衡量的是事件的不确定性;条件熵衡量的是知道了某个条件后,事件的不确定性。

对于同一个事件,熵的值肯定是大于或等于条件熵的。

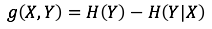

因此引入信息增益的概念,写作g(X,Y)。它的计算方式为熵减去条件熵:

信息增益表示的是,知道了某个条件后,原来事件不确定性降低的幅度。

扫描二维码关注公众号,回复:

11133806 查看本文章

参考资料:https://kaiwu.lagou.com/course/courseInfo.htm?courseId=15#/detail/pc?id=219