我的环境:Hadoop-2.7.1 + jdk1.8 + CentOS7

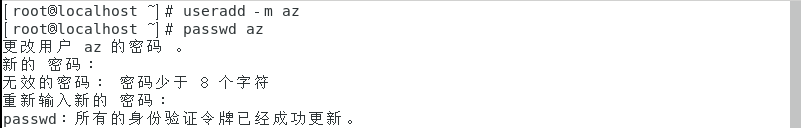

1.创建hadoop-vm用户(用户名可以自及定义)

1.1 输入useradd -m az 创建用户

1.2 输入passwd az(此处为你设置的用户名) 更改密码

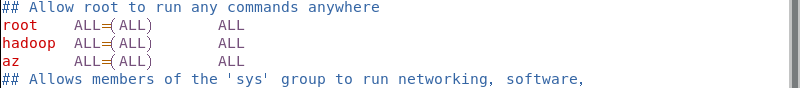

2.设置用户为管理员

2.1 更改/etc/sudoers文件权限

chmod 744 /etc/sudoers

2.2 编辑 /etc/sudoers 文件,加入以下内容:

注意:虽然我设置用户名时输入的大写的AZ,但其实系统默认它为小写,在修改文件时也应该是小写。

az ALL=(ALL) ALL

2.3 切换到AZ用户

su az

3. 修改主机名

3.1 编辑sudo vim /etc/sysconfig/network 文件,介入以下内容

NETWORKING=yes

HOSTNAME=hadoop01

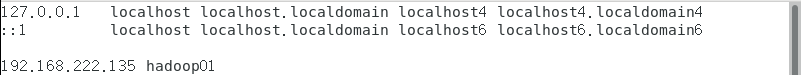

4. 修改主机名和IP的映射关系

4.1 sudo vim /etc/hosts 修改文件内容为,如下图:

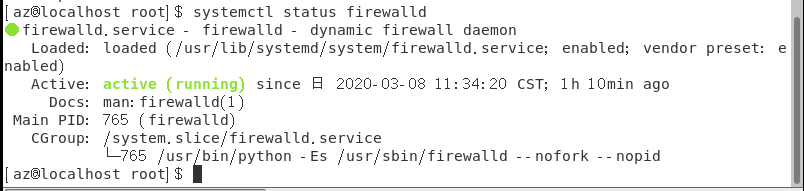

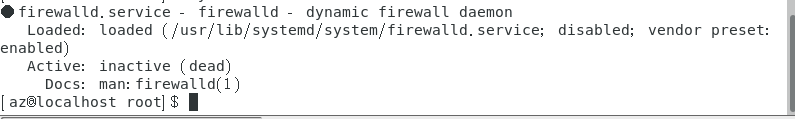

5. 关闭防火墙

5.1 查看防火墙状态

systemctl status firewalld

5.2 关闭防火墙(如果你的防火墙是关着的就不用执行这一步了)

(1)设置停止并不开机启动

sudo systemctl disable firewalld

(2)关闭防火墙

sudo systemctl stop firewalld

(3) 查看状态

systemctl status firewalld

6. 重启Linux

7. 安装JDK,具体见我的另一篇博客:

https://blog.csdn.net/qq_43437122/article/details/104731475

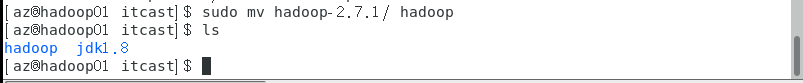

8.安装hadoop(文件自行下载并上传)

8.1 解压文件

sudo tar -zxvf hadoop-2.7.1.tar.gz -C /itcast/

8.2 修改文件名

sudo mv hadoop-2.7.1/ hadoop

9. 配置Hadoop相关文件

进入到hadoop目录下的 /etc/hadoop 目录下。

9.1 修改hadoop-env.sh文件

sudo vim hadoop-env.sh

将以下内容填入到文件中

#在27行修改

export JAVA_HOME=/itcast/jdk1.8

9.2 修改core-site.xml文件

sudo vim core-site.xml

修改前进入/itcast/hadoop目录下即安装目录下创建tmp目录,然后修改下tmp目录权限

sudo chmod -R a+w /itcast/hadoop/tmp

将以下内容填入到文件中

<configuration>

<!-- 指定HDFS老大(namenode)的通信地址 -->

<property>

<name>fs.defaultFS</name>

<!-- 根据自己的主机名填写 -->

<value>hdfs://hadoop01:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储路径 -->

<property>

<name>hadoop.tmp.dir</name>

<!-- 根据自己的安装路径配置,tmp目录提前创建好 -->

<value>/itcast/hadoop/tmp</value>

</property>

</configuration>

9.3 修改hdfs-site.xml文件

sudo vim hdfs-site.xml

将以下内容填入到文件中

<configuration>

<!-- 设置hdfs副本数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

9.4 修改mapred-site.xml文件

mapred-site.xml文件找不到,但是有个mapred-site.xml.template文件,所以我们需要先执行下面的命令将其重命名:

mv mapred-site.xml.template mapred-site.xml

然后再编辑:

sudo vim mapred-site.xml

将以下内容填入到文件中

<configuration>

<!-- 通知框架MR使用YARN -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

9.5 修改yarn-site.xml文件

sudo vim yarn-site.xml

将以下内容填入到文件中

<configuration>

<!-- reducer取数据的方式是mapreduce_shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

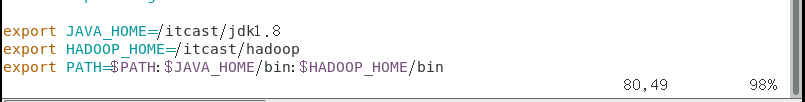

10. 配置hadoop环境变量

10.1 编辑/etc/profile文件

sudo vim /etc/profile

如图所示:

10.2 刷新配置文件

source /etc/profile

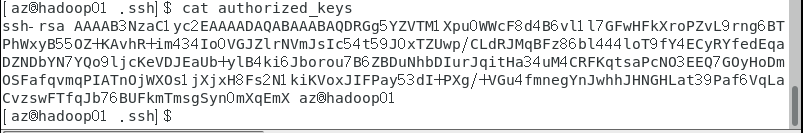

11.配置ssh免登录

11.1 回到主目录 cd ~,然后进入到 .ssh 目录下

cd .ssh

如果没有.ssh目录,先执行下ssh localhost命令

11.2 执行命令:

中间需要一路回车即可。。。

ssh-keygen -t rsa

11.3 将公钥追加入授权文件【authorized_keys】

(1)创建文件authorized_keys

touch authorized_keys

(2)追加内容

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

11.4 .ssh目录权限设置为700

chmod 700 ~/.ssh

11.5 授权文件权限设置为600

chmod 600 ~/.ssh/authorized_keys

12 . 格式化HDFS(namenode)

执行命令:

hadoop namenode -format

如下图就是格式化成功,成功了会有successfully,和Exiting with status 0(如果为1就是格式化失败)提示

13. 启动hadoop

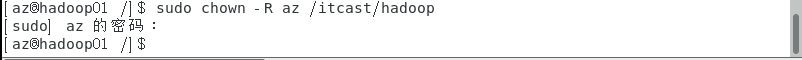

13.1 修改Hadoop安装目录的权限

sudo chown -R 你自己电脑的用户名 /itcast/hadoop

sudo chown -R az /itcast/hadoop

13.2 进入到sbin目录下

cd /itcast/hadoop/sbin/

13.3 执行命令:

./start-all.sh

结果如图:

13.5 jps查看是否启动成功

正常启动进程应该和上图一样,缺少进程的话,可能是配置文件出了问题。

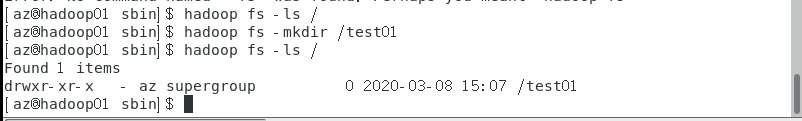

14 . 测试Hadoop

打开浏览器输入localhost:50070查看HDFS的状态

执行命令以下命令在HDFS上创建文件夹test01并查看:

hadoop fs -mkdir /test01

hadoop fs -ls /

到此,伪分布式就搭建成功,大家赶紧去熟悉常用命令吧。