1.下载jdk 可从官网下载最好是rpm版本,如我下载的版本为jdk-8u271-linux-x64.rpm(此处省略)

2.下载hadoop2.6.5 可在https://archive.apache.org/dist/hadoop/common/找到2.6.5版本下载hadoop-2.6.5.tar.gz

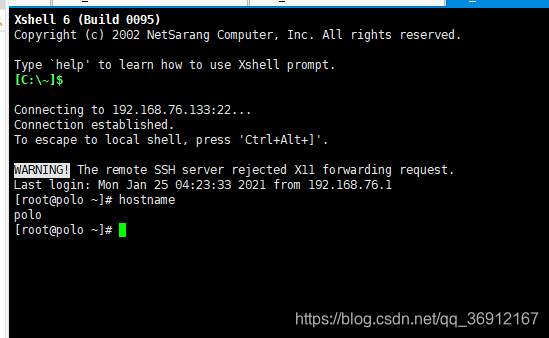

3.使用xshell连接至centos(此处略)

4.使用yum -y install lrzsz命令安装上传下载文件功能。

yum -y install lrzsz

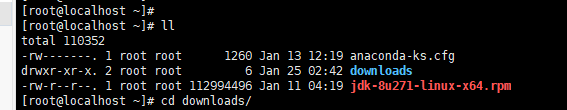

5.用rz命令上传jdk-8u271-linux-x64.rpm和hadoop-2.6.5.tar.gz到centos7,然后用ll命令查看可以看见刚刚上传的文件

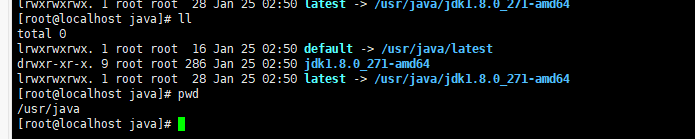

6.安装jdk

rpm -i jdk-8u271-linux-x64.rpm

执行以上命令后文件会被自动安装在/usr/java目录下并且有相应的链接指向这个地址

7.配置java环境

使用命令 vi /etc/profile打开文件按i编辑,到最后一行,输入以下代码

export JAVA_HOME=/usr/java/default

PATH=$PATH:$JAVA_HOME/bin

最后再source /etc/profile一下

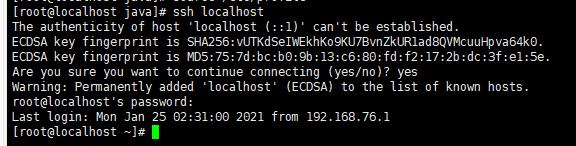

8.ssh免密登陆

首先使用ssh localhost命令测试一下是否可以免密登陆

如图是一种需要密码才能登陆的情况

此时我们需要让他免密登陆

执行 ssh-keygen -t dsa -P ‘’ -f ~/.ssh/id_dsa命令会生成一些文件,使用cd命令打开.ssh文件夹

ll命令查看

接着执行cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys可以将id_dsa.pub的内容赋给authorized_keys

然后ssh localhost命令可以看到可以免密登陆了

9.解压hadoop安装包

mkdir -p /opt/bigdata

tar xf hadoop-2.6.5.tar.gz -C /opt/bigdata/

10.配置hadoop环境变量

vi /etc/profile

//在JAVA_HOME下面加上export HADOOP_HOME=/opt/bigdata/hadoop-2.6.5

//在PATH后面追加:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

//如下:

export HADOOP_HOME=/opt/bigdata/hadoop-2.6.5

PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

然后source /etc/profile

11.修改hadoop的java环境变量

cd $HADOOP_HOME/etc/hadoop

vi hadoop-env.sh

vi mapred-env.sh

vi yarn-env.sh

在上面三个文件的最后一行加上export JAVA_HOME=/usr/java/default

export JAVA_HOME=/usr/java/default

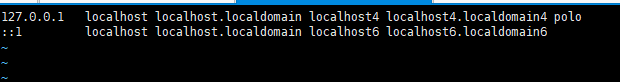

12.修改当前机器名称(centos7)

hostnamectl set-hostname centos77.magedu.com # 使用这个命令会立即生效且重启也生效

hostname # 查看下

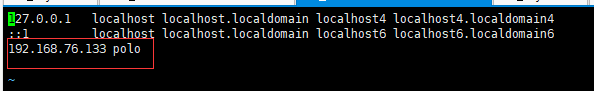

vi /etc/hosts # 编辑下hosts文件, 给127.0.0.1添加hostname如polo

再次重新连接服务器时会发现服务器名称已变

13.若想让idea等开发工具能连上hadoop,还需修改/etc/hosts文件

a.使用ifconfig -a 查看你的ip(此处ip为内网ip 不是外网ip使用此命令即可查看你的内网ip)

b.vi /etc/hosts,在最后加上你刚刚记录的内网ip和你之前修改的主机名

14.配置core-site.xml

vi core-site.xml在中添加

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop-1:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/var/ycyz/hadoop/local</value>

</property>

15.配置hdfs-site.xml

vi hdfs-site.xml 在configuration里面添加

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/var/bigdata/hadoop/local/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/var/bigdata/hadoop/local/dfs/data</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>polo:50090</value>

</property>

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>/var/bigdata/hadoop/local/dfs/secondary</value>

</property>

16.配置slaves文件

在文件里只写polo(前面改的主机名)

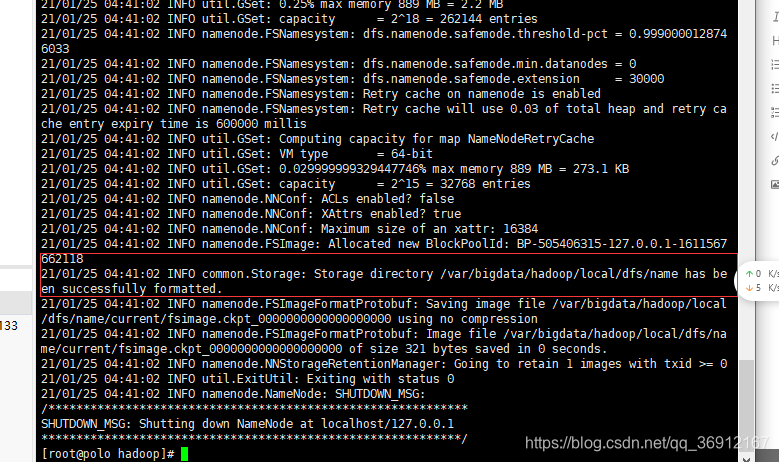

17.格式化hdfs

hdfs namenode -format(只能格式化一次 再次启动无须格式化)

看到下面圈出的内容代表格式化成功。。。 has been successfully formatted

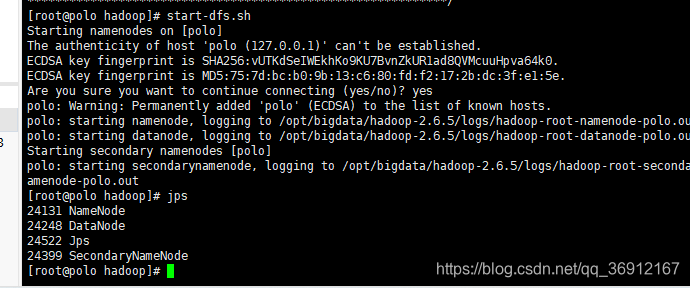

18.启动hdfs

start-dfs.sh

启动成功后然后输入jps命令查看是否启动成功若有namenode datanode secondarynamenode即为启动成功

19.关闭防火墙

service firewalld stop

备注:查看web ui为你的ip加50070端口 如 192.168.76.133:50070