1.前言

Tensorflow 是非常重视结构的, 我们得建立好了神经网络的结构, 才能将数字放进去, 运行这个结构.

2.导入模块并创建数据

首先, 我们这次需要加载 tensorflow 和 numpy 两个模块, 并且使用 numpy 来创建我们的数据.

import tensorflow as tf

import numpy as np

x_data = np.random.rand(100).astype(np.float32) #随机样本位于[0, 1)中

y_data = x_data*0.5 + 2

3.构建模型

我们用 tf.Variable 来创建描述 y 的参数. 我们可以把 y_data = x_data*0.1 + 0.3 想象成 y=Weights * x + biases, 然后神经网络也就是学着把 Weights 变成 0.1, biases 变成 0.3.

Weights = tf.Variable(tf.random_uniform([1],-1.0,1.0)) #返回一维数组,产生于low和high之间,产生的值是均匀分布的 #tf.Variable()用于生成一个初始值为initial-value的变量;必须指定初始化值

biases = tf.Variable(tf.zeros([1]))

y = Weights*x_data + biases

4.计算误差与误差的反向传递

接着就是计算 y 和 y_data 的误差,反向传递误差的工作就教给optimizer了, 我们使用的误差传递方法是梯度下降法: Gradient Descent 让后我们使用 optimizer 来进行参数的更新。

loss = tf.reduce_mean(tf.square(y-y_data)) #tf.reduce_mean用于计算张量tensor沿着指定的数轴(tensor的某一维度)上的的平均值

optimizer = tf.train.GradientDescentOptimizer(0.5)

train = optimizer.minimize(loss)

5.训练模型

我们只是建立了神经网络的结构, 还没有使用这个结构. 在使用这个结构之前, 我们必须先初始化所有之前定义的Variable, 所以这一步是很重要

init = tf.global_variables_initializer() #返回一个用来初始化计算图中所有global variable的op

接着,我们再创建会话 Session. 我们用 Session 来执行 init 初始化步骤. 并且, 用 Session 来 run 每一次 training 的数据. 逐步提升神经网络的预测准确性.

sess = tf.Session() #创建一个会话

sess.run(init) #用 Session 来执行 init 初始化

for step in range(301): #定义300次迭代

sess.run(train)

if step%20 == 0: #每隔20次打印一次权重和偏置

print(step, sess.run(Weights),sess.run(biases))

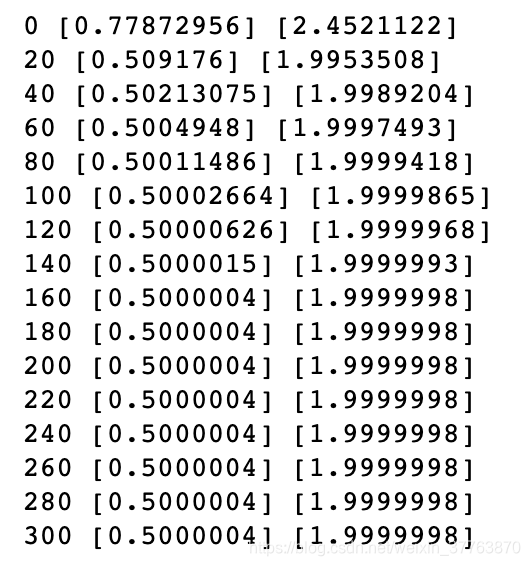

可见,最后的权重和偏置非常接近于y_data = x_data*0.5 + 2的权重和偏置。