9.1 聚类任务

聚类试图将数据集中的样本划分为若干个通常不想交的子集,每个子集称为一个簇。

9.2 性能度量

聚类性能度量大致两类:外部指标、内部指标

外部指标:将聚类结果与某个“参考模型”进行比较

内部指标:考察聚类结果 而不利用任何参考模型

外部指标:

聚类给出的簇划分:

![]()

参考模型给出的簇划分:

![]()

相应的簇标记向量为λ,λ*

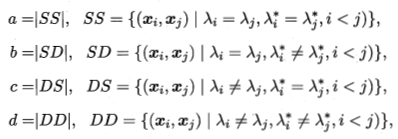

SS包含了在C中隶属于相同簇且在C*中也隶属于相同簇的样本对;a+b+c+d=m(m-1)/2

于是导出下面常用的聚类性能度量外部指标,值在[0,1],越大越好

Jaccard系数,JC:

![]()

FM指数,FMI:

![]()

Rand指数,RI:

![]()

内部指标:

对于聚类结果簇划分![]()

于是导出下面常用的聚类性能度量内部指标,DBI越小越好,DI越大越好

DB指数,DBI:

![]()

Dunn指数,DI:

![]()

9.3 距离计算

距离度量函数 dist(·,·),需满足:

非负性 :![]()

同一性:![]() ,当且仅当

,当且仅当 ![]()

对称性:![]()

直递性: ![]()

给定样本![]()

闵可夫斯基距离:

![]()

p=2时是欧氏距离

p=1时是曼哈顿距离

闵可夫斯基距离可用于计算连续属性和有序属性

无序属性用VDM,属性u上两个离散值a,b之间的VDM距离为

![]() ,

,![]() 表示第i个样本簇中在属性u上取值为a的样本数

表示第i个样本簇中在属性u上取值为a的样本数

于是,假设有![]() 个有序属性,

个有序属性, ![]() 个无序属性

个无序属性

![]()

加权距离

![]()

9.4 原型聚类

亦称“基于原型的聚类”,此类算法假设聚类结构能通过一组原型刻画。“原型”是指样本空间中具有代表性的点

一般,先对原型初始化,然后对原型进行迭代更新求解

K-means

针对聚类所得簇划分 ![]() 最小化平方误差:

最小化平方误差:

![]()

学习向量量化(LVQ)

和K均值类似,都是试图找出一组原型向量来刻画聚类结构,但是假设数据样本带有类别标记,学习过程利用样本的这些监督信息来辅助聚类。

关键是如何更新原型向量,对样本Xj,若最近的原型向量Pi, 与Xj的类别标记相同,则令Pi向Xj的方向靠拢。

学得一组原型向量{P1,P2,……Pq}后,即可实现对样本空间X的簇划分。对任意样本x,它将被划入到与其距离最近的原型向量所代表的簇中;换言之,每个原型向量Pi定义了与之相关的一个区域Ri,该区域中每个样本与P 的距离不大于它与其他原型向量Pi '的距离。

高斯混合聚类

采用概率模型来表达聚类原型

多元高斯分布定义:

![]()

记为:![]()

高斯混合分布:

![]()

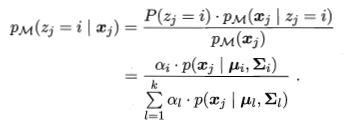

假设样本生成过程由高斯混合分布给出:首先,根据![]() 定义的先验分布选择高斯混合成分,其中

定义的先验分布选择高斯混合成分,其中![]() 为选择第i个成分的概率;然后,根据被选择的混合成分的概率密度函数进行采样,从而生成相应的样本

为选择第i个成分的概率;然后,根据被选择的混合成分的概率密度函数进行采样,从而生成相应的样本

极大似然估计:

也就是,假定每个簇都服从高斯分布,每个簇按各自的分布生成样本,所有样本独立,所有样本放在一起对应的是高斯混合分布

9.5 密度聚类

亦称“基于密度的聚类”,此类算法假设聚类结构能通过样本分布的紧密程度确定。通常,密度聚类算法从样本密度的角度来考察样本之间的可连续性,并基于可连接样本不断扩展聚类簇以获得最终的聚类结果。

DBSCAN,基于一组“邻域”参数刻画样本分布的紧密程度。

ε-邻域: ![]()

核心对象:![]() ,

,![]() 的ε-邻域内至少包含MinPts个样本,则

的ε-邻域内至少包含MinPts个样本,则![]() 是一个核心对象

是一个核心对象

密度直达:![]() 位于

位于![]() 的ε-邻域中且是核心对象,则

的ε-邻域中且是核心对象,则![]() 由

由![]() 密度直达

密度直达

密度可达:对于![]() 与

与![]() ,存在序列

,存在序列![]() ,

,![]() =

=![]() ,

, ![]() =

=![]() ,

, ![]() 由

由![]() 密度直达,则

密度直达,则![]() 由

由![]() 密度可达

密度可达

密度相连:对于![]() 与

与![]() ,若存在

,若存在![]() ,使

,使![]() 与

与![]() 均由

均由![]() 密度可达,则称

密度可达,则称![]() 与

与![]() 密度相连

密度相连

DBSCAN将簇定义为:由密度可达关系导出的最大的密度相连样本集合。

算法先根据给定的邻域参数(ε,MinPts)找出所有核心对象,再以任一核心对象为出发点,找出由其密度可达样本生成聚类簇,知道所有核心对象都被访问过为止

9.6 层次聚类

系统聚类,“自顶向下”,“自底向上”

其他:K均值算法可看作高斯混合聚类在混合成分方差相等、且每个样本仅指派给一个混合成分时的特例