题外话:

最近投了一篇PR,行人重识别方向,主要研究摄像头视角变化对Re-ID的影响。在改论文的过程中,编辑推荐了两篇相关的文章,也是研究类似的问题。不得不说的是,在修改参考文献格式的时候,用到了Mendeley。将期刊参考文献的模板数据下载并导入后,该软件可以自动修改参考文献的格式。一些知名期刊甚至可以使用Mendeley直接导入相应格式数据。很巧的是,在收到编辑推荐的两篇论文后,Mendeley根据我所引用的文献,也给我推荐了一篇论文。这篇论文和前述的两篇论文几乎研究的是同一内容。在这里强烈吹一波AI的推荐系统。

先附上三篇论文:

Person Transfer GAN to Bridge Domain Gap for Person Re-Identification

链接:https://arxiv.org/pdf/1711.08565.pdf

Camera Style Adaptation for Person Re-identification

链接:https://arxiv.org/pdf/1711.10295v1.pdf

Image-Image Domain Adaptation with Preserved Self-Similarity and

Domain-Dissimilarity for Person Re-identification

链接:https://arxiv.org/pdf/1711.07027.pdf

行人重识别有一个很重要的问题,就是当数据类型或者风格变化后,对识别的准确度会产生严重的影响。这个变化可以是数据库的变化,摄像头视角的变化等。比如下面两张图,分别展示数据库变化和摄像头视角变化的影响。红色框表示不是同一个人,绿色框表示是同一个人。c代表摄像头编号。

这三篇文章都是解决以上问题,所以放在了同一篇博文中。接下来,分别来看一下:

Person Transfer GAN to Bridge Domain Gap for Person Re-Identification

主要有两个贡献:

①创建了MSMT17数据库,包含了室内外场景、15个摄像头、四天的时间跨度。总而言之是目前最大、最全面的行人重识别数据库。

②提出了用于做数据库风格迁移的PTGAN(Person Transfer GAN)。

主要说一下PTGAN:

- 作用是数据库风格迁移,如下图。第一行是duke数据库,二三行是duke迁移为market数据库风格。

-

框架是cyclegan,加入了一个损失函数进行约束。损失函数的意义是保证风格迁移过后,行人的label不受影响。可能有点难理解:张三在校园的图像,迁移成菜市场风格后,还要保留张三的主要特征,不能让他变得更像李四。这样原有的张三的label就可以被应用于风格迁移后的新数据库。

扫描二维码关注公众号,回复: 10618443 查看本文章

扫描二维码关注公众号,回复: 10618443 查看本文章

-

损失函数介绍

a和b分别表示源域和目标域的图像,两者不需要成对,也不可能成对,因为源域和目标域没有相同的人,M表示使用图像生成前景的分割模板(利用PSPNet) G和加线的G是cyclegan的两个生成器,忘记cyclegan的小伙伴参考:https://blog.csdn.net/weixin_39417323/article/details/89381113

利用这个公式就可以对上一点中提到的内容进行约束了。

效果图:

Image-Image Domain Adaptation with Preserved Self-Similarity and Domain-Dissimilarity for Person Re-identification

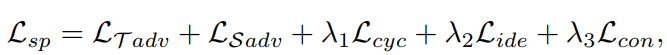

这篇文章做了同样的事情,与PTGAN不同,这篇文章提出了SPGAN(similarity preserving GAN)。其损失函数如下:

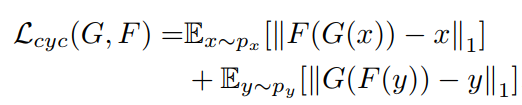

其中,前三项依旧是传统的cyclegan。

第四项:

可能第一眼觉得就是循环一致损失,其实不然。对比一下:

不加第四项就会产生颜色的不真实,如下所示:

a原图,b直接用cyclegan,c加了第四项,d加了第四、五项。

至于为什么,我觉得作者自己也不知道。

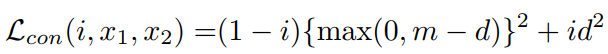

第五项:

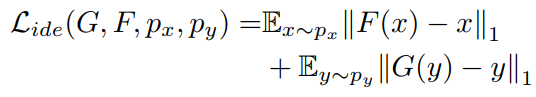

使用孪生网络进行约束,i=1是正样本对,i=0是负样本对。d是样本对特征向量的欧式距离。这一项的意义和上一篇文章中的LID相同。

另外,有一个看似鸡肋,实则还挺有效果的创新点:

池化前先分块,然后再concat,分成7块最好,图示是分为两块。

Camera Style Adaptation for Person Re-identification

以上两篇主要是数据库之间的domain adaptation。这篇文章是同一数据库中不同摄像头的迁移。

读懂了上面两个,这个就很容易理解了。作者直接使用了cyclegan,并没有做什么改进。比如market1501数据库,有6个摄像头。那么要训练15个cyclegan(从6个里挑2个,排列组合),就可以实现camera1->camera2、camera1->camera3…的30种迁移。(刚开始我还在想为什么不是30个。因为训练好了1->2的cyclegan,G可以1->2,那么F就可以2->1了,我太蠢了)。最后,因为生成的样本不可能完美,所以使用了标签平滑LSR对其置信度进行弱化。另外,训练时,真样本和假样本的比例控制在3:1左右比较好。

总结:

如果前两篇文章是为了利用有标签数据库训练无标签场景下的识别模型,那么最后一篇文章是为了将有标签的数据库扩充到极致,增加数据数量,缓解过拟合,同时也缓解摄像头角度变化带来的负面影响。

GAN大法好,其热度犹存,还是要抓紧蹭一波的。

完

欢迎讨论 欢迎吐槽