CNN卷积网络

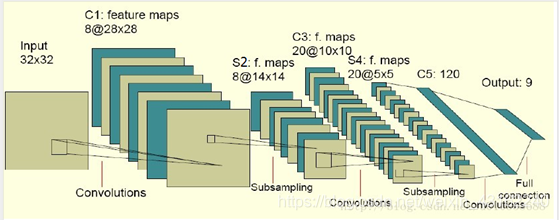

CNN卷积网络的结构

输入层: 输入层是32×32 RGB图像。

注:有必要计算每一层输出的图片大小。

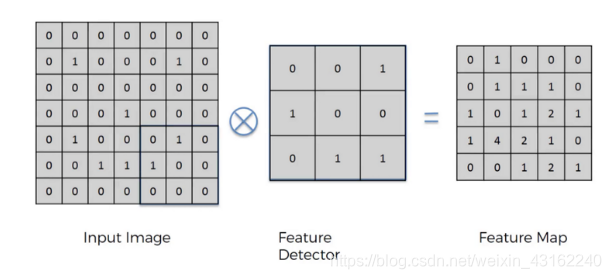

卷积层: 卷积层的核心在于卷积核与激活函数。

卷积层最主要的作用是寻找与卷积核匹配的特征,因为与卷积核符合(卷积核权重较大的位置)的话,卷积后该区域的值也就越大,也就是说,feature map的值越大,表示该处特征越明显。

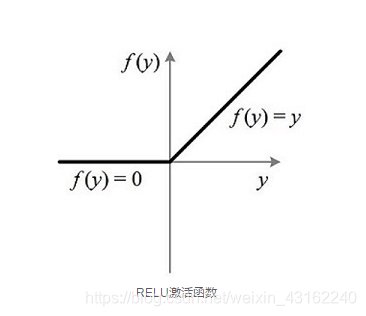

激活函数的作用是使模型具有非线性性。缺少激活函数的模型是一个线性模型,这样无法模拟任意函数,模型的各层与一个线性函数的效果是一样的。

激活函数一般选择sigmoid, tanh, relu函数。(深层网络选用relu较多,因为relu可以将部分神经元的输出置0,造成网络的稀疏性,可以缓解过拟合的问题)

pool层:

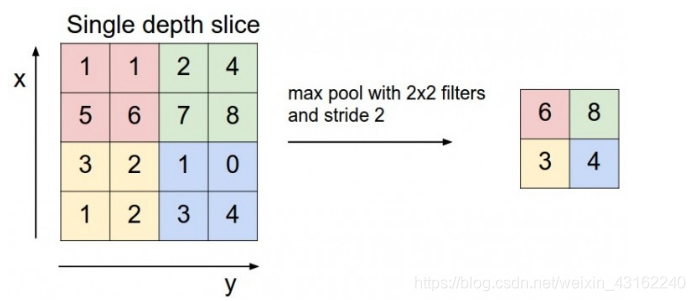

池化层(也叫下采样层)一般用maxpool。

池化层的作用在于提取重要特征,忽视较小的特征(前面卷积可以通过数字大小决定与特征的符合程度),大幅降低权重参数,减小计算成本。

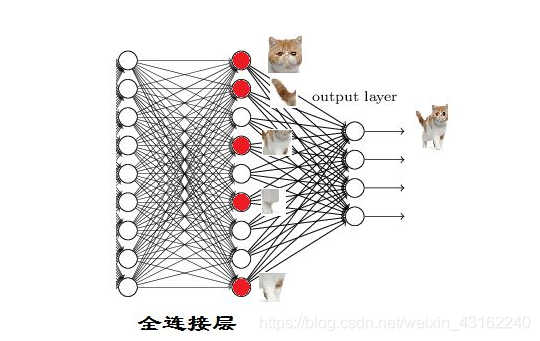

全连接层:

全连接层(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用。与池化和卷积不同,它是全局操作,它从前一层获取输入,并全局分析所有前一层的输出。然后将所有特征进行各种可能的组合,用于数据分类。

先将上一层卷积层的输出展平,扩展成1通道的向量X,然后再对这个向量通过权重W变到Y = W*X, 然后用激活函数非线性化, 经过几个这样的全连接层后,最后一层输出为各个类别的概率.

CNN的每一层都有什么作用?

卷积层: 关注局部,参数共享,作用是检测特征。

激活层: 对卷积层经过线性运算的结果赋予非线性特征,否则深度学习的层数没有实际意义。

池化层: 提取重要特征,忽视较小的特征(前面卷积可以通过数字大小决定与特征的符合程度),大幅降低权重参数,减小计算成本。

dropout层: 训练后,神经网络的权重与训练样本太过匹配,导致对测试集的效果不好,即过拟合。dropout层是为了解决过拟合的问题。

参考资料:

[1]relu函数的意义https://blog.csdn.net/wangkun1340378/article/details/74517252

[2]maxpool的意义https://blog.csdn.net/pangjiuzala/article/details/71840947

[3]全连接层https://blog.csdn.net/weixin_41055137/article/details/81174443