优化算法进阶

11.6 Momentum

在 Section 11.4 中,我们提到,目标函数有关自变量的梯度代表了目标函数在自变量当前位置下降最快的方向。因此,梯度下降也叫作最陡下降(steepest descent)。在每次迭代中,梯度下降根据自变量当前位置,沿着当前位置的梯度更新自变量。然而,如果自变量的迭代方向仅仅取决于自变量当前位置,这可能会带来一些问题。对于noisy gradient,我们需要谨慎的选取学习率和batch size, 来控制梯度方差和收敛的结果。

%matplotlib inline

import sys

sys.path.append("/home/kesci/input")

import d2lzh1981 as d2l

import torch

eta = 0.4

def f_2d(x1, x2):

return 0.1 * x1 ** 2 + 2 * x2 ** 2

def gd_2d(x1, x2, s1, s2):

return (x1 - eta * 0.2 * x1, x2 - eta * 4 * x2, 0, 0)

d2l.show_trace_2d(f_2d, d2l.train_2d(gd_2d))

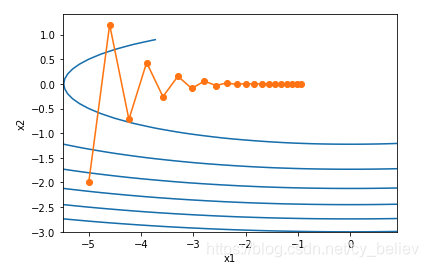

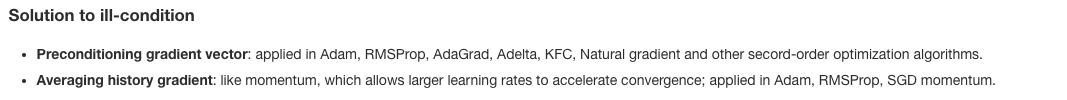

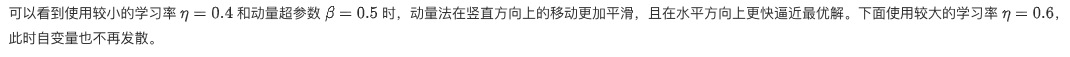

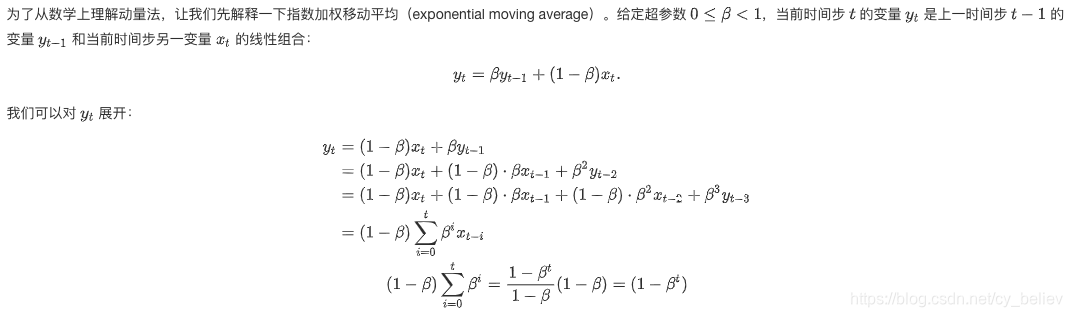

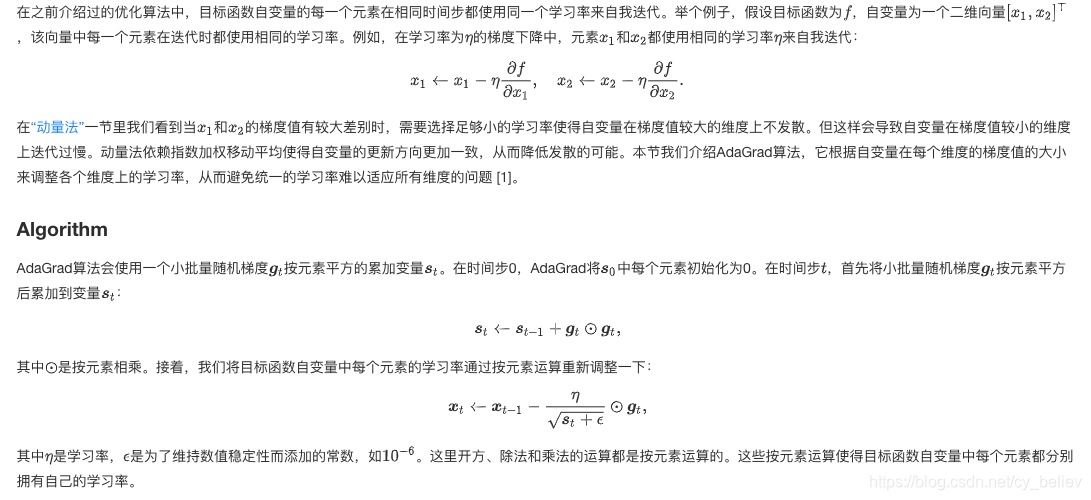

可以看到,同一位置上,目标函数在竖直方向(轴方向)比在水平方向(轴方向)的斜率的绝对值更大。因此,给定学习率,梯度下降迭代自变量时会使自变量在竖直方向比在水平方向移动幅度更大。那么,我们需要一个较小的学习率从而避免自变量在竖直方向上越过目标函数最优解。然而,这会造成自变量在水平方向上朝最优解移动变慢。

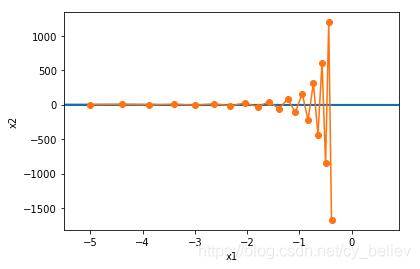

下面我们试着将学习率调得稍大一点,此时自变量在竖直方向不断越过最优解并逐渐发散。

eta = 0.6

d2l.show_trace_2d(f_2d, d2l.train_2d(gd_2d))

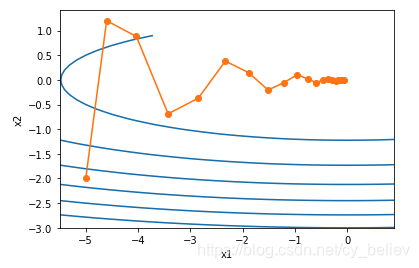

def momentum_2d(x1, x2, v1, v2):

v1 = beta * v1 + eta * 0.2 * x1

v2 = beta * v2 + eta * 4 * x2

return x1 - v1, x2 - v2, v1, v2

eta, beta = 0.4, 0.5

d2l.show_trace_2d(f_2d, d2l.train_2d(momentum_2d))

Exponential Moving Average

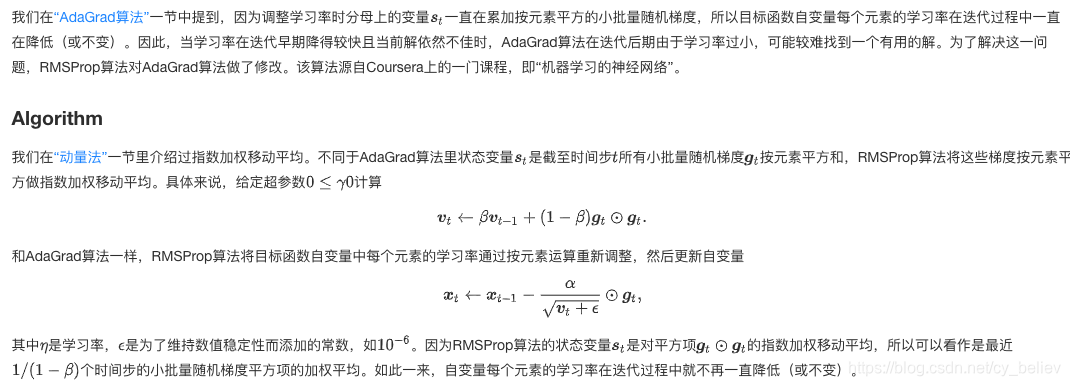

11.7 AdaGrad

11.8 RMSProp

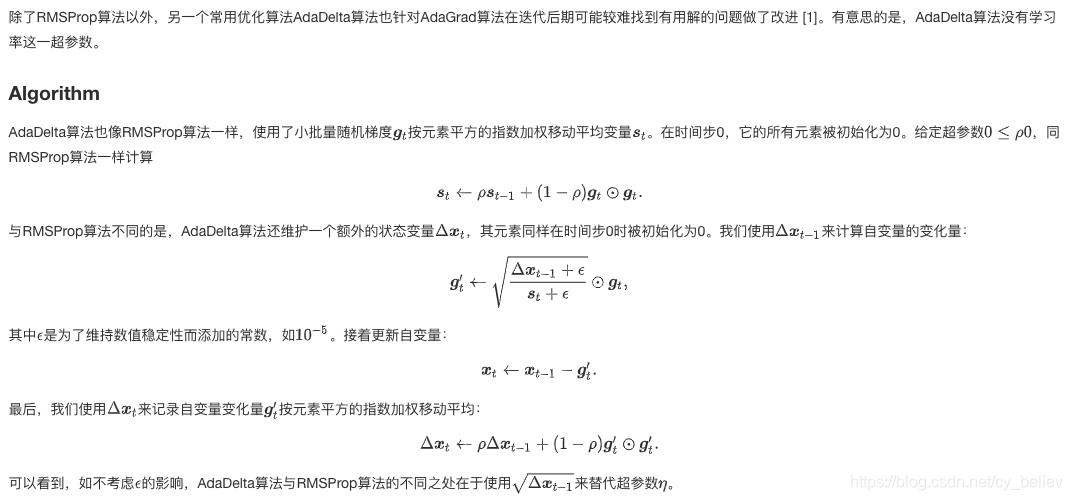

11.9 AdaDelta

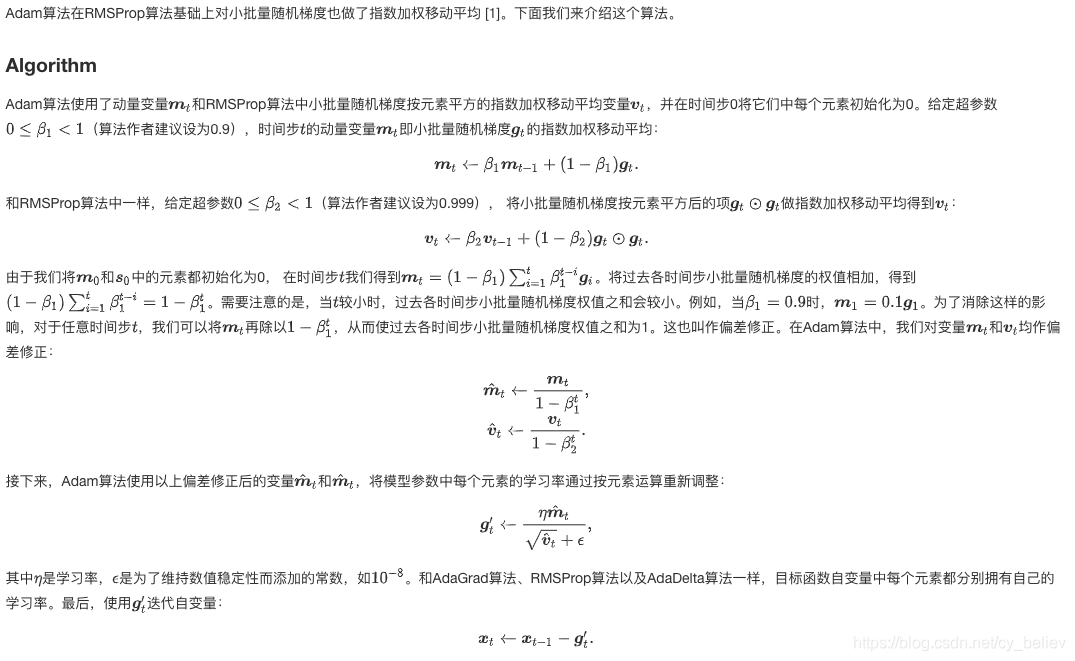

11.10 Adam

word2vec

词嵌入基础

我们在“循环神经网络的从零开始实现”一节中使用 one-hot 向量表示单词,虽然它们构造起来很容易,但通常并不是一个好选择。一个主要的原因是,one-hot 词向量无法准确表达不同词之间的相似度,如我们常常使用的余弦相似度。

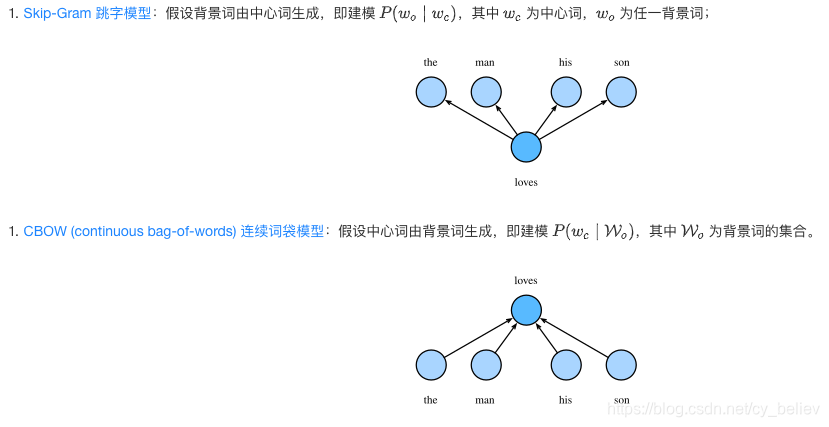

Word2Vec 词嵌入工具的提出正是为了解决上面这个问题,它将每个词表示成一个定长的向量,并通过在语料库上的预训练使得这些向量能较好地表达不同词之间的相似和类比关系,以引入一定的语义信息。基于两种概率模型的假设,我们可以定义两种 Word2Vec 模型:

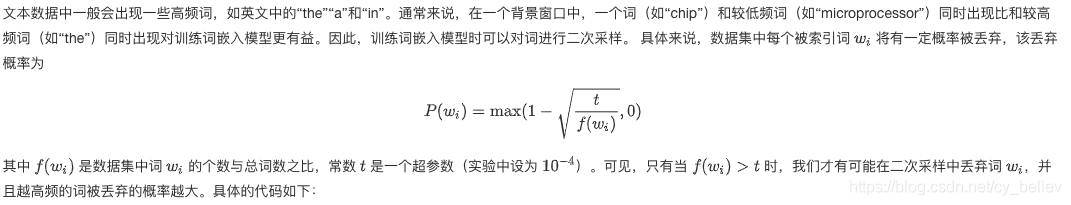

二次采样

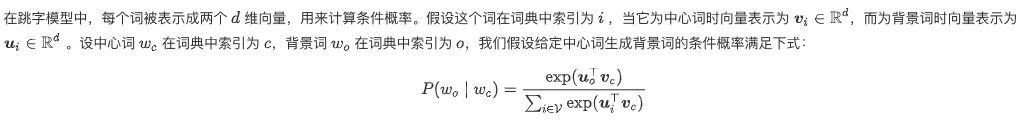

Skip-Gram 跳字模型

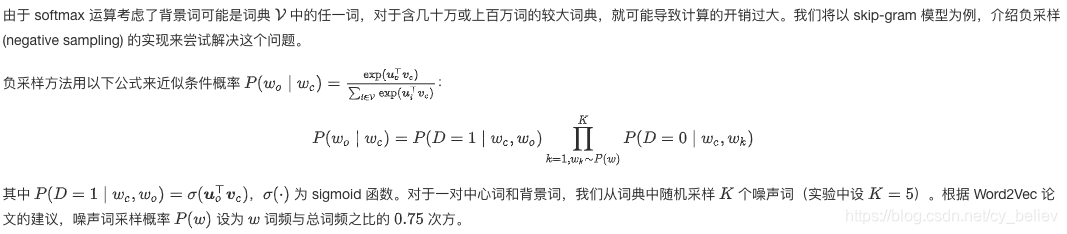

负采样近似

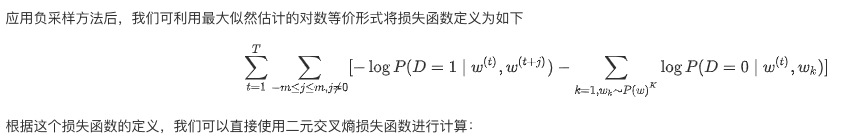

损失函数

词嵌入进阶

在“Word2Vec的实现”一节中,我们在小规模数据集上训练了一个 Word2Vec 词嵌入模型,并通过词向量的余弦相似度搜索近义词。虽然 Word2Vec 已经能够成功地将离散的单词转换为连续的词向量,并能一定程度上地保存词与词之间的近似关系,但 Word2Vec 模型仍不是完美的,它还可以被进一步地改进:

子词嵌入(subword embedding):FastText 以固定大小的 n-gram 形式将单词更细致地表示为了子词的集合,而 BPE (byte pair encoding) 算法则能根据语料库的统计信息,自动且动态地生成高频子词的集合;

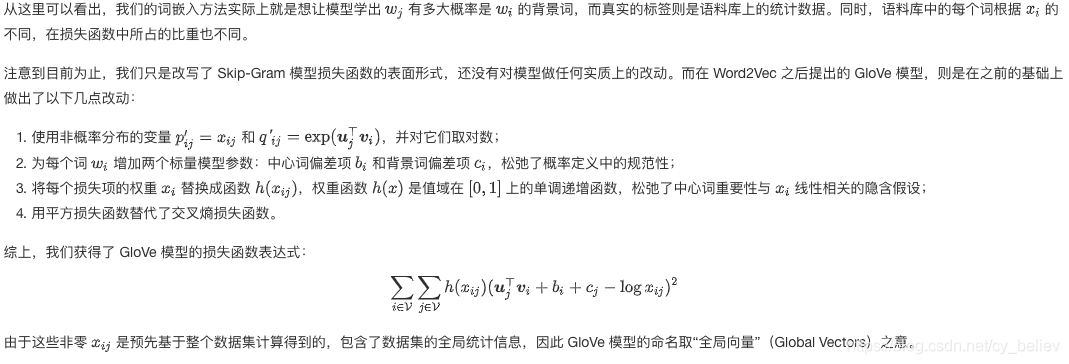

GloVe 全局向量的词嵌入: 通过等价转换 Word2Vec 模型的条件概率公式,我们可以得到一个全局的损失函数表达,并在此基础上进一步优化模型。

实际中,我们常常在大规模的语料上训练这些词嵌入模型,并将预训练得到的词向量应用到下游的自然语言处理任务中。本节就将以 GloVe 模型为例,演示如何用预训练好的词向量来求近义词和类比词。

GloVe 全局向量的词嵌入

GloVe 模型

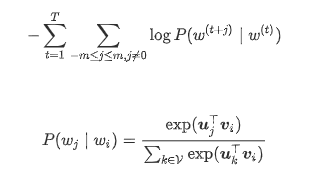

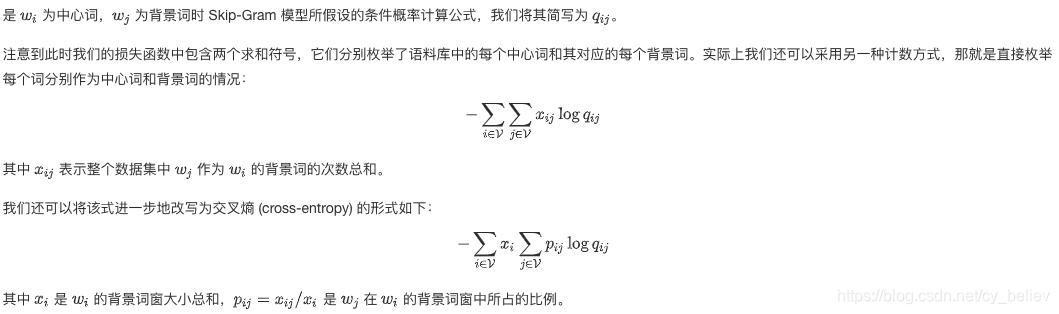

先简单回顾以下 Word2Vec 的损失函数(以 Skip-Gram 模型为例,不考虑负采样近似):

载入预训练的 GloVe 向量

GloVe 官方 提供了多种规格的预训练词向量,语料库分别采用了维基百科、CommonCrawl和推特等,语料库中词语总数也涵盖了从60亿到8,400亿的不同规模,同时还提供了多种词向量维度供下游模型使用。

torchtext.vocab 中已经支持了 GloVe, FastText, CharNGram 等常用的预训练词向量,我们可以通过声明 torchtext.vocab.GloVe 类的实例来加载预训练好的 GloVe 词向量。

import torch

import torchtext.vocab as vocab

print([key for key in vocab.pretrained_aliases.keys() if "glove" in key])

cache_dir = "/home/kesci/input/GloVe6B5429"

glove = vocab.GloVe(name='6B', dim=50, cache=cache_dir)

print("一共包含%d个词。" % len(glove.stoi))

print(glove.stoi['beautiful'], glove.itos[3366])

求近义词和类比词

求近义词

由于词向量空间中的余弦相似性可以衡量词语含义的相似性(为什么?),我们可以通过寻找空间中的 k 近邻,来查询单词的近义词。

def knn(W, x, k):

'''

@params:

W: 所有向量的集合

x: 给定向量

k: 查询的数量

@outputs:

topk: 余弦相似性最大k个的下标

[...]: 余弦相似度

'''

cos = torch.matmul(W, x.view((-1,))) / (

(torch.sum(W * W, dim=1) + 1e-9).sqrt() * torch.sum(x * x).sqrt())

_, topk = torch.topk(cos, k=k)

topk = topk.cpu().numpy()

return topk, [cos[i].item() for i in topk]

def get_similar_tokens(query_token, k, embed):

'''

@params:

query_token: 给定的单词

k: 所需近义词的个数

embed: 预训练词向量

'''

topk, cos = knn(embed.vectors,

embed.vectors[embed.stoi[query_token]], k+1)

for i, c in zip(topk[1:], cos[1:]): # 除去输入词

print('cosine sim=%.3f: %s' % (c, (embed.itos[i])))

get_similar_tokens('chip', 3, glove)

get_similar_tokens('baby', 3, glove)

get_similar_tokens('baby', 3, glove)

get_similar_tokens('beautiful', 3, glove)

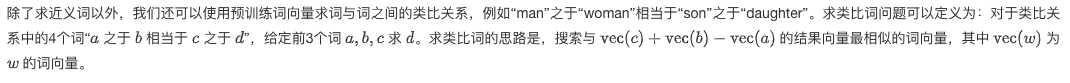

求类比词

def get_analogy(token_a, token_b, token_c, embed):

'''

@params:

token_a: 词a

token_b: 词b

token_c: 词c

embed: 预训练词向量

@outputs:

res: 类比词d

'''

vecs = [embed.vectors[embed.stoi[t]]

for t in [token_a, token_b, token_c]]

x = vecs[1] - vecs[0] + vecs[2]

topk, cos = knn(embed.vectors, x, 1)

res = embed.itos[topk[0]]

return res

get_analogy('man', 'woman', 'son', glove)

‘daughter’

get_analogy('beijing', 'china', 'tokyo', glove)

‘japan’

get_analogy('bad', 'worst', 'big', glove)

‘biggest’

get_analogy('do', 'did', 'go', glove)

‘went’