一、原理详解

与简单线性回归区别(simple linear regression)

多个自变量(x)多元回归模型

y=β0+β1x1+β2x2+ … +βpxp+ε

其中:β0,β1,β2… βp是参数

ε是误差值多元回归方程

E(y)=β0+β1x1+β2x2+ … +βpxp估计多元回归方程:

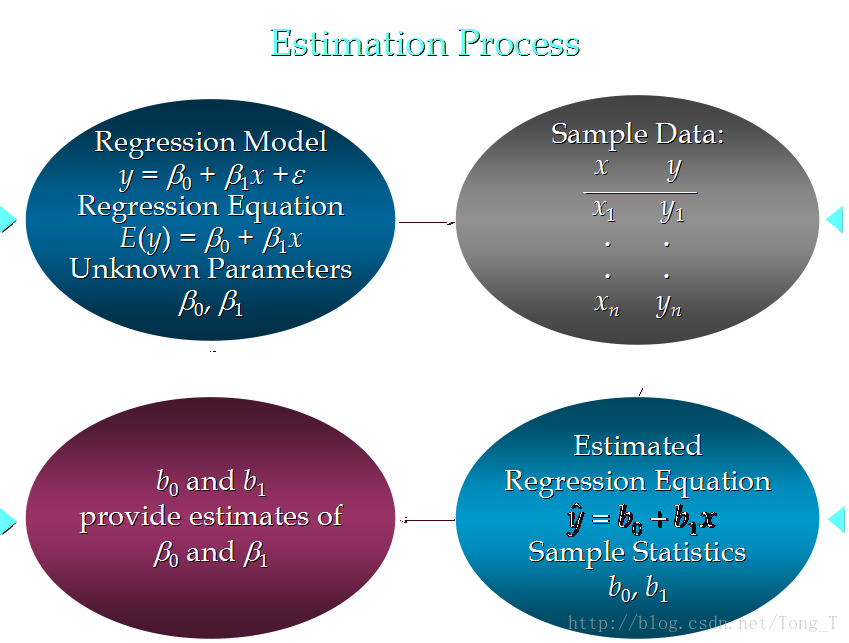

y_hat=b0+b1x1+b2x2+ … +bpxp一个样本被用来计算β0,β1,β2… βp的点估计b0, b1, b2,…, bp

估计流程 (与简单线性回归类似)

估计方法

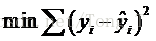

使sum of squares最小

运算与简单线性回归类似,涉及到线性代数和矩阵代数的运算例子

一家快递公司送货:X1: 运输里程 X2: 运输次数 Y:总运输时间

Time = b0+ b1*Miles + b2 * Deliveries

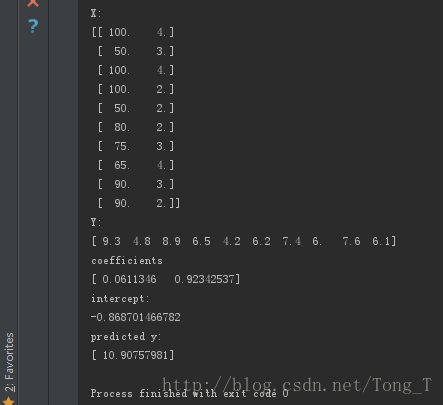

Time = -0.869 + 0.0611 Miles + 0.923 Deliveries描述参数含义

b0: 平均每多运送一英里,运输时间延长0.0611 小时

b1: 平均每多一次运输,运输时间延长 0.923 小时预测

如果一个运输任务是跑102英里,运输6次,预计多少小时?

Time = -0.869 +0.0611 102+ 0.923 6

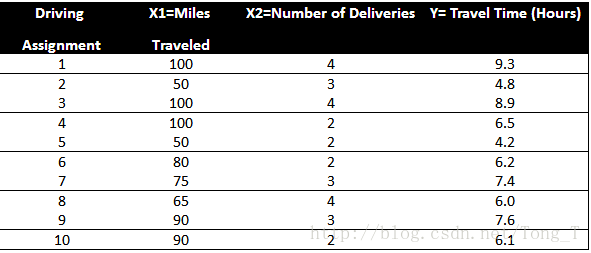

= 10.9 (小时)如果自变量中有分类型变量(categorical data) , 如何处理?

使用ont-hot的编码方式,将分类型变量转化为0,1的形式。关于误差的分布

误差ε是一个随机变量,均值为0

ε的方差对于所有的自变量来说相等

所有ε的值是独立的

ε满足正态分布,并且通过β0+β1x1+β2x2+ … +βpxp反映y的期望值

二、代码实现

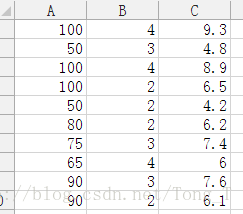

任务依然是上面的例子实现,保存一个csv文件显示为:

from numpy import genfromtxt

from sklearn import linear_model

import numpy as np

dataPath = r"delivery_analyze.csv"

deliveryData = genfromtxt(dataPath, delimiter=',')

print("data")

print(deliveryData)

X = deliveryData[:, :-1]

Y = deliveryData[:, -1]

print("X:")

print(X)

print("Y: ")

print(Y)

regr = linear_model.LinearRegression()

regr.fit(X, Y)

print("coefficients")

print(regr.coef_)

print("intercept: ")

print(regr.intercept_)

xPred = [102, 6]

yPred = regr.predict(np.array(xPred).reshape(1, -1))

print("predicted y: ")

print(yPred)