EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

前言

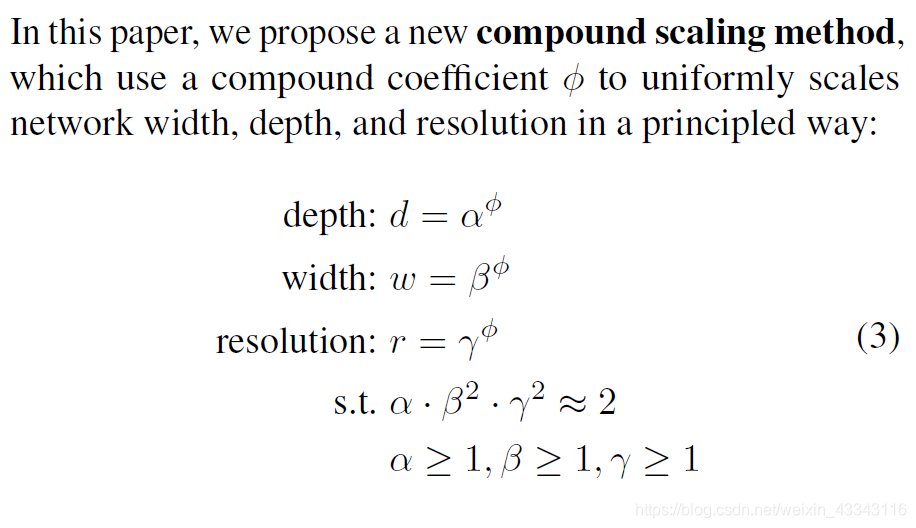

我们在设计一个网络的时候会考虑到网络的深度、宽度、输入图片的分辨率,人们常常将网络加深和加宽,或者是增加输入图片的分辨率来改进准确度。如ResNet can be scaled up from ResNet-18 to ResNet-200 by increasing the number of layers,事实上,人们一般通过单一的增加这三个维度中的一个维度(这里的维度是指depth、width and resolution)来提高网络的性能,但是这并不是最优解。所以产生了一个问题到底怎样的depth、width、resolution的搭配才是最优的,这篇论文就是解决这样的一个问题,所使用的方法叫做Compound Model Scaling(复合缩放)。

对以上公式的解释:

- 都是需要通过网格搜索得到的变量(grid search)

- 是根据自己的计算资源人为给定

相比于传统的模型缩放方法,该复合缩放方法可持续改善模型的准确率和效率,如 MobileNet 的 ImageNet 准确率提升了 1.4%,ResNet的准确率提升了 0.7%。

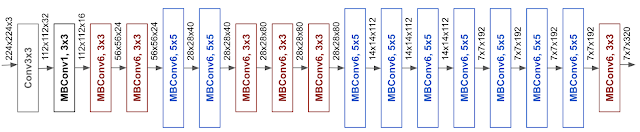

由于网络的性能严重依赖于基线网络的性能,作者使用AutoML MNAS框架进行神经网络架构的搜索以及各种的方法,从而的到了EfficientNets-B0:

效果

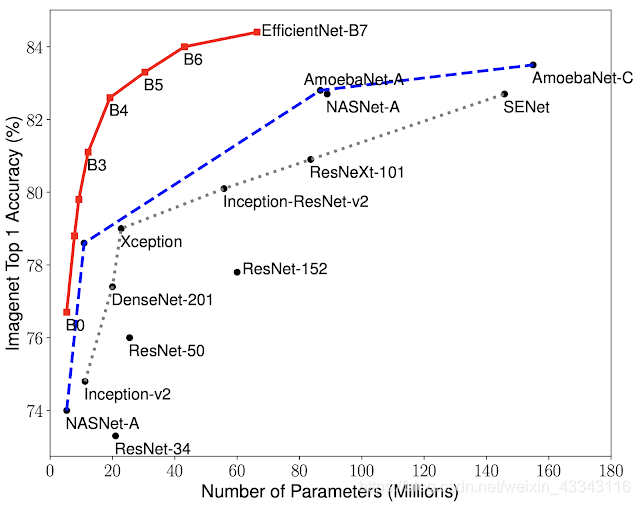

研究人员在 ImageNet 数据集上对比了 EfficientNets 和已有 CNN 模型。EfficientNet 模型要比已有 CNN模型准确率更高、效率更高,其参数量和 FLOPS 都下降了一个数量级。例如,在高准确率的模式中,EfficientNet-B7 在 ImageNet上获得了当前最优的 84.4% top-1 / 97.1% top-5 准确率,CPU 推断速度是 Gpipe 的 6.1 倍,而后者的大小是EfficientNet-B7 的 8.4 倍。与现在广泛使用的 ResNet-50 相比,EfficientNet-B4 使用类似的 FLOPS 取得的top-1 准确率比 ResNet-50 高出 6.3(ResNet-50 76.3%,EfficientNet-B4 82.6%)

EfficientNet-B0 是通过 AutoML MNAS 开发出的基线模型,Efficient-B1 到 B7是扩展基线模型后得到的网络。EfficientNet 显著优于其他 CNN。具体来说,EfficientNet-B7 取得了新的 SOTA 结果:84.4%top-1 / 97.1% top-5 准确率,且其大小远远小于之前的最优 CNN 模型 GPipe (后者的模型大小是 EfficientNet-B7 的8.4 倍),速度是 GPipe 的 6.1 倍。EfficientNet-B1 的参数量远远小于 ResNet-152,但速度是后者的 5.7 倍。

对我们的帮助

由于此方法需要大量的计算资源,并不适合个人来做,但是当我们在使用以前的backbone时,可以考使用开源好的EfficientNets的网络来直接作为backbone

参考:

https://www.chainnews.com/articles/200576776583.htm

https://ai.googleblog.com/2019/05/efficientnet-improving-accuracy-and.html