摘要

许多基于GCN的KGC模型增加了额外的计算复杂度,但效果并未提高。通过实验观察到,GCN中的图结构建模对KGC模型的性能没有显着影响,这与普遍看法相反。相反,实体表示的转换提供了性能改进。

引言

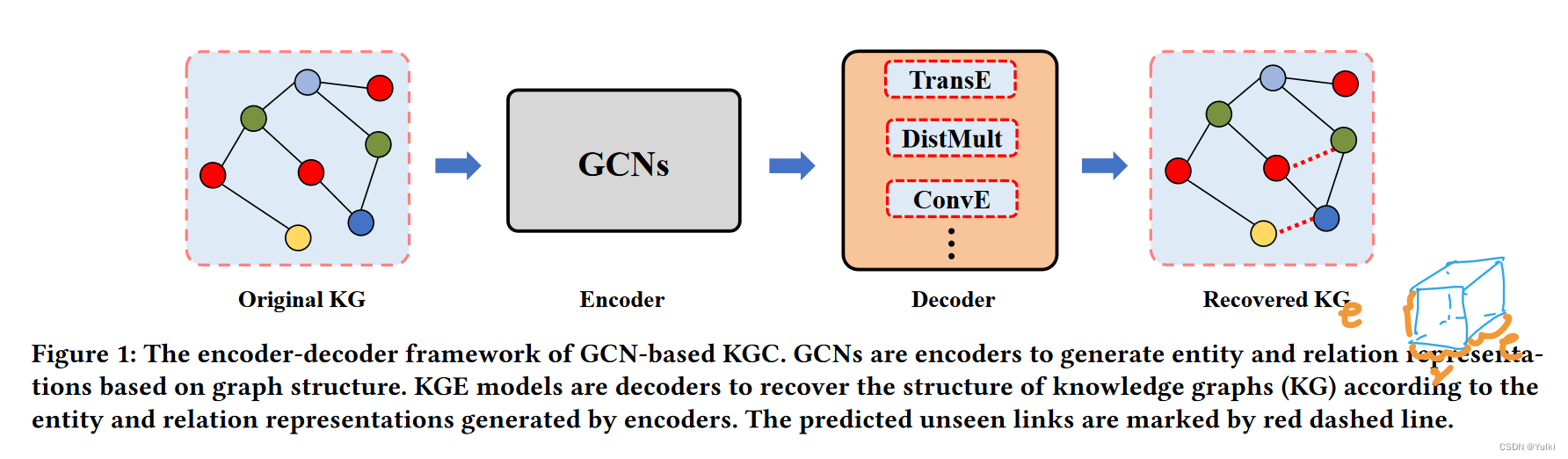

在KGC任务中,GCN和KGE模型分别充当encoder和decoder。值得注意的是,与仅聚合来自邻居节点 信息的经典 GCN 不同,KGC 中的 GCN 考虑了知识图中的边(关系)。

这些结果表明,对于KGC任务来说,现有的GCN是不必要的。在设计复杂的GCN架构时,我们应该进行更多的消融研究。

本文考虑了GCN中的以下因素:

- 随机破坏邻接矩阵对基于GCN的KGC任务没有影响。

- 图结构对GCN任务的改进没有实际影响。

- 自循环也没有实际影响。

最重要的是,可以区分具有不同语义的实体。实体表示的转换可以有效地提高KGE模型的性能。因此,本文提出了LTE-KGE。

预备知识

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XXDZX4NE-1680525124007)(Rethinking%20Graph%20Convolutional%20Networks%20in%20Knowled%20c512932e55134c809293abb1626fa8a5/Untitled%201.png)]](https://img-blog.csdnimg.cn/6e2043f464eb45d78a06a6349348c0cd.png)

KGE 模型也可以在此编码器-解码器框架下进行解释,其中编码器是来自嵌入空间的恒等函数,而解码器是 KGE 模型本身

实验

Encoder:Relational-GCN (RGCN),Weighted-GCN (WGCN),CompGCN

GCN对KGC的影响

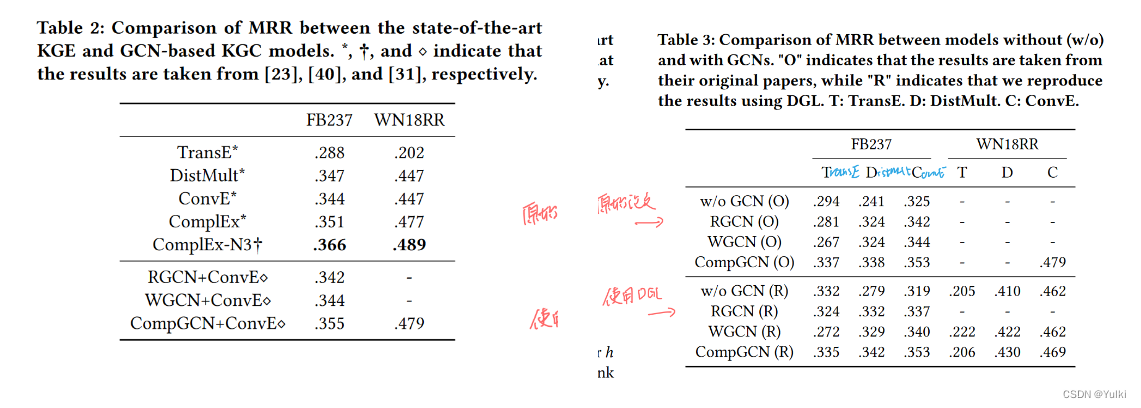

尽管引入了额外的计算复杂性,但基于 GCN 的 KGC 模型并未显示出优于最先进的 KGE 模型的巨大优势。需要解决两个问题:

Do GCNs really bring performance gain?

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XkixuUyv-1680525124007)(Rethinking%20Graph%20Convolutional%20Networks%20in%20Knowled%20c512932e55134c809293abb1626fa8a5/Untitled%204.png)]](https://img-blog.csdnimg.cn/6b9c4d894abe40d891f5818aaed80776.png)

并非所有 GCN 都能提高所有 KGE 模型的性能。

通过改进先进的训练技术也可以提高实验效果!

Which factor of GCNs is critical in KGC?

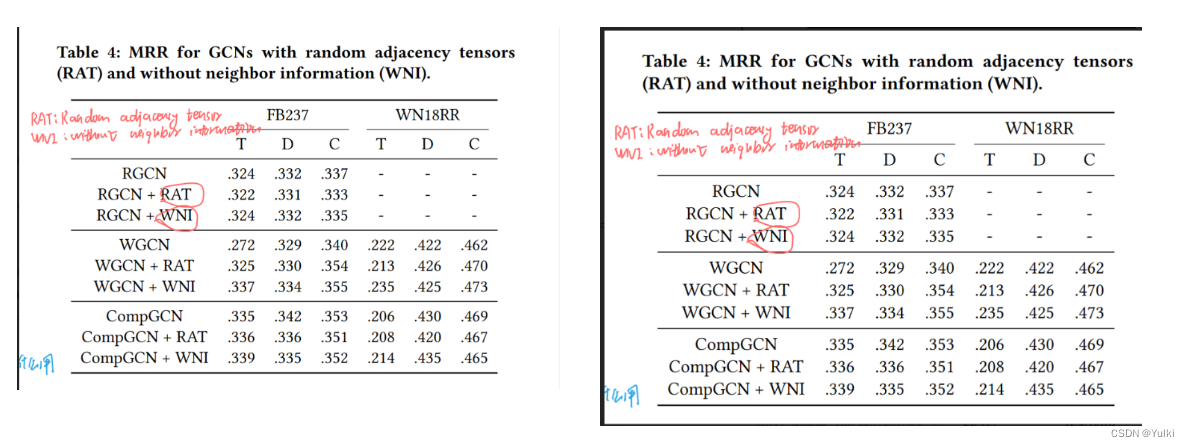

探讨了四个因素,分别是:图结构,邻居信息,自回归信息,关系的线性变化

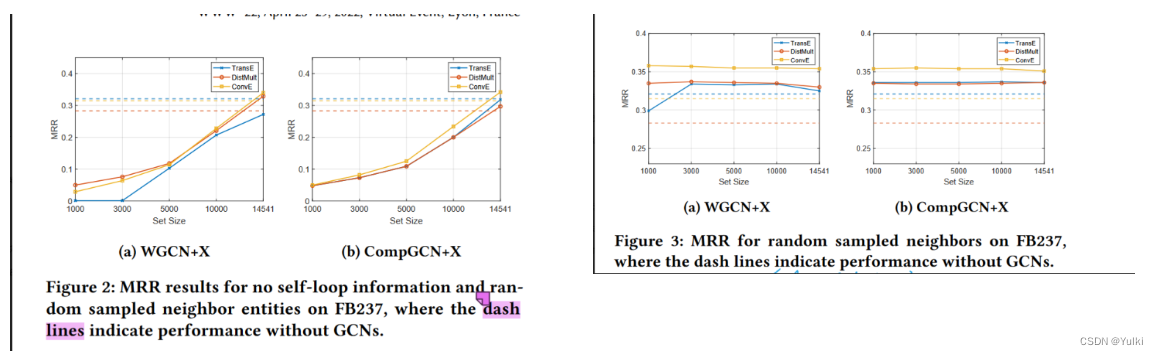

从图四中过就可以看到,对KGC任务来说,GCN中的图结构信息对性能没有帮助。

同样从图四中可以看到,GCN中的邻居信息对性能的提高也没有帮助。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ARlbU2eA-1680525124008)(Rethinking%20Graph%20Convolutional%20Networks%20in%20Knowled%20c512932e55134c809293abb1626fa8a5/Untitled%207.png)]](https://img-blog.csdnimg.cn/f3be321b6e324ebc81d4234dfcbfd9b7.png)

在大多数情况下,仅聚合邻居信息就可以获得与完整的基于 GCN 的 KGC 模型的比较结果。随机聚合邻居信息的结果也是一样的,设置略差一些。使用自回归信息,得到的效果差不多。

只要能区分出不同的实体就足够了!!!!!

‼️如果聚合过程可以很好地区分具有不同语义的实体,则 GCN 可以提高 KGE 模型的性能

对关系的线性变化对效果的提升,同样没有效果。

只要 GCN 能够通过其生成的实体表示很好地区分具有不同语义的实体,实体表示的转换就可以有效地提高 KGE 模型的性能

LTE-KGE

提出的目的不是为了SOTA,二十为了证明GCN是没有必要的,仅仅使用线性变化,就能达到与GCN相同的性能。

LTE-KGE 更加灵活,更加高效

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nJUVUHPa-1680525124009)(Rethinking%20Graph%20Convolutional%20Networks%20in%20Knowled%20c512932e55134c809293abb1626fa8a5/Untitled%2010.png)]](https://img-blog.csdnimg.cn/64010ed2d34b4537a929d6757a2c2a66.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-AxbKh7u1-1680525124009)(Rethinking%20Graph%20Convolutional%20Networks%20in%20Knowled%20c512932e55134c809293abb1626fa8a5/Untitled%2011.png)]](https://img-blog.csdnimg.cn/1195e231a640443fbac8e27cd4c520c9.png)

结论:总之,KGE 模型和梯度下降的组合已经表现得像 GCN 聚合。(证明过程没有详细的去看)

相关工作

最重要的点:早期的 GCN 通常设计用于同构图,其中节点和边只有一种类型。而在 KGC 任务中,直接使用这些 GCN 通常会导致性能不佳,因为知识图谱是异构图,即具有不同类型的节点和边。

结论

对于 KGC 任务来说,图结构并不重要,尽管这与常识想违背。相反,区分不同实体的能力和实体嵌入的转换是性能改进的原因。因此,建议基于 GCN 的新型 KGC 模型应该依靠更多的消融实验来验证模型的有效性。

附录

在许多情况下,增加 GCN 层并不能持续提高性能,性能甚至会随着 GCN 层数的增加而下降。