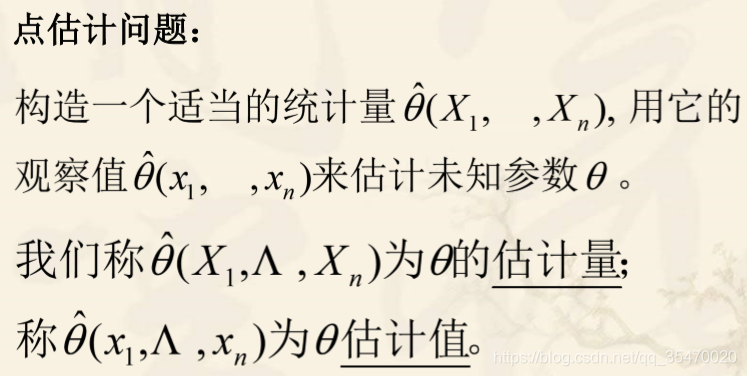

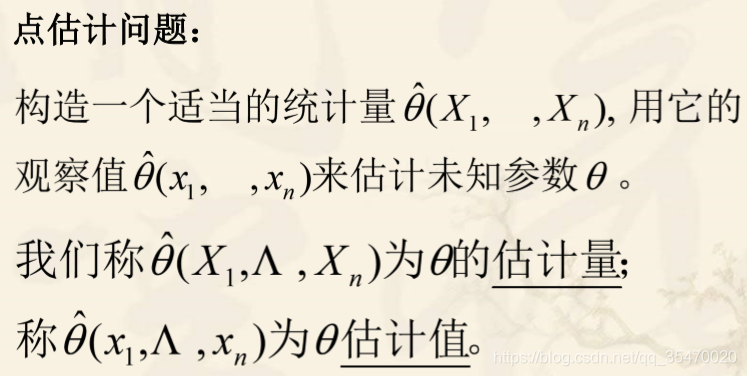

对于分布函数的形式已知,对于其中的未知参数,应用样本X1、X2…Xn所提供的信息去对其一个或者多个未知参数进行估计,这类问题称为参数估计问题。

参数估计在机器学习中的应用最为广泛。接下来就做一个简单的介绍学习。

一、矩估计

设

θ1,θ2,...θk为待估参数,

X1,X2,...Xn为来自X的样本。

设

EXl=μl,l=1,2,..k存在,根据

Al=n1∑Xil

建立包含k个未知参数的联立方程组,从而解出方程组的解

θ1

,...,θk

这种求估计量的方法称为矩估计法。

比如:设总体X在

(0,θ)上服从均匀分布,

θ未知,

X1,...Xn是来自X的样本,求

θ的矩估计量。

解:

μ1=E(X)=2θ

得

θ=2μ1

得:

θ

=2A1=2X

二、极大似然法

极大似然估计得基本思想:

比如一孩子和一个猎人外出打猎,这时打死一个兔子,问是谁打死的?这时你肯定想,猎人打中的概率大得多,所以应该是猎人打死的。

这种选择一个参数使得实验结果具有最大概率的思想就是极大似然法。

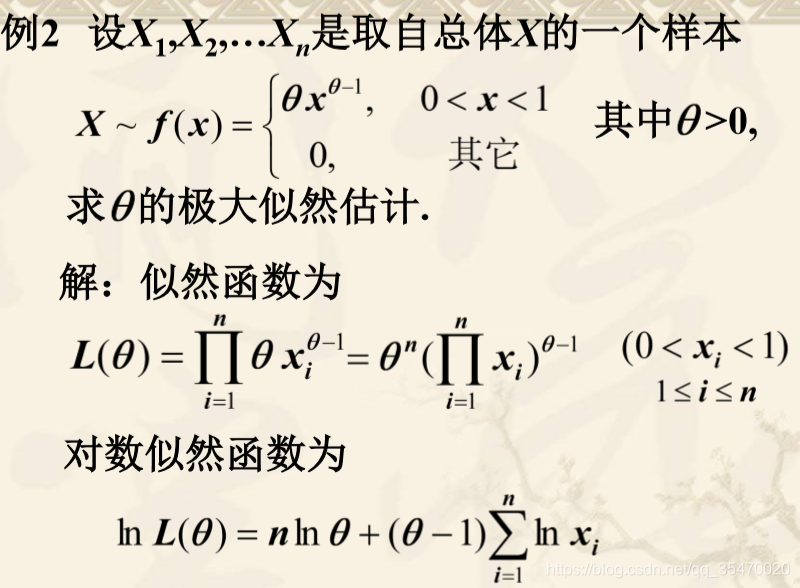

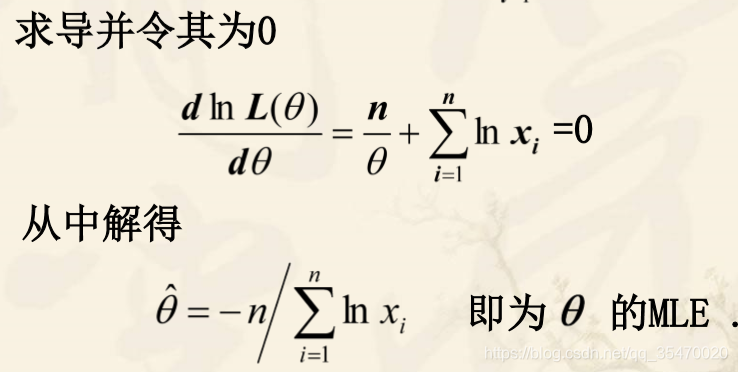

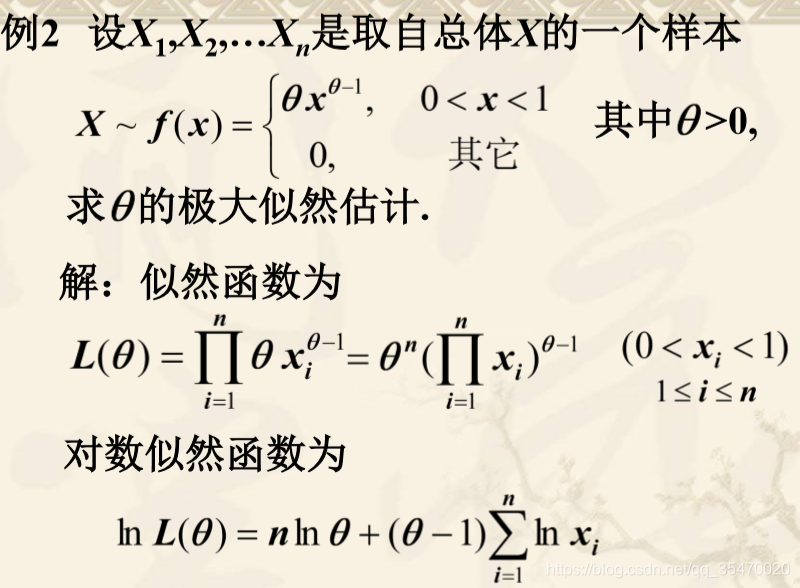

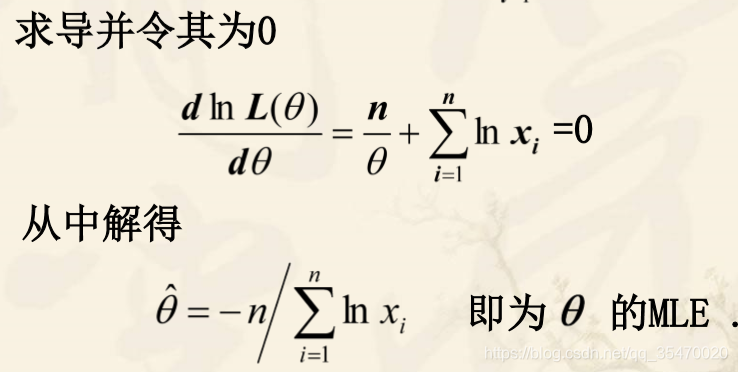

求极大似然估计(MLE)的一般步骤是:

1)由总体分布导出样本的联合分布律(或联合密度)

2)把样本联合分布律(或联合密度)中自变量看成已知常数,而把参数

θ看做自变量,得到似然函数

L(θ)

3)求似然函数

L(θ)的最大值(通常转化为求

lnL(θ)的最大值点),即

θ的MLE。

4)在最大值点的表达式中,用样本值带入就得参数的极大似然估计值。

x1,x2..是

X1,X2....样本的对应概率,

L(θ)=i=1∏np(xi;θ)

L(θ)称为样本的似然函数。

由极大似然估计法:固定

x1,..,xn,挑选使得概率L达到最大的参数

θ

,作为

θ的估计值,称为参数的极大似然估计值。

举个例子就很明白这个计算过程了。

例如:直接贴图好了